学习笔记

背景

对于现在的深度神经网络,训练起来既昂贵又耗时。论文中提出了一种方法,可以减少训练时间,同时保持与传统训练方法几乎相同的精度。这允许更快的实验和更好地使用计算资源。

方法通过在训练期间随机移除整个网络层而不是单个神经元来扩展众所周知的dropout技术,从而减少每次训练迭代所需的昂贵卷积运算的数量。

介绍

本文的贡献是通过沿 ResNet 模型的深度方向执行 dropout 来加速训练。 具体来说,在训练期间,我们逐个图像地随机绕过层,从而减少每个训练示例所需的计算量。

相关工作

width dropout

之前我们一直使用的dropout方法,就是在每次训练迭代和每个训练实例中,某个层内的有一部分神经元被随机置零,为了将此方法与此论文提出的方法区分开来,将其称为width dropout。一个称为dropout ratio的参数控制着任何单个神经元被抑制的概率。

宽度丢失可以用两种方式解释。 首先,width dropout 提供了一种规范训练的机制,可以防止网络每一层内的特征共同适应。 结果就学习更多不同的特征。 其次,width dropout 可以被看作是动态训练子网络的指数集合。 换句话说,每次训练迭代操作原始网络的不同子集。 两种解释都与观察结果一致,即width dropout有助于防止过度拟合并导致模型在看不见的测试数据上具有更好的准确性

残差网络

与此方法对比,论文提出的dropout方法沿深度方向随机跳过整个层,将这种方法称为depth dropout。 与 width dropout 不同,这里的动机不是为了防止特征的共同适应,而是为了减少训练时间。 通过跳过整个层,可以完全避免这些层内的卷积操作,从而提高计算速度。 请注意,depth dropout是width dropout的补充,并且在训练深度卷积神经网络时都可以使用两者。

现在考虑到深度丢失抑制了整个层的输出,通过这些层的信息路径被有效地阻止了。 因此,深度丢失只有在存在信息传递的替代路径时才有意义(这一层被完全抑制,这意味着上一层的输出不再经过这一层,无法加入到下一层,所以这一层必须有一个代替路径,当这一层被抑制的时候,使上一层的输入可以通过代替路径传入下一层)。 于是有了第二个灵感——残差网络。

在残差网络中,每个残差单元由两个或三个卷积层的主要路径和将输入到相关残差单元的输出短路的替代路径组成。 更具体地说,将通过卷积层的主要路径的输出添加到单元的输入中以产生单元的输出。 这种类型的架构允许我们随机跳过主要路径,而跳跃连接为信息流动提供了替代路径。

depth dropout

1.为了方便,模型考虑原有resnet体系结构中,仅仅使得第n个残差块中有2残差单元来讲解depth dropout,如图(a)所示。

该残差块接收输入信息,然后通过两个卷积层对其进行处理,最后再与该残差块的输入信息元素相加以生成单元的输出。写成公式就是:

2.现在我们考虑原始残差网络的一种稍微广义的形式,其中我们允许卷积路径按以下因子进行缩放:

当

a

n

=

1

a_n=1

an?=1时,它就是原始残差网络。

其中

a

n

a_n

an?来自伯努利分布,下面的

p

p

p 是预设的depth dropout ratio 。

t

n

t_n

tn? 是一个可训练的函数。 我们实现了另一个卷积层,如图 (b) 所示:

所以,最终可以用公式表示为:

所以,最终可以用公式表示为:

此时,在 a n = 0 a_n=0 an?=0 这种情况下,来自第 n 层的所有信息都流经 t n t_n tn? 。 在正向传播和反向传播过程中都保存了计算。

分析

运行时间

通过跳过残差块中主路径的计算,我们获得了与原始残差块网络相比的很大加速。为了将其形式化,让

τ

1

τ1

τ1和

τ

2

τ2

τ2表示剩余单元的主路径和跳连路径的运行时间。这里我们包括向前和向后传播的总时间。因此,计算残差块输出的时间为

τ

1

+

τ

2

τ1+τ2

τ1+τ2,这里我们忽略了其他非常小的开销,因为这与我们的分析无关。现在,随着深度衰减的引入,以概率

p

p

p跳过主路径。因此,预期运行时间变为

E

p

[

τ

1

]

+

τ

2

Ep[τ1]+τ2

Ep[τ1]+τ2,其中

E

p

[

?

]

Ep[·]

Ep[?]是关于参数

p

p

p的伯努利分布的预期。

例如,假设我们有一个残差块,主路径中有两个卷积层,快捷路径中有一个卷积层,如图(b)所示。同样,通过卷积层,我们指的是卷积层、批量归一化层和非线性层的堆栈。我们假设主路径上的两个卷积层有3×3个滤波器,而跳连路径上的卷积层有1×1个滤波器。我们进一步假设所有卷积层具有相同的输入维度。因此,1×1滤波器卷积层的运行时间理论上是3×3滤波器卷积层的

1

/

9

1/9

1/9。设

τ

τ

τ表示单个卷积层的总运行时间。原始残差块 (图(a)) 的总运行时间为

2

τ

2τ

2τ。当depth dropout radio

p

=

1

/

2

p=1/2

p=1/2时,改进残差块 (图(b)) 的预期运行时间为

12

(

τ

+

τ

)

+

19

τ

=

109

τ

12(τ+τ)+19τ=109τ

12(τ+τ)+19τ=109τ。

因此,理论上节省的时间为45.5%

参数量

由于残差块的跳连路径具有可训练的权重,有人可能会争辩说改进的网络比原始基线残差网络更复杂。 然而,与原始残差网络相比,随机丢弃主要路径将在每次迭代期间使得模型训练更少数量的期望权重。

例如:假设主路径上有两个卷积层,快捷路径上有一个卷积层,depth dropout radio

p

=

1

/

2

p =1/2

p=1/2 , 具有 depth dropout 的可训练卷积层的期望参数量为

(

1

/

2

)

?

2

+

1

/

9

=

10

/

9

(1/2)*2 + 1/9 = 10/9

(1/2)?2+1/9=10/9 ,而原先的残差块参数量为2,所以改进的残差块参数量预期明显小于原本残差网络。

测试

在测试时,只需要固定 a n = 1 a_n=1 an?=1。 与 width dropout 不同,我们不将特征输出除以 dropout radio,因为我们模型中的 dropout 是逐层执行的,并且我们已经通过学会了使用 t n t_n tn? 在跳连路径来消除丢弃的残差单元的影响。 请注意,虽然在原始残差网络上引入 t n t_n tn? 意味着额外的处理成本(在测试时),但与训练网络的成本相比,测试时间成本可以忽略不计。

结果

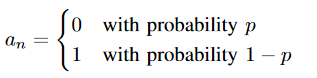

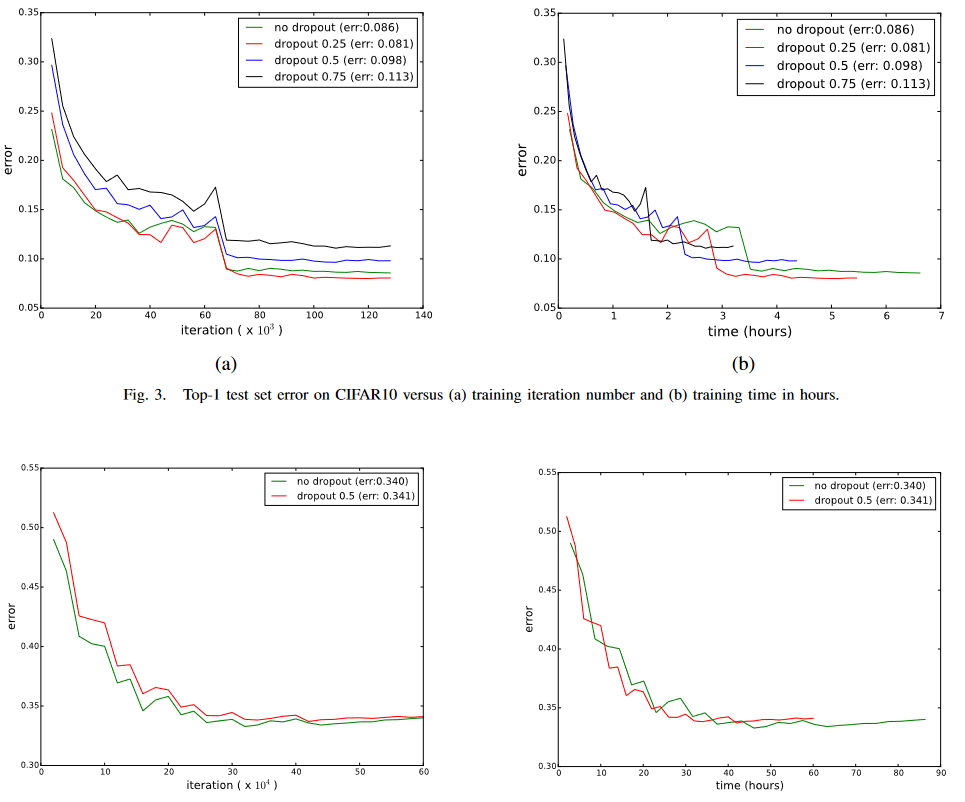

论文给出,使用了现在的网络,训练时间大大减少,并且精度也没有受到大的影响。

论文下载:

论文下载:

链接:https://pan.baidu.com/s/1Tjk5VWnqDNDiWljv3pwbKw

提取码:1yz7