存在的问题&研究动机&研究思路

- 目前的多智能体强化学习任务主要集中在得到一个分散式的协作的策略来最大化集体奖励。这样模型的可扩展性较差,不能用到更复杂的多智能体任务。

- 目前多数模型用于纯协作或者纯竞争的环境,无法应用于混合式的环境。

- CTDE的框架有维度灾难*的问题,当智能体数量增加,critic的训练将会变得很难。

- 最基本的问题还是,当前很多训练好的模型无法被迁移到 有不同数量的智能体,且不同智能体有不同的目标的任务。即可迁移性较差。

创新点

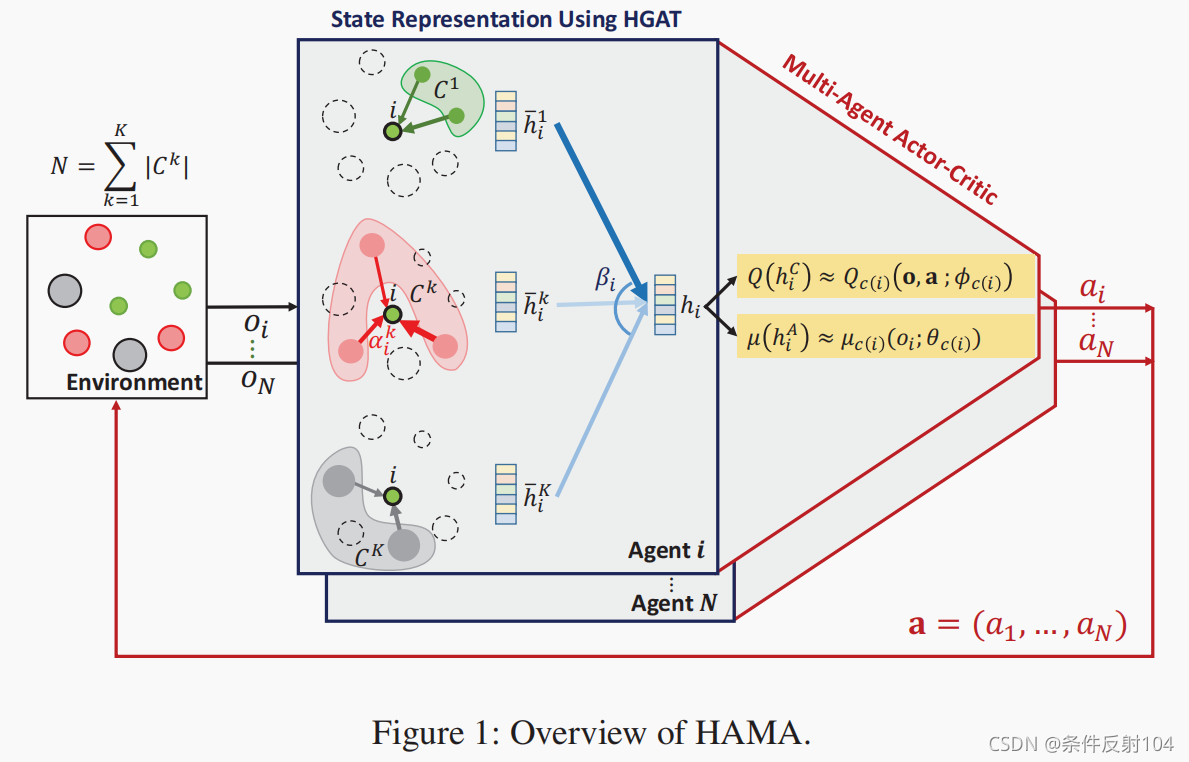

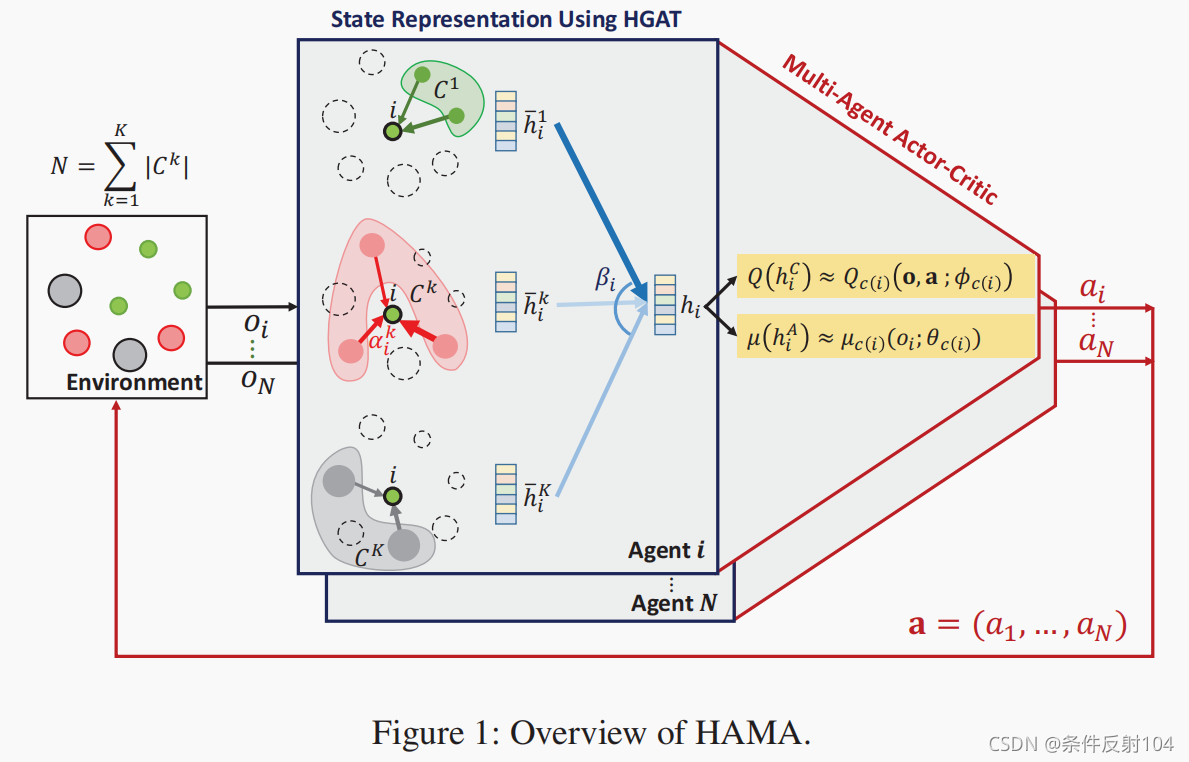

- 提出了HGAT——分层的图注意力机制:

- 先利用先验知识将智能体分为K类。

- 对每个智能体,首先在每个组内计算加权向量

h

i

k

ˉ

\bar{h_i^k}

hik?ˉ?。(第一层注意力)

- 然后对每个智能体,计算每组智能体之间的加权向量

h

i

h_i

hi?。(第二次注意力)

- HGAT相当于对每个智能体的观测值做了embedding,但同时考虑了分组的先验信息。

- 首先用两套HGAT得到每个智能体的向量

h

i

A

,

h

i

C

h_i^A,h_i^C

hiA?,hiC?后,后面的训练过程类似于MADDPG,只不过输入用

h

i

h_i

hi?替代

o

i

o_i

oi?,这样每个智能体的输入向量更好的提取了局部观测值的一些特征。同时,相同分组的智能体共享一套actor-critic参数。

算法框图

实验

- 实验环境为MAPE的四个环境,有协作的环境Cooperative Navigation(可扩展到大规模)和竞争环境Predator-Prey(可变化智能体数量)。

- HAMA和ATOC使用了注意力机制,因此具备可迁移到更大规模智能体环境的可行性。

- 文章证明了,分层图结构很大程度上提升了性能。

- 迁移学习:在某环境下训练后,改变智能体数量,进行测试。HAMA有不错的效果。

- 解释策略:将分层的注意力权重系数进行可视化,来解释智能体的策略。

some points

- attention权重系数的可视化,可以对决策进行解释。(具有解释性)

- 在混合式的环境下做实验的时候可以参考本文的方式。self-playing and play with different model。

|