背景介绍

Reinforcement Learning (RL)

假设环境是一个有限长度的折扣马尔可夫决策过程,可以用一个七元组来表示 M = ( S , A , ρ , P , r , γ , T ) \mathcal{M} = (\mathcal{S},\mathcal{A},\rho,\mathcal{P},r,\gamma,T) M=(S,A,ρ,P,r,γ,T),其中 T T T 是决策过程总长度; S \mathcal{S} S 是状态空间; A A A 是行为空间; r : S × A ? R r:\mathcal{S} \times \mathcal{A} \mapsto \mathbb{R} r:S×A?R 是奖励函数用于衡量某个状态行为对 ( s , a ) , s ∈ S , a ∈ A (s,a),s \in \mathcal{S},a \in \mathcal{A} (s,a),s∈S,a∈A 的好坏; P : S × A ? [ 0 , 1 ] \mathcal{P}: \mathcal{S} \times \mathcal{A} \mapsto [0,1] P:S×A?[0,1] 表示环境的状态转移概率函数; ρ : S ? [ 01 ] \rho: \mathcal{S} \mapsto [01] ρ:S?[01] 表示环境的初始状态分布; γ ∈ ( 0 , 1 ) \gamma \in (0,1) γ∈(0,1)是折扣因子。

对于智能体的行为模式,用策略函数

π

:

S

?

Δ

(

A

)

\pi : \mathcal{S} \mapsto \Delta (\mathcal{A})

π:S?Δ(A) 表示,即条件分布

π

(

a

∣

s

)

\pi(a\vert s)

π(a∣s) 表示改智能体在状态

s

s

s 处选择动作

a

a

a 的概率。则该策略在

M

\mathcal{M}

M 下的累计期望回报表示为值函数:

V

(

π

)

=

E

[

∑

t

=

0

T

γ

t

r

(

s

t

,

a

t

)

∣

s

0

~

ρ

(

?

)

,

a

t

~

π

(

?

∣

s

t

)

,

s

t

+

1

~

P

(

s

t

+

1

∣

s

t

,

a

t

)

]

V(\pi)=\mathbb{E}\left[\sum_{t=0}^{T} \gamma^{t} r\left(s_{t}, a_{t}\right) \mid s_{0} \sim \rho(\cdot), a_{t} \sim \pi\left(\cdot \mid s_{t}\right), s_{t+1} \sim \mathcal{P} \left(s_{t+1} \mid s_{t}, a_{t}\right)\right]

V(π)=E[t=0∑T?γtr(st?,at?)∣s0?~ρ(?),at?~π(?∣st?),st+1?~P(st+1?∣st?,at?)]

对于强化学习问题,其目标是在

r

r

r 已知的情况下求

π

?

∈

argmax

?

π

V

(

π

)

\pi^{*} \in \underset{\pi}{\operatorname{argmax}} V(\pi)

π?∈πargmax?V(π)。

Imitation Learning (IL)

而在模仿学习中, r r r 是未知或非常稀疏的,但有一个专家策略 π E \pi^E πE,假设专家策略是最优的,已知 π E \pi ^E πE 在 M \mathcal{M} M 下产生了一系列交互数据 D E = { t r 1 , t r 2 , … ? } \mathcal{D}^E = \{tr_1,tr_2,\dots\} DE={tr1?,tr2?,…},其中 t r = { ( s 1 , a 1 ) , ( s 2 , a 2 ) , ? ? , ( s T , a T ) } tr = \{(s_1,a_1),(s_2,a_2),\cdots,(s_T,a_T)\} tr={(s1?,a1?),(s2?,a2?),?,(sT?,aT?)} 表示智能体在环境中的一次完整轨迹。则模仿学习问题的目标是求 argmin ? π V ( π E ) ? V ( π ) \underset{\pi}{\operatorname{argmin}} V\left(\pi^{\mathrm{E}}\right)-V(\pi) πargmin?V(πE)?V(π)。

为了反映状态行为对

(

s

,

a

)

(s,a)

(s,a) 的访问频率,令策略

π

\pi

π 对于状态

s

s

s 和行为

a

a

a 的状态动作访问分布表示为

d

π

(

s

,

a

)

=

(

1

?

γ

)

∑

t

=

0

T

γ

t

P

π

(

s

t

=

s

,

a

t

=

a

)

d^{\pi}(s,a)=(1-\gamma) \sum_{t=0}^{T} \gamma^{t} \mathbb{P}^\pi\left(s_{t}=s,a_t=a\right)

dπ(s,a)=(1?γ)∑t=0T?γtPπ(st?=s,at?=a),其中

P

π

(

s

t

=

s

,

a

t

=

a

)

\mathbb{P}^\pi\left(s_{t}=s,a_t=a\right)

Pπ(st?=s,at?=a) 表示

t

t

t 时刻策略

π

\pi

π 对状态行为对

(

s

,

a

)

(s,a)

(s,a) 的访问概率。根据对偶分析,状态访问分布与值函数的联系为:

V

(

π

)

=

1

1

?

γ

∑

(

s

,

a

)

∈

S

×

A

d

π

(

s

,

a

)

r

(

s

,

a

)

V(\pi)=\frac{1}{1-\gamma} \sum_{(s, a) \in \mathcal{S} \times \mathcal{A}} d^{\pi}(s, a) r(s, a)

V(π)=1?γ1?(s,a)∈S×A∑?dπ(s,a)r(s,a)

则当策略

π

\pi

π 的状态动作分布

d

π

d^\pi

dπ 和专家策略的状态动作分布

d

π

E

d^{\pi^E}

dπE 距离很小时,

V

(

π

E

)

?

V

(

π

)

V\left(\pi^{\mathrm{E}}\right)-V(\pi)

V(πE)?V(π) 也会很小,因此生成对抗式模仿学习试图通过最小化状态动作分布来求出专家策略:

min ? π ∈ Π ψ ( d π , d π E ) \min _{\pi \in \Pi} \psi\left(d^{\pi}, d^{\pi^{\mathrm{E}}}\right) π∈Πmin?ψ(dπ,dπE)

其中 ψ \psi ψ 是距离度量函数。

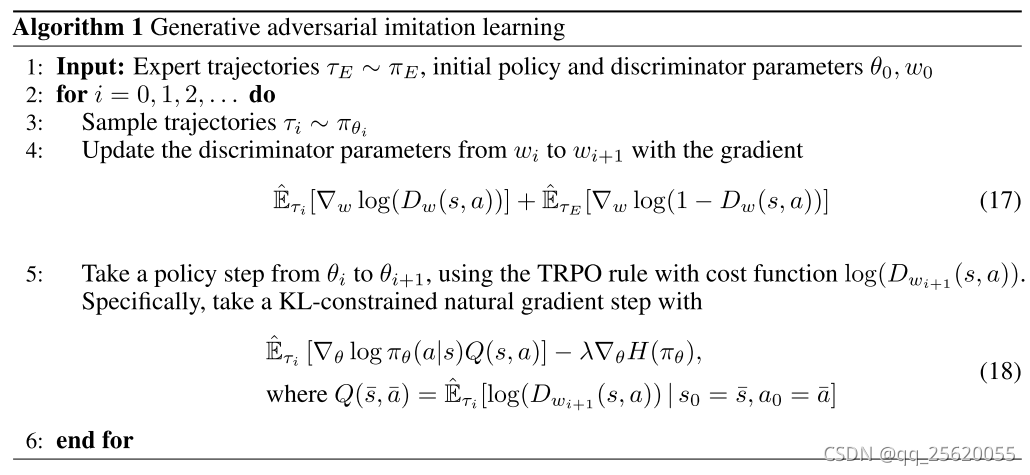

Generative Adversarial Imitation Learning (GAIL)

在生成对抗式模仿学习算法中,使用Jesen-Shannon距离进行度量,即:

min

?

π

∈

Π

D

J

S

(

d

π

,

d

^

π

E

)

\min _{\pi \in \Pi} D_{\mathrm{JS}}\left(d^{\pi}, \widehat{d}^{\pi^{\mathrm{E}}}\right)

π∈Πmin?DJS?(dπ,d

πE)

其中

h

^

π

E

\hat{h}^{\pi^E}

h^πE 是专家的状态动作分布估计器,则该算法的目标与GAN类似:

min

?

π

∈

Π

max

?

D

:

S

×

A

→

R

E

(

s

,

a

)

~

d

^

π

E

[

log

?

(

D

(

s

,

a

)

)

]

+

E

(

s

,

a

)

~

d

π

[

log

?

(

1

?

D

(

s

,

a

)

)

]

\min _{\pi \in \Pi} \max _{D: \mathcal{S} \times \mathcal{A} \rightarrow \mathbb{R}} \mathbb{E}_{(s, a) \sim \widehat{d}^{\pi} \mathrm{E}}[\log (D(s, a))]+\mathbb{E}_{(s, a) \sim d^{\pi}}[\log (1-D(s, a))]

π∈Πmin?D:S×A→Rmax?E(s,a)~d

πE?[log(D(s,a))]+E(s,a)~dπ?[log(1?D(s,a))]

其中

D

D

D 是判别器,用于区分某个状态动作对

(

s

,

a

)

(s,a)

(s,a) 是由专家策略

π

E

\pi^E

πE 还是模仿策略

π

\pi

π 产生,使用 Adam算法进行优化。

π \pi π 是生成器,目标是产生与专家数据相似度状态行为对,混淆判别器,使用 TRPO 等强化学习算法进行优化。

最后,根据因果熵理论,GAIL 使用

λ

H

(

π

)

=

E

π

[

?

log

?

π

(

s

∣

a

)

]

\lambda H(\pi) = \mathbb{E}_\pi[-\log \pi(s|a)]

λH(π)=Eπ?[?logπ(s∣a)] 作为正则化项对策略进行限制,使得到的策略唯一:

min

?

π

∈

Π

max

?

D

:

S

×

A

→

R

(

E

(

s

,

a

)

~

d

^

π

E

[

log

?

(

D

(

s

,

a

)

)

]

+

E

(

s

,

a

)

~

d

π

[

log

?

(

1

?

D

(

s

,

a

)

)

]

)

?

λ

H

(

π

)

\min _{\pi \in \Pi} \max _{D: \mathcal{S} \times \mathcal{A} \rightarrow \mathbb{R}}\left( \mathbb{E}_{(s, a) \sim \widehat{d}^{\pi} \mathrm{E}}[\log (D(s, a))]+\mathbb{E}_{(s, a) \sim d^{\pi}}[\log (1-D(s, a))]\right) - \lambda H(\pi)

π∈Πmin?D:S×A→Rmax?(E(s,a)~d

πE?[log(D(s,a))]+E(s,a)~dπ?[log(1?D(s,a))])?λH(π)

Model-Agnostic Meta-Learning (MAML)

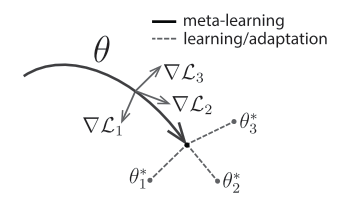

元学习上一种利用任务结构的相似性,使学习模型快速适应新环境的方法。与模型无关的元学习框架(MAML)通过二次梯度下降来获得一个较好的模型初始参数。具体来说是先让模型在多个子任务上进行梯度下降,然后利用这些梯度信息对原模型进行梯度下降。

问题与方案

对于黑白棋问题,我们有 m m m 个各不同级别风格的玩家数据,即 D = { D E i } i = 1 m \mathcal{D} = \{\mathcal{D}^{E_i}\}_{i=1}^m D={DEi?}i=1m?,目的是求每个玩家在黑白棋环境下的累计期望回报 { V ( π E i ) } i = 1 m \{V(\pi^{E_i})\}_{i=1}^m {V(πEi?)}i=1m?。由于环境相同,因此假设每个玩家基本策略具有相似性,同时拥有相似的状态访问概率。

在元学习的框架下使用生成对抗模仿学习算法学习各个玩家的策略,先在多个 D E i \mathcal{D}^{E_i} DEi? 上使用 GAIL ,通过自博弈的方式采样数据,并获得策略 π E i \pi^{E_i} πEi? 的策略梯度和鉴别器 D i D_i Di? 的梯度,利用这些梯度信息更新元模型的策略 π m e t a \pi^{meta} πmeta 和鉴别器 D m e t a D^{meta} Dmeta 的梯度。训练完成后 π m e t a \pi^{meta} πmeta 只需要少量数据即可学习到 π E i \pi^{E_i} πEi?。