AlphaGo浅析——浅析卷积神经网络

各位朋友中秋吉祥~,小编在此给您请安了。

在上节介绍AlphaGo的有监督学习策略网络Pσ的过程中,涉及到了卷积神经网络的相关知识,今日我们就着月饼来了解一下卷积神经网络的一些知识。

一、卷积神经网络概述

1. 组成:输入层+卷积层+激励层+池化层+全连接层

- 卷积神经网络在传统神经网络的基础上加入了特征提取功能,把传统神经网络的隐含层拓展成了卷积层,池化层(下采样层/降采样层)和全连接层,其中低隐含层是由卷积层和池化层以及激励层交替组成的,是用于实现特征提取功能的核心模块,高隐含(全连接层)对应传统多层感知器的隐含层和逻辑回归分类器。第一个全连接层的输入是由卷积层和池化层进行特征提取得到的特征图像,最后一层的输出是一个可以采用逻辑回归的分类器。

2. 关键操作:局部感受野+权值共享+降采样

1)局部感受野

- 对于一张图片来说,由于图片的空间联系是局部的,所以每个神经元并不需要了解整张图片,只需要感受局部特征就可以了,当然在更高层会将感受到不同局部特征的神经元汇聚起来得到全局的信息。局部感受野的好处是减少了参数的数目和连接的数目。

2)权值共享

对于一张图片来说,整张图片都是用一个滤波器去扫的,滤波器里面的数值叫做权重,整张图片的权重都是一样的。这样可以提取出处于图片不同位置的完全相同的特征。

3)降采样

池化层对特征图进行特征压缩,以减少连接的数目。常采用的压缩方法为最大池化和平均池化。

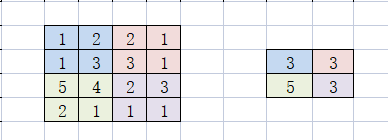

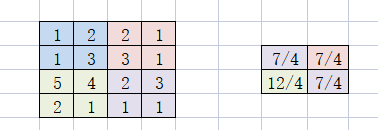

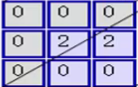

按照2 * 2的滤波器大小,以2为步长分别进行最大池化和平均池化的计算。

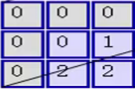

下图左为原特征,右为用最大池化进行特征压缩后的结果。

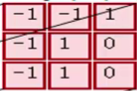

下图左为原特征,右为用平均池化进行压缩的结果

3.卷积过程

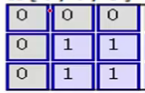

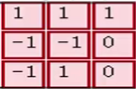

如下图所示,蓝色矩阵为大小 5 * 5,通道数(深度)为3的图,进过填充值为1的填充后变成了7 * 7的大小。粉红色的矩阵是滤波器,共有两组滤波器。对于每组滤波器而言,其深度与通道数相对应,换句话说就是:图像的通道数有多少,每组就有多少个滤波器。绿色矩阵表示卷积结果,有多少组滤波器参与卷积计算,就会产生多少个结果。-

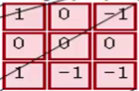

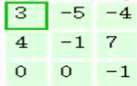

以滤波器产生第一个结果为例,过程详述如下:

- 输入矩阵中有一个和滤波器大小相同的滑框,将滑框中的元素与滤波器中的元素按照位置一一对应相乘。

与

与 对应位置相乘后求和,结果为0。

对应位置相乘后求和,结果为0。

与

与 对应位置相乘后求和,结果为2。

对应位置相乘后求和,结果为2。

与

与 对应位置相乘,结果为0

对应位置相乘,结果为0

- 由于填充量为1,故偏移量为1;

- 我们将上面计算的三个结果相加,加上偏移量:0+0+2+1=3。所以结果矩阵对应的第一个位置的结果为3.

- 根据计算过程,我们可以更加清晰地看出,有几组滤波器参与卷积运算,结果集的深度就是多少,与输入图像的通道数无关。结果集中的结果,是对应位置通道特征的累加和。

二、再度理解监督学习策略网络Pσ

- 下图为策略学习网络结构,前提条件是输入一个19 * 19 * 48的图像数组,48为通道数。先填充至23 * 23的大小,在第一层用192个 5 * 5 步长为1的卷积核进行卷积操作,经过一个非线性层,又使用192个大小为3 * 3,步长为1的卷积核进行卷积操作,再经过一个非线性层,最后用1个大小为1 * 1,步长为1的卷积核进行卷积操作,最后用Softmax函数进行分类并输出每个位置的下子概率。

经过对卷积神经网络的学习,小编重新履了一下图示过程:

- 对于卷积层的滤波器来说,输入图像的通道数有多少,滤波器的深度就要是多少,所以 5 * 5 * 48 * 192 中的 5 * 5 指滤波器的大小,48 指滤波器的深度(每组滤波器的数目),192 指共有192组滤波器。

- 卷积后的结果 19 * 19 * 192 表示的是有 192 个19 * 19 大小的结果矩阵。【再次强调结果矩阵的个数与输入图像的通道数和滤波器的深度无关,结果矩阵是输入图像的各个通道在经过滤波器特征提取后 结果的累加和】。

- 对于第 2-12 层隐含层来说,输入的图像数组变成了 19 * 19 * 192 ,192 在此可以理解为通道数,所以对应的滤波器深度变成了192个,由于把图像填充成了 21 * 21 ,所以使用 192组 大小为 3 * 3 ,深度为 192 的滤波器对输入图像进行特征的提取。

- 卷积后的结果 19 * 19 * 192 各个数字的含义同步骤2一致。

- 最后用 1 个大小为 1 * 1,深度为 192 的卷积核对之前提取到的特征进行汇总,卷积的结果 大小为 19 * 19 ,深度为1。

- 最后经过Softmax函数进行分类,输出一个 19 * 19 的结果。

写在最后

- 感谢您的阅读! 本文是小编针对AlphaGo中监督学习策略网络卷积过程的一篇学习笔记,如小编的一些理解有误,敬请斧正。

- 由于小编的数学能力有限,故近期会加大学习量,可能会减缓博客更新的频率,敬请谅解。