文章目录

内容介绍

机器学习是一个很大的研究领域,它与人工智能等许多相关领域的思想有很大的重叠和继承。

该领域的重点是学习,即从经验中获得技能或知识。最常见的是,这意味着从历史数据中综合有用的概念。

因此,作为机器学习领域的实践者,您可能会遇到许多不同类型的学习,从整个研究领域到特定技术。

本文介绍:

- 研究领域,如监督学习、非监督学习和强化学习。

- 混合学习类型,如半监督学习和自我监督学习.

- 广泛的技术,如主动、在线和转移学习。

非算法的学习类型

学习问题 包括:监督学习、无监督学习、强化学习。

混合学习问题 包括:半监督学习、自我监督学习、多实例学习。

统计推断 包括:归纳学习、演绎推理、转换学习。

学习技巧 包括:多任务学习、积极学习、在线学习、转移学习、整体学习。

学习问题

1.监督学习

监督学习描述一类涉及使用模型学习输入示例与目标变量之间的映射的问题。

《Pattern Recognition and Machine Learning》2016年

Applications in which the training data comprises examples of the input vectors along with their corresponding target vectors are known as supervised learning problems.

训练数据包含输入向量及其对应目标向量的示例的应用称为监督学习问题。

模型适合于由输入和输出组成的训练数据,用于对只提供输入的测试集进行预测,并将模型的输出与保留的目标变量进行比较,并用于估计模型的技能。

《Artificial Intelligence: A Modern Approach》2015年 第三版

Learning is a search through the space of possible hypotheses for one that will perform well, even on new examples beyond the training set. To measure the accuracy of a hypothesis we give it a test set of examples that are distinct from the training set.

学习是在可能的假设空间中搜索一个将表现良好的假设,即使是在训练集之外的新例子上。为了衡量假设的准确性,我们给出了一组与训练集不同的示例测试集。

有两种主要类型的监督学习问题:分类涉及预测一个类别标签和回归涉及预测一个数值。

分类监督学习问题,涉及到预测类标签。

回归监督学习问题,涉及到预测一个数字标签。

分类和回归问题都可能有一个或多个输入变量,输入变量可能是任何数据类型,例如数字或范畴。

分类问题的一个例子是MNIST手写数字数据集,其中输入是手写数字的图像(像素数据),输出是图像所代表的数字(数字0到9)的类标签。

回归问题的一个例子是波士顿房价数据集,其中输入是描述邻域的变量,输出是以美元为单位的房价。

一些机器学习算法被描述为“监督“机器学习算法是为有监督的机器学习问题而设计的。流行的算法包括:决策树, 支持向量机等。

《The Elements of Statistical Learning: Data Mining, Inference, and Prediction》 2016年 第二版

我们的目标是找到f(X)对函数f(X)的一个有用的近似,该函数是输入和输出之间的预测关系的基础。

算法被称为“监督“因为他们通过做出预测来学习,给出输入数据的例子,并通过一种算法对模型进行监督和修正,以便更好地预测训练数据集中的预期目标输出。

《Deep Learning》 2016年

The term supervised learning originates from the view of the target y being provided by an instructor or teacher who shows the machine learning system what to do.

监督学习这一术语来源于指导员或教师向机器学习系统展示该做什么的目标y的观点。

有些算法可能是专门为分类而设计的(例如Logistic回归)或回归(如线性回归),有些可用于这两种类型的小修改问题(如人工神经网络)。

2.无监督学习

无监督学习描述涉及使用模型描述或提取数据中关系的一类问题。

与监督学习相比,无监督学习只对输入数据进行学习,没有输出或目标变量。因此,无监督学习没有教师纠正模型,就像监督学习的情况一样。

《Deep Learning》 2016年

In unsupervised learning, there is no instructor or teacher, and the algorithm must learn to make sense of the data without this guide.

在无监督学习中,没有指导员或教师,算法必须学会在没有本指南的情况下理解数据。

有许多类型的无监督学习,尽管从业人员经常遇到两个主要问题:一种是聚类,涉及在数据中查找组,另一种是关于汇总数据分布的密度估计。

聚类:无监督学习问题,需要在数据中找到组。

密度估计:无监督学习问题,涉及总结数据的分布。

聚类算法的一个例子是k-均值k指要在数据中发现的集群数量。密度估计算法的一个例子是核密度估计这涉及到使用小组紧密相关的数据样本来估计问题空间中新点的分布。

《Artificial Intelligence: A Modern Approach》2015年 第三版

The most common unsupervised learning task is clustering: detecting potentially useful clusters of input examples. For example, a taxi agent might gradually develop a concept of “good traffic days” and “bad traffic days” without ever being given labeled examples of each by a teacher.

最常见的无监督学习任务是聚类:检测潜在有用的输入示例聚类。例如,的士代理商可能会逐渐发展出“好交通日”和“坏交通日”的概念,而教师却没有给每一个例子打上标签。

可以执行聚类和密度估计来了解数据中的模式。

还可以使用其他的无监督方法,例如可视化,包括以不同的方式绘制或绘制数据,以及涉及降低数据维数的投影方法。

可视化无监督 的学习问题,涉及创建数据图。

投影无监督 的学习问题,涉及创建数据的低维表示。

一个例子可视化技术是一个散点图矩阵,它为数据集中的每一对变量创建一个散点图。投影方法的一个例子是主成分分析这涉及到用特征值和特征向量来总结数据集,去掉线性依赖关系。

《Pattern Recognition and Machine Learning》2006年

The goal in such unsupervised learning problems may be to discover groups of similar examples within the data, where it is called clustering, or to determine the distribution of data within the input space, known as density estimation, or to project the data from a high-dimensional space down to two or three dimensions for the purpose of visualization.

这种无监督学习问题的目标可能是在数据中发现一组类似的例子,这称为聚类,或者确定数据在输入空间中的分布,称为密度估计,或者将数据从高维空间投射到二维或三维,以实现可视化。

3.强化学习

强化学习描述代理在环境中操作的一类问题,并且必须学学使用反馈操作。

《Reinforcement Learning: An Introduction》2018年 第二版

Reinforcement learning is learning what to do — how to map situations to actions—so as to maximize a numerical reward signal. The learner is not told which actions to take, but instead must discover which actions yield the most reward by trying them.

强化学习是学习该做什么–如何将情景映射到行动–从而最大限度地获得数字奖励信号。学习者不被告知采取什么行动,而是必须发现哪些行动产生最大的回报,通过尝试。

环境的使用意味着没有固定的训练数据集,而是一个或多个目标,Agent需要达到的目标,他们可以执行的行动,以及对目标性能的反馈。

《Deep Learning》2016年

Some machine learning algorithms do not just experience a fixed dataset. For example, reinforcement learning algorithms interact with an environment, so there is a feedback loop between the learning system and its experiences.

有些机器学习算法不只是体验固定的数据集。例如,强化学习算法与环境交互,因此在学习系统与其经验之间存在一个反馈循环。

它类似于监督学习,因为该模型具有一定的学习响应,尽管反馈可能会延迟和统计噪声,这使得Agent或模型难以将因果联系起来。

一个强化问题的例子是玩一个游戏,其中代理人的目标是获得高分,可以在游戏中采取行动,并在惩罚或奖励方面得到反馈。

《Artificial Intelligence: A Modern Approach》2015年 第三版

In many complex domains, reinforcement learning is the only feasible way to train a program to perform at high levels. For example, in game playing, it is very hard for a human to provide accurate and consistent evaluations of large numbers of positions, which would be needed to train an evaluation function directly from examples. Instead, the program can be told when it has won or lost, and it can use this information to learn an evaluation function that gives reasonably accurate estimates of the probability of winning from any given position.

在许多复杂的领域中,强化学习是训练高水平程序的唯一可行方法。例如,在游戏中,一个人很难对大量的职位提供准确和一致的评估,这将需要从实例中直接训练评价功能。相反,程序可以被告知它已经赢或输,它可以使用这些信息来学习一个评估函数,给出从任何给定位置的获胜概率的合理准确的估计。

令人印象深刻的结果有在谷歌的AlphaGo中使用了增强功能,在世界顶级围棋玩家中表现出色。

一些常用的强化学习算法包括Q学习、时差学习和深度强化学习.

混合学习问题

无监督学习和监督学习之间的界限是模糊的,有许多混合方法,从各个领域的研究。

4.半监督学习

半监督学习在有监督的学习中,培训数据中包含很少的有标记的示例和大量未标记的示例。

半监督学习模型的目标是有效地利用所有可用的数据,而不仅仅是像监督学习中那样的标签数据。

《Artificial Intelligence: A Modern Approach》2015年 第三版

In semi-supervised learning we are given a few labeled examples and must make what we can of a large collection of unlabeled examples. Even the labels themselves may not be the oracular truths that we hope for.

在半监督学习中,我们得到了几个有标记的示例,并且必须尽可能地收集大量未标记的示例。甚至标签本身也可能不是我们所希望的预言真理。

有效利用无标记数据可能需要使用非监督方法(如聚类和密度估计)或从中获得灵感。一旦发现组或模式,可以使用监督学习的监督方法或想法来标记未标记的示例或将标签应用于后来用于预测的未标记表示。

《Deep Learning》2016年

Unsupervised learning can provide useful cues for how to group examples in representation space. Examples that cluster tightly in the input space should be mapped to similar representations.

无监督学习可以为如何在表示空间中对示例进行分组提供有用的线索。在输入空间中紧密聚集的示例应该映射到类似的表示形式。

许多实际的监督学习问题通常都是半监督学习问题的例子,考虑到标注示例的费用或计算成本。例如,对照片进行分类需要一个已经被人工操作人员标记的照片数据集。

计算机视觉(图像数据)、自然语言处理(文本数据)和语音自动识别(音频数据)等领域的许多问题都属于这一范畴,难以用标准的监督学习方法加以解决。

《Data Mining: Practical Machine Learning Tools and Techniques》2016年 第四版

in many practical applications labeled data is very scarce but unlabeled data is plentiful. “Semisupervised” learning attempts to improve the accuracy of supervised learning by exploiting information in unlabeled data. This sounds like magic, but it can work!

在许多实际应用中,标记数据非常稀少,但未标记数据非常丰富。“半编”学习试图通过利用未标注数据中的信息来提高监督学习的准确性。这听起来像魔法,但它可以工作!

5.自我监督学习

自监督学习是指将无监督学习问题定义为监督学习问题,以应用有监督学习算法来求解的问题。

监督学习算法是用来求解一个替代的或借口的任务,其结果是一个模型或表示,可以用于解决原始(实际)建模问题。

《Revisiting Self-Supervised Visual Representation Learning》 2019年

The self-supervised learning framework requires only unlabeled data in order to formulate a pretext learning task such as predicting context or image rotation, for which a target objective can be computed without supervision.

自监督学习框架只需要未标注的数据,就可以构造一个借口学习任务,例如预测上下文或图像旋转,而目标目标可以在不受监督的情况下被计算出来。

自我监督学习的一个常见例子是计算机视觉,其中有一个未标记图像的语料库,可以用来训练一个有监督的模型,例如使图像灰度化,让一个模型预测图像的颜色表示(颜色化)或去除图像的块,并有一个模型预测缺失的部分(修复)。

《Scaling and Benchmarking Self-Supervised Visual Representation Learning》2019版

In discriminative self-supervised learning, which is the main focus of this work, a model is trained on an auxiliary or ‘pretext’ task for which ground-truth is available for free. In most cases, the pretext task involves predicting some hidden portion of the data (for example, predicting color for gray-scale images

在这一工作的重点-有区别的自我监督学习中,一个模型被训练在一个辅助或“借口”任务上,而这一任务是免费提供基础真理的。在大多数情况下,借口任务涉及预测数据的某些隐藏部分(例如,预测灰度图像的颜色)。

自监督学习算法的一个一般例子是自动编码器。这是一种用于创建输入样本的紧凑或压缩表示的神经网络类型。它们通过一个具有编码器和解码器元素的模型来实现这一点,该模型由表示输入的内部紧凑表示的瓶颈分隔。

《Deep Learning》 2016年

An autoencoder is a neural network that is trained to attempt to copy its input to its output. Internally, it has a hidden layer h that describes a code used to represent the input.

自动编码器是一种神经网络,它经过训练试图将其输入复制到其输出。在内部,它有一个隐藏的层。h它描述用于表示输入的代码。

这些自动编码器模型通过将输入提供给模型作为输入和目标输出进行训练,要求模型首先将输入编码为压缩表示,然后将其解码回原始表示。一旦经过训练,就会丢弃解码器,并根据需要使用编码器来创建输入的紧凑表示。

虽然自动编码器是使用监督学习方法训练的,但它们解决了一个非监督学习问题,即它们是一种降低输入数据维数的投影方法。

《Deep Learning》 2016年

Traditionally, autoencoders were used for dimensionality reduction or feature learning.

传统上,自动编码器主要用于降维或特征学习。

另一个自我监督学习的例子是生成对抗性网络或甘斯。这些是生成模型,最常见的是用来创建合成照片,只使用一组未标记的例子,从目标领域。

GaN模型通过一个单独的判别器模型间接训练,该模型将来自域的照片分类为真实的或假的(生成),其结果被反馈以更新GaN模型,并鼓励它在下一次迭代中生成更真实的照片。

《Deep Learning》 2016年

The generator network directly produces samples […]. Its adversary, the discriminator network, attempts to distinguish between samples drawn from the training data and samples drawn from the generator. The discriminator emits a probability value given by d(x; θ(d)), indicating the probability that x is a real training example rather than a fake sample drawn from the model.

生成器网络直接生成示例[…]。它的对手,即鉴别器网络,试图区分从训练数据中提取的样本和从生成器中提取的样本。判别器发出由d(x;θ(D))给出的概率值,表示x是一个真实的训练示例而不是从模型中抽取的假样本的概率。

6.多实例学习

多实例学习是一个有监督的学习问题,其中个别的例子是没有标签的;相反,袋或一组样本被贴上标签。

《Deep Learning》 2016年

In multi-instance learning, an entire collection of examples is labeled as containing or not containing an example of a class, but the individual members of the collection are not labeled.

在多实例学习中,整个示例集合被标记为包含或不包含类的示例,但是集合的单个成员没有标记。

实例在“袋“而不是设置,因为给定的实例可能出现一次或多次,例如重复。

建模涉及到使用袋子中的一个或一些实例与目标标签相关联的知识,并预测未来新袋子的标签,因为它们由多个未标记的示例组成。

《Data Mining: Practical Machine Learning Tools and Techniques》 2016年 第四版

In supervised multi-instance learning, a class label is associated with each bag, and the goal of learning is to determine how the class can be inferred from the instances that make up the bag.

在受监督的多实例学习中,类标签与每个包相关联,学习的目的是确定如何从构成包的实例中推断类。

简单的方法,如为单个实例分配类标签和使用标准的监督学习算法,通常都是很好的第一步。

统计推断

推论是指达成一个结果或决定。

在机器学习中,模型拟合和预测都是推理的类型。

有不同的推理范式,可以作为一个框架来理解某些机器学习算法是如何工作的,或者如何处理一些学习问题。

学习方法的一些例子有归纳学习、演绎学习、换能型学习和推理。

7.归纳学习

归纳学习用证据来决定结果。

归纳推理是指使用特定的案例来确定一般的结果,例如一般的结果。

大多数机器学习模型使用一种归纳推理或归纳推理来学习,其中一般规则(模型)是从特定的历史示例(数据)中学习的。

《机器学习的概率视角》 2012年

the problem of induction, which is the problem of how to draw general conclusions about the future from specific observations from the past.

归纳问题,是如何从过去的具体观察中得出关于未来的一般性结论的问题。

机器学习模型的拟合是一个归纳的过程。该模型是训练数据集中具体示例的推广。

使用训练数据对问题提出了一个模型或假设,并且相信在以后使用该模型时,它会保留新的未见数据。

《Machine Learning》1997年

Lacking any further information, our assumption is that the best hypothesis regarding unseen instances is the hypothesis that best fits the observed training data. This is the fundamental assumption of inductive learning

由于缺乏任何进一步的信息,我们的假设是,关于未见实例的最佳假设是最适合观察到的训练数据的假设。这是归纳学习…的基本假设。

-第23页,机器学习, 1997.

8.演绎推理

扣减或演绎推理指使用一般规则来确定具体结果。

通过将归纳与演绎进行对比,我们可以更好地理解归纳。

演绎是归纳的反面。如果归纳是从特定到一般,扣减是从一般到具体。

《Machine Learning》1997年

the simple observation that induction is just the inverse of deduction!

简单的观察,归纳只是演绎的反义词!

演绎是一种自上而下的推理,它在确定结论之前寻求满足所有前提,而归纳则是一种自下而上的推理,它使用现有数据作为结果的证据。

在机器学习的背景下,一旦我们使用归纳法来拟合训练数据集上的模型,就可以使用该模型进行预测。模型的使用是一种演绎或演绎推理。

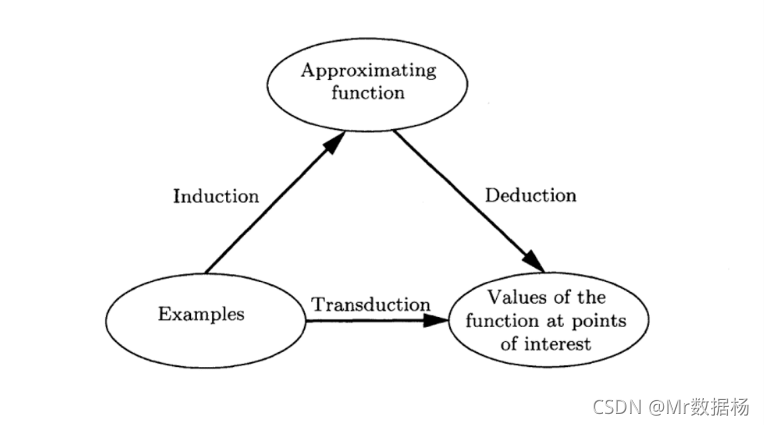

9.转换学习

传导或换能式学习用于统计学习理论领域,用于预测特定实例,给出一个领域的具体实例。

与归纳不同的是,它涉及从具体的例子中学习一般规则,例如特定的例子。

《The Nature of Statistical Learning Theory》 1995年

Induction, deriving the function from the given data. Deduction, deriving the values of the given function for points of interest. Transduction, deriving the values of the unknown function for points of interest from the given data.

归纳,从给定的数据派生函数。推导,导出兴趣点的给定函数的值。从给定的数据中导出感兴趣点的未知函数的值。

与归纳不同,不需要泛化;相反,直接使用特定的示例。事实上,这可能是一个比归纳更简单的问题。

《The Nature of Statistical Learning Theory》1995年

The model of estimating the value of a function at a given point of interest describes a new concept of inference: moving from the particular to the particular. We call this type of inference transductive inference. Note that this concept of inference appears when one would like to get the best result from a restricted amount of information.

在给定的兴趣点上估计函数值的模型描述了一个新的推断概念:从特定到特定。我们称之为这种推理–换能式推理。请注意,当您希望从有限的信息量中获得最佳结果时,就会出现这种推断的概念。

换能器算法的一个经典例子是k近邻算法,它不对训练数据建模,而是在每次需要预测时直接使用它。

归纳、演绎和转换的对比

在机器学习的背景下,我们可以比较这三种类型的推理。

例如:

- 感应 Induction 从具体实例中学习一般模式。

- 演绎 Deduction 使用模型进行预测。

- 传导 Transduction 使用具体实例进行预测。

下面的图像很好地总结了这三种不同的方法。

学习技巧

有许多技术被描述为学习的类型。

10.多任务学习

多任务学习是一种监督学习,它涉及在一个数据集上拟合一个模型,以解决多个相关问题。

它涉及到设计一个模型,该模型可以对多个相关任务进行培训,从而通过跨任务的培训来提高模型的性能,而不是对任何单个任务进行培训。

《Deep Learning》 2016年

Multi-task learning is a way to improve generalization by pooling the examples (which can be seen as soft constraints imposed on the parameters) arising out of several tasks.

多任务学习是一种通过汇集由多个任务产生的示例(可以看作是对参数施加的软约束)来提高泛化能力的一种方法。

多任务学习是一种有用的解决问题的方法,当有大量的输入数据标记为一个任务时,它可以与另一个任务共享,而另一个任务的标记数据则要少得多。

《Machine Learning: A Probabilistic Perspective》2012年

we may want to learn multiple related models at the same time, which is known as multi-task learning. This will allow us to “borrow statistical strength” from tasks with lots of data and to share it with tasks with little data.

我们可能需要同时学习多个相关模型,即多任务学习。这将使我们能够从拥有大量数据的任务中“借用统计力量”,并将其与数据很少的任务共享。

例如,多任务学习问题通常涉及相同的输入模式,可以用于多个不同的输出或监督学习问题。在这种设置中,每个输出可以由模型的不同部分来预测,允许模型的核心对相同的输入跨每个任务进行泛化。

《Deep Learning》 2016年

In the same way that additional training examples put more pressure on the parameters of the model towards values that generalize well, when part of a model is shared across tasks, that part of the model is more constrained towards good values (assuming the sharing is justified), often yielding better generalization.

同样,额外的培训示例给模型的参数带来了更大的压力,使其趋向于具有良好通用性的值,当模型的一部分跨任务共享时,模型的这一部分更多地局限于良好的价值观(假设共享是合理的),往往会产生更好的泛化效果。

多任务学习的一个流行例子是使用相同的单词嵌入来学习文本中单词的分布式表示,然后在多个不同的自然语言处理监督学习任务之间共享。

11.积极学习

主动学习是一种技术,在学习过程中,为了解决学习过程中的歧义,模型能够在学习过程中查询人类用户操作员。

《Foundations of Machine Learning》 2018年 第二版

Active learning: The learner adaptively or interactively collects training examples, typically by querying an oracle to request labels for new points.

主动学习:学习者通过自适应或交互的方式收集训练示例,通常是通过查询甲骨文来请求新点的标签。

主动学习是一种有监督的学习,它的目的是达到所谓的“主动学习”的相同或更好的效果。“被动“有监督的学习,虽然是通过更有效的数据收集或使用的模型。

《Active Learning Literature Survey》2009年

The key idea behind active learning is that a machine learning algorithm can achieve greater accuracy with fewer training labels if it is allowed to choose the data from which it learns. An active learner may pose queries, usually in the form of unlabeled data instances to be labeled by an oracle (e.g., a human annotator).

主动学习背后的关键思想是,机器学习算法能够以较少的训练标签达到更高的精度,如果允许它选择它所学习的数据。主动学习者可以提出查询,通常以未标记的数据实例的形式由Oracle标记(例如,人工注释器)。

把主动学习看作是解决半监督学习问题的一种方法,或者是解决同一类型问题的另一种范式,这并不是不合理的。

《Active Learning Literature Survey》2009年

we see that active learning and semi-supervised learning attack the same problem from opposite directions. While semi-supervised methods exploit what the learner thinks it knows about the unlabeled data, active methods attempt to explore the unknown aspects. It is therefore natural to think about combining the two

我们看到主动学习和半监督学习从相反的方向攻击同一个问题。半监督方法利用学习者认为自己知道的无标记数据,而主动方法则试图探索未知的方面。因此,考虑将两者结合起来是很自然的。

主动学习是一个有用的方法,当没有太多的数据可用,新的数据是昂贵的收集或标签。

主动学习过程允许对域的采样以最小化样本数量和最大限度地提高模型有效性的方式进行。

《Foundations of Machine Learning》

Active learning is often used in applications where labels are expensive to obtain, for example computational biology applications.

主动学习通常用于标签昂贵的应用程序,例如计算生物学应用程序。

12.在线学习

在线学习包括使用可用的数据,并在需要预测之前或在进行最后观察之后直接更新模型。

在线学习适用于那些随着时间推移提供观测,且观测的概率分布预计也会随时间变化的问题。因此,为了捕捉和利用这些变化,预计该模型将发生同样频繁的变化。

《Machine Learning: A Probabilistic Perspective》2012年

Traditionally machine learning is performed offline, which means we have a batch of data, and we optimize an equation […] However, if we have streaming data, we need to perform online learning, so we can update our estimates as each new data point arrives rather than waiting until “the end” (which may never occur).

传统的机器学习是脱机进行的,这意味着我们有一批数据,我们优化了一个方程[…]。然而,如果我们有流数据,我们需要执行在线学习,这样我们就可以在每个新的数据点到达时更新我们的估计值,而不是等到“结束”(这可能永远不会发生)。

这种方法也被算法所使用,在这些算法中,可能有更多的观测比合理地适合记忆,因此,学习是以增量的方式进行的,而不是像数据流这样的观测。

《Artificial Intelligence: A Modern Approach》2015年第三版

Online learning is helpful when the data may be changing rapidly over time. It is also useful for applications that involve a large collection of data that is constantly growing, even if changes are gradual.

当数据随着时间的迅速变化时,在线学习是有帮助的。它对于涉及大量数据收集的应用程序也很有用,这些数据集在不断增长,即使变化是渐进的。

一般来说,网上学习的目的是尽量减少“后悔,“这是模型的执行情况,而不是如果所有可用的信息都作为一个批处理可用的话,那么它的性能会有多好。

《Machine Learning: A Probabilistic Perspective》2012年

In the theoretical machine learning community, the objective used in online learning is the regret, which is the averaged loss incurred relative to the best we could have gotten in hindsight using a single fixed parameter value

在理论机器学习领域中,在线学习所使用的目标是遗憾,这是相对于我们使用单个固定参数值所能得到的最佳结果而言所遭受的平均损失。

在线学习的一个例子是所谓的随机或在线梯度下降,用于拟合人工神经网络。

《Deep Learning》 2016年

The fact that stochastic gradient descent minimizes generalization error is easiest to see in the online learning case, where examples or minibatches are drawn from a stream of data.

随机梯度下降使泛化误差最小化这一事实在在线学习案例中是最容易看到的,在这种情况下,示例或小批是从数据流中提取的。

13.转移学习

转移学习是一种学习,其中一个模型首先被训练在一个任务上,然后一部分或全部模型被用作相关任务的起点。

《Deep Learning》 2016年

In transfer learning, the learner must perform two or more different tasks, but we assume that many of the factors that explain the variations in P1 are relevant to the variations that need to be captured for learning P2.

在迁移学习中,学习者必须完成两个或更多不同的任务,但我们认为,解释P1变化的许多因素与学习P2所需捕捉的变体有关。

它是一个有用的方法,当有一个任务相关的主要任务感兴趣,而相关的任务有大量的数据。

它不同于多任务学习,因为任务是在迁移学习中顺序学习的,而多任务学习则是通过一个单一模型同时并行地对所有考虑的任务寻求良好的性能。

《Deep Learning》 2016年

pretrain a deep convolutional net with 8 layers of weights on a set of tasks (a subset of the 1000 ImageNet object categories) and then initialize a same-size network with the first k layers of the first net. All the layers of the second network (with the upper layers initialized randomly) are then jointly trained to perform a different set of tasks (another subset of the 1000 ImageNet object categories), with fewer training examples than for the first set of tasks.

在一组任务(1000 ImageNet对象类别的子集)上预先训练8层权重的深卷积网,然后用第一网的前k层初始化相同大小的网络。然后,对第二网络的所有层(上层随机初始化)进行联合训练,以执行不同的任务集(1000 ImageNet对象类别的另一个子集),并使用比第一组任务更少的训练示例。

一个例子是图像分类,其中一个预测模型,例如一个人工神经网络,可以在大量的一般图像上进行训练,当在一个较小的更具体的数据集上进行训练时,可以使用模型的权重作为起点,例如猫狗。模型在更广泛的任务上已经学习到的特征,如提取线条和模式,将有助于新的相关任务。

《Deep Learning》 2016年

If there is significantly more data in the first setting (sampled from P1), then that may help to learn representations that are useful to quickly generalize from only very few examples drawn from P2. Many visual categories share low-level notions of edges and visual shapes, the effects of geometric changes, changes in lighting, etc.

如果在第一个设置中有更多的数据(从P1中取样),那么这可能有助于学习表示,这些表示对于从P2中提取的非常少的例子快速概括是有用的。许多视觉类别共享边缘和视觉形状的低层次概念,几何变化的影响,照明的变化等。

如前所述,转移学习对于经过增量培训的模型尤其有用,现有模式可作为继续培训的起点,例如深度学习网络。

14.整体学习

集成学习是一种将两个或多个模式拟合在同一数据上,并将来自每个模型的预测结合在一起的一种方法。

《Deep Learning》 2016年

The field of ensemble learning provides many ways of combining the ensemble members’ predictions, including uniform weighting and weights chosen on a validation set.

集成学习领域提供了多种组合集成成员预测的方法,包括在验证集上选择均匀加权和权重。

集成学习的目的是通过集成模型来获得比任何单个模型更好的性能。这既包括决定如何创建集合中使用的模型,也包括如何最好地组合来自集成成员的预测。

《The Elements of Statistical Learning: Data Mining, Inference, and Prediction》 2016年 第二版

Ensemble learning can be broken down into two tasks: developing a population of base learners from the training data, and then combining them to form the composite predictor.

集合学习可以分解为两项任务:根据训练数据建立基础学习者群体,然后将它们组合起来形成复合预测器。

集成学习是提高问题域预测能力和减少随机学习算法(如人工神经网络)方差的一种有效方法。

一些流行的集成学习算法的例子包括:加权平均,叠加泛化(堆叠),以及引导聚合(套袋).

《Data Mining: Practical Machine Learning Tools and Techniques》 2016年 第四版

Bagging, boosting, and stacking have been developed over the last couple of decades, and their performance is often astonishingly good. Machine learning researchers have struggled to understand why.

在过去的几十年里,袋装、增压和堆叠技术都得到了发展,而且它们的表现往往是惊人的好。机器学习研究人员一直难以理解其中的原因。