一、NumPy

NumPy 是 Python 数值计算的基础包

1.ndarray

1.1.创建 ndarray

np.array

import NumPy as np

data1=[6,7,8,9,0,1]

arr1=np.array(data1)

data2=[[1,2,3,4],[5,6,7,8]]

arr2=np.array(data2)

d3=np.array((1.2,3.4,5,7))

除非特别说明,np.array 会尝试为新建的这个数组推断出一个较为合适的数据类型,数据类型保存在一个特殊的 dtype 对象中.比如

>>> arr1.dtype

dtype('int32')

>>> arr2.dtype

dtype('int32')

>>> d3.dtype

dtype('float64')

除 np.array之外,还有一些函数也可以新建数组.比如,zeros 和 ones 分别可以创建指定长度或形状的全 0 或全 1 数组,empty 可以创建一个没有任何具体值的数组,要用这些方法创建多维数组,只需传入一个表示形状的元组即可

np.zeros((3,6))

array([[0., 0., 0., 0., 0., 0.],

[0., 0., 0., 0., 0., 0.],

[0., 0., 0., 0., 0., 0.]])

>>> np.empty((2,3,2))

array([[[0., 0.],

[0., 0.],

[0., 0.]],

[[0., 0.],

[0., 0.],

[0., 0.]]])

arrange 是 内置函数 range 的数组版

>>> np.arange(15)

array([ 0, 1, 2, 3, 4, 5, 6, 7, 8, 9, 10, 11, 12, 13, 14])

1.2.ndarray的数据类型

dtype 是一个特殊的对象,它含有 ndarray 将一块内存解释为特定数据类型所需的信息

>>> arr1=np.array([1,2,3],dtype=np.float64)

>>> arr1

array([1., 2., 3.])

>>> arr1.dtype

dtype('float64')

dtype 是 NumPy 灵活交互其他系统的源泉之一.多数情况下,它们直接映射到对象的机器表示,这使得 “读写磁盘上的二进制数据流"以及"集成低级语言代码"等工作变得更见简单.数值型 dtype 的命名方式相同:一个类型名(如 float 和 int),后面跟一个用于表示各元素位长的数字,表述的双精度浮点值需要占用 8 个字节,即 64 位,因此,该类型在 NumPy 中就记作 float64.

可以使用 ndarry.astype 明确地将一个数组从一个 dtype 转换为另一个 dtype

arr=np.arange(5)

>>> arr.dtype

dtype('int32')

>>> float_arr=arr.astype(np.float64)

>>> float_arr.dtype

dtype('float64')

如果浮点数被转换为整数,则小数部分将被截取删除.如果字符串数组表示的全是数字,也可以使用 astype 将其转换为数值形式:

>>> numeric_strings=np.array(['1.25','9.6','7.7','3'])

>>> numeric_strings.astype(float)

array([1.25, 9.6 , 7.7 , 3. ])

如果转换过程因为某种原因而失败了,就会引发一个 ValueError

1.3.NumPy数组的运算

数组很重要,因为它使你不用编写循环即可对数据执行批量运算,NumPy 用户称其为矢量化.大小相等的数组之间的任何算术运算都会将运行应用到元素级:

>>> arr=np.array([[1,2,3],[4,5,6]])

>>> arr

array([[1, 2, 3],

[4, 5, 6]])

>>> arr*arr

array([[ 1, 4, 9],

[16, 25, 36]])

>>> arr-arr

array([[0, 0, 0],

[0, 0, 0]])

数组与标量间的算术运算会将标量值传播到各个元素

>>> arr*3

array([[ 3, 6, 9],

[12, 15, 18]])

大小相同的数组之间的比较会生成布尔数组

>>> arr2=np.array([[0,4,1],[2,4,6]])

>>> arr2>arr

array([[False, True, False],

[False, False, False]])

不同大小的数组之间的运算叫做广播,这里不做深入讨论

1.4.基本的索引和切片

NumPy 一维数组很简单,表面上看他们和 Python 列表的功能查不多

>>> a1=np.arange(10)

>>> a1

array([0, 1, 2, 3, 4, 5, 6, 7, 8, 9])

>>> a1[5]

5

>>> a1[3:6]

array([3, 4, 5])

>>> a1[5:8]=12

>>> a1

array([ 0, 1, 2, 3, 4, 12, 12, 12, 8, 9])

数组切片是原始数组的视图,这意味着数据不会被复制,视图上的任何修改都会直接反映到源数组上

>>> arr_slice=a1[5:8]

>>> arr_slice

array([12, 12, 12])

>>> arr_slice[1]=1234

>>> a1

array([ 0, 1, 2, 3, 4, 12, 1234, 12, 8, 9])

如果想要得到的是 ndarray 的一份副本而非视图,需要明确进行复制

newa1=a1[5:8].copy()

对于二维数组,下面的两种方式是等价的

>>> arr2d=np.array([[1,2,3],[4,5,6]])

>>> arr2d[0,2]

3

>>> arr2d[0][2]

3

1.5.切片索引

ndarray 的切片语法与 Python 列表这样的一维对象差不多

>>> a1

array([ 0, 1, 2, 3, 4, 12, 1234, 12, 8, 9])

>>> a1[1:6]

array([ 1, 2, 3, 4, 12])

对于二维数组,切片方式稍有不同

>>> arr2d=np.array([[1,2,3,4],[5,6,7,8],[9,10,11,12]])

>>> arr2d[:2]

array([[1, 2, 3, 4],

[5, 6, 7, 8]])

>>> arr2d[:2,1:]

array([[2, 3, 4],

[6, 7, 8]])

可以理解为切片是沿着一个轴选取元素的,例如,可以选取第二行的前两列

>>> arr2d[1,:2]

array([5, 6])

1.6.布尔型索引

假设我们有一个用于存储数据的数组以及一个存储姓名的数组,这里可以使用 np.ramdom中的 randn 函数生成一些正态分布的随机数据

>>> names=np.array(['Bob','Jack','Will','Joe','Tim'])

>>> data=np.random.randn(5,4)

>>> names

array(['Bob', 'Jack', 'Will', 'Joe', 'Tim'], dtype='<U4')

>>> data

array([[ 0.78667694, -0.89465253, 0.04595273, -0.70866619],

[-0.24614004, -0.06740967, 0.27178199, -0.34001949],

[ 0.26853935, -1.44356176, 1.37335606, 0.44868366],

[ 1.23932028, -0.49224827, -0.1345172 , -0.66206581],

[ 0.61680412, -0.13877081, 0.1485935 , -0.98164137]])

假设每个名字都对应 data 数组中的一行,而我们想要选出对应名字 ‘Bob’ 的所有行.跟算术运算一样,数组的比较运算也是矢量化的.因此,对于 name 和 字符串 “Bob” 的比较运算将产生一个布尔型数组,这个数组可以用于数组索引

>>> names=='Bob'

array([ True, False, False, False, False])

>>> data[names=='Bob']

array([[ 0.78667694, -0.89465253, 0.04595273, -0.70866619]])

布尔型数组的长度必须与被索引的轴长度一致.此外,还可以将布尔型数组跟切片,整数(或整数序列)混合使用

>>> data[names=='Bob',2:]

array([[ 0.04595273, -0.70866619]])

>>> data[names!='Bob']

array([[-0.24614004, -0.06740967, 0.27178199, -0.34001949],

[ 0.26853935, -1.44356176, 1.37335606, 0.44868366],

[ 1.23932028, -0.49224827, -0.1345172 , -0.66206581],

[ 0.61680412, -0.13877081, 0.1485935 , -0.98164137]])

也可以使用 ~ 操作符作为反转条件

>>> cond=names=='Bob'

>>> data[~cond]

array([[-0.24614004, -0.06740967, 0.27178199, -0.34001949],

[ 0.26853935, -1.44356176, 1.37335606, 0.44868366],

[ 1.23932028, -0.49224827, -0.1345172 , -0.66206581],

[ 0.61680412, -0.13877081, 0.1485935 , -0.98164137]])

运用多个组合条件时,使用 &、| 之类的布尔运算符即可(不支持关键字 and 和 or)

>>> data[(names=='Bob')|(names=='Will')]

array([[ 0.78667694, -0.89465253, 0.04595273, -0.70866619],

[ 0.26853935, -1.44356176, 1.37335606, 0.44868366]])

为了将 data 中的所有负值设为0,只需

>>> data[data<0]=0

>>> data

array([[0.78667694, 0. , 0.04595273, 0. ],

[0. , 0. , 0.27178199, 0. ],

[0.26853935, 0. , 1.37335606, 0.44868366],

[1.23932028, 0. , 0. , 0. ],

[0.61680412, 0. , 0.1485935 , 0. ]])

1.7.花式索引

花式索引 是一个 NumPy 术语,它指的是利用整数数组进行索引,假设有一个 8x4 数组

>>> arr=np.empty((8,4))

>>> for i in range(8):

... arr[i]=i

>>> arr

array([[0., 0., 0., 0.],

[1., 1., 1., 1.],

[2., 2., 2., 2.],

[3., 3., 3., 3.],

[4., 4., 4., 4.],

[5., 5., 5., 5.],

[6., 6., 6., 6.],

[7., 7., 7., 7.]])

为了以特定顺序选取子集,只需传入一个用于指定顺序的整数列表为 ndarray 即可

>>> arr[[4,3,0,6]]

array([[4., 4., 4., 4.],

[3., 3., 3., 3.],

[0., 0., 0., 0.],

[6., 6., 6., 6.]])

>>> arr[[-3,-5,-7]]

array([[5., 5., 5., 5.],

[3., 3., 3., 3.],

[1., 1., 1., 1.]])

一次传入多个索引数组会有一点特别,它返回的是一个一维数组,其中的元素对应各个索引元组

>>> arr=np.arange(32).reshape((8,4))

>>> arr

array([[ 0, 1, 2, 3],

[ 4, 5, 6, 7],

[ 8, 9, 10, 11],

[12, 13, 14, 15],

[16, 17, 18, 19],

[20, 21, 22, 23],

[24, 25, 26, 27],

[28, 29, 30, 31]])

>>> arr[[1,5,7,2],[0,3,1,2]]

array([ 4, 23, 29, 10])

最终选取的是元素(1,0),(5,3),(7,1),(2,2).无论数组是多少维的,花式索引总是一维的.这个花式索引的行为可能与我们期望的不一样,选取矩阵的行列子集应该是矩形区域的形才对,下面是得到该结果的一个方法

>>> arr[[1,5,7,2]][:,[0,3,1,2]]

array([[ 4, 7, 5, 6],

[20, 23, 21, 22],

[28, 31, 29, 30],

[ 8, 11, 9, 10]])

花式索引与切片不同,它总是将数据复制到新数组中

1.8.数组转置和轴对称

转置是重塑的一种特殊形式,它返回的是源数据的视图.数组不仅有 transpose 方法,还有一个特殊的 T 属性

>>> arr=np.arange(15).reshape((3,5))

>>> arr

array([[ 0, 1, 2, 3, 4],

[ 5, 6, 7, 8, 9],

[10, 11, 12, 13, 14]])

>>> arr.T

array([[ 0, 5, 10],

[ 1, 6, 11],

[ 2, 7, 12],

[ 3, 8, 13],

[ 4, 9, 14]])

进行矩阵计算时,经常需要用到该操作,比如用 np.dot 计算矩阵内积

>>> arr=np.random.randn(6,3)

>>> arr

array([[-1.05379508, -2.22022699, 0.74830555],

[-1.5887828 , 2.08855534, -0.23345742],

[ 0.01365803, -0.65193559, 0.64825581],

[ 1.98834876, -0.83723806, 0.93235855],

[-0.8361967 , 1.04227256, 0.43267013],

[ 1.40133596, 0.33984628, 2.09784193]])

>>> np.dot(arr.T,arr)

array([[10.25139958, -3.04752799, 4.02304426],

[-3.04752799, 11.61928646, -2.18832004],

[ 4.02304426, -2.18832004, 6.49213582]])

对于高位数组,transpose 需要得到一个由轴编号组成的元组才能对这些轴进行转置

>>> arr=np.arange(16).reshape((2,2,4))

>>> arr

array([[[ 0, 1, 2, 3],

[ 4, 5, 6, 7]],

[[ 8, 9, 10, 11],

[12, 13, 14, 15]]])

>>> arr.transpose((1,0,2))

array([[[ 0, 1, 2, 3],

[ 8, 9, 10, 11]],

[[ 4, 5, 6, 7],

[12, 13, 14, 15]]])

这里第一个轴被换成了第二个,第二个轴被换成了第一个,子u后一个轴不变

简单的转置可以使用 .T,它其实就是进行轴对换而已。ndarray 还有一个 swapaxes 方法,它需要接受一对轴编号

>>> arr

array([[[ 0, 1, 2, 3],

[ 4, 5, 6, 7]],

[[ 8, 9, 10, 11],

[12, 13, 14, 15]]])

>>> arr.swapaxes(1,2)

array([[[ 0, 4],

[ 1, 5],

[ 2, 6],

[ 3, 7]],

[[ 8, 12],

[ 9, 13],

[10, 14],

[11, 15]]])

swapaxes 也是返回源数据的视图(不会进行任何复制操作)

2.通用函数:快速的元素级数组函数

通用函数(即ufunc)是一种对 ndarray 中数据执行元素级运算的函数.可以将其看作一个简单函数的矢量化包装器,许多 ufunc 都是简单的元素级变体,如 sqrt 和 exp

>>> arr=np.arange(10)

>>> arr

array([0, 1, 2, 3, 4, 5, 6, 7, 8, 9])

>>> np.sqrt(arr)

array([0. , 1. , 1.41421356, 1.73205081, 2. ,

2.23606798, 2.44948974, 2.64575131, 2.82842712, 3. ])

>>> np.exp(arr)

array([1.00000000e+00, 2.71828183e+00, 7.38905610e+00, 2.00855369e+01,

5.45981500e+01, 1.48413159e+02, 4.03428793e+02, 1.09663316e+03,

2.98095799e+03, 8.10308393e+03])

这些都是一元 unfunc。另外一些如 add 或 maximum 接受两个数组,并返回一个结果数组

>>> x=np.random.randn(8)

>>> y=np.random.randn(8)

>>> x

array([-0.48107306, 0.75461704, -0.4909556 , 0.06156705, 0.24418227,

0.06613 , -0.81159631, -0.35049848])

>>> y

array([ 1.0264434 , -0.29667443, 1.23448712, 0.26938702, 0.00835983,

-0.89374578, 0.21309029, 0.4258789 ])

>>> np.maximum(x,y)

array([1.0264434 , 0.75461704, 1.23448712, 0.26938702, 0.24418227,

0.06613 , 0.21309029, 0.4258789 ])

这里 np.maximum 计算了 x 和 y 中元素级别最大的元素

虽然并不常见,但有些 ufunc 的确可以返回多个数组。modf 就是一个例子,它是 Python 内置函数 divmod 的矢量化版本,它会返回浮点数数组的小数和整数部分

>>> arr=np.random.randn(7)*5

>>> arr

array([ 3.62417129, 13.73401592, 0.220063 , 0.44405971, 3.5043984 ,

-0.62760798, 7.59859361])

>>> remainder,whole_part=np.modf(arr)

>>> remainder

array([ 0.62417129, 0.73401592, 0.220063 , 0.44405971, 0.5043984 ,

-0.62760798, 0.59859361])

>>> whole_part

array([ 3., 13., 0., 0., 3., -0., 7.])

其他函数见 https://www.cnblogs.com/WSX1994/articles/9061516.html

3.利用数组进行数据处理

NumPy 数组使你可以将许多数据处理任务表述为简洁的数组表达式.用数组表达式代替循环的做法,通常被称为矢量化.一般来说,矢量化数组运算要比等价的纯 Python 方式快一两个数量级,尤其是各种数值计算.

作为简单的例子,假设我们想要在一组值(网格型)上计算函数 sqrt(x2+y2),np.meshgrid 函数接受两个一维数组,并产生两个二维矩阵,对应两个数组中的所有(x,y)对

>>> points=np.arange(-5,5,0.01)

>>> xs,ys=np.meshgrid(points,points)

>>> ys

array([[-5. , -5. , -5. , ..., -5. , -5. , -5. ],

[-4.99, -4.99, -4.99, ..., -4.99, -4.99, -4.99],

[-4.98, -4.98, -4.98, ..., -4.98, -4.98, -4.98],

...,

[ 4.97, 4.97, 4.97, ..., 4.97, 4.97, 4.97],

[ 4.98, 4.98, 4.98, ..., 4.98, 4.98, 4.98],

[ 4.99, 4.99, 4.99, ..., 4.99, 4.99, 4.99]])

>>> z=np.sqrt(xs**2+ys**2)

>>> z

array([[7.07106781, 7.06400028, 7.05693985, ..., 7.04988652, 7.05693985,

7.06400028],

[7.06400028, 7.05692568, 7.04985815, ..., 7.04279774, 7.04985815,

7.05692568],

[7.05693985, 7.04985815, 7.04278354, ..., 7.03571603, 7.04278354,

7.04985815],

...,

[7.04988652, 7.04279774, 7.03571603, ..., 7.0286414 , 7.03571603,

7.04279774],

[7.05693985, 7.04985815, 7.04278354, ..., 7.03571603, 7.04278354,

7.04985815],

[7.06400028, 7.05692568, 7.04985815, ..., 7.04279774, 7.04985815,

7.05692568]])

3.1.将逻辑表述为数组运算

np.where 函数是三元表达式 x if condition else y 的矢量化版本.假设有一个布尔数组和两个值数组

>>> xarr=np.array([1.1,1.2,1.3,1.4,1.5])

>>> yarr=np.array([2.1,2.2,2.3,2.4,2.5])

>>> cond=np.array([True,False,True,True,False])

假设我们想要根据 cond 中的值选取 xarr 和 yarr 的值:当 cond 中的值为 True 时,选取 xarr 的值,否则从 yarr 中选取.列表推导式的写法应该如下

>>> result=[(x if c else y) for x,y,c in zip(xarr,yarr,cond)]

>>> result

[1.1, 2.2, 1.3, 1.4, 2.5]

这有几个问题.第一,它对大数组的处理速度不是很快(因为所有工作都是由 Python 完成的).第二,无法用于多维数组.若使用 np.where,则可以将该功能写得非常简洁

>>> result=np.where(cond,xarr,yarr)

>>> result

array([1.1, 2.2, 1.3, 1.4, 2.5])

np.where 的第二个和第三个参数不必是数组,他们都可以是标量值.在数据分析工作中,where 通常用于根据另一个数组而产生一个新的数组.假设有一个由随机数据组成的矩阵,希望将所有正值替换为 2,将所有的负值替换为 -2,若利用 np.where,则会非常简单

>>> arr=np.random.randn(4,4)

>>> arr

array([[-6.81187446e-04, -3.08173177e-02, 1.94670113e+00,

9.17937213e-01],

[ 2.91347928e-01, 5.33416809e-01, -1.65383139e-03,

-5.18703508e-01],

[ 2.79722394e-01, 4.52300258e-01, -9.86292591e-01,

-8.88423776e-01],

[-3.07760163e-01, 1.58389627e+00, -1.75546309e-01,

1.39253356e-01]])

>>> arr>0

array([[False, False, True, True],

[ True, True, False, False],

[ True, True, False, False],

[False, True, False, True]])

>>> np.where(arr>0,2,-2)

array([[-2, -2, 2, 2],

[ 2, 2, -2, -2],

[ 2, 2, -2, -2],

[-2, 2, -2, 2]])

利用 np.where,可以将标量和数组结合起来.例如,可以使用常数 2 替换 arr 中所有正的值

>>> np.where(arr>0,2,arr)

array([[-6.81187446e-04, -3.08173177e-02, 2.00000000e+00,

2.00000000e+00],

[ 2.00000000e+00, 2.00000000e+00, -1.65383139e-03,

-5.18703508e-01],

[ 2.00000000e+00, 2.00000000e+00, -9.86292591e-01,

-8.88423776e-01],

[-3.07760163e-01, 2.00000000e+00, -1.75546309e-01,

2.00000000e+00]])

传递给 where 的数组大小可以不相等,甚至可以是标量值

3.2.数学和统计方法

可以通过数组上的一组数学函数对整个数组或轴向的数据进行统计计算。sum,mean,以及标准差 std 等聚合计算,(通常也叫做约简)既可以当作数组的实例化方法使用,也可以当作顶级的 NumPy 函数使用

>>> arr=np.random.randn(5,4)

>>> arr

array([[-3.23434804, -0.64442005, 0.42145953, -0.11863871],

[-0.02168163, 0.50264785, -0.69081768, 0.65468194],

[ 0.05753042, -0.2800016 , 0.48061392, 0.56035693],

[-0.40486474, 0.23107818, 1.79671592, 0.23704017],

[-0.07259393, 0.63497811, 0.04348496, 0.61579049]])

>>> arr.mean()

0.03845060250384825

>>> np.mean(arr)

0.03845060250384825

>>> arr.sum()

0.7690120500769649

mean 和 sum 这类函数可以接受一个 axis 选项参数用,用于计算该轴向上的统计值,最终结果是一个少一维的数组

>>> arr.mean(axis=1)

array([-0.89398682, 0.11120762, 0.20462492, 0.46499238, 0.30541491])

>>> arr.sum(axis=0)

array([-3.67595792, 0.4442825 , 2.05145666, 1.94923082])

这里 arr.mean(1) 是计算行的平均值,arr.sum(0) 是计算每列的和

- axis 不设置值,对 m*n 个数求均值,返回一个实数

- axis = 0:压缩行,对各列求均值,返回 1* n 矩阵

- axis =1 :压缩列,对各行求均值,返回 m *1 矩阵

其他如 cumsum 和 cumprod 之类的方法则不聚合,而是产生一个由中间结果组成的数组

>>> arr=np.array([0,1,2,3,4,5,6,7])

>>> arr.cumsum()

array([ 0, 1, 3, 6, 10, 15, 21, 28], dtype=int32)

在多维数组中,累加函数 cumsum 返回的是同样大小的数组,但是会根据每个低纬的切片沿着标记轴计算部分聚类:

>>> arr.cumsum(axis=0)

array([[ 0, 1, 2],

[ 3, 5, 7],

[ 9, 12, 15]], dtype=int32)

>>> arr.cumprod(axis=1)

array([[ 0, 0, 0],

[ 3, 12, 60],

[ 6, 42, 336]], dtype=int32)

更多基本的数组统计方法见 https://blog.csdn.net/weixin_30449239/article/details/99033428

3.3.用于布尔型数组的方法

在上面这些方法中,布尔值会被强制转换为 1 和 0。因此,sum 经常用来对布尔型数组中的 True 值计数

>>> arr=np.random.randn(100)

>>> (arr>0).sum()

47

另外还有两个方法 any 和 all,它们对布尔型数组非常有用。any 用于测试数组中是否存在一个或多个 True,而 all 检查是否全为 True

>>> bools=np.array([False,False,True])

>>> boos.any()

>>> bools.any()

True

>>> bools.all()

False

这两个方法也能用于非布尔型数组,所有非 0 元素将会被当作 True

3.4.排序

与 Python 的内置列表类型一样,NumPy 数组也可以通过 sort 方法就地进行排序

>>> arr=np.random.randn(6)

>>> arr

array([ 0.19241435, -1.97750926, -2.19373232, 0.16377065, -1.53856866,

0.85725756])

>>> arr.sort()

>>> arr

array([-2.19373232, -1.97750926, -1.53856866, 0.16377065, 0.19241435,

0.85725756])

多维数组可以在任何一个轴向上进行排序,只需要将轴编号传递给 sort 即可

>>> arr=np.random.randn(5,3)

>>> arr

array([[ 1.65867043, -1.52429008, -0.76280479],

[ 0.16523488, 1.00124376, -0.91270849],

[-0.66346771, -1.52085457, 0.11703748],

[ 1.00249776, 0.12546034, -1.02326127],

[ 0.69575876, 0.54695987, -0.333557 ]])

>>> arr.sort(1)

>>> arr

array([[-1.52429008, -0.76280479, 1.65867043],

[-0.91270849, 0.16523488, 1.00124376],

[-1.52085457, -0.66346771, 0.11703748],

[-1.02326127, 0.12546034, 1.00249776],

[-0.333557 , 0.54695987, 0.69575876]])

顶级方法 np.sort 返回的是数组的已排序副本,而就地排序则会修改数组本身,计算数组分位数最简单的方法是对其进行排序,然后选取特定位置的值

>>> large_arr=np.random.randn(1000)

>>> large_arr.sort()

>>> large_arr[int(0.05*len(large_arr))]

-1.6251383615945285

3.5.唯一化以及其他的集合逻辑

NumPy 提供了一些针对一维 ndarray 的基本集合运算.最常用的是 np.unique,它用于找出数组中的唯一值并返回已排序的结果

>> names=np.array(['Bob','Jack','Will','Joe','Tim',"Bob","Jack",'Will'])

>>> np.unique(names)

array(['Bob', 'Jack', 'Joe', 'Tim', 'Will'], dtype='<U4')

另一个函数 np.in1d 用于测试一个数组中的值在另一个数组中的成员资格,返回一个布尔型数组

>>> values=np.array([6,0,0,3,2,5,6])

>>> np.in1d(values,[2,3,6])

array([ True, False, False, True, True, False, True])

更多的集合函数见 https://blog.csdn.net/qq_43709590/article/details/115100035

4.用于数组的文件输入输出

NumPy 能够读写磁盘上的文本数据或二进制数据,文本或表格数据可以由 pandas 来处理,NumPy 内置的二进制格式是这节主要内容

np.save 和 np.load 是读写磁盘数组数据的两个主要函数.默认情况下,数组是以未压缩的原始二进制格式保存在扩展名为 .npy 的文件中的;如果文件路径末尾没有扩展名 .npy,则该扩展名会被自动加上,然后可以通过 np.load 读取磁盘上的数组

>>> arr=np.arange(10)

>>> np.save('array',arr)

>>> np.load('array.npy')

array([0, 1, 2, 3, 4, 5, 6, 7, 8, 9])

通过 np.savez 可以将多个数组保存到一个未压缩文件中,将数组以关键字形式存入即可,加载 npz 文件时,会得到一个类似字典的对象,该对象会对整个数组进行延迟加载

>>> np.savez('array_archive.npz',a=arr,b=arr)

>>> arch=np.load('array_archive.npz')

>>> arch['b']

array([0, 1, 2, 3, 4, 5, 6, 7, 8, 9])

>>> arch['a']

array([0, 1, 2, 3, 4, 5, 6, 7, 8, 9])

如果数据压缩得很好,就可以使用 NumPy.savez_compressed:

>>> np.savez_compressed('arr.npz')

5.线性代数

线性代数是任何数组库的重要部分.不像其他语言(如 MATALB),通过 * 对两个二维数组相乘得到的是一个元素级的积,而不是一个矩阵点积.因此,NumPy 提供了一个用于矩阵乘法的 dot 函数,它既是一个数组方法,也是 NumPy 命名空间中的一个函数

>>> x=np.array([[1,2,3],[4,5,6]])

>>> y=np.array([[6,23],[-1,7],[8,9]])

>>> x

array([[1, 2, 3],

[4, 5, 6]])

>>> y

array([[ 6, 23],

[-1, 7],

[ 8, 9]])

>>> x.dot(y)

array([[ 28, 64],

[ 67, 181]])

>>> np.dot(x,y)

array([[ 28, 64],

[ 67, 181]])

一个二维数组与一个大小合适的一维数组的矩阵点积运算之后将会得到一个一维数组

>>> np.dot(x,np.ones(3))

array([ 6., 15.])

@ 符,也可以作为中缀运算符,进行矩阵乘法

>>> x@np.ones(3)

array([ 6., 15.])

NumPy.linalg 中有一组标准的矩阵分解运算以及诸如求逆和行列式之类的东西,它们与 MATLAB 和 R 语言等所使用的是相同的行业标准线性代数库

>>> from NumPy.linalg import inv,qr

>>> x=np.random.randn(5,5)

>>> mat=x.T.dot(x)

>>> inv(mat)

array([[ 96.63610734, 345.17591916, 161.78594311, 82.8657469 ,

280.60713777],

[ 345.17591916, 1244.86817786, 585.92337162, 299.40742459,

1012.78357153],

[ 161.78594311, 585.92337162, 276.5027913 , 141.10741819,

476.96605779],

[ 82.8657469 , 299.40742459, 141.10741819, 72.2925602 ,

243.76338003],

[ 280.60713777, 1012.78357153, 476.96605779, 243.76338003,

824.46449201]])

>>> mat.dot(inv(mat))

array([[ 1.00000000e+00, -1.03358995e-13, -1.78262299e-13,

-5.06871841e-14, -1.30490998e-13],

[-1.35051120e-13, 1.00000000e+00, -5.54420381e-15,

1.23039466e-13, 1.83912356e-13],

[-1.01903888e-13, -2.32123454e-13, 1.00000000e+00,

-9.10686219e-14, -2.76929715e-13],

[ 4.90470196e-14, 1.04289400e-13, 1.57544077e-14,

1.00000000e+00, 1.75555899e-14],

[ 1.41972992e-14, -4.20330324e-13, 8.16715857e-14,

-1.44775684e-13, 1.00000000e+00]])

>>> q,r=qr(mat)

>>> r

array([[-5.40128252e+00, 4.00184911e+00, -6.59129408e+00,

8.01724308e-01, 4.98613800e-01],

[ 0.00000000e+00, -2.11046058e+00, -7.48076251e-01,

-1.61290880e+00, 3.50315675e+00],

[ 0.00000000e+00, 0.00000000e+00, -1.56581454e+00,

2.81687905e+00, 7.30735985e-02],

[ 0.00000000e+00, 0.00000000e+00, 0.00000000e+00,

-3.86877452e+00, 1.14391169e+00],

[ 0.00000000e+00, 0.00000000e+00, 0.00000000e+00,

0.00000000e+00, 6.94858441e-04]])

关于Numpy中的矩阵有:

使用 array:

对于一维向量

array * array 得到的是对应元素相乘的一维向量

array @ array 得到的是对应元素相乘的一维向量所有元素相加的和

对于高维数组

array * array 得到的是对应元素相乘的高维数组

array @ array 得到的是矩阵相乘的结果

- +,-,*,\ 作用于 array 一维以上的对象会是逐个元素处理

- @ 和 .dot 一样,表示的是矩阵乘法

- 处理向量时,array 中,矢量 1 ? N 1*N 1?N 和 N ? 1 N*1 N?1??? 不同,在一维的 array上,转置什么也不做。即对于一维数组(向量),a.T @ a 和 a @ a.T一样,得到的是数字

以下是官方回答:

NumPy 包含一个array类和一个matrix类。所述 array类旨在是通用n维阵列,用于许多种数值计算的,而matrix意在具体促进线性代数计算。在实践中,两者之间只有少数几个关键区别。

- 运算符

*and@、函数dot()和multiply():- 对于

array,\*表示逐元素乘法,而@表示矩阵乘法;它们具有相关的功能multiply()和dot()。(在 Python 3.5 之前,@不存在,必须dot()用于矩阵乘法)。 - 对于

matrix,\*表示矩阵乘法,对于逐元素乘法,必须使用该multiply()函数。

- 对于

- 处理向量(一维数组)

- 对于

array,矢量形状 1xN、Nx1 和 N 都是不同的东西。类似的操作A[:,1]返回一个形状为 N 的一维数组,而不是一个形状为 Nx1 的二维数组。在一维array上转置什么都不做。 - 对于

matrix,一维数组总是向上转换为 1xN 或 Nx1 矩阵(行或列向量)。A[:,1]返回形状为 Nx1 的二维矩阵。

- 对于

- 处理高维数组 (ndim > 2)

array对象的维数可以大于 2;matrix对象总是正好有两个维度。

- 便利属性

array有一个 .T 属性,它返回数据的转置。matrix还具有 .H、.I 和 .A 属性,它们分别返回asarray()矩阵的共轭转置、逆矩阵和矩阵。

- 便利构造器

- 该

array构造采用(嵌套)的Python序列初始化。如,array([[1,2,3],[4,5,6]])。 - 该

matrix构造还需要一个方便的字符串初始化。如matrix("[1 2 3; 4 5 6]").

- 该

两者都有利有弊:

array:)按元素乘法很容易:A*B.:(您必须记住,矩阵乘法有其自己的运算符@。:)你可以把一维数组作为任何行或列向量。视为列向量,而 视为行向量。这可以节省您输入大量移调的麻烦。A @ v``v``v @ A``v:)array是“默认”的 NumPy 类型,因此它得到最多的测试,并且是使用 NumPy 的第 3 方代码最有可能返回的类型。:)非常擅长处理任意维度的数据。:)在语义上更接近张量代数,如果你熟悉的话。:)所有操作(*,/,+,-等)的逐元素。:(来自的稀疏矩阵scipy.sparse不会与数组交互。

matrix:\\行为更像是 MATLAB 矩阵的行为。<:(二维的最大值。要保存您需要的三维数据,array或者可能是一个 Python 列表matrix。<:(二维的最小值。你不能有向量。它们必须转换为单列或单行矩阵。<:(由于array是 NumPy 中的默认值,因此array即使您将 amatrix作为参数,某些函数也可能返回a 。这不应该发生在 NumPy 函数中(如果它发生了,那就是一个错误),但是基于 NumPy 的 3rd 方代码可能不像 NumPy 那样尊重类型保留。:)A*B是矩阵乘法,所以它看起来就像你用线性代数写的一样(对于 Python >= 3.5 普通数组与@运算符具有相同的便利性)。<:(逐元素乘法需要调用函数multiply(A,B)。<:(运算符重载的使用有点不合逻辑:*不能按元素工作,但/可以。- 与的交互

scipy.sparse更干净一些。

将array因此更建议使用。事实上,我们打算matrix最终弃用。

更多的线性代数函数见 https://blog.csdn.net/weixin_45665432/article/details/105738079

6.伪随机数生成

np.random 模块对 Python 内置的 random 进行了补充,增加了一些用于高效生成多种概率分布的样本值的函数,例如,可以通过用 normal 来得到一个标准正太分布的4*4样本数组

>>> samples=np.random.normal(size=(4,4))

>>> samples

array([[-0.84175786, -0.82942681, 1.54383108, 0.42470515],

[-0.37866622, 0.67574588, 2.23220922, 0.46379467],

[ 0.10213208, 1.27697678, 0.1180446 , -0.13052506],

[ 0.83932778, 0.43247417, -1.15065155, -2.00549457]])

这些伪随机数都是在确定条件下生成的,可以使用 NumPy 的 np.random.seed 更改随机数种子,np.random 的数据生成函数使用了全局的随机种子,要想避免全局状态,可以使用 np.random.RandomState,创建一个与其它隔离的随机数生成器

>>> rng=np.random.RandomState(1234)

>>> rng.randn(10)

array([ 0.47143516, -1.19097569, 1.43270697, -0.3126519 , -0.72058873,

0.88716294, 0.85958841, -0.6365235 , 0.01569637, -2.24268495])

7.示例:随机漫步

通过模拟来说明如何运用数组运算,这是一个简单的随机漫步例子:从0开始,步长1和-1出现的概率相等,下面通过 random 模块实现

import random

import matplotlib.pyplot as plt

position=0

walk=[position]

steps=1000

for i in range(steps):

step=1 if random.randint(0,1) else -1

position+=step

walk.append(position)

plt.plot(walk[:1000])

plt.show()

可以使用 np.random 模块一次随机生成 1000 个 “掷硬币” 结果,将其设为0 和 1,然后计算累加和

>>> nsteps=1000

>>> draws=np.random.randint(0,2,size=nsteps)

>>> steps=np.where(draws>0,1,-1)

>>> walk=steps.cumsum()

>>> walk.min()

-1

>>> walk.max()

51

现在有一个更复杂的统计任务 首次穿越时间,即随机漫步过程中第一次到大某个特定值的时间.假设想要知道本次随机漫步需要多久才能距离初始值0至少10步远,np.abs(walk)>=10可以得到一个布尔型数组,它表示的是距离是否达到或超过10,而我们想要的是第一个10或-10的索引,可以使用argmax来解决这个问题,它返回的是该布尔型数组第一个最大值的索引

>>> (np.abs(walk>=10)).argmax()

23

一次模拟多个随机漫步

如果希望模拟多个随机漫步过程(比如5000个),只需对上面的代码做一点点修改即可生成所有的随机漫步过程.只要给np.random的函数传入一个二元元组就可以产生一个二维数组,然后我们就可以一次性计算5000个随机漫步过程(一行一个)的累计和了

>>> nwalks=5000

>>> nsteps=1000

>>> draws=np.random.randint(0,2,size=(nwalks,nsteps))

>>> steps=np.where(draws>0,1,-1)

>>> walks=steps.cumsum(1)

>>> walks

array([[ -1, 0, -1, ..., -38, -39, -38],

[ 1, 2, 1, ..., -76, -77, -76],

[ 1, 0, 1, ..., 32, 33, 34],

...,

[ 1, 2, 3, ..., -26, -25, -26],

[ -1, -2, -3, ..., 24, 25, 26],

[ -1, -2, -3, ..., -62, -61, -62]], dtype=int32)

>>> walks.max()

114

>>> walks.min()

-114

二、pandas入门

pandas 是后续内容的首选库,它包含使数据清洗和分析工作变得更快更简单的数据结构和操作工具.pandas 经常和其他的工具一同使用,比如数值计算工具 NumPy和SciPy,分析库statsmodels和scikit-learn和数据可视化库matplotlib.pandas是基于NumPy数组构建的,特别是基于数组的函数和不使用for循环的数据处理,二者最大的不同是pandas是专门为处理表格和混杂数据设计的,而Numpy更适合处理统一的数值数组数据.因为 Series 和 DataFrame 用的次数非常多,所以将其引入本地命名空间会非常方便

>>> import pandas as pd

>>> from pandas import Series,DataFrame

1.pandas的数据结构介绍

pandas的两个主要数据结构是Series和DataFrame,它们为大多数应用提供了一种可靠的易于使用的基础

1.1.Series

Series是一中类似于一维数组的对象,它由一组数据(各种NumPy数据类型)以及一组与之相关的数据标签(即索引)组成.

>>> obj=Series([4,7,-5,3])

>>> obj

0 4

1 7

2 -5

3 3

dtype: int64

Series的字符串表现形式为:索引在左边,值在右边.由于我们没有为数据指定索引,于是会自动创建一个0到N-1的整数型索引,可以通过Series的values和index属性获取其数组表示形式和索引对象

>>> obj.values

array([ 4, 7, -5, 3], dtype=int64)

>>> obj.index

RangeIndex(start=0, stop=4, step=1)

通常,我们希望所创建的Series带有一个可以对各个数据点进行标记的索引

>>> obj2=Series([4,7,-5,2],index=['d','b','a','c'])

>>> obj2

d 4

b 7

a -5

c 2

dtype: int64

和普通NumPy数组相比,可以通过索引的方式选取Series中的单个或一组值

>>> obj2['a']

-5

>>> obj2['d']=6

>>> obj2[['c','a','d']]

c 2

a -5

d 6

dtype: int64

[‘c’,‘a’,‘d’]是索引列表,即使它包含的是字符串而不是整数

使用NumPy函数或类似NumPy的运算(如根据布尔型数组进行过滤,标量乘法,应用数学函数等)都会保留索引值的链接

>>> obj2[obj2>0]

d 6

b 7

c 2

dtype: int64

>>> obj2*2

d 12

b 14

a -10

c 4

dtype: int64

d 403.428793

b 1096.633158

a 0.006738

c 7.389056

dtype: float64

还可以将Series看成是一个定长的有序字典,因为它是索引值到数据值的一个映射,它可以用在许多原本需要字典参数的函数中,也可以通过字典创建Series

>>> 'b' in obj2

True

>>> 'e' in obj2

False

>>> data={'age':12,'name':'ys','sex':'m'}

>>> obj3=Series(data)

>>> obj3

age 12

name ys

sex m

dtype: object

如果之传入一个字典,则结果Series中的索引就是原字典的键(有序排列),可以传入排好序的字典的键以改变顺序

>>> xdata=['age','sex','grade']

>>> obj4=Series(data,index=xdata)

>>> obj4

age 12

sex m

grade NaN

在这个例子中,xdata中与data匹配的值会被找到并放在相应的位置上,找不到结果就为NaN(即"非数字"),在pandas中,它表示缺少或NA值,可以使用pandas的isnull和notnull函数检测缺失数据,也可以使用Series中的实例方法

>>> pd.isnull(obj4)

age False

sex False

grade True

dtype: bool

>>> pd.notnull(obj4)

age True

sex True

grade False

dtype: bool

>>> obj4.isnull()

age False

sex False

grade True

dtype: bool

对许多应用而言,Series最重要的一个功能是,它会更具运算的索引标签自动对齐数据

>>> obj3

age 12

name ys

sex m

dtype: object

>>> obj4

age 12

sex m

grade NaN

dtype: object

>>> obj3+obj4

age 24

grade NaN

name NaN

sex mm

dtype: object

Series对象本身及其索引都有一个name属性,该属性与pandas其他的关键功能关系非常密切

>>> obj4.name='YS'

>>> obj4.index.name='data'

>>> obj4

data

age 12

sex m

grade NaN

Name: YS, dtype: object

1.2.DataFrame

DataFrame是一个表格型的数据结构,它含有一组有序的列,每列可以是不同的值类型(数值,字符串,布尔值等).DataFrame既有行索引又有列索引,它可以被看做是由Series组成的字典(公用一个索引),DataFrame中的数据是一个或多个二维块存放的(而不是列表,字典或别的一维数据结构).但也可以轻松地将其表示为更高维的数据.

创建DataFrame的方法由很多,最常用的一种是直接传入一个由等长列表或NumPy数组组成的字典

>>> data={'name':['小李子','小罗伯特唐尼','艾玛'],

... 'age':['11','22','33'],

... 'salary':[200,300,400]}

>>> frame=DataFrame(data)

>>> frame

name age salary

0 小李子 11 200

1 小罗伯特唐尼 22 300

2 艾玛 33 400

对于特别大的DataFrame,head方法会选择前五行

>>> frame.head()

name age salary

0 小李子 11 200

1 小罗伯特唐尼 22 300

2 艾玛 33 400

如果指定了列,DataFrame的列就会按照指定顺序进行排列

>>> DataFrame(data,columns=['age','name','salary'])

age name salary

0 11 小李子 200

1 22 小罗伯特唐尼 300

2 33 艾玛 400

如果传入的列在数据中找不到,就会在结果中产生缺失值

age salary name debt

one 11 200 小李子 NaN

two 22 300 小罗伯特唐尼 NaN

three 33 400 艾玛 NaN

通过类似字典标记的方式或属性的方式,可以将DataFrame的列获取为一个Series:

>>> frame2['name']

one 小李子

two 小罗伯特唐尼

three 艾玛

Name: name, dtype: object

>>> frame2.age

one 11

two 22

three 33

Name: age, dtype: object

返回的Series拥有原DataFrame相同的索引,且其name属性也已经被相应的设计号了,行也可以通过位置或名称的方式获取,比如用loc属性

>>> frame2.loc['three']

age 33

salary 400

name 艾玛

debt NaN

Name: three, dtype: object

列可以通过赋值的方式进行修改,例如,可以给空的’debt’列赋上一个标量值或一组值

>>> frame2['debt']=1

>>> frame2

age salary name debt

one 11 200 小李子 1

two 22 300 小罗伯特唐尼 1

three 33 400 艾玛 1

>>> frame2['debt']=np.arange(3)

>>> frame2

age salary name debt

one 11 200 小李子 0

two 22 300 小罗伯特唐尼 1

three 33 400 艾玛 2

将列表赋或数组赋给某个列时,其长度必须与DataFrame的长度相匹配,如果赋值的是一个Series,就会精确匹配DataFrame的索引,所有的空位将被填上缺少值

>>> val=Series([1.2,3.4,5.6],index=['two','one','three'])

>>> frame2['debt']=val

>>> frame2

age salary name debt

one 11 200 小李子 3.4

two 22 300 小罗伯特唐尼 1.2

three 33 400 艾玛 5.6

为不存在的列赋值会创建出一个新列,关键字del用于删除列,作为del的例子,先添加一个新的布尔值的列,salary是否为300:

>>> frame2['Bool']=frame2.salary==200

>>> frame2

age salary name debt Bool

one 11 200 小李子 3.4 True

two 22 300 小罗伯特唐尼 1.2 False

three 33 400 艾玛 5.6 False

>>> del frame2['Bool']

>>> frame2.columns

Index(['age', 'salary', 'name', 'debt'], dtype='object')

另一种常见的数据形式是嵌套字典,pandas会被解释为外层字典的键作为列索引,内层键则作为行索引:

>>> pop={'age':{'艾玛':33,'钢铁侠':11,'小李子':22},'salary':{'钢铁侠':100,'艾玛':300,'小李子':200}}

>>> frame3=DataFrame(pop)

>>> frame3

age salary

艾玛 33 300

钢铁侠 11 100

小李子 22 200

也可以是使用类似NumPy数组的方法,对DataFrame进行转置

>>> frame3.T

艾玛 钢铁侠 小李子

age 33 11 22

salary 300 100 200

内层字典的键会被合并,排序以形成最终的索引,如果明确指定了索引,则不会这样,则不会这样

age salary

钢铁侠 11.0 100.0

艾玛 33.0 300.0

杨森 NaN NaN

由Series组成的字典差不多也是一样的用法,下面是DataFrame构造函数所能接受的各种数据

下表是DataFrame构造函数所能接受的各种数据。

| 类型 | 说明 |

|---|---|

| 二维ndarray | 数据矩阵,还可以传入行标和列标 |

| 由数组、列表或元组组成的字典 | 每个序列会变成Datarame的一列,所有序列的长度必须相同。 |

| NumPy的结构化/记录数组 | 类似于“由数组组成的字典” |

| 由Series组成的字典 | 每个Series会称为一列,如果没有显示指定索引,则各Series的索引会被合并成结果的行索引。 |

| 由字典组成的字典 | 各内层字典会成为一列,键会被合并成结果的行索引,跟“由Series组成的字典”的情况一样。 |

| 字典或Series的列表 | 各项将会成为DataFrame的一行,字典键或Series索引的并集将会成为DataFrame的列标。 |

| 由列表或元组组成的列表 | 类似于“二维ndarray” |

| 另一个DataFrame | 该DataFrame的索引将被沿用,除非显示指定了其他索引 |

| NumPy的MaskedArray | 类似于“二维ndarray”的情况,知识掩码值在结果DataFrame会变成Na/缺省值。 |

如果设置了DataFrame的index和columns的name属性,则这些信息也会被显示出来

>>> frame3.index.name='data'

>>> frame3.columns.name='xdata'

>>> frame3

xdata age salary

data

艾玛 33 300

钢铁侠 11 100

小李子 22 200

跟Series一样,values属性也会以二维ndarray的形式返回DataFrame中的数据

>>> frame3.values

array([[ 33, 300],

[ 11, 100],

[ 22, 200]], dtype=int64)

如果DataFrame各列的数据类型不同,则值数组中的dtype就会选择能兼容所有列的数据类型

>>> frame2.values

array([['11', 200, '小李子', 3.4],

['22', 300, '小罗伯特唐尼', 1.2],

['33', 400, '艾玛', 5.6]], dtype=object)

1.3.索引对象

pandas的索引对象负责管理轴标签和其他元数据(比如轴名称等).构建Series或DataFrame时,所用到的任何数组或其他序列的标签都会被转换成一个 index

>>> obj=Series(range(3),index=['a','b','c'])

>>> index=obj.index

>>> index

Index(['a', 'b', 'c'], dtype='object')

index对象是不可变的,不能对其进行修改,这可以使得 index 对象在多个数据结构之间安全共享

>>> labels=pd.Index(np.arange(3))

>>> labels

Int64Index([0, 1, 2], dtype='int64')

>>> obj2=Series([1.5,-2.4,0],index=labels)

>>> obj2

0 1.5

1 -2.4

2 0.0

dtype: float64

>>> obj2.index is labels

True

除了类似于数组,index的功能也类似一个固定大小的集合

>>> frame3

xdata age salary

data

艾玛 33 300

钢铁侠 11 100

小李子 22 200

>>> frame3.columns

Index(['age', 'salary'], dtype='object', name='xdata')

>>> 'age' in frame3.columns

True

>>> 300 in frame3.columns

False

与 Python中的集合不同的是,pandas的index可以包含重复的标签

>>> dup_labels=pd.Index(['foo','foo','bar'])

>>> dup_labels

Index(['foo', 'foo', 'bar'], dtype='object')

选择重复的标签,会显示所有的结果,每个索引都有一些方法和属性,它们可以用于设置逻辑并回答有关该索引所包含的数据的常见问题

append 连接另一个index对象,产生一个新的index

difference 计算差集,并得到一个index

intersection 计算交集

union 计算并集

isin 计算一个指示各值是否都包含在参数集合中的布尔型数组

delete 删除索引i处的元素,并得到新的index

drop 删除传入的值,并得到新的index

insert 将元素插入到索引i处,并得到新的index

is_monnotonic 当各元素均大于等于前一个元素时,返回True

is_unique 当index没有重复值时,返回True

unique 计算index中唯一值的数

2.基本功能

本节是Series和DataFrame中的数据的基本手段.

2.1.重新索引

pandas 对象的一个重要方法是 reindex,其作用是创建一个新对象,它的数据符合新的索引

>>> obj=pd.Series([4.5,2,3,-5,3.1],index=['d','a','b','c','e'])

>>> obj

d 4.5

a 2.0

b 3.0

c -5.0

e 3.1

dtype: float64

>>> obj2=obj.reindex(['a','b','c','d','e'])

>>> obj2

a 2.0

b 3.0

c -5.0

d 4.5

e 3.1

dtype: float64

用该 Series 的 reindex 将会更具新索引进行重排.如果某个索引值当前不存在,就引入缺失值.

对于时间序列这样的有序数据,重新索引可能需要做一些插值处理,method选项即可达到此目的.例如,使用ffill可以实现前向值i安崇

>>> obj3=pd.Series(['blue','purple','yellow'],index=[0,2,4])

>>> obj3

0 blue

2 purple

4 yellow

dtype: object

>>> obj3.reindex(range(6),method='ffill')

0 blue

1 blue

2 purple

3 purple

4 yellow

5 yellow

dtype: object

借助 DataFrame,reindex 可以修改(行)索引和列,值传递一个序列时,会重新索引结果的行:

>>> frame=pd.DataFrame(np.arange(9).reshape(3,3),index=['a','c','d'],columns=['Ohio','Texas','California'])

>>> frame

Ohio Texas California

a 0 1 2

c 3 4 5

d 6 7 8

>>> frame2=frame.reindex(['a','b','c','d'])

>>> frame2

Ohio Texas California

a 0.0 1.0 2.0

b NaN NaN NaN

c 3.0 4.0 5.0

d 6.0 7.0 8.0

列可以使用columns关键字重新索引

Texas Utah California

a 1 NaN 2

c 4 NaN 5

d 7 NaN 8

对 reindex 的详解见 https://baijiahao.baidu.com/s?id=1637861793545367173&wfr=spider&for=pc

2.2.丢弃指定轴上的项

丢弃某条轴上的一个或多个项很简单,只要有一个索引数列或列表即可,由于需要执行一些数据整理和集合逻辑,所以drop方法返回的是一个在指定轴上删除了指定值的新对象

>>> obj=pd.Series(np.arange(5.),index=['a','b','c','d','e'])

>>> obj

a 0.0

b 1.0

c 2.0

d 3.0

e 4.0

dtype: float64

>>> new_obj=obj.drop('c')

>>> new_obj

a 0.0

b 1.0

d 3.0

e 4.0

dtype: float64

>>> obj.drop(['d','c'])

a 0.0

b 1.0

e 4.0

对于 DataFrame,可以删除任意轴上的索引值

>>> data=pd.DataFrame(np.arange(16).reshape(4,4),index=['Ohio','Colorado','Utah','New York'],columns=['one','two','three','four'])

>>> data

one two three four

Ohio 0 1 2 3

Colorado 4 5 6 7

Utah 8 9 10 11

New York 12 13 14 15

>>> data.drop(['Colorado','Ohio'])

one two three four

Utah 8 9 10 11

New York 12 13 14 15

通过传递 axis=1或 axis='columns’可以删除列的值

>>> data.drop('two',axis=1)

one three four

Ohio 0 2 3

Colorado 4 6 7

Utah 8 10 11

New York 12 14 15

>>> data.drop(['two','four'],axis='columns')

one three

Ohio 0 2

Colorado 4 6

Utah 8 10

New York 12 14

许多函数,如drop,会修改Series或DataFrame的大小或形状,可以就地修改对象,不会返回新的对象

>>> obj.drop('c',inplace=True)

>>> obj

a 0.0

b 1.0

d 3.0

e 4.0

dtype: float64

2.3.索引,选取和过滤

Series的工作方式类似于NumPy数组的索引,只不过Series的索引值不只是整数

>>> obj=pd.Series(np.arange(4.),index=['a','b','c','d'])

>>> obj

a 0.0

b 1.0

c 2.0

d 3.0

dtype: float64

>>> obj['b']

1.0

>>> obj[1]

1.0

>>> obj[2:4]

c 2.0

d 3.0

dtype: float64

>>> obj['b','a','d']

>>> obj[['b','a','d']]

b 1.0

a 0.0

d 3.0

dtype: float64

>>> obj[obj<2]

a 0.0

b 1.0

dtype: float64

利用标签的切片运算和普通的Python切片运算不同,其末端是包含的

>>> obj['b':'c']

b 1.0

c 2.0

dtype: float64

利用切片可以对Series的相应部分进行设置

>>> obj['b':'c']=5

>>> obj

a 0.0

b 5.0

c 5.0

d 3.0

dtype: float64

用一个值或序列对DataFrame进行索引其实就是获取一个或多个列:

>>> data=pd.DataFrame(np.arange(16).reshape(4,4),index=['Ohio','Colorado','Utah','New York'],columns=['one','two','three','four'])

>>> data

one two three four

Ohio 0 1 2 3

Colorado 4 5 6 7

Utah 8 9 10 11

New York 12 13 14 15

>>> data['two']

Ohio 1

Colorado 5

Utah 9

New York 13

Name: two, dtype: int32

>>> data[['one','three']]

one three

Ohio 0 2

Colorado 4 6

Utah 8 10

New York 12 14

这种索引方式有几个特殊的情况,首先通过切片或布尔型数组选取数据

>>> data[:2]

one two three four

Ohio 0 1 2 3

Colorado 4 5 6 7

>>>

>>> data[data['three']>5]

one two three four

Colorado 4 5 6 7

Utah 8 9 10 11

New York 12 13 14 15

>>> data

one two three four

Ohio 0 1 2 3

Colorado 4 5 6 7

Utah 8 9 10 11

New York 12 13 14 15

另一种用法是通过布尔型DataFrame进行索引

>>> data<5

one two three four

Ohio True True True True

Colorado True False False False

Utah False False False False

New York False False False False

>>> data[data<5]=0

>>> data

one two three four

Ohio 0 0 0 0

Colorado 0 5 6 7

Utah 8 9 10 11

New York 12 13 14 15

这使得DataFrame的语法和NumPy二维数组的语法很像

2.4.用loc和iloc进行选取

对于DataFrame的行的标签索引,引入标签运算发loc和iloc,它们类似于NumPy的标记,使用轴标签(loc)或整数索引iloc,从DataFrame选取行和列的子集

>>> data.loc['Colorado',['two','three']]

two 5

three 6

Name: Colorado, dtype: int32

>>> data.iloc[2,[3,0,1]]

four 11

one 8

two 9

Name: Utah, dtype: int32

>>> data.iloc[2]

one 8

two 9

three 10

four 11

Name: Utah, dtype: int32

这两个索引函数也适用于一个标签或多个标签的切片

>>> data.loc[:'Utah','two']

Ohio 0

Colorado 5

Utah 9

Name: two, dtype: int32

>>> data.iloc[:,:3][data.three>5]

one two three

Colorado 0 5 6

Utah 8 9 10

New York 12 13 14

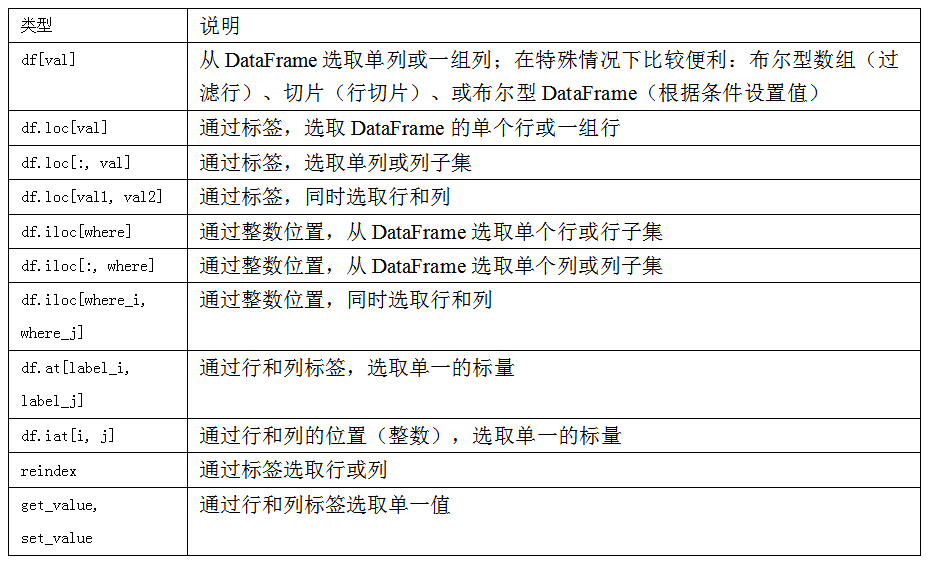

在pandas中,有多个方法可以选取和重新组合数据.对于DataFrame,下面是总结

ix是iloc和loc的混合索引

2.5.整数索引

处理整数索引的pandas的对象可能比较麻烦,因为它与Python内置的列表和元组的索引语法不同,例如,你可能认为下面的代码不会出错

>>> ser

0 0.0

1 1.0

2 2.0

dtype: float64

>>> ser[-1] #KeyValue Error

而它实际上会产生错误,因为这里只有索引0,1,2,而没有-1,这使得原本内置的-1产生了歧义.而对于非整数索引则不会产生歧义

>>> ser2=pd.Series(np.arange(3.),index=['a','b','c'])

>>> ser2

a 0.0

b 1.0

c 2.0

dtype: float64

>>> ser2[-1]

2.0

为了进行统一,如果轴索引含有整数,数据选取总会使用整数,为了更准确,可以使用loc(标签)和iloc(整数)

>>> ser[:1]

0 0.0

dtype: float64

>>> ser.loc[:1]

0 0.0

1 1.0

dtype: float64

>>> ser.iloc[:1]

0 0.0

dtype: float64

>>> ser

0 0.0

1 1.0

2 2.0

dtype: float64

2.6.算术运算和数据对齐

pandas最重要的一个功能是,它可以对不同索引的对象进行算术运算.将对象相加时,如果存在不同的索引对,则结果的索引就是该索引对的并集,就像是在索引标签上进行数据库意义上的自动外连接

>>> s1=Series([7.3,-2.5,3.4,1.5],index=['a','c','d','e'])

>>> s2=Series([-2.1,3.6,-1.5,4,3.1],index=['a','c','e','f','g'])

>>> s1+s2

a 5.2

c 1.1

d NaN

e 0.0

f NaN

g NaN

自动的数据对齐在不重叠的索引处引入了NA值,缺失值会在算术运算过程中传播

对于DataFrame,对齐操作会同时发生在行和列上

>>> df1=DataFrame(np.arange(9.).reshape((3,3)),columns=list('bcd'),index=['Ohio','Texas','Colorado'])

>>> df2=DataFrame(np.arange(12.).reshape((4,3)),columns=list('bde'),index=['Utah','Ohio','Texas','Oregon']) >>> df1

b c d

Ohio 0.0 1.0 2.0

Texas 3.0 4.0 5.0

Colorado 6.0 7.0 8.0

>>> df2

b d e

Utah 0.0 1.0 2.0

Ohio 3.0 4.0 5.0

Texas 6.0 7.0 8.0

Oregon 9.0 10.0 11.0

>>> df1+df2

b c d e

Colorado NaN NaN NaN NaN

Ohio 3.0 NaN 6.0 NaN

Oregon NaN NaN NaN NaN

Texas 9.0 NaN 12.0 NaN

Utah NaN NaN NaN NaN

将它们相加后会返回一个新的DataFrame,其索引和列为原来那两个DataFrame的并集

如果DataFrame对象相加,没有共用的列或行标签,结果都会是空

>>> df1=DataFrame({'A':[1,2]})

>>> df1

A

0 1

1 2

>>> df2=DataFrame({'B':[3,4]})

>>> df2

B

0 3

1 4

>>> df1-df2

A B

0 NaN NaN

1 NaN NaN

2.7.在算术方法中填充值

在对不同索引的对象进行算术运算时,可能希望当一个对象中某个轴标签在另一个对象中找不到时填充一个特定值

>>> df1 = pd.DataFrame(np.arange(12.).reshape((3, 4)),columns=list('abcd'))

>>> df2 = pd.DataFrame(np.arange(20.).reshape((4, 5)),columns=list('abcde'))

>>> df2.loc[1, 'b'] = np.nan

>>> df1

a b c d

0 0.0 1.0 2.0 3.0

1 4.0 5.0 6.0 7.0

2 8.0 9.0 10.0 11.0

>>> df2

a b c d e

0 0.0 1.0 2.0 3.0 4.0

1 5.0 NaN 7.0 8.0 9.0

2 10.0 11.0 12.0 13.0 14.0

3 15.0 16.0 17.0 18.0 19.0

将它们相加时,没有重叠的位置就会产生NA值

>>> df1+df2

a b c d e

0 0.0 2.0 4.0 6.0 NaN

1 9.0 NaN 13.0 15.0 NaN

2 18.0 20.0 22.0 24.0 NaN

3 NaN NaN NaN NaN NaN

使用df1的add方法,传入df2以及一个fill_value参数

>>> df1.add(df2,fill_value=0)

a b c d e

0 0.0 2.0 4.0 6.0 4.0

1 9.0 5.0 13.0 15.0 9.0

2 18.0 20.0 22.0 24.0 14.0

3 15.0 16.0 17.0 18.0 19.0

下面的表出了Series和DataFrame的算术方法。它们每个都有一个副本,以字母r开头,它会翻转参数。因此这两个语句是等价的:

In [172]: 1 / df1

Out[172]:

a b c d

0 inf 1.000000 0.500000 0.333333

1 0.250000 0.200000 0.166667 0.142857

2 0.125000 0.111111 0.100000 0.090909

In [173]: df1.rdiv(1)

Out[173]:

a b c d

0 inf 1.000000 0.500000 0.333333

1 0.250000 0.200000 0.166667 0.142857

2 0.125000 0.111111 0.100000 0.090909

与此类似,在对Series或DataFrame重新索引时,也可以指定一个填充值

>>> df1.reindex(columns=df2.columns, fill_value=0)

a b c d e

0 0.0 1.0 2.0 3.0 0

1 4.0 5.0 6.0 7.0 0

2 8.0 9.0 10.0 11.0 0

2.8.DataFrame和Series之间的运算

与不同维度的NumPy数组一样,DataFrame和Series之间的算术运算也是有明确规定的,下面是一个例子,计算二维数组与其某行之间的差

>>> arr=np.arange(12.).reshape((3,4))

>>> arr

array([[ 0., 1., 2., 3.],

[ 4., 5., 6., 7.],

[ 8., 9., 10., 11.]])

>>> arr[0]

array([0., 1., 2., 3.])

>>> arr-arr[0]

array([[0., 0., 0., 0.],

[4., 4., 4., 4.],

[8., 8., 8., 8.]])

当从arr减去arr[0]时,每一行都会执行这个操作,这叫做广播.DataFrame和Series之间的运算差不多也是如此

>>> frame = pd.DataFrame(np.arange(12.).reshape((4, 3)),columns=list('bde'), index=['Utah', 'Ohio', 'Texas', 'Oregon'])

>>> series=frame.iloc[0]

>>> frame

b d e

Utah 0.0 1.0 2.0

Ohio 3.0 4.0 5.0

Texas 6.0 7.0 8.0

Oregon 9.0 10.0 11.0

>>> series

b 0.0

d 1.0

e 2.0

Name: Utah, dtype: float64

默认情况下,DataFrame和Series之间的算术运算会将Series的索引匹配到DataFrame的列,然后沿着行一直向下广播

>>> frame-series

b d e

Utah 0.0 0.0 0.0

Ohio 3.0 3.0 3.0

Texas 6.0 6.0 6.0

Oregon 9.0 9.0 9.0

如果某个索引在DataFrame的列或Series的索引中找不到,则参与运算的两个对象就会被重新索引以形成并集这里就是比较计算的series索引名和DataFrame的列名。

>>> series2 = pd.Series(range(3), index=['b', 'e', 'f'])

>>> frame+series2

b d e f

Utah 0.0 NaN 3.0 NaN

Ohio 3.0 NaN 6.0 NaN

Texas 6.0 NaN 9.0 NaN

Oregon 9.0 NaN 12.0 NaN

如果希望匹配行且在列上广播,必须使用算术运算方法,例如

b d e

Utah 0.0 1.0 2.0

Ohio 3.0 4.0 5.0

Texas 6.0 7.0 8.0

Oregon 9.0 10.0 11.0

>>> series3

Utah 1.0

Ohio 4.0

Texas 7.0

Oregon 10.0

Name: d, dtype: float64

>>> frame.sub(series3,axis='index')

b d e

Utah -1.0 0.0 1.0

Ohio -1.0 0.0 1.0

Texas -1.0 0.0 1.0

Oregon -1.0 0.0 1.0

传入的轴号就是希望匹配的轴,在上面的例子中,目的是匹配DataFrame的行索引(axis=‘index’ or axis=0),并进行广播

2.9.函数应用和映射

NumPy的ufuncs(元素级数组方法)也可以操纵pandas对象

>>> frame = pd.DataFrame(np.random.randn(4, 3), columns=list('bde'),index=['Utah', 'Ohio', 'Texas', 'Oregon'])

>>> frame

b d e

Utah -1.694994 -0.270174 0.597397

Ohio 1.451881 0.585898 -0.897480

Texas 0.558496 0.059872 1.012110

Oregon 0.750981 -0.575618 -0.102459

>>> np.abs(frame)

b d e

Utah 1.694994 0.270174 0.597397

Ohio 1.451881 0.585898 0.897480

Texas 0.558496 0.059872 1.012110

Oregon 0.750981 0.575618 0.102459

另一个常见的操作是,将函数应用到由各列或行所形成的一维数组上,DataFrame的apply方法即可实现此功能

>>> f=lambda x:x.max()-x.min()

>>> frame.apply(f)

b 3.146875

d 1.161516

e 1.909590

dtype: float64

这里的函数 f,计算了一个Series的最大和最小值的差,在frame的每列都执行了一次,结果是一个Seires,使用frame的列作为索引,如果传递axis='columns’到apply,这个函数就会在每行执行

>>> frame.apply(f,axis='columns')

Utah 2.292392

Ohio 2.349361

Texas 0.952238

Oregon 1.326599

dtype: float64

许多最为常见的数组统计功能都被实现为DataFrame的方法,因此无需使用apply方法.

传递到apply的函数不是必须返回一个标量,还可以返回由多个值组成的Series

>>> def f(x):

... return pd.Series([x.min(), x.max()], index=['min', 'max'])

...

>>> frame.apply(f)

b d e

min -1.694994 -0.575618 -0.89748

max 1.451881 0.585898 1.01211

元素级的Python函数也是可以使用的.假如想要得到frame中各个浮点值的格式化字符串,使用applymap即可

>>> format = lambda x: '%.2f' % x

>>> frame.applymap(format)

b d e

Utah -1.69 -0.27 0.60

Ohio 1.45 0.59 -0.90

Texas 0.56 0.06 1.01

Oregon 0.75 -0.58 -0.10

之所以叫做applymap,是因为Series有一个用于应用于元素级函数的map方法

>>> frame['e'].map(format)

Utah 0.60

Ohio -0.90

Texas 1.01

Oregon -0.10

Name: e, dtype: object

2.10.排序和排名

根据条件对数据集进行排序也是一种重要的内置运算,要对行或列索引进行排序(按字典排序),可以使用sort_index方法,它返回一个新对象

>>> obj = pd.Series(range(4), index=['d', 'a', 'b', 'c'])

>>> obj

d 0

a 1

b 2

c 3

dtype: int64

>>> obj.sort_index()

a 1

b 2

c 3

d 0

dtype: int64

对于DataFrame,则可以根据任意一个轴上的索引进行排序

>>> frame = pd.DataFrame(np.arange(8).reshape((2, 4)),index=['three', 'one'],columns=['d', 'a', 'b', 'c'])

>>> frame.sort_index()

d a b c

one 4 5 6 7

three 0 1 2 3

>>> frame.sort_index(axis=1)

a b c d

three 1 2 3 0

one 5 6 7 4

数据默认是按照升序排序的,也可以按照降序排序

>>> frame.sort_index(axis=1,ascending=False)

d c b a

three 0 3 2 1

one 4 7 6 5

若要按值对Series排序,可以使用其sort_values方法

>>> obj=pd.Series([4,7,-3,2])

>>> obj.sort_values()

2 -3

3 2

0 4

1 7

在排序时,任何缺失值默认都会被放到Series的末尾

>>> obj = pd.Series([4, np.nan, 7, np.nan, -3, 2])

>>> obj.sort_values()

4 -3.0

5 2.0

0 4.0

2 7.0

1 NaN

3 NaN

dtype: float64

当排序一个DataFrame时,你可能希望根据一个或多个列的值进行排序,将一个或多个列的名字传递给sort_values的by选项即可

>>> frame = pd.DataFrame({'b': [4, 7, -3, 2], 'a': [0, 1, 0, 1]})

>>> frame

b a

0 4 0

1 7 1

2 -3 0

3 2 1

>>> frame.sort_values(by='b')

b a

2 -3 0

3 2 1

0 4 0

1 7 1

>>> frame.sort_values(by=['b','a'])

b a

2 -3 0

3 2 1

0 4 0

1 7 1

排名会从1开始一直到数组中有效数据的数量.

下面是Series和DataFrame的rank方法.默认情况下,rank是通过"为各组分配一个平均排名"的方式破坏平级关系的

>>> obj = pd.Series([7, -5, 7, 4, 2, 0, 4])

>>> obj.rank() #返回值: 索引 位置的平均值

0 6.5

1 1.0

2 6.5

3 4.5

4 3.0

5 2.0

6 4.5

dtype: float64

(我们可以自己先排一下一些没用争议的数字,比如-5最小,其排名为1.0,0其次,因此其排名为2.0,数字2同理,其排名为3.0,这些都没问题,但是到了4的时候,我们发现Series中存在两个4,那么根据不同的规则,我们可以说数字4的排名是4.0,但也可以说是5.0,而“为各组分配一个平均排名”就能很好的解释这个4.5的来源了,即取4.0和5.0的平均值,那么对于数字7来说,也是一个道理了,其既可以取6.0,也可以取7.0,这里平均一下,就成了6.5了)

也可以根据值在原数据中出现的顺序给出排名

>>> obj.rank(method='first')

0 6.0

1 1.0

2 7.0

3 4.0

4 3.0

5 2.0

6 5.0

dtype: float64

也可以按降序进行排名

>>> obj.rank(ascending=False, method='max')

0 2.0

1 7.0

2 2.0

3 4.0

4 5.0

5 6.0

6 4.0

dtype: float64

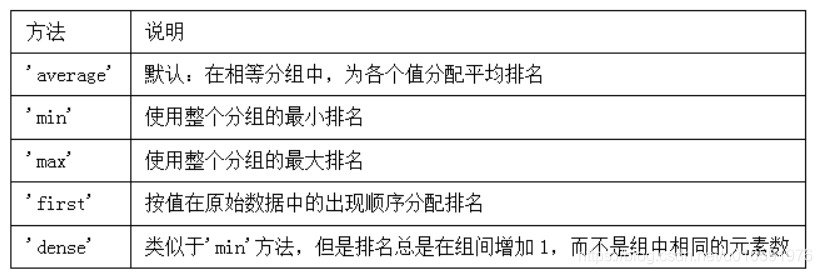

下面是所有用于破坏平级关系的method选项

DataFrame可以在行或列上计算排名:

>>> frame = pd.DataFrame({'b': [4.3, 7, -3, 2], 'a': [0, 1, 0, 1], 'c': [-2, 5, 8, -2.5]})

>>> frame

b a c

0 4.3 0 -2.0

1 7.0 1 5.0

2 -3.0 0 8.0

3 2.0 1 -2.5

>>> frame.rank(axis='columns')

b a c

0 3.0 2.0 1.0

1 3.0 1.0 2.0

2 1.0 2.0 3.0

3 3.0 2.0 1.0

2.11.带有重复标签的轴索引

虽然许多pandas函数(如reindex)都要求标签唯一,但这并不是强制性的

>>> obj = pd.Series(range(5), index=['a', 'a', 'b', 'b', 'c'])

>>> obj

a 0

a 1

b 2

b 3

c 4

dtype: int64

索引的is_unique属性可以告诉你它的值是否是唯一的obj.index.is_unique:

>>> obj.index.is_unique

False

对于带有重复值的索引,数据选取的行为将会有些不同。如果某个索引对应多个值,则返回一个Series;而对应单个值的,则返回一个标量值

>>> obj['a']

a 0

a 1

dtype: int64

>>> obj['c']

4

这样会使代码变复杂,因为索引的输出类型会根据标签是否有重复发生变化。对DataFrame的行进行索引时也是如此:

>>> df = pd.DataFrame(np.random.randn(4, 3), index=['a', 'a', 'b', 'b'])

>>> df

0 1 2

a -0.650315 -0.822075 -0.145283

a 1.167576 1.102189 0.583245

b 1.047264 -1.398393 -0.001450

b 0.764462 0.536134 2.858152

>>> df.loc['b']

0 1 2

b 1.047264 -1.398393 -0.001450

b 0.764462 0.536134 2.858152

3.汇总和计算描述统计

pandas对象拥有一组常用的数学和统计方法.它们大部分都属于约简和汇总统计,用于Series中提取单个值(如sum或mean)或从DataFrame的行或列中提取一个Series.与对应的NumPy数组方法相比,它们都是基于没有缺失数据的假设而构建的

>>> df=DataFrame([[1.4,np.nan],[7.1,-4.5],[np.nan,np.nan],[0.75,-1.3]],index=['a','b','c','d'],columns=['one','two'])

>>> df

one two

a 1.40 NaN

b 7.10 -4.5

c NaN NaN

d 0.75 -1.3

调用DataFrame的sum方法将会返回一个含有列的小计的Series:

>>> df.sum()

one 9.25

two -5.80

dtype: float64

通过设置axis=1 可以按行进行求和计算。

NA值将会被自动剔除,除非整个切片都是NA。通过skipna选项可以禁用该功能

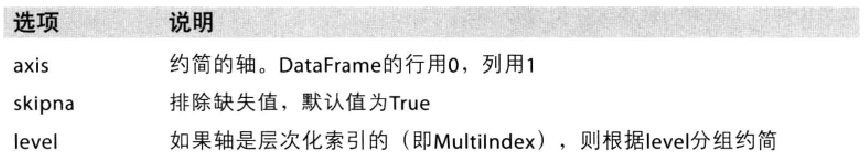

下面为一些约简方法常用选项:

有些方法(如idxmin和idxmax)返回的是间接统计(比如达到最大值或最小值的索引):

>>> df.idxmax()

one b

two d

dtype: object

另一些方法则是累计型的

>>> df.cumsum()

one two

a 1.40 NaN

b 8.50 -4.5

c NaN NaN

d 9.25 -5.8

还有一种方法,它既不是约简也不是累计型,describe就是一个例子,它用于一次性产生多个汇总统计:

>>> df.describe()

one two

count 3.000000 2.000000

mean 3.083333 -2.900000

std 3.493685 2.262742

min 0.750000 -4.500000

25% 1.075000 -3.700000

50% 1.400000 -2.900000

75% 4.250000 -2.100000

max 7.100000 -1.300000

对于非数值型数据,describe会产生另一种汇总统计

>>> obj=Series(['a','a','b','c']*4)

>>> obj.describe()

count 16

unique 3

top a

freq 8

dtype: object

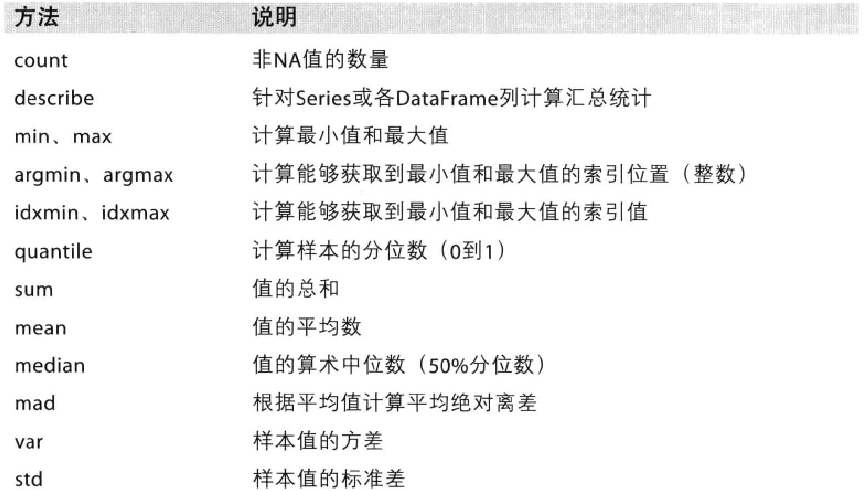

下面是所有与描述统计相关的方法

3.1.唯一值,值计数以及成员资格

还有一类方法可以从一维Series的值中抽取信息,下面是例子

obj = pd.Series(['c', 'a', 'd', 'a', 'a', 'b', 'b', 'c', 'c'])

>>> uniques = obj.unique()

>>> uniques

array(['c', 'a', 'd', 'b'], dtype=object)

返回的唯一值是未排序的,如果需要的话,可以对结果再次进行排序(uniques.sort()).相似的,value_counts可以用于计算一个Series中各值出现的频率

>>> obj.value_counts()

a 3

c 3

b 2

d 1

dtype: int64

为了便于查看,结果是按值频率降序排列的

value_counts还是一个顶级的pandas方法,可以用于任何数组或序列

>>> pd.value_counts(obj.values,sort=False)

d 1

c 3

b 2

a 3

dtype: int64

isin 用于判断矢量化集合的成员资格,可以用于过滤Seiries中或DataFrame列中数据的子集

>>> obj

0 c

1 a

2 d

3 a

4 a

5 b

6 b

7 c

8 c

dtype: object

>>> mask=obj.isin(['b','c'])

>>> mask

0 True

1 False

2 False

3 False

4 False

5 True

6 True

7 True

8 True

dtype: bool

>>> obj[mask]

0 c

5 b

6 b

7 c

8 c

dtype: object

与isin类似的是index.get_indexer方法,它返回一个索引数组,从可能包含重复值的数组到另一个不同值的数组

>>> to_match = pd.Series(['c', 'a', 'b', 'b', 'c', 'a'])

>>> unique_vals = pd.Series(['c', 'b', 'a'])

>>> pd.Index(unique_vals).get_indexer(to_match)

array([0, 2, 1, 1, 0, 2], dtype=int64)

下面的表是这几个方法的一些参考信息

有时,你可能希望得到DataFrame中多个相关列的一张柱状图。例如:

>>> data = pd.DataFrame({'Qu1': [1, 3, 4, 3, 4],'Qu2': [2, 3, 1, 2, 3],'Qu3': [1, 5, 2, 4, 4]})

>>> data

Qu1 Qu2 Qu3

0 1 2 1

1 3 3 5

2 4 1 2

3 3 2 4

4 4 3 4

将pandas.value_counts传递给该DataFrame的apply函数,就会出现

>>> reslut=data.apply(pd.value_counts).fillna(0)

>>> reslut

Qu1 Qu2 Qu3

1 1.0 1.0 1.0

2 0.0 2.0 1.0

3 2.0 2.0 0.0

4 2.0 0.0 2.0

5 0.0 0.0 1.0

这里,结果中的行标签是所有列的唯一值。后面的频率值是每个列中这些值的相应计数。

三、数据加载.存储与文件格式

输入输出数据可以划分为几个大类:读取文本文件和其他更高效的磁盘存储格式,加载数据库的数据,利用Web API操作网络资源

1.读写文本格式的数据

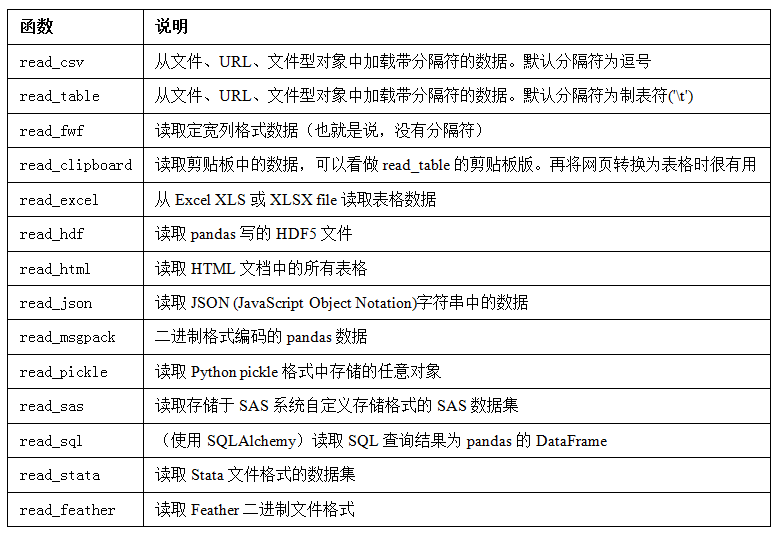

pandas提供了一些用于将表格数据读取为DataFrame对象的函数,其中read_csv和read_table可能会是使用最多的

我将大致介绍一下这些函数在将文本数据转换为DataFrame时所用到的一些技术。这些函数的选项可以划分为以下几个大类:

- 索引:将一个或多个列当做返回的DataFrame处理,以及是否从文件、用户获取列名。

- 类型推断和数据转换:包括用户定义值的转换、和自定义的缺失值标记列表等。

- 日期解析:包括组合功能,比如将分散在多个列中的日期时间信息组合成结果中的单个列。

- 迭代:支持对大文件进行逐块迭代。

- 不规整数据问题:跳过一些行、页脚、注释或其他一些不重要的东西(比如由成千上万个逗号隔开的数值数据)。

因为工作中实际遇到的数据可能十分混乱,一些数据加载函数(尤其是read_csv)的选项逐渐变得复杂起来,面对不同的参数,感到很烦.pandas文档由这些参数的例子

其中的一些函数,比如pandas.read_csv,有类型推断功能,因为列数据的类型不属于数据类型.也就是说,不需要指定列的类型到底是整数还是字符串等.其他的数据格式,比如HDF5,Feather和msgpack,会在格式中存储数据类型.日期和其他自定义的类型的处理需要更多时间来处理

下面是一个以逗号分隔的CSV文本文件

a,b,c,d,message

1,2,3,4,hello

5,6,7,8,world

9,10,11,12,foo

>>> df=pd.read_csv('C:\\Users\\PC\\Desktop\\程序\\Python\\Test\\ex1.csv')

>>> df

a b c d message

0 1 2 3 4 hello

1 5 6 7 8 world

2 9 10 11 12 foo

还可以使用read_table,并指定分隔符

>>> pd.read_table('C:\\Users\\PC\\Desktop\\程序\\Python\\Test\\ex1.csv',sep=',')

a b c d message

0 1 2 3 4 hello

1 5 6 7 8 world

2 9 10 11 12 foo

并不是所有文件都有标题行。看看下面这个文件:

1,2,3,4,hello

5,6,7,8,world

9,10,11,12,foo

读入该文件的方法有两个.可以让pandas为其分配默认的列名,也可以自定义列名

>>> pd.read_csv('C:\\Users\\PC\\Desktop\\程序\\Python\\Test\\ex2.csv',header=None)

0 1 2 3 4

0 1 2 3 4 hello

1 5 6 7 8 world

2 9 10 11 12 foo

>>> pd.read_csv('C:\\Users\\PC\\Desktop\\程序\\Python\\Test\\ex2.csv',names=['a','b','c','d','message'])

a b c d message

0 1 2 3 4 hello

1 5 6 7 8 world

2 9 10 11 12 foo

假如希望将message列作为DataFrame的索引,可以明确表示要将该列放到索引4的位置上,也可以通过index_col参数指定message

>>> pd.read_csv('C:\\Users\\PC\\Desktop\\程序\\Python\\Test\\ex2.csv',names=names,index_col='messages')

a b c d

messages

hello 1 2 3 4

world 5 6 7 8

foo 9 10 11 12

如果希望将多个列做成一个层次化索引,只需传入由列编号或列名组成的列表即可:

value1 value2

key1 key2

one a 1 2

b 3 4

c 5 6

d 7 8

two a 9 10

b 11 12

c 13 14

d 15 16

有些情况下,有些表格可能不是用固定的分隔符去分隔字段的(比如空白符或其他模式).看下面的文件

>>> list(open('examples/ex3.txt'))

[' A B C\n',

'aaa -0.264438 -1.026059 -0.619500\n',

'bbb 0.927272 0.302904 -0.032399\n',

'ccc -0.264273 -0.386314 -0.217601\n',

'ddd -0.871858 -0.348382 1.100491\n']

虽然可以手动规整,这里的字段是被数量不同的空白字符放开的.这种情况下,可以传递一个正则表达式作为read_table的分隔符.可以用正则表达式为\s+,于是有

>>> result = pd.read_table('examples/ex3.txt', sep='\s+')

>>> result

A B C

aaa -0.264438 -1.026059 -0.619500

bbb 0.927272 0.302904 -0.032399

ccc -0.264273 -0.386314 -0.217601

ddd -0.871858 -0.348382 1.100491

这里,由于列名比数据行的数量少,所以read_table退镀按第一列应该是DataFrame的索引

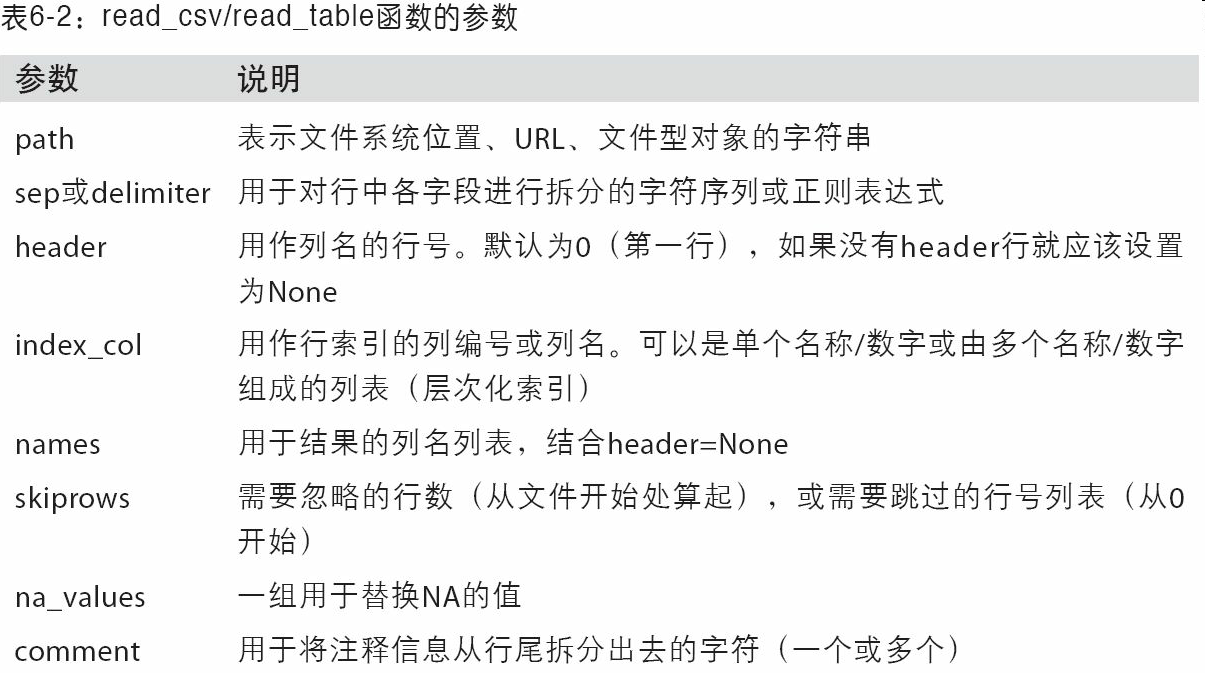

这些解析器函数还有许多参数可以帮助处理各种各样的异形文件格式,下面列出了一些

比如说,你可以用skiprows跳过文件的第一行、第三行和第四行:

1,2,3,4,hello

5,6,7,8,world

9,10,11,12,foo

>>> pd.read_csv('examples/ex4.csv', skiprows=[0, 2, 3])

a b c d message

0 1 2 3 4 hello

1 5 6 7 8 world

2 9 10 11 12 foo

缺失值处理是文件解析任务中的一个重要组成部分。缺失数据经常是要么没有(空字符串),要么用某个标记值表示。默认情况下,pandas会用一组经常出现的标记值进行识别,比如NA及NULL:

something,a,b,c,d,message

one,1,2,3,4,NA

two,5,6,,8,world

three,9,10,11,12,foo

>>> result = pd.read_csv('examples/ex5.csv')

>>> result

something a b c d message

0 one 1 2 3.0 4 NaN

1 two 5 6 NaN 8 world

2 three 9 10 11.0 12 foo

In [28]: pd.isnull(result)

Out[28]:

something a b c d message

0 False False False False False True

1 False False False True False False

2 False False False False False False

na_values可以用于一个列表或集合的字符串表示缺失值:

>>> result = pd.read_csv('examples/ex5.csv', na_values=['NULL'])

>>> result

something a b c d message

0 one 1 2 3.0 4 NaN

1 two 5 6 NaN 8 world

2 three 9 10 11.0 12 foo

字典的各列可以使用不同的NA标记值:

>>> sentinels = {'message': ['foo', 'NA'], 'something': ['two']}

>>> pd.read_csv('examples/ex5.csv', na_values=sentinels)

something a b c d message

0 one 1 2 3.0 4 NaN

1 NaN 5 6 NaN 8 world

2 three 9 10 11.0 12 NaN

1.2.逐块读取文本文件

在处理很大的文件时,或找出打文件中的参数集以便于后续处理时,你可能只想要读取文件的一小部部分

在看大文件之前,我们先设置pandas显示地更紧些:

>>> pd.options.display.max_rows = 10

然后有:

>>> result = pd.read_csv('examples/ex6.csv')

>>> result

one two three four key

0 0.467976 -0.038649 -0.295344 -1.824726 L

1 -0.358893 1.404453 0.704965 -0.200638 B

2 -0.501840 0.659254 -0.421691 -0.057688 G

3 0.204886 1.074134 1.388361 -0.982404 R

4 0.354628 -0.133116 0.283763 -0.837063 Q

... ... ... ... ... ..

9995 2.311896 -0.417070 -1.409599 -0.515821 L

9996 -0.479893 -0.650419 0.745152 -0.646038 E

9997 0.523331 0.787112 0.486066 1.093156 K

9998 -0.362559 0.598894 -1.843201 0.887292 G

9999 -0.096376 -1.012999 -0.657431 -0.573315 0

[10000 rows x 5 columns]

If you want to only read a small

如果只想读取几行(避免读取整个文件),通过nrows进行指定即可:

>>> pd.read_csv('examples/ex6.csv', nrows=5)

one two three four key

0 0.467976 -0.038649 -0.295344 -1.824726 L

1 -0.358893 1.404453 0.704965 -0.200638 B

2 -0.501840 0.659254 -0.421691 -0.057688 G

3 0.204886 1.074134 1.388361 -0.982404 R

4 0.354628 -0.133116 0.283763 -0.837063 Q

要逐块读取文件,可以指定chunksize(行数):

>>> chunker = pd.read_csv('ch06/ex6.csv', chunksize=1000)

>>> chunker

<pandas.io.parsers.TextParser at 0x8398150>

read_csv所返回的这个TextParser对象使你可以根据chunksize对文件进行逐块迭代。比如说,我们可以迭代处理ex6.csv,将值计数聚合到"key"列中,如下所示:

>>> chunker = pd.read_csv('examples/ex6.csv', chunksize=1000) #1000行组成一块

>>> tot = pd.Series([])

>>> for piece in chunker:

>>> tot = tot.add(piece['key'].value_counts(), fill_value=0) #对于块里的每一行

>>> tot = tot.sort_values(ascending=False)

然后有:

>>> tot[:10]

E 368.0

X 364.0

L 346.0

O 343.0

Q 340.0

M 338.0

J 337.0

F 335.0

K 334.0

H 330.0

dtype: float64

TextParser还有一个get_chunk方法,它使你可以读取任意大小的块。

1.3.将数据写出到文本格式

数据也可以被输出为分隔符格式的文本,

>>> data=pd.read_csv("ex5.csv")

>>> data

something a b c d message

0 one 1 2 3.0 4 NaN

1 two 5 6 NaN 8 world

2 three 9 10 11.0 12 foo

利用DataFrame的to_csv方法,可以将数据写入到一个以逗号分隔的文件中

>>> data.to_csv("ex5out.csv")

>>> f=open("ex5out.csv","r",encoding="utf-8")

>>> f.read()

',something,a,b,c,d,message\n0,one,1,2,3.0,4,\n1,two,5,6,,8,world\n2,three,9,10,11.0,12,foo\n'

也可以使用其他分隔符

>>> import sys

>>> data.to_csv(sys.stdout,sep="|")

|something|a|b|c|d|message

0|one|1|2|3.0|4|

1|two|5|6||8|world

2|three|9|10|11.0|12|foo

缺失值在输出结果中会被表示为空字符串,可以设置为别的值

>>> data.to_csv(sys.stdout,na_rep="NULL")

,something,a,b,c,d,message

0,one,1,2,3.0,4,NULL

1,two,5,6,NULL,8,world

2,three,9,10,11.0,12,foo

如果没有设置其他选项,则会写出列和行的标签,他们也可以被禁用

>>> data.to_csv(sys.stdout,index=None,header=None)

one,1,2,3.0,4,

two,5,6,,8,world

three,9,10,11.0,12,foo

还可以只写出一部分列,并以指定的顺序排列

>>> data.to_csv(sys.stdout,index=False,columns=["a","message","c"])

a,message,c

1,,3.0

5,world,

9,foo,11.0

Seires也有一个to_csv方法

>>> dates=pd.date_range("1/1/2000",periods=7)

>>> ts=pd.Series(np.arange(7),index=dates)

>>> ts

2000-01-01 0

2000-01-02 1

2000-01-03 2

2000-01-04 3

2000-01-05 4

2000-01-06 5

2000-01-07 6

Freq: D, dtype: int32

>>> ts.to_csv(sys.stdout)

2000-01-01,0

2000-01-02,1

2000-01-03,2

2000-01-04,3

2000-01-05,4

2000-01-06,5

2000-01-07,6

1.4.处理分隔符格式

大部分存储在磁盘上的表格型数据都能用pd.read_table进行加载,然而,有时还是需要做一些手工处理。由于接收到含有畸形行的文件而使read_table出毛病的情况并不少见。为了说明这些基本工具,看看下面这个 简单的CSV文件:

>>> import csv

>>> f=open("test.csv","r",encoding="utf-8")

>>> data=csv.reader(f)

>>> for line in data:

... print(line)

...

['a', 'b', 'c']

['1', '2', '3']

['1', '2', '3']

现在,为了使数据格式合乎要求,你需要对其做一些整理工作。我们一步一步来做。首先,读取文件到一个多行的列表中:

>>> with open("test.csv","r",encoding="utf-8") as f:

... lines=list(csv.reader(f))

...

>>> lines

[['a', 'b', 'c'], ['1', '2', '3'], ['1', '2', '3']]

然后,我们将这些行分为标题行和数据行:

>>> header,value=lines[0],lines[1:]

>>> header

['a', 'b', 'c']

>>> value

[['1', '2', '3'], ['1', '2', '3']]

然后,我们可以用字典构造式和zip(*values),后者将行转置为列,创建数据 列的字典:

>>> data_dict = {h:v for h, v in zip(header, zip(*value))}

>>> data_dict

{'a': ('1', '1'), 'b': ('2', '2'), 'c': ('3', '3')}

CSV文件的形式有很多.只需定义csv.Dialect的一个子类即可定义出新格式 (如专门的分隔符、字符串引用约定、行结束符等):

class my_dialect(csv.Dialect):

lineterminator = '\n'

delimiter = ';'

quotechar = '"'

quoting = csv.QUOTE_MINIMAL

reader = csv.reader(f,dialect=my_dialect)

各个CSV语支的参数也可以用关键字的形式提供给csv.reader,而无需定义子类:

reader = csv.reader(f,delimiter='|')

可用的选项(csv.Dialect的属性)及其功能如下表所示

对于那些使用复杂分隔符或多字符分隔符的文件,csv模块就无 能为力了.这种情况下,你就只能使用字符串的split方法或正则表达式方法re.split进行行拆分和其他整理工作了.

要手工输出分隔符文件,你可以使用csv.writer.它接受一个已打开且可写的文件对象以及跟csv.reader相同的那些语支和格式化选项:

>>> with open("test.csv","w",encoding="utf-8") as f:

... writer=csv.writer(f,dialect=my_dialect)

... writer.writerow(('one','two','three')) #header

... writer.writerow(('1','2','3')) #可以是元组 也可以是列表

... writer.writerow(('1','2','3'))

>>> pd.read_csv("test.csv")

one;two;three

0 1;2;3

1 1;2;3

1.5.JSON

JSON 已经成为通过HTTP请求在Web浏览器和其他程序之间发送数据的标准格式之一.它是一种比表格型文本格式灵活得多的数据格式

obj = """

{"name":"Wes",

"places_lived":["United States","Spain","Germany"],

"pet":null,

"siblings":[{"name":"Scott","age":25,"pet":"Zuko"},

{"name":"Katie","age":31,"pet":"Cisco"}]

}

"""

除其空值null和一些其他的细微差别(如列表末尾不允许存在多余的逗号)之外,JSON非常接近于有效的Python代码。基本类型有对象(字典)、数组(列表)、字符串、数值、布尔值以及null。对象中所有的键都必须是字符串。许多Python库都可以读写JSON数据。我将使用json,因为它是构建于Python标准库中的。通过json.loads即可将JSON字符串转换成Python形式:

>>> result=json.loads(obj)

>>> result

{'name': 'Wes', 'places_lived': ['United States', 'Spain', 'Germany'], 'pet': None, 'siblings': [{'name': 'Scott', 'age': 25, 'pet': 'Zuko'}, {'name': 'Katie', 'age': 31, 'pet': 'Cisco'}]}

json.dumps则将Python对象转换成JSON格式

>>> asjson=json.dumps(result)

>>> asjson

'{"name": "Wes", "places_lived": ["United States", "Spain", "Germany"], "pet": null, "siblings": [{"name": "Scott", "age": 25, "pet": "Zuko"}, {"name": "Katie", "age": 31, "pet": "Cisco"}]}'

如何将(一个或一组)JSON对象转换为DataFrame或其他便于分析的数据结构就由你决定了.最简便的方式是:像DataFrame的构造器中传入一个字典的列表,并选取数据字段的子集:

>>> siblings = pd.DataFrame(result['siblings'], columns=['name', 'age'])

>>> siblings

name age

0 Scott 25

1 Katie 31

pd.read_json可以自动将特别格式的JSON数据集转化为Series或DataFrame.例如

>>> with open("test.json","r") as f:

... data=f.read()

...

>>> data

'\n[{"a": 1, "b": 2, "c": 3},\n {"a": 4, "b": 5, "c": 6},\n {"a": 7, "b": 8, "c": 9}]\n '

>>> data=pd.read_json("test.json")

>>> data

a b c

0 1 2 3

1 4 5 6

2 7 8 9

如果需要将数据从pandas中输出到Json,可以使用to_json方法

{"a":{"0":1,"1":4,"2":7},"b":{"0":2,"1":5,"2":8},"c":{"0":3,"1":6,"2":9}}

>>> print(data.to_json(orient='records'))

[{"a":1,"b":2,"c":3},{"a":4,"b":5,"c":6},{"a":7,"b":8,"c":9}]

1.6.XML和HTML:Web信息收集

Python有许多可以读写常见的HTML和XML格式数据的库,包括lxml、Beautiful Soup和html5lib。lxml的速度比较快,但其它的库处理有误的HTML或XML文件更好。

pandas有一个内置的功能,read_html,它可以使用lxml和Beautiful Soup自 动将HTML文件中的表格解析为DataFrame对象。为了进行展示,我从美国 联邦存款保险公司下载了一个HTML文件(pandas文档中也使用过),它记 录了银行倒闭的情况。首先,你需要安装read_html用到的库:

pip install lxml

pip install beautifulsoup4 html5lib

pandas.read_html有一些选项,默认条件下,它会搜索、尝试解析标签内的的表格数据。结果是一个列表的DataFrame对象:

tables = pd.read_html('examples/fdic_failed_bank_list.html')

print(len(tables)) #html中的表格数量

failures = tables[0]

failures.head()

这里,我们可以做一些数据清洗和分析(后面会进一步讲解),比如按年份计算倒闭的银行数:

close_timestamps = pd.to_datetime(failures['Closing Date'])

close_timestamps.dt.year.value_counts()

1.7. 利用lxml.objectify解析XML

前面,我介绍了pandas.read_html函数,它可以使用lxml或Beautiful Soup从HTML解析数据。XML和HTML的结构很相似,但XML更为通用。这里,我会 用一个例子演示如何利用lxml从XML格式解析数据。

纽约大都会运输署发布了一些有关其公交和列车服务的数据资料(http:// www.mta.info/developers/download.html)。这里,我们将看看包含在一组XML文件中的运行情况数据。每项列车或公交服务都有各自的文件(如Metro-North Railroad的文件是Performance_MNR.xml),其中每条XML记 录就是一条月度数据,如下所示:

我们先用lxml.objectify解析该文件,然后通过getroot得到该XML文件的根节 点的引用:

from lxml import objectify

path = 'datasets/mta_perf/Performance_MNR.xml'

parsed = objectify.parse(open(path))

root = parsed.getroot()

root.INDICATOR返回一个用于产生各个XML元素的生成器。对于每条记录, 我们可以用标记名(如YTD_ACTUAL)和数据值填充一个字典(排除几个标 记):

data = []

skip_fields = ['PARENT_SEQ', 'INDICATOR_SEQ',

'DESIRED_CHANGE', 'DECIMAL_PLACES']

for elt in root.INDICATOR: #遍历所有数据

el_data = {}

for child in elt.getchildren(): #遍历子标签

if child.tag in skip_fields: #跳过这几个标签

continue

el_data[child.tag] = child.pyval #构建字典

data.append(el_data) #字典列表

最后,将这组字典转换为一个DataFrame:

perf = pd.DataFrame(data)

perf.head()

XML数据可以比本例复杂得多。每个标记都可以有元数据。看看下面这个HTML的链接标签(它也算是一段有效的XML):

from io import StringIO

tag = ‘Google’

root = objectify.parse(StringIO(tag)).getroot()

现在就可以访问标签或链接文本中的任何字段了(如href):

print(root)

print(root.get('href')) #获取属性

print(root.text) #获取文本

2.二进制数据格式

实现数据的高效二进制格式存储的最简单办法之一是使用Python内置的pickle序列化,pandas对象都有一个用于将数据以pickle格式保存到磁盘上的to_pickle方法

frame=pd.read_csv('test.csv')

frame.to_pickle('example_pickle')

可以通过pickle直接读取数据,或者使用pd.read_pickle

pd.read_pickle('example_pickle')

pandas内置支持两个二进制数据格式:HDF5和MessagePack。pandas或Numpy数据的其他存储格式有:

- bcolz:一种可压缩的列存储二进制格式,基于Blosc压缩库

- Feather:跨语言的列存储文件格式。其使用了Apache Arrow的列式内存格式。

2.1.使用HDF5格式

HDF5是一种存储大规模科学数组数的非常好的数据格式,它可以被作为C库,带有许多语言的接口.HDF5中的HDF指的是层次型数据格式.每个HDF5文件都含有一个文件系统式的节点结构,它能够存储多个数据集并支持元数据.与其他简单格式相比,HDF5支持存储多种压缩器的即时压缩,还能更高效地存储重复数据模式.对于那些非常大的无法直接存入内存的数据集,HDF5就是一个不错的选择,因为它可以高效的分块读取.

虽然可以用PyTables和h5py库直接访问HDF5文件,pandas提供了更为高效的接口,可以简化存储Series和DataFrane对象.HDFStore类可以像字典一样,处理低级的细节

>>> frame=pd.DataFrame({'a':np.random.randn(100)})

>>> store=pd.HDFStore('./mydata.h5')

>>> store['obj1']=frame

>>> store

<class 'pandas.io.pytables.HDFStore'>

File path: ./mydata.h5

HDF5文件中的对象可以通过与字典一样的API进行获取

>>> pd.options.display.max_rows=10

>>> store['obj1']

a

0 -1.852219

1 0.362798

2 -1.224496

3 0.344129

4 -0.528258

.. ...

95 0.186281

96 -1.445115

97 -0.094687

98 2.630851

99 0.180347

[100 rows x 1 columns]

HDFStore支持两种存储模式,‘fixed’和’table’.后者通常更慢,但是支持使用特殊语法进行查询操作

>>> store.put('obj2',frame,format='table')

>>> store.select('obj2',where=['index>=10 and index<=15'])

a

10 -0.388608

11 -1.380919

12 1.030166

13 1.480958

14 0.845949

15 -0.527707

>>> store.close()

put是store[‘obj2’]=frame方法的显示版本,允许我们设置其他的选项,比如格式

pandas.read_hdf()函数可以快捷地使用这些工具:

>>> frame.to_hdf('mydata.h5','obj3',format='table')

>>> pd.read_hdf('mydata.h5','obj3',where=['index < 5'])

a

0 -1.852219

1 0.362798

2 -1.224496

3 0.344129

4 -0.528258

注意:如果需要处理的数据位于远程服务器,比如Amazon S3或HDFS,使用专门为分布式存储(比如Apache Parquet)的二进制格式也许更加合适。

如需要本地处理海量数据,需好好研究PyTables和h5py。由于许多数据分析问题都是IO密集型(非CPU密集型),利用HDF5这类工具能显著提升应用程序的效率。(HDF5不是数据库,是最适合用作“一次写多次读”的数据集)

2.2.读取Miscrosoft Excel文件

pandas的ExcelFile类或pandas.read_excel函数支持读取存储在Excel 2003及更高版本的表格型数据,他们分别使用xlrd或openpyxl读取xls和xlsx文件

要使用ExcelFile,通过传递xls或xlsx路径创建一个实例:

xlsx = pd.ExcelFile('ex1.xlsx')

存储在表单中的数据可以用read_excel读取到DataFrame中

pd.read_excel(xlsx,'sheet1')

如果要读取一个文件中的多个表单,创建ExcelFile会更快,但是也可以将文件名直接传递到pd.read_excel

frame=pd.read_excel('ex1.xlsx')

如果要将pandas的数据写入为Execl格式,必须首先创建一个ExcelWriter,然后使用pandas对象的to_excel方法将数据写入其中

writer=pd.ExcelWriter('newex.xlsx')

frame.to_excel(writer,'sheet1')

writer.save()

还可以不使用ExcelWriter,而是传递文件的路径到to_excel

frame.to_excel('newex,xlsx')

2.3.Web APIs交互

通过爬虫获得数据字典(json文件)后,可以使用DataFrame进行解析,提取想要的字段

frame=pd.DataFrame(data,columns=[xx,xx,xx])

2.4.数据库交互

在商业场景下,大多数数据可能不是存储在文本或Excel文件中。基于SQL的关系型数据库(如SQL Server、PostgreSQL和MySQL等)使用非常广泛,其它一些数据库也很流行。数据库的选择通常取决于性能、数据完整性以及应用程序的伸缩性需求。

将数据从SQL加载到DataFrame的过程很简单,此外pandas还有一些能够简化该过程的函数。例如,我将使用SQLite数据库(通过Python内置的sqlite3驱动器):

import sqlite3

query = """

CREATE TABLE test

(a VARCHAR(20), b VARCHAR(20),

c REAL, d INTEGER

;"""

con = sqlite3.connect('mydata.sqlite')

con.execute(query)

<sqlite3.Cursor at 0x7f6b12a50f10>

con.commit()

然后插入几行数据:

data = [('Atlanta', 'Georgia', 1.25, 6),

.....: ('Tallahassee', 'Florida', 2.6, 3),

.....: ('Sacramento', 'California', 1.7, 5)]

stmt = "INSERT INTO test VALUES(?, ?, ?, ?)"

con.executemany(stmt, data)

<sqlite3.Cursor at 0x7f6b15c66ce0>

从表中选取数据时,大部分Python SQL驱动器(PyODBC、psycopg2、MySQLdb、pymssql等)都会返回一个元组列表:

cursor = con.execute('select * from test')

rows = cursor.fetchall()

rows

[('Atlanta', 'Georgia', 1.25, 6),

('Tallahassee', 'Florida', 2.6, 3),

('Sacramento', 'California', 1.7, 5)]

你可以将这个元组列表传给DataFrame构造器,但还需要列名(位于光标的description属性中):

cursor.description

(('a', None, None, None, None, None, None),

('b', None, None, None, None, None, None),

('c', None, None, None, None, None, None),

('d', None, None, None, None, None, None))

pd.DataFrame(rows, columns=[x[0] for x in cursor.description])

a b c d

0 Atlanta Georgia 1.25 6

1 Tallahassee Florida 2.60 3

2 Sacramento California 1.70 5

四、数据清洗和准备

在数据分析和建模的过程中,相当多的时间要用在数据准备上:加载、清理、转换以及重塑。这些工作会占到分析师时间的80%或更多。有时,存储在文件和数据库中的数据的格式不适合某个特定的任务。许多研究者都选择使用通用编程语言(如Python、Perl、R或Java)或UNIX文本处理工具(如sed或awk)对数据格式进行专门处理。幸运的是,pandas和内置的Python标准库提供了一组高级的、灵活的、快速的工具,可以让你轻松地将数据规整为想要的格式。

如果你发现了一种本书或pandas库中没有的数据操作方式,请在邮件列表或GitHub网站上提出。实际上,pandas的许多设计和实现都是由真实应用的需求所驱动的。

在本章中,我会讨论处理缺失数据、重复数据、字符串操作和其它分析数据转换的工具。

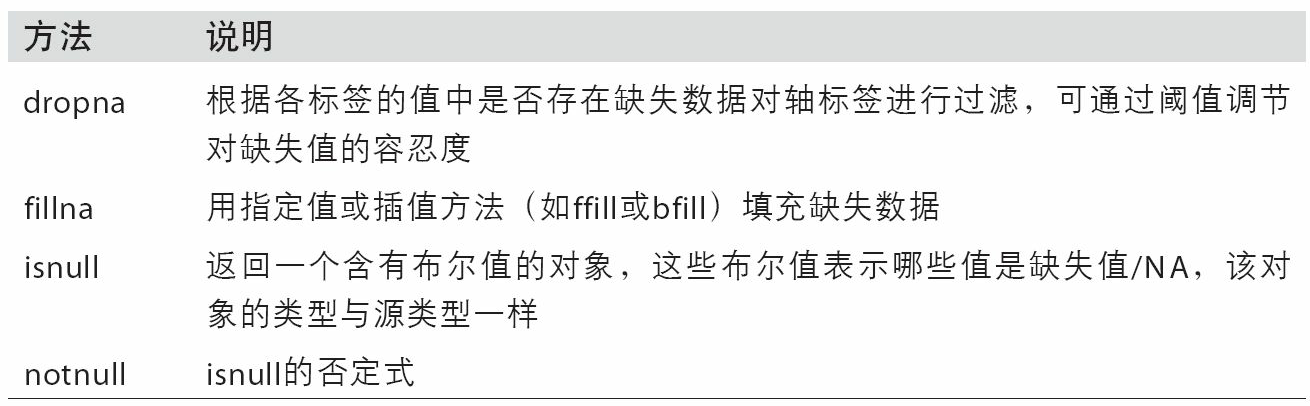

1.处理缺失数据

在许多数据分析工作中,缺失数据是经常发生的。pandas的目标之一就是尽量轻松地处理缺失数据。例如,pandas对象的所有描述性统计默认都不包括缺失数据。

缺失数据在pandas中呈现的方式有些不完美,但对于大多数用户可以保证功能正常。对于数值数据,pandas使用浮点值NaN(Not a Number)表示缺失数据。我们称其为哨兵值,可以方便的检测出来:

>>> string_data = pd.Series(['aardvark', 'artichoke', np.nan, 'avocado'])

>>> string_data

0 aardvark

1 artichoke

2 NaN

3 avocado

dtype: object

>>> string_data.isnull()

0 False

1 False

2 True

3 False

dtype: bool

在pandas中,采用了R语言中的惯用法,即将缺失值表示为NA,它表示不可用not available.在统计应用中,NA数据可能是不存在的数据或者虽然存在,但未被观察到.当进行数据清洗和分析时,最好直接对缺失数据进行分析,以判断数据采集的问题或缺失数据可能导致的偏差

Python内置的None值在对象数组中也可以作为NA:

>>> string_data[0]=None

>>> string_data.isnull()

0 True

1 False

2 True

3 False

dtype: bool

pandas项目中还在不断优化内部细节以更好地处理缺失数据,像用户的API功能,pd.isnull

1.1.滤除缺失数据

过滤掉缺失数据的办法有很多.可以通过pd.isnull或布尔索引的手工方法,但dropna可能会更实用一些

>>> from numpy import nan as NA

>>> data=pd.Series([1, NA, 3.5, NA, 7])

>>> data.dropna()

0 1.0

2 3.5

4 7.0

dtype: float64

这等价于

>>> data[data.notnull()]

0 1.0

2 3.5

4 7.0

dtype: float64

对于DataFrame对象,dropna默认丢弃任何含有缺失值的行

>>> data = pd.DataFrame([[1., 6.5, 3.], [1., NA, NA],[NA, NA, NA], [NA, 6.5, 3.]])

>>> data

0 1 2

0 1.0 6.5 3.0

1 1.0 NaN NaN

2 NaN NaN NaN

3 NaN 6.5 3.0

>>> data.dropna()

0 1 2

0 1.0 6.5 3.0

传入how='all’将之丢弃全为NA的那些行

>>> data.dropna(how='all')

0 1 2

0 1.0 6.5 3.0

1 1.0 NaN NaN

3 NaN 6.5 3.0

用这种方式丢弃,只需传入axis=1

>>> data[4]=NA

>>> data

0 1 2 4

0 1.0 6.5 3.0 NaN

1 1.0 NaN NaN NaN

2 NaN NaN NaN NaN

3 NaN 6.5 3.0 NaN

>>> data.dropna(axis=1)

Empty DataFrame

Columns: []

Index: [0, 1, 2, 3]

>>> data.dropna(axis=1,how='all')

0 1 2

0 1.0 6.5 3.0

1 1.0 NaN NaN

2 NaN NaN NaN

3 NaN 6.5 3.0

另一个滤除DataFrame行的问题涉及时间序列数据.假设只想留下一部分观测数据,可以使用thresh参数实现此目的

>>> df=pd.DataFrame(data=np.random.randn(7,3))

>>> df.iloc[:4,1]=NA

>>> df.iloc[:2,2]=NA

>>> df

0 1 2

0 -1.094214 NaN NaN

1 0.736272 NaN NaN

2 -0.022099 NaN -1.360762

3 -1.237905 NaN -0.439053

4 0.278880 0.334727 -1.822946

5 -0.607863 -0.513699 0.604313

6 0.197915 1.674042 -1.346943

>>> df.dropna()

0 1 2

4 0.278880 0.334727 -1.822946

5 -0.607863 -0.513699 0.604313

6 0.197915 1.674042 -1.346943

>>> df.dropna(thresh=2)

0 1 2

2 -0.022099 NaN -1.360762

3 -1.237905 NaN -0.439053

4 0.278880 0.334727 -1.822946

5 -0.607863 -0.513699 0.604313

6 0.197915 1.674042 -1.346943

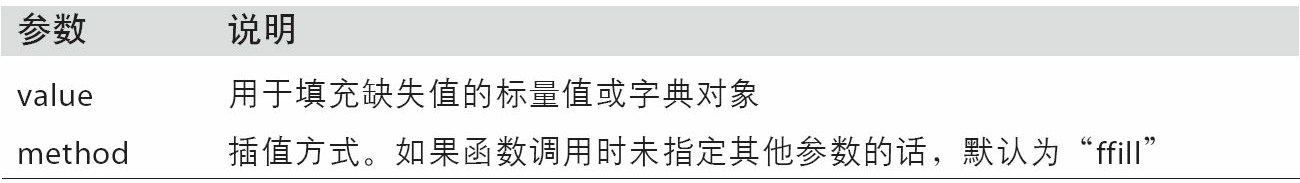

1.2.填充缺失数据

大多数情况fillna是最主要的函数

>>> df.fillna(0)

0 1 2

0 -1.094214 0.000000 0.000000

1 0.736272 0.000000 0.000000

2 -0.022099 0.000000 -1.360762

3 -1.237905 0.000000 -0.439053

4 0.278880 0.334727 -1.822946

5 -0.607863 -0.513699 0.604313

6 0.197915 1.674042 -1.346943

若用一个字典,fillna就可以实现对不同列填充不同的值

>>> df.fillna({1:0,2:99})

0 1 2

0 -1.094214 0.000000 99.000000

1 0.736272 0.000000 99.000000

2 -0.022099 0.000000 -1.360762

3 -1.237905 0.000000 -0.439053

4 0.278880 0.334727 -1.822946

5 -0.607863 -0.513699 0.604313

6 0.197915 1.674042 -1.346943

fillna会默认返回新对象,但也可以就现有对象进行就地修改

>>> _=df.fillna(0,inplace=True)

>>> df

0 1 2

0 -1.094214 0.000000 0.000000

1 0.736272 0.000000 0.000000

2 -0.022099 0.000000 -1.360762

3 -1.237905 0.000000 -0.439053

4 0.278880 0.334727 -1.822946

5 -0.607863 -0.513699 0.604313

6 0.197915 1.674042 -1.346943

对于reindexing有效的那些插值的方法也可以用于fillna:

>>> df = pd.DataFrame(np.random.randn(6, 3))

>>> df.iloc[2:, 1] = NA

>>> df.iloc[4:, 2] = NA

>>> df

0 1 2

0 -0.176256 0.420071 0.105654

1 0.032201 1.239530 -0.523275

2 0.070707 NaN -0.002044

3 -1.079108 NaN -0.104748

4 0.458134 NaN NaN

5 0.097470 NaN NaN

>>> df.fillna(method='ffill')

0 1 2

0 -0.176256 0.420071 0.105654

1 0.032201 1.239530 -0.523275

2 0.070707 1.239530 -0.002044

3 -1.079108 1.239530 -0.104748

4 0.458134 1.239530 -0.104748

5 0.097470 1.239530 -0.104748

>>> df.fillna(method='ffill',limit=2)

0 1 2

0 -0.176256 0.420071 0.105654

1 0.032201 1.239530 -0.523275

2 0.070707 1.239530 -0.002044

3 -1.079108 1.239530 -0.104748

4 0.458134 NaN -0.104748

5 0.097470 NaN -0.104748

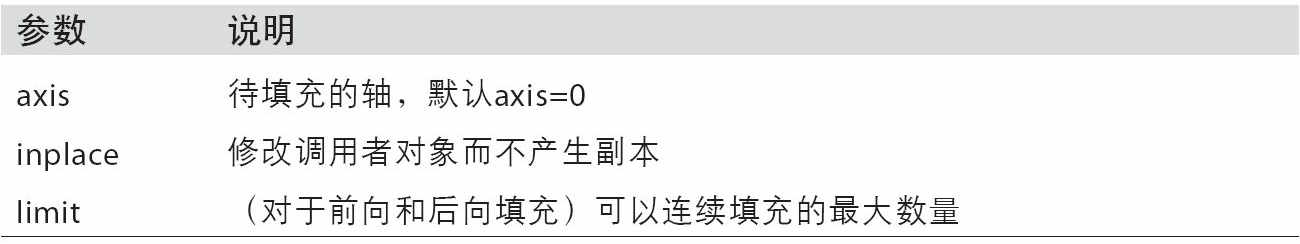

下面是fillna的参数

2.数据转换

DataFrame中出现重复行有多种原因,下面是一个例子

>>> data = pd.DataFrame({'k1': ['one', 'two'] * 3 + ['two'],'k2': [1, 1, 2, 3, 3, 4, 4]})

>>> data

k1 k2

0 one 1

1 two 1

2 one 2

3 two 3

4 one 3

5 two 4

6 two 4

DataFrame的duplicated方法返回一个布尔型Series,表示各行是否是重复行

>>> data.duplicated()

0 False

1 False

2 False

3 False

4 False

5 False

6 True

还有一个于此相关的drop_duplicates方法,它返回一个DataFrame,重复的数组会被标记为False

>>> data.drop_duplicates()

k1 k2

0 one 1

1 two 1

2 one 2

3 two 3

4 one 3

5 two 4

这两个方法默认会判断全部列,也可以指定部分列进行重复项判断.假设还有一列值,且只希望根据k1列过滤重复值

>>> data['v1']=range(7)

>>> data

k1 k2 v1

0 one 1 0

1 two 1 1

2 one 2 2

3 two 3 3

4 one 3 4

5 two 4 5

6 two 4 6

>>> data.drop_duplicates('k1')

k1 k2 v1

0 one 1 0

1 two 1 1

duplicated和drop_duplicates默认保留的是第一个出现的值组合,传入keep='last’则保留最后一个:

>>> data.drop_duplicates(['k1','k2'],keep='last')

k1 k2 v1

0 one 1 0

1 two 1 1

2 one 2 2

3 two 3 3

4 one 3 4

6 two 4 6

2.1.利用函数或映射进行出局转换

对于许多数据值,可能希望根据数组,Seires或DataFrame列中的值来实现转换工作,下面是一组有关肉类的数据

>>> data = pd.DataFrame({'food': ['bacon', 'pulled pork', 'bacon','Pastrami', 'corned beef', 'Bacon','pastrami', 'honey ham', 'nova lox'],'ounces': [4, 3, 12, 6, 7.5, 8, 3, 5, 6]})

>>> data

food ounces

0 bacon 4.0

1 pulled pork 3.0

2 bacon 12.0

3 Pastrami 6.0

4 corned beef 7.5

5 Bacon 8.0

6 pastrami 3.0

7 honey ham 5.0

8 nova lox 6.0

假如要添加一列表示该肉类食物来源的动物类型,可以先编写一个不同肉类动物的映射

>>> meat_to_animal = {

... 'bacon': 'pig',

... 'pulled pork': 'pig',

... 'pastrami': 'cow',

... 'corned beef': 'cow',

... 'honey ham': 'pig',

... 'nova lox': 'salmon'

... }

Series的map方法接受一个函数或者映射关系的字典型对象,但是这里有一些肉类的首字母大写了,而另一些则没有,因此还需要先将各个值转换为小写

>>> data['anmial']=lowercased.map(meat_to_animal)

>>> data

food ounces anmial

0 bacon 4.0 pig

1 pulled pork 3.0 pig