YOLOv1

? ? ? ? 论文思想:

????????????????1)将一幅图像分成SxS个网格(grid cell),如果某个object的中心落在这个网格中,则该网格负责预测该object。

? ? ? ? ? ? ? ? 2)每个网格要预测B(论文中为2)个bounding box,每个bounding box除了要预测位置之外,还要负责预测一个confidence值和C个类别的分数,其中confidence = Pr(object)* IoU(truth,pred),Pr(object)的值为0或1,当网格中确实存在object时值为1,否则为0。

?

网络结构:

?

?其中最后的30channels是指每个网格预测的2个box(x, y, w, h),2个confidence值和20个类别的预测分数(VOC数据集),7x7是讲图片分成7x7个网格。

损失函数:

?

?

YOLO v2

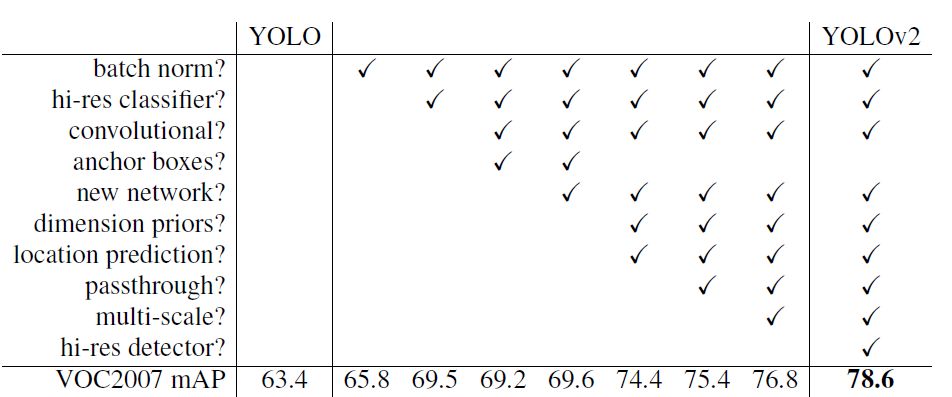

? ? ? ? 在v1的基础上进行了一系列的改进

?1)Batch Normalization可以提升模型收敛速度,而且可以起到一定正则化效果,降低模型的过拟合。在YOLOv2中,每个卷积层后面都添加了Batch Normalization层,并且不再使用droput。

2)?High Resolution Classifier 使用高分辨率检测模型。

3)Convolutionlal With Anchor Boxes?在YOLOv1中,输入图片最终被划分为7*7网格,每个单元格预测2个边界框。YOLOv1最后采用的是全连接层直接对边界框进行预测,其中边界框的宽与高是相对整张图片大小的,而由于各个图片中存在不同尺度和长宽比(scales and ratios)的物体,YOLOv1在训练过程中学习适应不同物体的形状是比较困难的,这也导致YOLOv1在精确定位方面表现较差。针对这一问题,yolov2借鉴Faster RCNN中RPN层的anchor box的策略,移除了YOLOv1中的全连接层而采用了卷积和anchor boxes来预测边界框。为了使检测所用的特征图分辨率更高,移除其中的一个pool层。

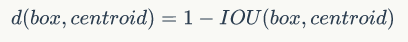

4)Dimension Clusters??YOLOv2采用k-means聚类方法对训练集中的边界框做了聚类分析。因为设置先验框的主要目的是为了使得预测框与ground truth的IOU更好,所以聚类分析时选用box与聚类中心box之间的IOU值作为距离指标:

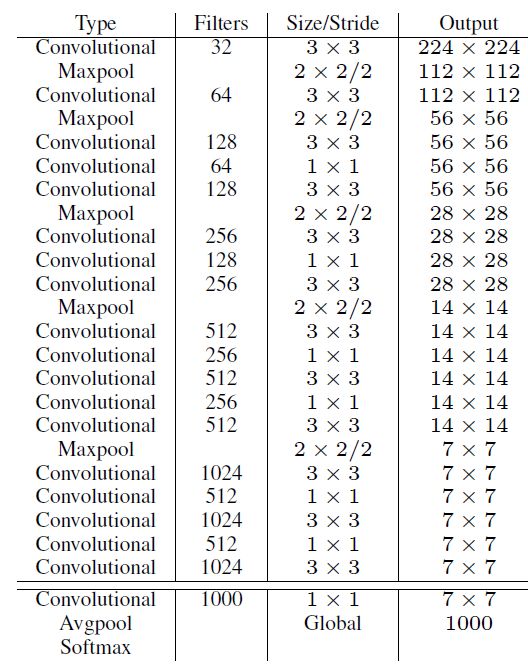

?5)?New Network:Darknet-19??YOLOv2采用了一个新的backbone,称为Darknet-19,包括19个卷积层和5个maxpooling层

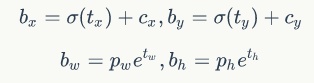

?6)Direct location prediction??YOLOv2借鉴RPN网络使用anchor boxes来预测边界框相对先验框的offsets。边界框的实际中心位置(x,y)需要根据预测的坐标偏移值(tx,ty),先验框的尺度(wa,ha)以及中心坐标(xa,ya)来计算:

x = (tx * wa) + xa , y = (ty * ha) + ya

但是上面的公式是无约束的,预测的边界框很容易向任何方向偏移,导致模型的不稳定性。所以,YOLOv2弃用了这种预测方式,而是沿用YOLOv1的方法,就是预测边界框中心点相对于对应cell左上角位置的相对偏移值,为了将边界框中心点约束在当前cell中,使用sigmoid函数处理偏移值,这样预测的偏移值在(0,1)范围内(每个cell的尺度看做1),根据边界框预测的4个offsets(tx, ty, tw, th)可以按下面的公式计算出边界框实际位置和大小

?7)Fine-Grained Features??YOLOv2提出了一种passthrough层来利用更精细的特征图。

YOLOv2所利用的Fine-Grained Features是26*26大小的特征图(最后一个maxpooling层的输入),对于Darknet-19模型来说就是大小为26*26*512的特征图。passthrough层与ResNet网络的shortcut类似,以前面更高分辨率的特征图为输入,然后将其连接到后面的低分辨率特征图上。前面的特征图维度是后面的特征图的2倍,passthrough层抽取前面层的每个2*2的局部区域,然后将其转化为channel维度,对于26*26*512的特征图,经passthrough层处理之后就变成了13*13*256的新特征图?,这样就可以与后面的13*13*1024特征图连接在一起形成13*13*1280的特征图,然后在此特征图基础上卷积做预测。

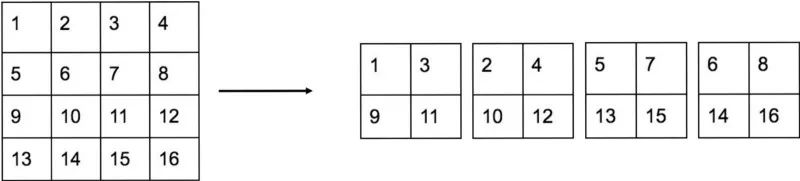

?passthrough层实例

?将原特征层分成四份,每份的相同位置的信息放在一起,然后在channels维度上进行拼接。

8)Multi-Scale Training???为了增强模型的鲁棒性,YOLOv2采用了多尺度输入训练策略,就是在训练过程中每间隔一定的batch之后改变模型的输入图片大小,由于YOLOv2的下采样总步长为32,输入图片大小选择一系列为32倍数的值{320,352,...,608}。

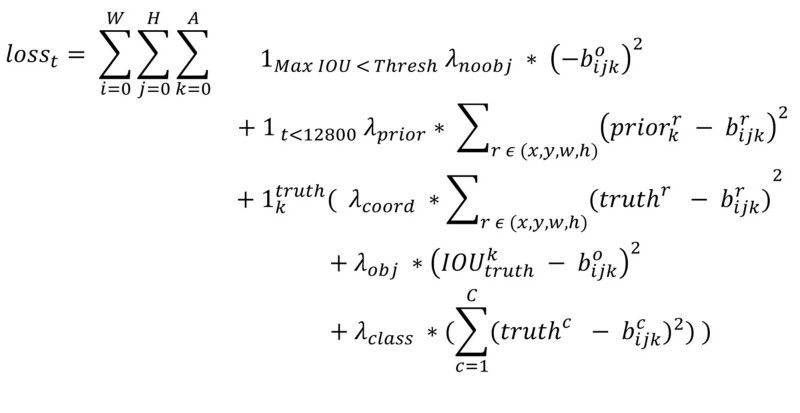

损失函数:

?第一项loss是计算background的置信度误差,但是哪些预测框来预测背景呢,需要先计算各个预测框和所有ground truth的IOU值,并且取最大值Max_IOU,如果该值小于一定的阈值(YOLOv2使用的是0.6),那么这个预测框就标记为background,需要计算noobj的置信度误差。第二项是计算先验框与预测宽的坐标误差,但是只在前12800个iterations间计算,我觉得这项应该是在训练前期使预测框快速学习到先验框的形状。第三大项计算与某个ground truth匹配的预测框各部分loss值,包括坐标误差、置信度误差以及分类误差。先说一下匹配原则,对于某个ground truth,首先要确定其中心点要落在哪个cell上,然后计算这个cell的5个先验框与ground truth的IOU值(YOLOv2中bias_match=1),计算IOU值时不考虑坐标,只考虑形状,所以先将先验框与ground truth的中心点都偏移到同一位置(原点),然后计算出对应的IOU值,IOU值最大的那个先验框与ground truth匹配,对应的预测框用来预测这个ground truth。在计算obj置信度时,在YOLOv1中target=1,而YOLOv2增加了一个控制参数rescore,当其为1时,target取预测框与ground truth的真实IOU值。对于那些没有与ground truth匹配的先验框(与预测框对应),除去那些Max_IOU低于阈值的,其它的就全部忽略,不计算任何误差。这点在YOLOv3论文中也有相关说明:YOLO中一个ground truth只会与一个先验框匹配(IOU值最好的),对于那些IOU值超过一定阈值的先验框,其预测结果就忽略了。这和SSD与RPN网络的处理方式有很大不同,因为它们可以将一个ground truth分配给多个先验框。尽管YOLOv2和YOLOv1计算loss处理上有不同,但都是采用均方差来计算loss。另外需要注意的一点是,在计算boxes的和误差时,YOLOv1中采用的是平方根以降低boxes的大小对误差的影响,而YOLOv2是直接计算,但是根据ground truth的大小对权重系数进行修正:l.coord_scale * (2 - truth.w*truth.h),这样对于尺度较小的boxes其权重系数会更大一些,起到和YOLOv1计算平方根相似的效果。