1.BN层

解决在训练中,中间层数据分布发生变化的问题,防止梯度爆炸、梯度消失,加快训练速度。

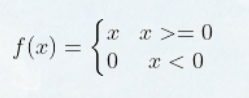

2.Relu

Relu会使一部分神经元的输出为0,这样就造成了网络的稀疏性,并且减少了参数之间互相依存的关系,缓解了过拟合的发生。

3.Sigmod

第一,采用sigmoid函数,算激活函数时(指数运算),计算量大。而使用Relu,整个计算节省了很多。

第二,对于深层网络,sigmoid函数反向传播时,很容易出现梯度消失的情况,(sigmoid接近饱和区的时候,变化太缓慢,导数趋于0)从而无法完成深层网络的训练。

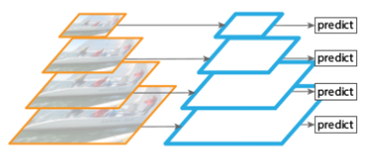

4.FPN(feature pyramid networks)—FPN网络详解

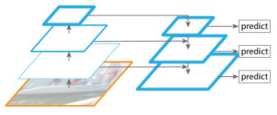

FPN主要解决的是物体检测中的多尺度问题,通过简单的网络连接改变,在基本不增加原有模型计算量的情况下,大幅度提升了小物体检测的性能。

同时利用低层特征高分辨率和高层特征的高语义信息,通过融合这些不同层的特征达到预测的效果。并且预测是在每个融合后的特征层上单独进行的,效果甚佳。

| 模型类型 | 示意图 |

|---|---|

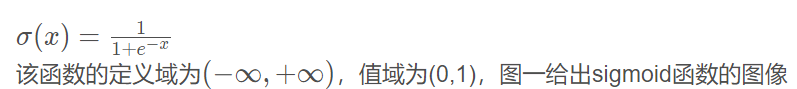

| 通常的CNN:自底向上卷积,然后使用最后一层特征图进行预测,像SPP-Net,Fast R-CNN,Faster R-CNN就是采用这种方式,即仅采用网络最后一层的特征。缺点就是会造成检测小物体的性能急剧下降。 |  |

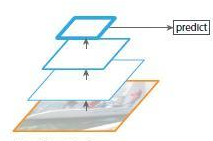

| 图片金字塔生成特征金字塔:利用图像的各个尺度进行训练和测试,如图所示,将图像做成不同的scale,然后不同scale的图像生成对应的不同scale的特征进行预测。可以得到比较理想的结果,但是比较耗时,不太适合运用到实际当中。 |  |

| 多尺度融合方式:SSD(Single Shot Detector)就是采用这种多尺度特征融合的方式,没有上采样过程,即从网络不同层抽取不同尺度的特征做预测,这种方式不会增加额外的计算量。 |  |

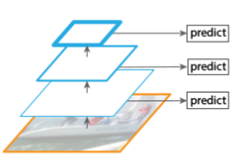

| FPN特征金字塔:同时利用低层特征高分辨率和高层特征的高语义信息,通过融合这些不同层的特征达到预测的效果。并且预测是在每个融合后的特征层上单独进行的,效果甚佳。 |  |

5.U-Net

| FPN | U-Net |

|---|---|

| FPN出自detection任务; | U-Net出自segmentation任务。 |

| FPN的“放大”部分是直接插值放大的,没有deconvolution的filters学习参数; | U-Net“放大”部分就是Decoder,需要deconvolution的filters学习参数的。 |

| FPN及其大多数改进都是把原Feature Map和FPN的Feature Map做加法; | U-Net及其大多数改进都是把原Feature Map和Decoder的Feature Map做Concatiantion,再做1x1卷积。 |

| FPN对每一个融合的层都做detection; | U-Net 只在最后一层做segmentation的pixel预测。 |