1. 图嵌入方法

由Bordes等人首次提出。

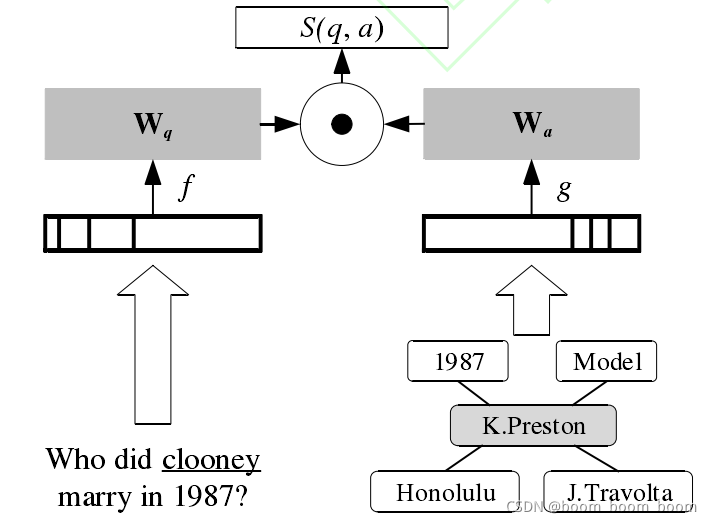

思想: 将问题和候选答案(KG中的实体、关系)嵌入同一个向量空间,比较其相似度,获得最终答案。

不足之处: 若将整个KG(候选答案)嵌入向量空间工作量巨大,系统准确率和运行时间不容乐观。

改进: 限定候选答案范围,仅将问题—答案路径及周围子图编码进向量空间。工作流程如下图所示。

模型介绍: 问题与答案均用

R

k

×

N

R^{k×N}

Rk×N的矩阵W表示,其中k为预先指定的嵌入空间维度,N为词汇表大小,

N

=

N

w

+

2

N

s

N=N_w+2N_s

N=Nw?+2Ns?,其中,

N

w

N_w

Nw?为自然语言问题中出现的单词类型总数,

N

s

N_s

Ns?为KG中实体、关系类型的总数。

??令问题为 q ,候选答案为 a , q 使用函数 f(·)完成映射,问题的词袋向量作为输入; a 使用函数g(·) 完成映射。分别使用 W 的 3 层、4 层向量表示问题实体 e 到候选答案实体的一跳、二跳路径,若候选答案实体一跳范围内有 C 个实体和 D 个关系,则继续使用 C + D 层向量表示候选答案实体附近的子图。设置 2 个

N

s

N_s

Ns? 的目的是区分路径表示和子图表示,两者分别使用不同的两个

N

s

N_s

Ns?区域进行表示。

??候选答案的得分通过问题表示 f(q) 与候选答案表示 g(a) 的点积获得,训练目标是使正确答案的得分最高。

2.记忆网络方法

MemNN

Weston 等人提出MemNN——一个以可读写的记忆组件为核心的学习系统。

MemNNs系统则将 MemNN 记忆网络框架应用于开放领域知识图谱问答领域,幵提出了重要的简单问题数据集 SimpleQuestions。

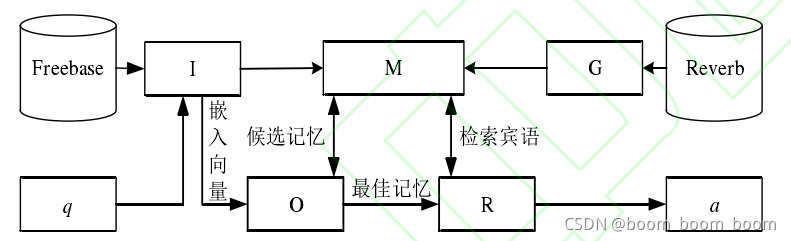

框架流程图:

系统架构由下图中的记忆(M)、输入(I)、输出(O)、响应(R)、泛化(G)共 5 个模块的组合而成。记忆模块 M 用于存储 KG 三元组,幵被剩余四个模块读写;输入模块 I 用于预处理外部输入,包括 KG 三元组及自然语言问题的预处理;输出模块 O 用于在 M 中选择与 I 的输出最相关的记忆,幵对所得候选记忆进行打分排序;响应模块R 用于将 O 提供的记忆以对应栺式输出最终结果;泛化模块 G 用于导入外部知识更新记忆模块 M 的内容。

??存储知识阶段,首先使用 I 模块对 Freebase 进行预处理,合幵具有相同头实体、关系的三元组,去除 Freebase 中介结点。后使用 3.1 节相同的词袋模型编码作为记忆存入 M 中。

??存入记忆后可使用问答对数据训练整个记忆网络框架。首先用输入模块 I 处理问题 q ,使用与图嵌入方法相同的词袋模型表示问题。输出模块 O 将问句中的所有 n-gram 与 KG 实体迚行匹配,确定候选实体,将以候选实体为头实体的三元组提出作为候选记忆,将候选记忆投影至与问题相同的低维嵌入空间,通过 cos 相似度作为得分函数排出最佳记忆。训练模型即调节 cos相似度计算过程中 2 个权值矩阵的过程。获得记忆后,由回答模块 R 将该记忆对应三元组的宾语作为最终答案 a 输出。

??模型训练完毕后,将 Reverb 三元组作为新的知识,用泛化模块 G 将新知识与旧知识融合并存储到记忆模块 M 中,在不经重新训练的情况下使用该记忆回答问题,结果显示模型具有较强的泛化能力。

3. 基于神经网络的语义解析

神经网络+图嵌入

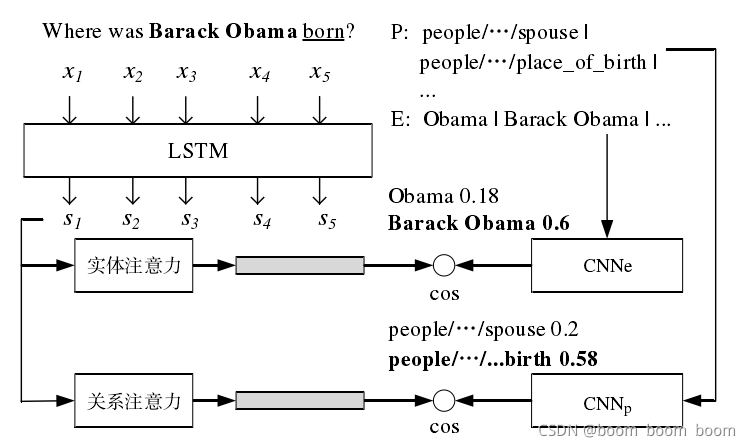

思想: 针对简单问题(仅包含单个实体和关系),神经网络替换传统方法的词汇表,图嵌入方法完成实体关系消歧。

工作流程: 根据实体提及获得对应流行度最高的 10 个实体作为候选实体集E ,根据 E 检索 KG 提取所有一跳关系作为候选关系集 P 。后将问题 q 的独热向量输入 LSTM 获得问题编码,候选实体集 E 、候选关系集 P 作为输入,系统分别从 E 、 P 集合选取最优实体、关系作为输出。选取过程为分别使用不同 CNN 网络以字符为单位编码,获得固定长度的向量表示,后使用注意力机制解码与问题最相关的实体与关系,使用语义相关函数计算解码器所得实体向量表示与候选实体对应向量表示的 cos相似度,选出相似度乘积最大的 e 、p 作为输出,得到用于构造逻辑查询语句的实体和关系。

参考文献:

陈子睿. 开放领域知识图谱问答研究综述[J]. 计算机科学与探索,2021.