Anchor Detr学习笔记:

1.首先介绍下什么叫锚点(Anchor point)

? ??Anchor point就类似一张钉在墙上的相框,但是钉的确不是那么的紧,相框可以围绕着钉子进行旋转,也就是做为变换的支点,类似的还有平移、缩放。这样就实现了图层的旋转与移动。

??懂了Anchor point以后,问题来了—怎么确定Anchor point的位置呢?

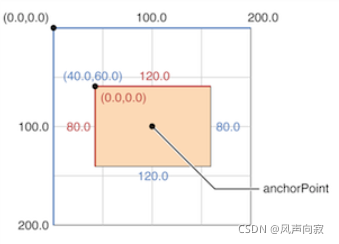

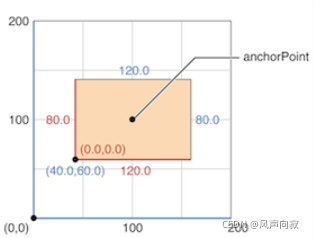

??经过一方学习后,我找到了这个答案。在IOS中,anchorPoint点的值是用一种相对bound的比例值来确定的。意思是说,在相框形成的单元坐标左上角、右下角中,AnchorPoint分别为(0,0)、(1,1),同样的就可以得到中心点、左下角和右上角的AnchorPoint为(0.5,0.5), (0,1), (1,0)。

如下图所示:

? ??(注意:iOS使用左手坐标系,坐标原点在左上角,MacOS使用右手坐标系,原点在左下角)如下图所示:

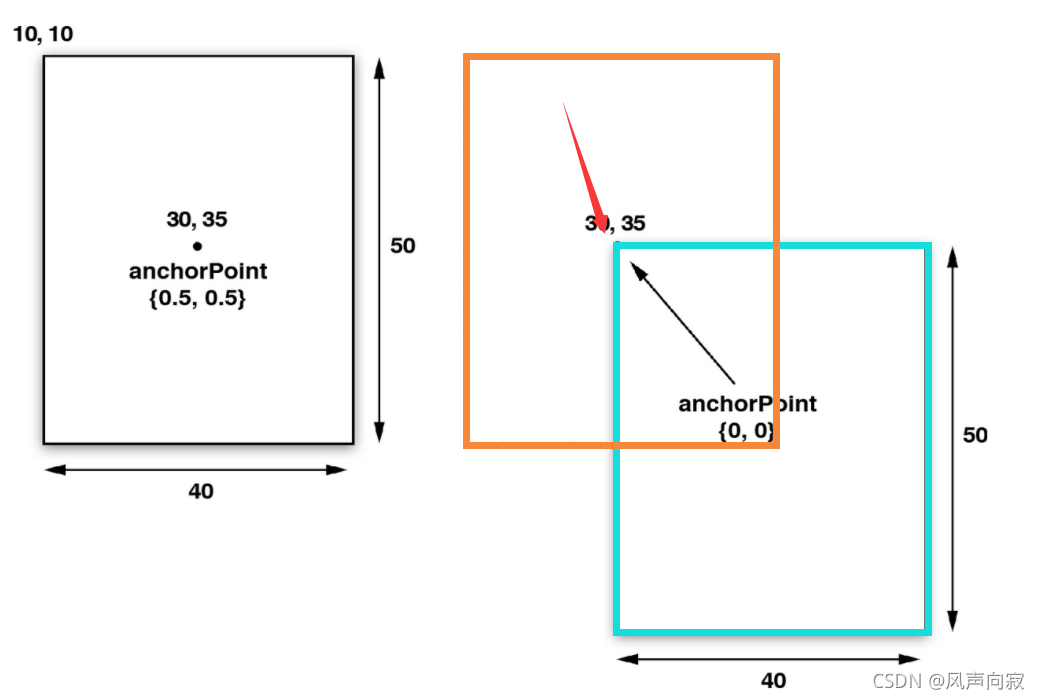

以下一张图片对Anchor point的移动进行讲解:

在我看来这张图的意思大概可以讲解为如下:

??原图(蓝色框)的锚点在(0.5,0.5)处,现在将它的锚点移到(0,0)位置,也就是原图的左上方的点(红色箭头所指位置),就相当于将整张图像”向左上方滑动“直到移动的图像的锚点与原图(0,0)位置重合,滑动后在原图左上方复制一个一模一样大小的视图(橙色框)。

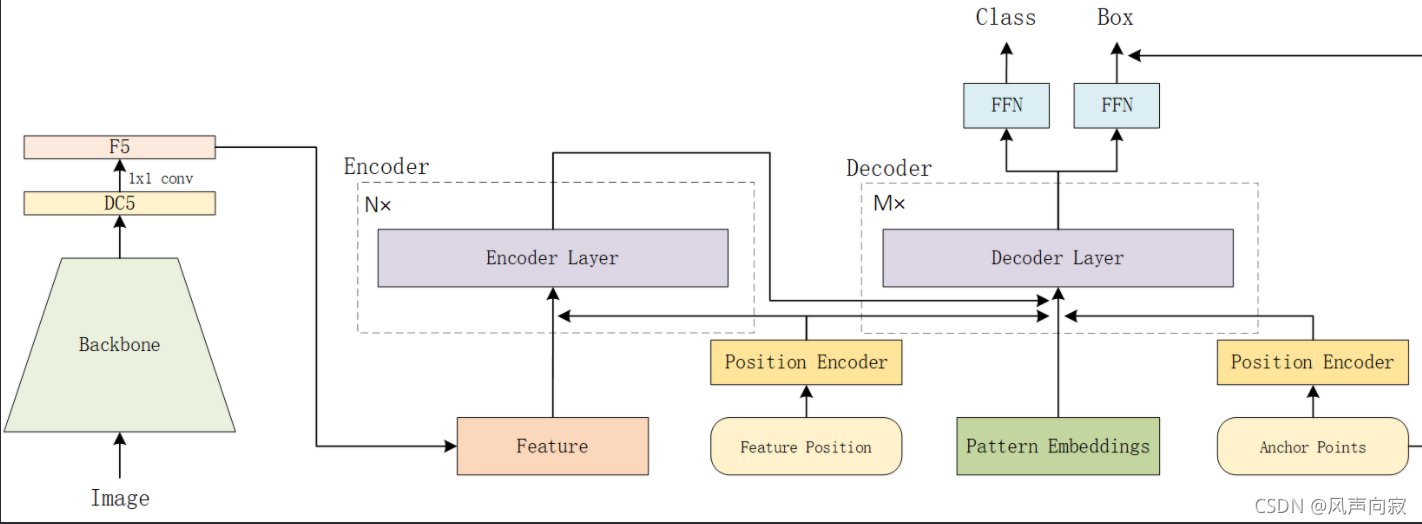

2.再来介绍下什么叫DETR

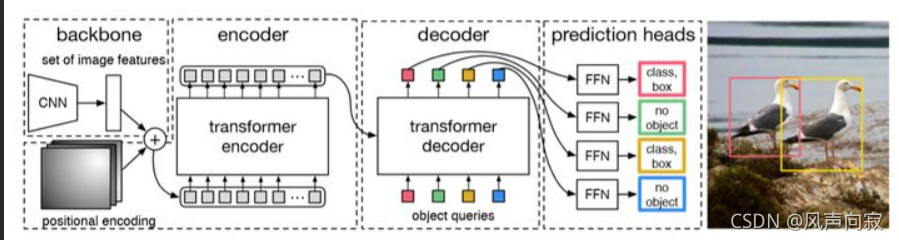

? ??DETR通过将常见的CNN与transformer架构相结合,直接(并行)预测最终的检测结果。 在训练期间,二分匹配将唯一的预测分配给GT框。 不匹配的预测应产生“无对象”类预测。

? ??DETR的流程大为简化,可以归结如下:Backbone -> Transformer -> detect header。

??其中,Backbone:主干网络,用于对图像进行特征提取,生成对应的feature map后,传递给后面的网络使用。

??Transformer:基于self—attention的模型,一般用于处理图像、语义问题,因为已经分布过一次笔记这里就不多介绍了。详细的可以看:(29条消息) Transformer学习笔记:_风声向寂的博客-CSDN博客

??detect header:后续连接的网络层,主要是服务于detection任务。

??下面给大家举个图片例子:

3.Anchor Detr

? ??Anchor Detr基于Transformer的目标检测器。在以前基于Transformer的检测器中,目标的查询是一组可学习的embedding。

??然而,每个可学习的embedding都没有明确的意义 (因为是随机初始化的),所以也不能解释它最终将集中在哪里。此外,由于每个对象查询将不会关注特定的区域,所以训练时优化也是比较困难的 。为了解决这些问题,大佬们借鉴了CNN目标检测器中的Anchor Point机制,使得每个查询都基于特定的Anchor Point的,使每个查询都可以集中在Anchor Point附近的目标上。

??此外大佬们还使用了一种轻量级的attention变体(行列解耦注意),减少attention的计算成本。

以下是其结构:

??以下是大佬们的项目,有兴趣的可以自取:megvii-research/AnchorDETR (github.com)

10.17学习笔记