梯度

梯度是一个所有偏微分的向量

1、求最小值

鞍点和局部极小值会影响到搜索最小值。

2、影响搜索过程的因素还有:

1)initialization status

2)learning rate (stepLR)

3)momentum

常见函数的梯度

激活函数

loss及其梯度

1、Mean Squared Error(MSE)均方差:

autograd.grad() 函数——求导

(1)w.required_grad_()# 设置w可以求导

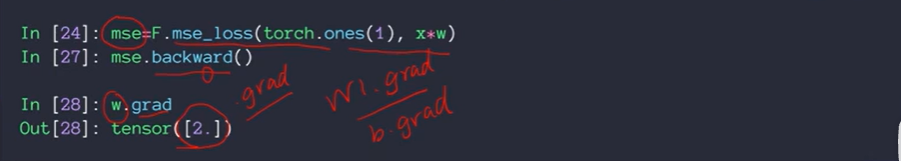

(2)因为pytorch是一个动态图,做一步计算一步图,w更新后图用的还是原来的图要使用[24]来更新图

(3)也可以这样计算导数,因为网络图已经记住计算导数的路径了,并且该函数把计算出来的导数保存到对应需要梯度的变量上,通过tensor.grad 来获取导数值

w.norm返回一个w本身的norm(范式)

w.grad.norm返回一个w梯度的norm(范式)

2、Cross Entropy Loss

p.backward()# 如果后面还需要在使用torch.backward(),需要设置retain_graph=True

借鉴

pytorch学习笔记5–pytorch基本运算