论文:Incorporating Temporal Prior from Motion Flow for Instrument Segmentation in Minimally Invasive Surgery Video

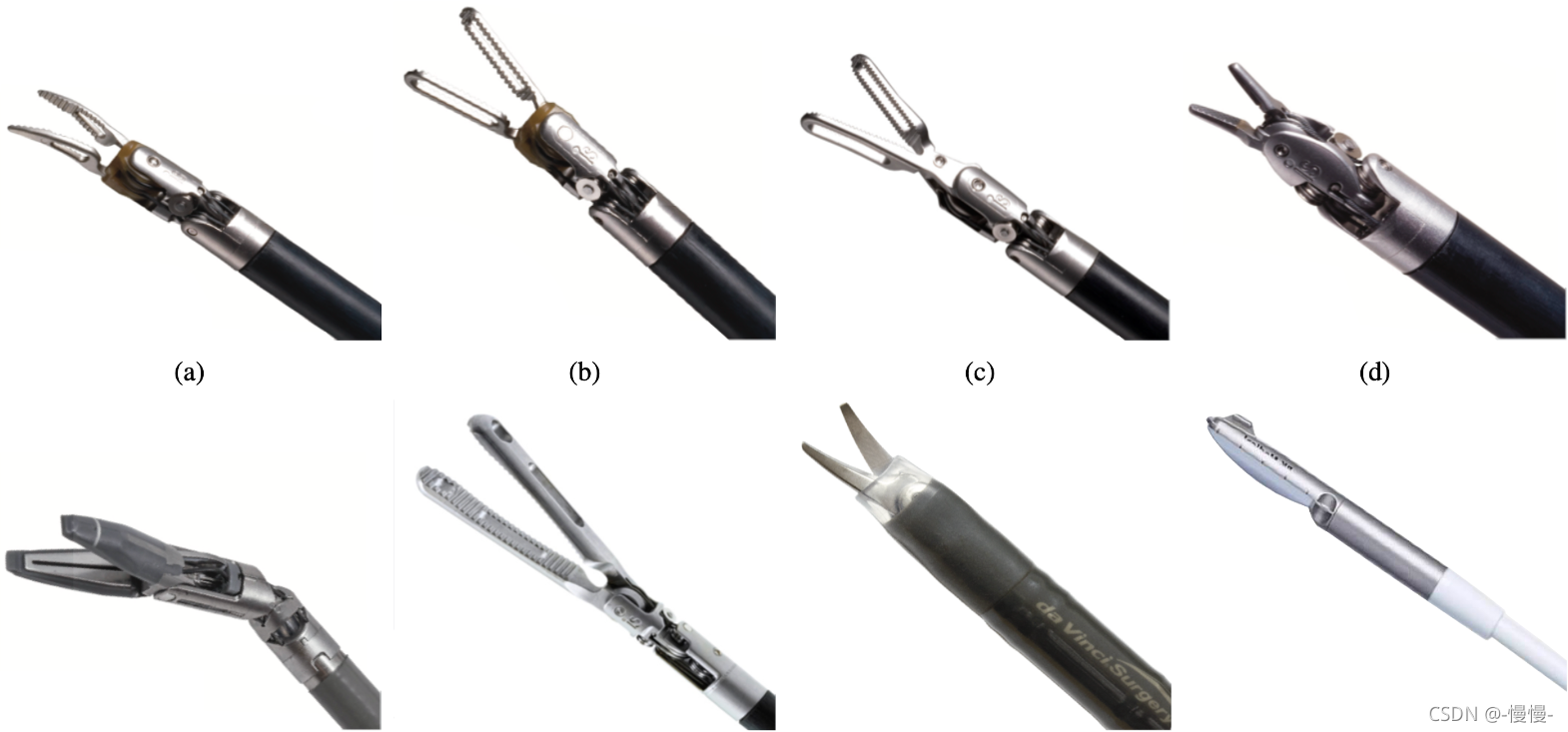

视频仪器自动分割是机器人辅助微创手术的基本问题,也是具有挑战性的问题。在这篇论文提出了一个新的框架来利用仪器内的运动信息,通过合并一个导出的时间之前的注意金字塔网络来精确分割。我们推断的先验可以提供仪器位置和形状的可靠指示,这些位置和形状根据帧间运动流从前一帧传播到当前帧。该先验被注入到编码器-解码器分割网络的中间,作为注意模块金字塔的初始化,以明确地引导分割输出从粗到细。这样,时间动态和注意网络就可以有效地互补和受益。作为额外的使用,我们的临时先验使半监督学习与周期无标记的视频帧,简单地通过反向执行。我们在2017年公开的MICCAI EndoVis机器人仪器分割挑战数据集上验证了我们的方法,其中包含三个不同的任务。我们的方法在所有三个任务中始终以很大的优势超过了最先进的结果。我们的半监督变体也证明了在临床实践中降低注释成本的潜力。

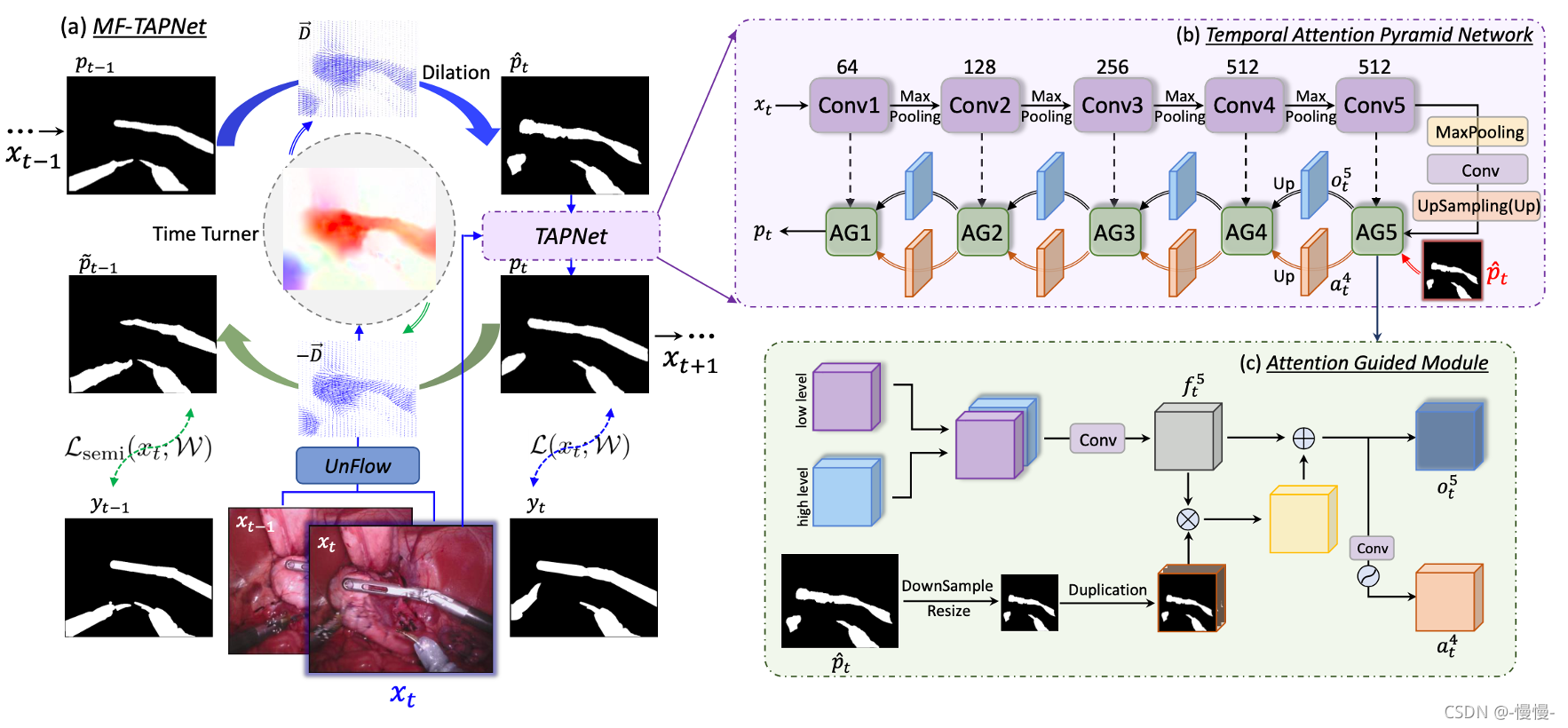

为此,作者提出的方法是:从视频图像的运动流(motion flow)中得到先验信息,再将先验信息整合到注意力金字塔网络中(称为MF-TAPNet)。

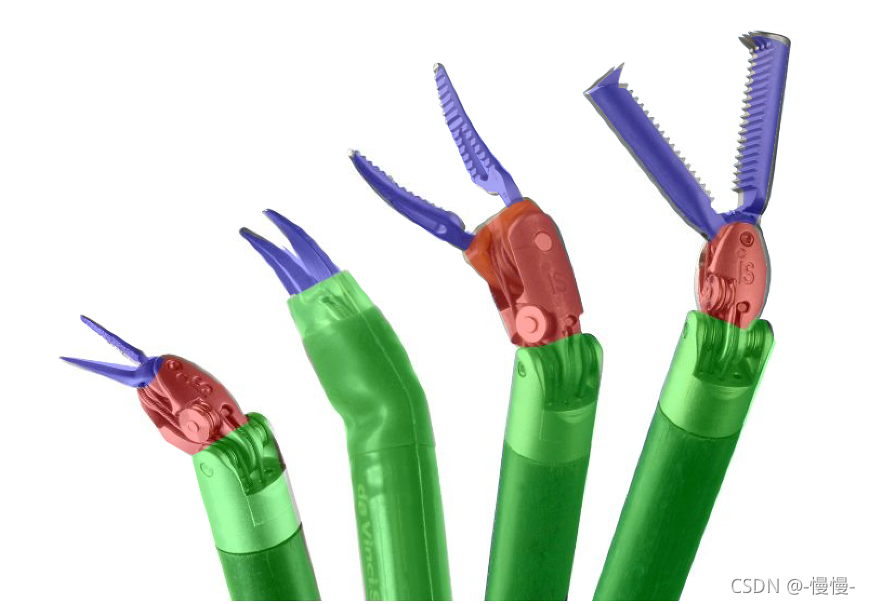

具体来说,首先使用Unflow [2]方法计算相邻的两帧之间的光流(optical flow),能表示每个像素移动的幅度和方向。作者认为,对应的mask也会发生相同的位移。基于这个假设,结合光流和网络输出的上一帧分割图,去预测当前帧中器械的位置和形状。这一步骤称为time turner,得到的当前帧的预测图为接下来的分割网络提供了可靠的先验信息(temporal prior)。然后,将得到的prior加入分割网络,即时序金字塔网络(TAPNet)的瓶颈层(bottleneck layer)作为初始的注意力图(attention map)。此分割网络由多尺度的注意力模块(multi-stage attention guided modules,缩写为AG)组成。在这种金字塔结构中可以逐渐完善注意力图,提升细化特征,最终得到准确的分割结果。以AG5来解释注意力模块的具体操作:首先使用跳跃连接来拼接高维和低维特征,再用1×1卷积来降低拼接结果 经过下采样和1×1卷积之后,与具有同样的维度,然后二者进行element-wise multiplication,提取prior识别出的特征。该结果再次与相加,并进行3×3卷积和sigmoid激活,产生下一个AG模块的attention map。

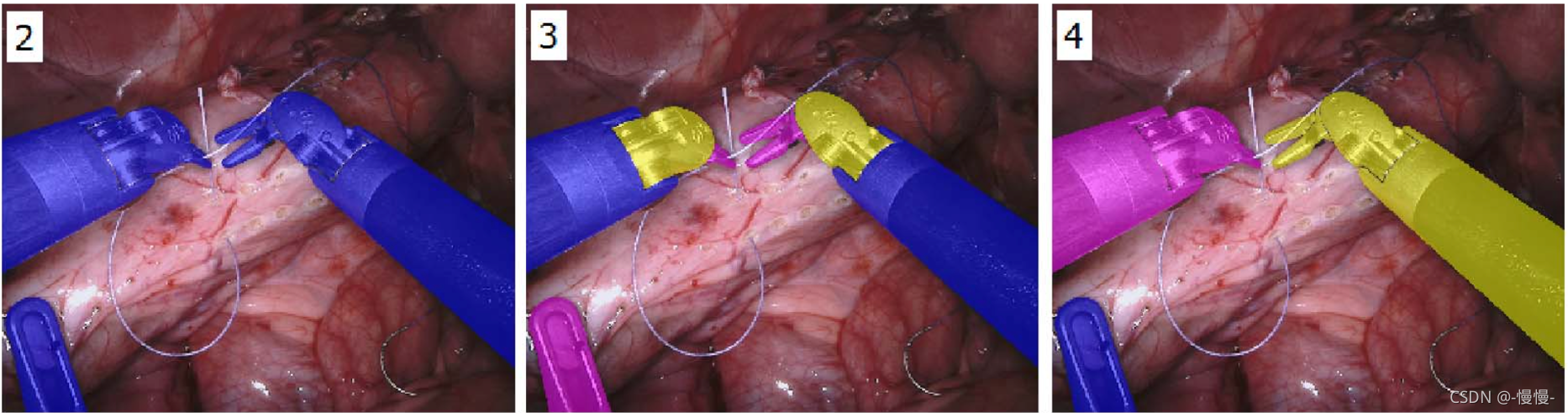

作者给出了在三个任务上不同框架进行四折交叉验证的分割结果,可以看到,TAPNet的性能比起之前的工作已经有所提升,而结合TAPNet和motion flow之后结果仍然能够继续提升。对于多类分割任务,采用加权的交叉熵loss。评价指标为两张mask之间的交并比和dice系数。图2为三种分割网络的结果对比。从上到下,对每个任务都选了连续的两帧以及它们对应的mask,图中第二行是图片对应的ground truth,第三行至第五行分别是PlainUNet、TAPNet和MF-TAPNet的分割结果。其中,MF-TAPNet对像素类别的判断最为准确。这表明,明确地结合时间先验可以提供强有力的指导,即使是先前框架的粗略预测。因此,我们的TAPNet可以金字塔式的细化引导,并逐渐专注于细分关注的对象。在这里,我们的TAPNet已经可以用最先进的方法取得可比的结果。更重要的是,我们的MF-TAPNet进一步大幅提高了所有任务的性能(平均2.67% IoU)。结果表明,在引入时间转换器的运动动力学后,先验图像的质量大大提高,能够更准确地表达当前帧中的形状和位置。一些可视结果如图2所示。MF-TAPNet可以实现完整一致的分割,很大程度上抑制了不相关和错误的区域。

第三个任务准确率最低,这反映了这个任务本身的巨大挑战,即在不同的细粒度类型中,外观(形状和强度值)极为相似。我们的方法是可扩展的,可以通过推断多类先验来进一步改进,而这种扩展对于其他方法是有限的。最后,由于我们的方法依赖于时间的一致性,当意外运动出现时,它的效果可能会降低,导致稍高的标准偏差。随着更稳定的外科机器人的发展,这一问题可以得到缓解。