《DisenQNet: Disentangled Representation Learning forEducational Questions》

DisenQNet:教育问题的解偶表示学习

目录

来源

数据挖掘领域顶会ACM Knowledge Discovery and Data Mining(KDD)

作者 Zhenya Huang(中国科学技术大学)

研究动机/背景(Motivation)

1.教育问题的基本表示学习是在线学习系统领域中的一个基本问题,它可以用于如问题的难度分析、相似度分析等应用:

- 如果注意到学生多次尝试当前题目还是错误,则建议提出更容易的问题 ———— 难度分析

- 在回答一个问题后选择类似的问题来复习所需的概念 ———— 相似度分析

2.大多数教育问题表示学习的解决方案按照有监督的方式(supervised)将一个问题的所有信息整合在一起,对于每个问题输出一个表示,这样的表示结果由于以下问题而不尽人意:

- 由于标记数据的缺乏,无法保证问题表示的能力 ———— 专家标记、学生标记困难

- 标签依赖的问题表示结果可移植性差,只能应用于特定的任务 ———— A、B系统不通用

- 将所有信息聚合到统一信息中会引入噪声 ———— 无法识别个性差异

因此,本文的目标:

1.它可以去除特定任务中的标签,通过自己进行问题学习来进行优化,应该以一种明确的方式来区分问题内在的不同特征;

2.它学习到的表示应该很灵活,可以应用于不同的下游任务 ;

传统方法

Question Understanding

| 名称 | 方法描述 | 优缺点 |

|---|---|---|

| 早期的学者[9] | 试图设计细粒度的规则或语法来理解问题,问题可以由特定的结构来组织,如语义树或模板。 | 这种结构需要手动设计,需要强大的专业知识、花费很多时间、但是匹配能力和范围非常有限。不适合用于包含数百万个问题资源的在线系统。 |

| Qiu et al.[24] | 利用NLP技术,提取了多项选择题的语义表示来预测难度。 | 该模型遵循有监督的方式,这需要足够的标记数据来进行优化。然而,在实践中获得高质量的问题标签是极其困难的。此外,它依赖于特定的应用程序,在不同的应用程序中应用的可行性很差。 |

| Liu et al.[18] | 提出了一个注意力模型来评估集成了异构信息的问题对之间的相似性。 | 虽然取得了一些成功,但仍采取有监督的方式,所以依旧存在标签获取困难和标签不足的问题。 |

Question Pre-training

预处理就是通过大量的语料库获得与具体任务无关的预训练模型。

基于预训练的方法,模型参数在语料库上进行预训练,然后在特定任务中进行微调。预训练充分利用大型语料库,试图将所有信息整合在一起,以学习每个输入的一个统一表示。

| 名称 | 方法描述 | 优缺点 |

|---|---|---|

| GPT(2017) | 利用了Transformer网络代替了LSTM作为语言模型来更好的捕获长距离语言结构。 | GPT 更多地用于自然语言生成,比如写文章、写诗等创作型任务,它本质上是一个单向语言模型,可以根据句子的一部分预测下一个词。 |

| BERT(2018) | 它不再像以往一样采用传统的单向语言模型或者把两个单向语言模型用浅层拼接的方法进行预训练,而是采用新的masked language model(MLM),以致能生成深度的双向语言表征 | BERT模型与GPT的区别就在于采用了Transformer Encoder,也就是每个时刻的Attention计算都能够得到全部时刻的输入,而GPT采用了Transformer Decoder,每个时刻的Attention计算只能依赖于该时刻前的所有时刻的输入。 |

| Yin et al.[36] | 首次尝试从异构数据中对教育问题的表示进行预训练,通过预训练来增强无标记的问题表示学习,集成一个特定问题的所有信息后表示为一个统一的向量。 | 缺点是具有相同概念属性的问题(如“function”)可能具较大差别的个性属性(如难度)。如果不能区分这些个性差异,可能会引入一些噪声。 |

主要思想

1.本文提出一个无监督模型DisenQNet,将一个问题分为两部分进行表示,即解偶表示:概念表示(concept representation)、个体表示(individual representation)。具体来说,本文通过三个自监督估计器(estimator)来进行互信息(mutual information)估计,来优化两个解耦表示。

注:这里提到的一些概念后文会详细解释。

2.本文又提出了一个增强模型DisenQNet+,它将通过无监督模型DisenQNet学习到的解耦表示应用于几个应用程序任务。具体来说,由于个性解耦表示(只有一个问题的个性信息而没有概念(concept)信息),它可以提高有监督学习在不同任务中的表示能力(即使拥有非常有限的标签),所以本文通过最大限度地提高无监督表示和监督表示之间的互信息来实现这一目标,以便知识可以从DisenQNet模型转移到监督模型。

下面展示的是我自己画的对于本文所做贡献的概览图:

耦合和解偶

耦合关系:反映了两个事物或事物内部个因素之间的相互作用、联系或依赖。

解偶:用数学方法将耦合的关系分离开来处理问题,解偶后的表示往往是互相独立的。

互信息

互信息,Mutual Information,缩写为MI,表示两个变量X与Y是否有关系,以及关系的强弱。

互信息的符号表示为 I (X,Y):收到Y前后关于X的不确定度减少的量(Y的值透露了多少关于X 的信息量)。

X,Y关系越密切,I(X,Y)就越大;I(X,Y)取0时,代表X与Y独立;I(X,Y)取1时,代表X与Y相同。

最近的研究显示,在许多领域的表示学习中采用了几种基于深度神经网络的非线性估计器进行互信息估计。

| 名称 | 方法描述 |

|---|---|

| Hjelm et al. [12] | 通过JS散度(Jensen-Shannon divergence)提出Deep InfoMax模型进行图表示学习。 |

| Velickovic et al. [32] and Sun et al. [31] | 分别在生成节点级嵌入和图级嵌入方面提出了DGI模型和 InfoGraph模型进行图表示学习。 |

| Sanchez et al. [28] | 采用互信息估计,通过两两实例学习进行shared和exclusive的图像解耦表示学习。 |

互信息I(X,Y)测量两个随机变量X、Y之间的依赖性,可以表示为一个给另一个变量的不确定性的减少量。

互信息的公式为I(X;Y) = H(X) ? H(X |Y) = H(Y) ? H(Y |X)

H(X)表示X的绝对熵,H(X|Y)表示X的条件熵

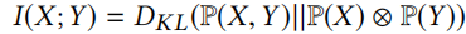

Kullback-Leibler divergence(KL散度)又称为相对熵 / 信息散度 / 信息增益。常用来衡量两个概率分布之间的距离。互信息又可以用KL散度进行表示:

对于高维的变量,Belghazi et al. [3]提出了基于Donsker-Varadhan表示的神经网络估计器MINE得到KL散度的对偶表示:

注: T θ T_\theta Tθ?(x,y)是神经网络估计器。

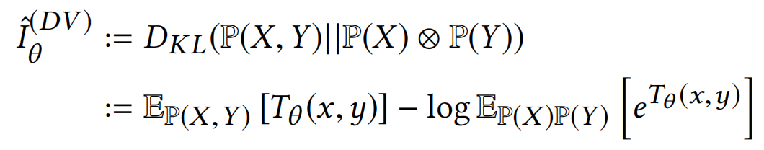

但是,由于KL散度是不对称的,MINE估计器对于负样本不稳定,为了克服这个问题,并且我们注意到表示学习工作并不关注互信息的精确价值,而是关注最大化它,Hjelm et al.[12]引入了一个近似Jensen-Shannon divergence(JS散度)估计器:

注:sp(x)是softplus激活函数

通过上式可以得到X、Y之间互信息I(X,Y)的下界

直观理解概念表示和概念表示

如图所示,

Q

1

,

Q

2

,

Q

3

Q_1,Q_2,Q_3

Q1?,Q2?,Q3?分别表示三个学习系统的具体问题,蓝色字体表示概念性名词,绿色字体表示问题中具体不同的表达式,红色字体表示难度和相似度关系。

对于概念表示(concept representation)就是更关注蓝色字体的部分;

对于个体表示(individual representation)则更关注绿色字体的部分;

由于

Q

1

Q_1

Q1?的表达式比

Q

2

Q_2

Q2?复杂,因此

Q

1

Q_1

Q1?比

Q

2

Q_2

Q2?更加难;

由于

Q

2

Q_2

Q2?和

Q

3

Q_3

Q3?的表达式和设问相似,因此

Q

2

Q_2

Q2?和

Q

3

Q_3

Q3?是相似的。

实现方法

DisenQNet

创新点

传统上,某个问题的表示学习是输出一个统一的d维向量(d?N),它应该能捕获尽可能多的信息,由于具有相同概念属性的问题可能会有很大区别,因此DisenQNet对问题进行解耦表示学习,输出二维向量,包括一个 v k v_k vk?∈ R d R_d Rd?引用其概念信息,另一个 v i v_i vi?∈ R d R_d Rd?包含其个性信息。

概览图

通过DisenQNet的概览图我们可以知道,DisenQNet主要由两个部分组成:

1.Question Encoder

2.Self-supervised optimization

接下来我们就详细说说这两部分

Question Encoder

实现方法:

Self-supervised optimization.

为了得到两个理想的解耦表示,我们提出了三个具有自监督目标的估计器来指导模型学习。

1.MI Estimator

2.Concept Estimator

3.Disentangling Estimator

MI Estimator

Concept Estimator

Disentangling Estimator

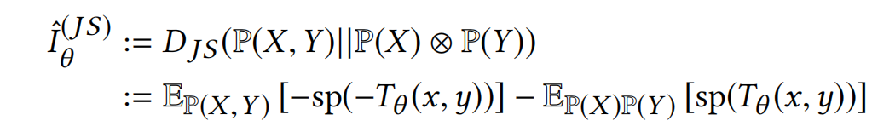

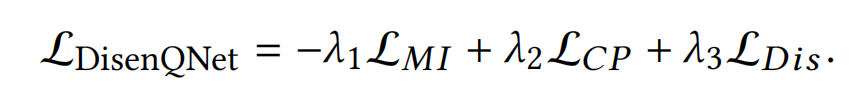

Summary about DisenQNet

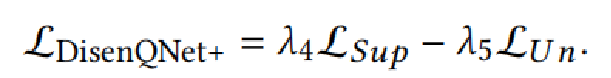

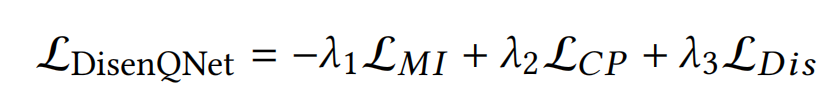

模型DisenQNet的最终目标是用超参数λ1、λ2和λ3来定义的:

DisenQNet的优点:

1.它只学习具有特征本身的问题表示,而不需要额外的标签,其中可以很好地利用大量未标记的问题语料库来提高学习的能力。

2.其次,通过互信息估计将问题分为两个独立的分离问题,从而区分概念意义和个人信息的不同影响。

DisenQNet+

创新点

一个理想的模型应该投入更多的精力来获取一个问题本身的独特信息,而不是相同部分的信息。

受此启发,在DisenQNet+中,本文直接将来自DisenQNet的个性表示(individual representations)

v

I

v_I

vI?,转移到下游任务(难度分析、相似度分析),因为个性解偶表示独立于概念信息,只保留了问题的独有特征。

概览图

第一部分

第二部分

Summary about DisenQNet+

模型DisenQNet+的最终目标是用超参数λ4、λ5来定义的:

评价指标

F1

F1 =2PR/(P+R),适用于二分类问题,在尽可能的提高Precision和Recall的同时,也希望两者之间的差异尽可能小。

F1的大小反应了模型的稳定性。数值越大,说明模型越稳定。

Micro-f1、Macro-f1

对于多分类问题,将二分类的F1推广,有Micro-F1和Macro-F1两种度量:

Micro-f1:统计各个类别的TP、FP、FN、TN,加和构成新的TP、FP、FN、TN,然后计算Micro-Precision和Micro-Recall,得到Micro-F1。

Macro-f1:统计各个类别的TP、FP、FN、TN,分别计算各自的Precision和Recall,得到各自的F1值,然后取平均值得到Macro-F1。

Macro-F1平等地看待各个类别,它的值会受到稀有类别的影响

MAP

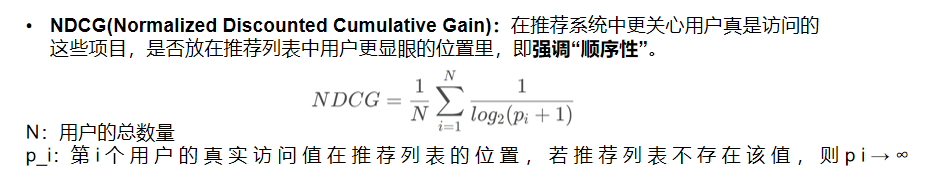

NDCG

DOA

DOA(Degree of Agreement)也叫做满意度标准,是一种衡量用户对于所有项目喜好程度排序正确性的评价指标。

DOA计算方法:将所有的项目分成用户评过分的项目与用户未评过分的项目,统计用户评过分的项目与未评过分的项目在推荐系统中的评分值,两两进行比较,计算在推荐系统中评过分的项目得分值>推荐系统中未评过分的项目得分值的数量与总配对数量的比值。

DOA衡量推荐系统为用户u对项目排序的正确序的对数所占的比例,一个好的推荐系统应该把用户已经评过分的项目相对于那些未评过分的项目排在一个更靠前的位置。

实验评估

Datasets

Baselines

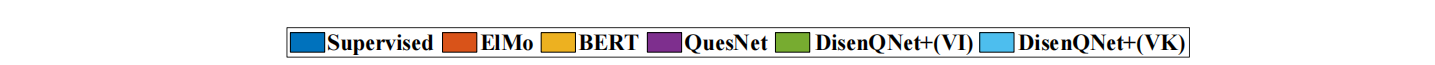

此外,实验中

D

i

s

e

n

Q

N

e

t

?

v

K

DisenQNet-v_K

DisenQNet?vK?表示概念表示(concept representation),

D

i

s

e

n

Q

N

e

t

?

v

I

DisenQNet-v_I

DisenQNet?vI?表示个性表示(individual representation)。

Experiment about DisenQNet

目标:检测我们学习到的两种解耦表示的有效性。

方法:通过分类任务进行概念预测,通过本文的模型表示来预测问题的概念属性(concept)。

1.Concept Prediction Performance

2.Disentanglement Visualization

3.Parameter Sensitivity

4.Case Study

Concept Prediction Performance

概念预测任务 = 多标签分类问题

模型DisenQNet学习的概念表示( D i s e n Q N e t ? v K DisenQNet-v_K DisenQNet?vK?)在所有数据集上都表现最好,到达了预期结果,说明模型准确捕获了概念信息

相比之下,保留个性特征的个性表示( D i s e n Q N e t ? v I DisenQNet-v_I DisenQNet?vI?)在这项任务上失败了

此外,预训练模型(ElMo、BERT、QuesNet)比传统的TextCNN表现更好,这意味着它们可以用更复杂的体系结构提取更多的语义。

总之,DisenQNet模型可以区分问题表示学习的概念效应和个性效应。

Disentanglement Visualization

我们选择数据集SYSTEM 1中前5个常见的概念属性,并在每个概念属性中随机抽取2000个问题。

将这些问题的概念表示v_k 和个性表示v_i 投影到二维空间中进行可视化,并且用不同的颜色来标记不同概念属性下的问题。

一般来说,从概念表示 v k v_k vk?来看(图(a)),具有相同概念的问题很容易聚集,相比之下,问题的个性表示 v I v_I vI?是分散的(图(b)),因为它们独立于概念表示。

Parameter Sensitivity

DisenQNet的目标函数:

λ2规范了概念表示捕获的信息量;λ3控制了问题的个性特征保留的程度。

图(a)显示随着λ2的增加,概念表示表现得越来越好,因为它们尽可能多地捕获问题的概念信息。

图(b)显示随着λ3的增加,个性表现逐渐降低,因为它表示保留个性特征量增多,如果λ3很大,就只留下个性。

因此,目标函数是帮助DisenQNet模型学习良好的解耦表示。

Case Study

从图中可以看出,一个问题中的不同部分在

v

k

v_k

vk?和

v

I

v_I

vI?被赋予了不同的关注度。

概念性意义的词可以解释问题的概念特征,表达式细节可以揭示问题本身的个性特征

Experiment about DisenQNet+

目标:检测我们的问题解耦表示在下游任务中的有效性

方法:通过执行【难度估计任务】对问题的难度进行分类和【相似性分析任务】对特定问题的相似问题进行排序;将二者均视为排名任务。

1.Difficulty estimation task

2.Similarity analysis task

Difficulty estimation task

Metrics:MAP@5、DNCG@5、DOA

Similarity analysis task

实验结果

DisenQNet可以区分教育问题表示学习中独特的概念效应和个性效应

DisenQNet+通过整合个体表示增强了模型在具体应用中难度估计任务和相似度分析任务中的表现