Apollo Perception

感知系统:

传感器: Lidar, Camera, Radar, Ultrasonic, Phone

地图: 高精地图

机器输出:

- 道路信息:不强求在线识别,可以来自高精地图;场景理解,分割;

- 障碍物信息:障碍物检测(位置,类别,形状大小),障碍物跟踪(轨迹,速度),传感器融合(更安全)

- 信号灯信息: camera识别颜色,其他信息来自地图;v2x是终极途径。

Part-1 多个维度看问题

-

感知技术模块:

- 大感知: 标定,定位,障碍物行为预测

- 小感知: 检测,(语义)分割,(属性)识别,跟踪,融合

-

多维度看感知问题:

- Sensor维度(Input): Lidar, Camera, Radar 高精地图等

- Target维度(Output): 障碍物,车道线,道路边界,红绿灯等

- 问题空间维度:2D算法,3D算法,静态帧检测,时序处理

- 机器视觉维度:模型计算,几何计算

- 机器学习维度:深度学习(数据驱动),后处理(启发式)

- 系统维度: 硬件,软件

点云障碍物感知: 障碍物的(位置,大小), 类别,朝向,轨迹,速度

点云检测(分割)技术

Part-3 感知算法

启发式方法:NCut

- 算法思路

- 给予空间平滑性假设,空间上接近的点来自于同一个障碍物

- 基于点云构建Graph, G=(V,E,W),

- 把点云检测问题建模成Graph分割问题,一个Cluster是一个障碍物

- 预处理(ROI过滤,去地面)和后处理(异常过滤)

- 基于Graph的聚类,是一个经典问题,也是经典谱聚类问题;有很多衍生算法

优点: 解释性好

缺点: 鲁棒性差

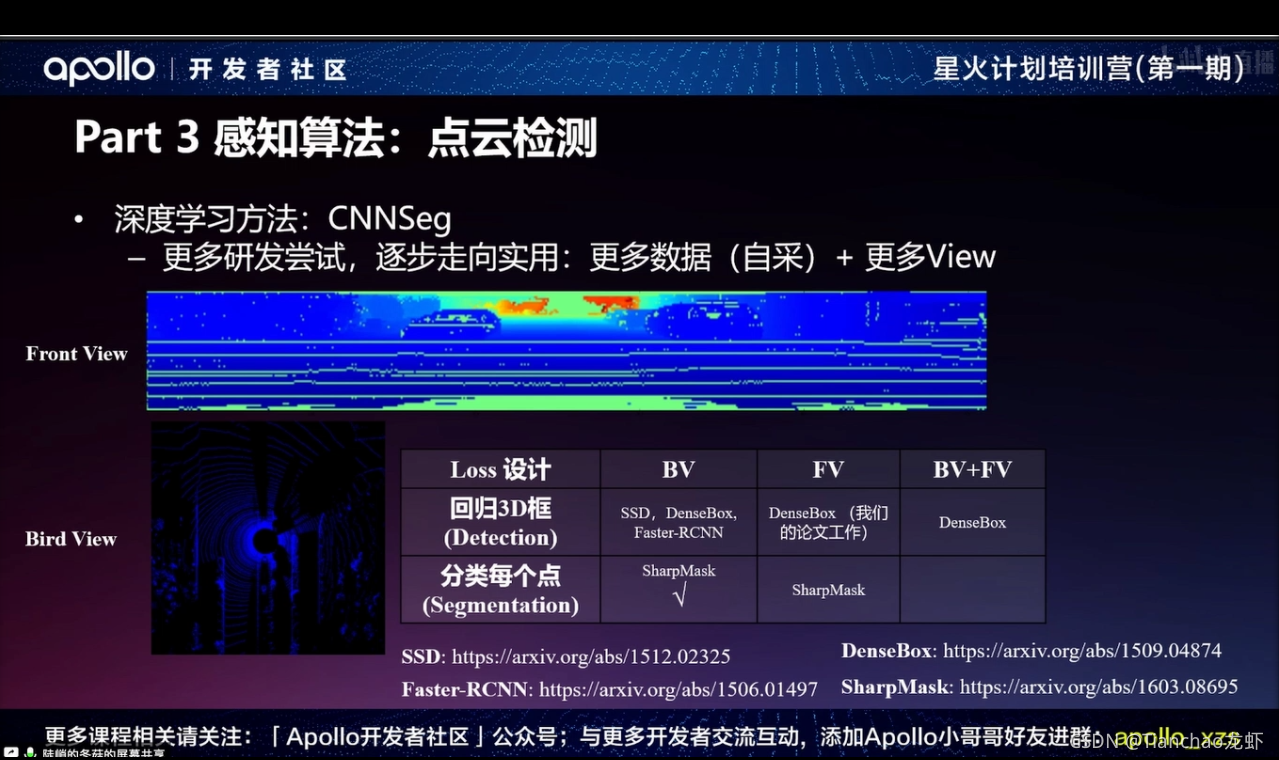

深度学习方法:

CNNSeg

- 把点云投影到Front View(Cylinder View)

- 用全卷积神经网络(FCN)做检测

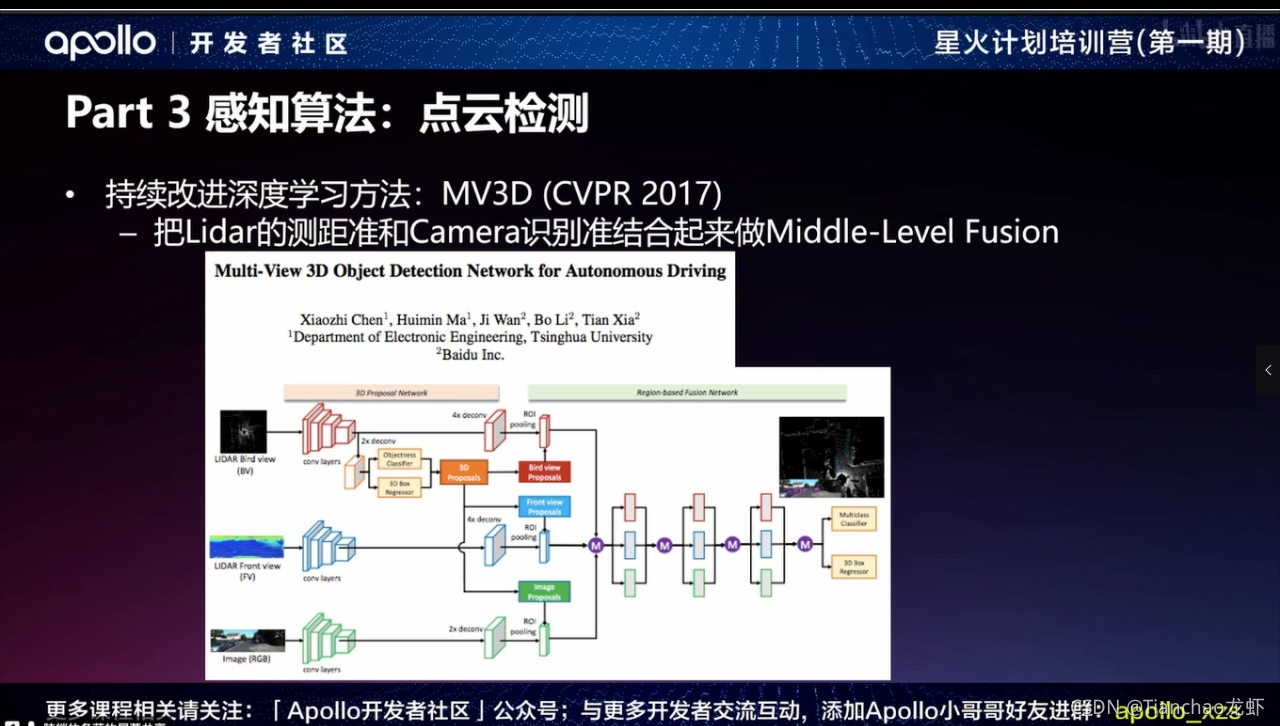

MV3D

- 把雷达的测距准和Camera识别准结合起来做Middle-Level Fusion

后处理计算

- 2D-to-3D的计算

- 相机POSE的影响

- 接地点,2D框,绝对尺寸多条路径回3D

- 稳定性至关重要

- 时序信息计算:跟踪

- 对相机帧率和延时有要求

- 充分利用检测模型的输出信息:特征, 类别

- 可以考虑轻量级Metric Learning

- 多相机环视融合

- 相机布局决定融合策略

- 几何计算+时序计算+环视融合,密不可分

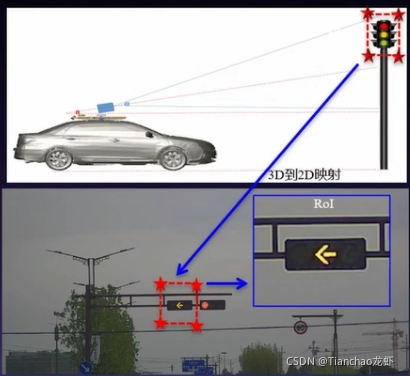

红绿灯检测

难点:

- 绿灯准确度搞(3个9)否则闯灯,召回影响通过率和体验

- 各种环境都work(光照和天气)

- 各种制式红绿灯都可识别(距离,高度,纵横,信号形状,频闪)

技术途径:

- Sensor选项和setup,获取最大可视范围

- High-Dynamic Range(HDR)大于100dB,1080P

- 双camera, 长短焦切换, 6mm+12mm

- 高精地图交互,增加在线识别鲁棒性

- 地图提供灯组3D坐标和交通含义

- 只看RoI区域,避免形状识别

- 深度学习,应对appearance变化

- 检测:灯组/灯头在哪

- 分类:什么颜色?

Part-4 感知中的机器学习

不同一般的机器学习应用,对准、召、延时要求极其严格

- 如何应对corner case?

- 训练和测试的独立同分布

- 训练时封闭的,测试是开放集

- 可解释性是否需要?

- 如何评估模型?如何回归测试?如何得到使用边界?

- 不仅仅是深度学习

- 还需要其他非机器学习方法,如何融合两种方法?

- 也需要其他机器学习方法

- 有监督学习可以走多远?

Part-5 感知的未来

- Sensor迭代非常快

- 深度学习+仿真数据+车载AI芯片

- 智能交通设施,V2X普及

- 人工智能技术进一步提升

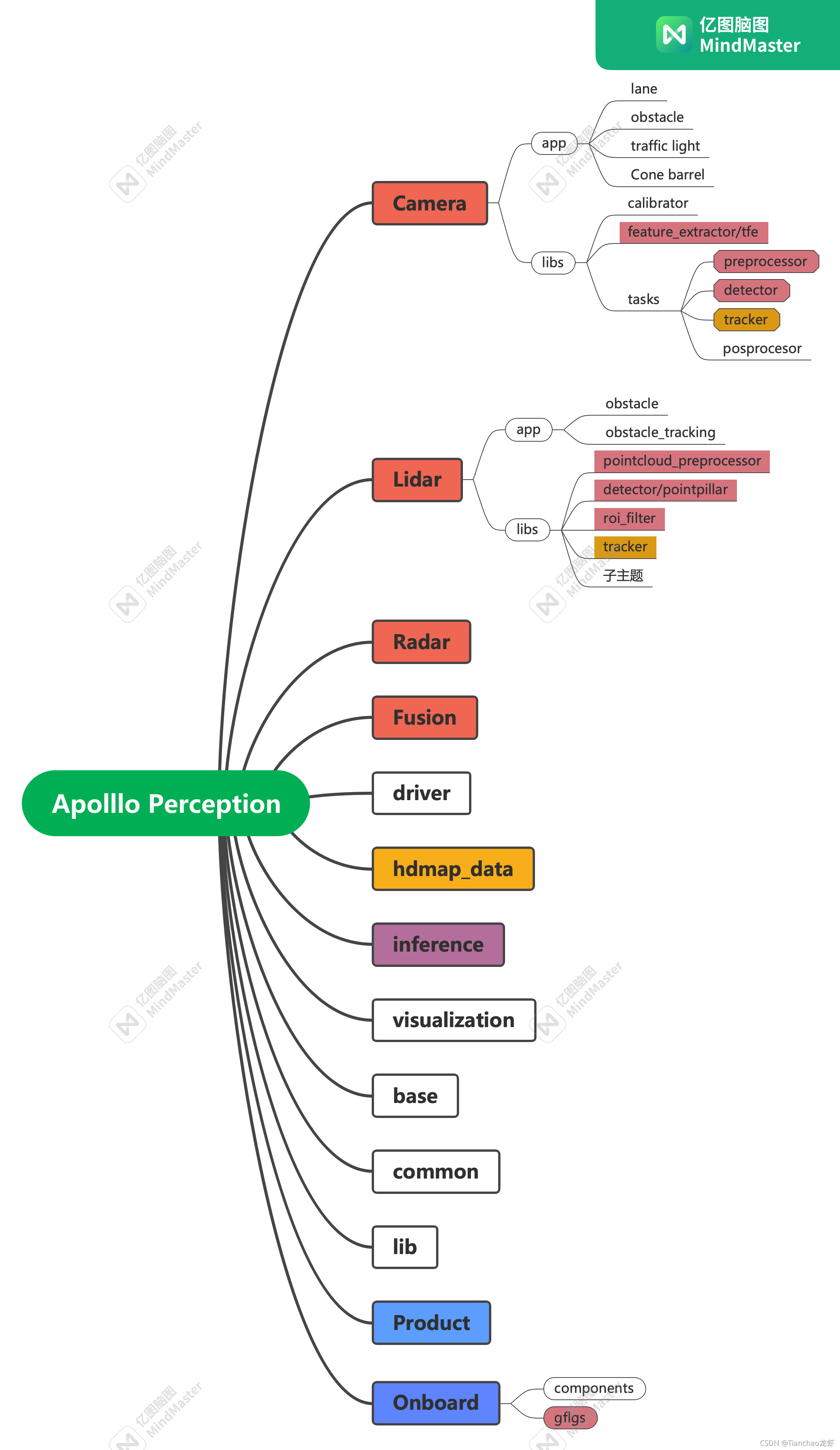

目录

- 感知技术综述

- 感知业务线划分和Apollo感知模块基础设施

- 未来

1. 感知技术综述

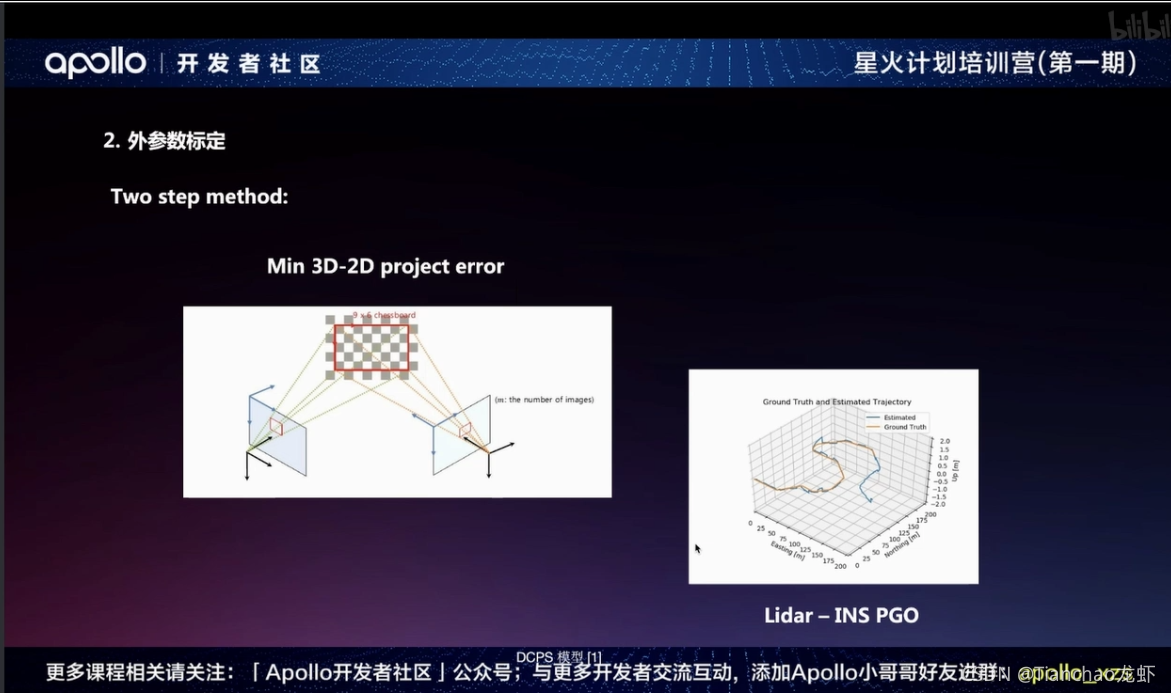

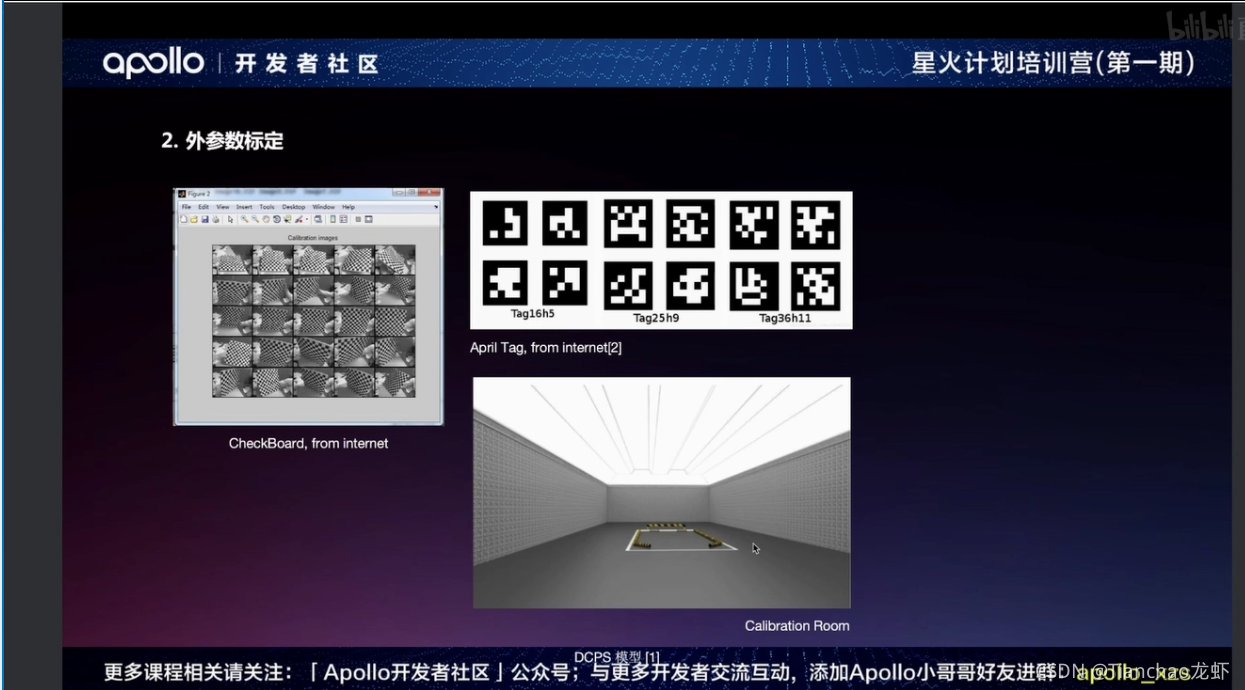

外参数标定

传感器不同位置,有相对位置的,就是计算两两设备的位姿态变换矩阵

离线标定基本策略:

LIDAR-IMU-Camera策略

- Lidar–>IMU, 两条位姿曲线的优化

Camera-Camera

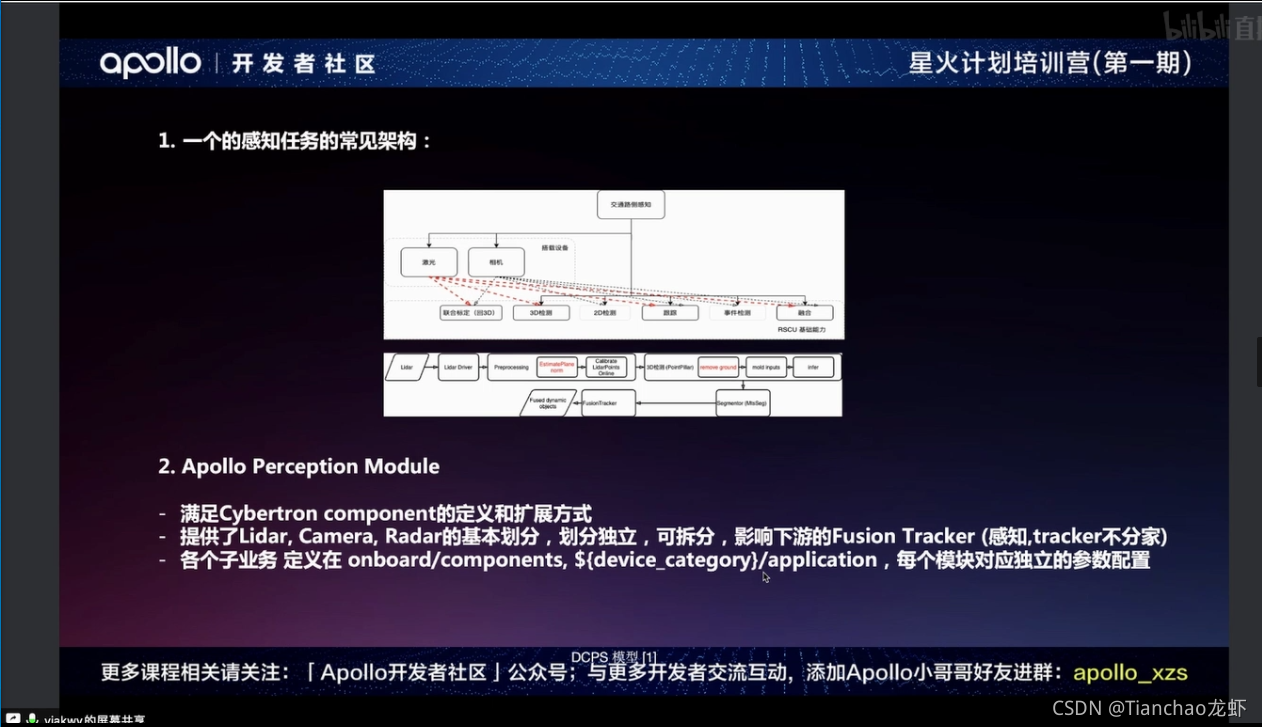

2. 感知业务线划分和Apollo感知模块基础设施

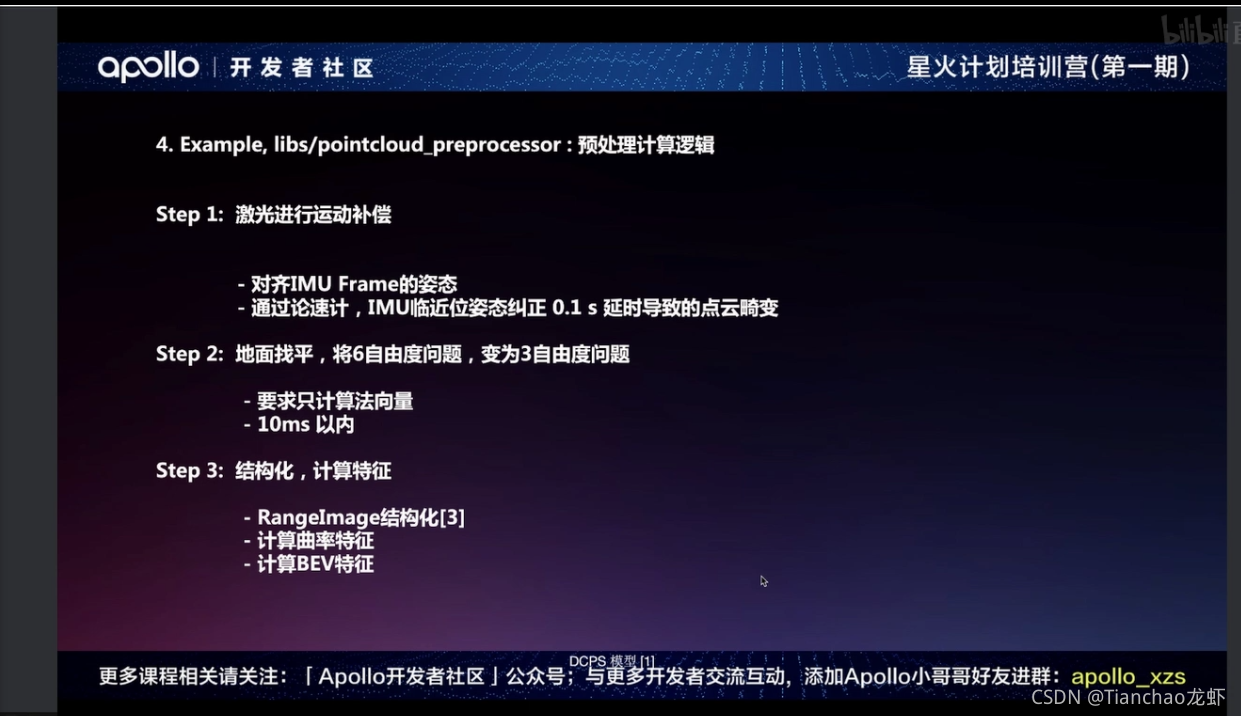

通过Driver,获取数据。进行预处理,主要做一些数据补偿。然后优化和编码。紧接着就是Inference,最后发结果给tracker。

第一个例子:

第二个例子:

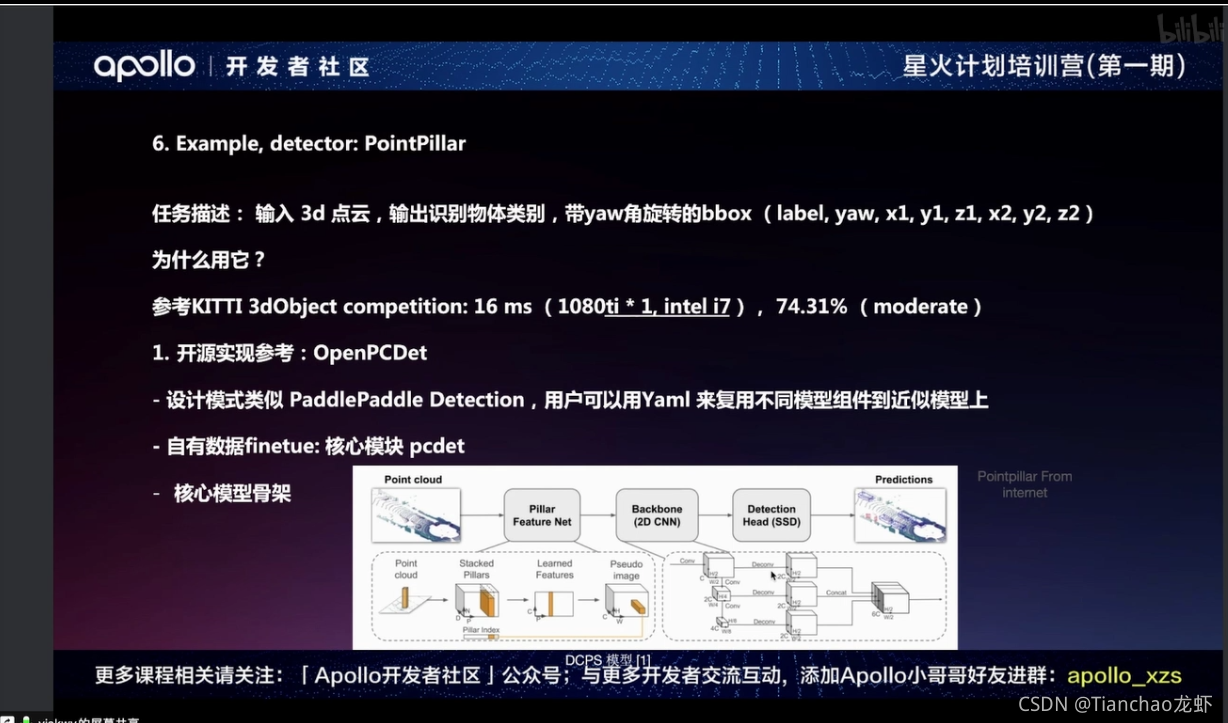

第三个例子:

3. 未来

- 自监督技术数据扩展数据集

- Attention(ViT)