RoadMap: A Light-Weight Semantic Map for Visual Localization towards Autonomous Driving*

摘要

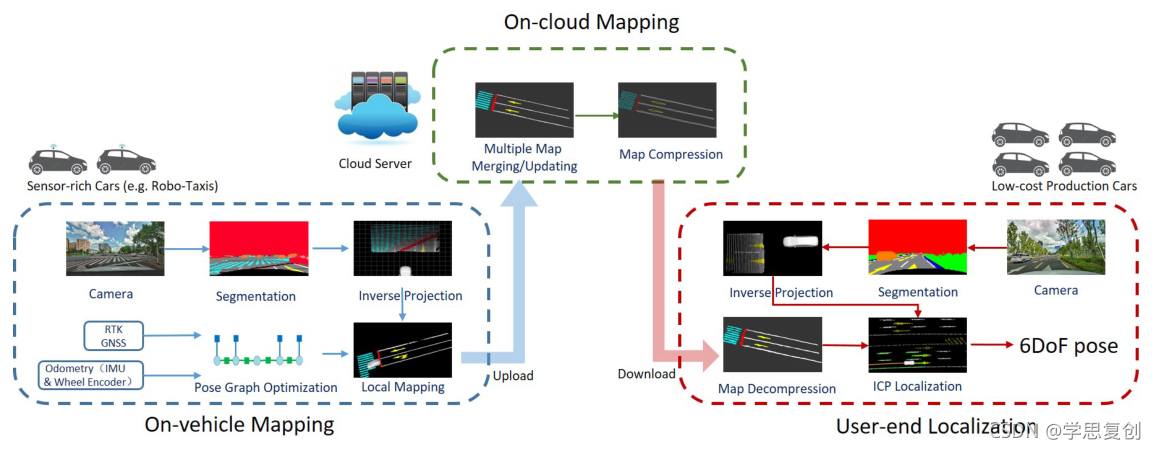

精确的定位是自动驾驶任务的关键。如今,我们已经看到许多传感器丰富的车辆(如机器人出租车)在街上自动驾驶,这些车辆依靠高精度传感器(如激光雷达和RTK GPS)和高精度地图。但是,低成本的汽车无法负担传感器和地图的高昂费用。如何降低成本?**传感器丰富的车辆如何使低成本汽车受益?在本文中,我们提出了一种轻量级的定位解决方案,它依赖于低成本的摄像机和紧凑的视觉语义地图。**地图很容易由传感器丰富的车辆以一种众包的方式制作和更新。具体来说,该地图由几个语义元素组成,如车道线、人行横道、地面标志和路面上的停车线。我们介绍了车载地图、云维护和用户端定位的整体框架。地图数据在车辆上收集和预处理。然后,将众包数据上传到云服务器。将多辆车的海量数据融合到云上,及时更新语义地图。最后,语义地图被压缩并分发到生产车辆,后者使用该地图进行定位。我们在实际实验中验证了该算法的性能,并与其他算法进行了比较。语义地图的平均大小为36kb/km。我们强调,这个框架是一个可靠和实用的自动驾驶定位解决方案。

现有技术存在的问题:

- 量产车承担不起激光雷达和高精地图的高成本

- 点云地图消耗大量内存,无法大规模生产

- 制作高精地图需要大量人力,难保证高精地图的更新

解决方法:

由高成本传感器丰富的车辆通过众包的方式制作一个紧凑的视觉语义地图。低成本的车辆通过配备的摄像头与视觉语义地图进行定位。

系统综述

系统由三部分组成:

1.高成本车辆建图:车辆配备了前置摄像头、RTK-GPS和基本导航传感器(IMU和车轮编码器)。这些车辆每天收集大量的实时数据。通过语义分割网络从前视图像中提取语义特征。然后根据优化后的车辆姿态,将语义特征投影到世界坐标系中。车辆建立一个局部语义地图,并将该地图上传到云地图服务器。

2.云端建图:云服务器从多个车辆收集局部地图。局部地图合并为全局地图。然后通过轮廓提取对全局地图进行压缩。最后,将压缩的语义地图发布给最终用户。

3.低成本车辆定位:车辆配备低成本传感器,如摄像机、低精度GPS、IMU和车轮编码器。用户从云服务器下载语义地图后解码。与高成本车辆建图部分一样,通过语义分割从前视图像中提取语义特征。通过语义特征匹配对地图进行定位。

算法细述:

高成本车辆建图

-

图像分割

使用基于CNN的语义分割算法进行场景分割。提取地面、车道线、停车线和道路标记类别。

-

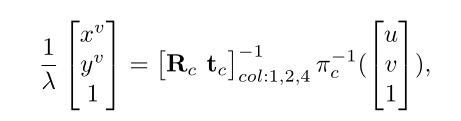

逆透视变换

将分割后的语义像素在车辆坐标系下从图像平面反投影到地平面。由于透视噪声的存在(越远的场景有着越大的误差),只选择靠近相机的区域(靠近相机的 12 m × 8 m 12m×8m 12m×8m的矩形区域)进行变换。变换方式:

像素坐标->相机坐标系下的坐标->车辆坐标系下的坐标

λ

\lambda

λ:齐次变换时的所需乘的常数

-

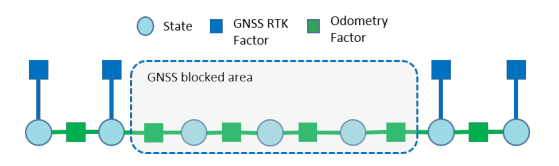

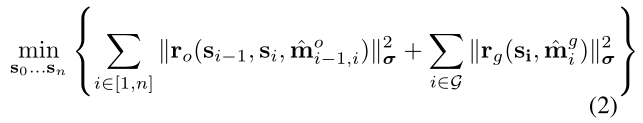

位姿图优化

为消除在GNSS-RTK信号遮挡区域中里程计累计误差产生的漂移进行位姿图优化:

蓝色节点:车辆的状态 s s s(平移 p p p,旋转 q q q)

蓝色边:GNSS约束

绿色边:里程计约束

-

局部建图

基于优化的位姿将语义像素从车俩坐标系转换到全局坐标系

当车辆行驶时,一个区域可以被观察多次。但是由于分割噪声的存在,这个区域可能会被划分成不同的类别。为了克服这个问题,我们使用统计学来过滤噪声。地图被划分成小栅格,分辨率为 0.1 × 0.1 × 0.1 0.1×0.1×0.1 0.1×0.1×0.1m。每个栅格信息包含位置、语义标签和每个语义标签的计数。语义标签包括地面、车道线、停车线、地面标志和人行横道。开始时,每个语义标签的计数为零。当语义点插入到栅格中时,对应标签的计数加1。因此,得分最高的语义标签表示网格的类。该方法提高了语义图的准确性和对分割噪声的鲁棒性。

云端建图

-

地图合并以及更新

云端建图服务器用于合并由多个车辆捕获的海量数据。它及时合并/更新局部地图,从而使全局语义地图是最新的。**为了节省带宽,只上传本地地图中被占用的栅格到云端。**与高成本车车辆建图过程相同,云服务器上的语义地图也被划分为栅格,分辨率为 0.1 × 0.1 × 0.1 m 0.1×0.1×0.1m 0.1×0.1×0.1m。局部地图的栅格将根据其位置添加到全局地图中。具体来说,局部地图栅格中的分数将被添加到全局地图的相应栅格中。这个过程是并行进行的。最后,得分最高的标签是栅格的标签。 -

地图压缩

采用轮廓提取方法对地图进行压缩。首先,生成语义地图的俯视图图像。每个像素代表一个网格。其次,提取每个语义组的轮廓。最后,将轮廓点保存并分布到低成本车辆中。

低成本车定位 -

地图解压缩

首先在压缩后的语义地图的俯视图图像平面中,用相同的语义标签填充轮廓内的点。然后将每个标记的像素从图像平坐标系面恢复到世界坐标中。

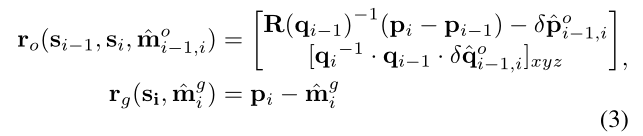

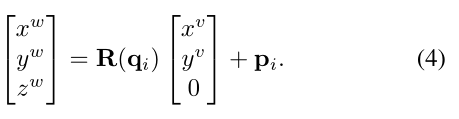

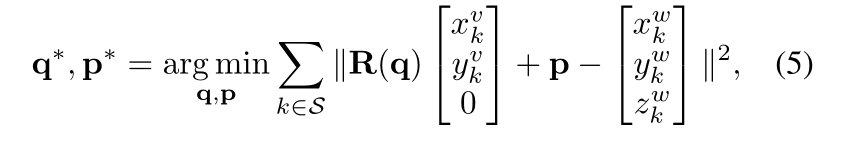

ICP定位

1.对前视图进行语义分割提取语义点,投影到车辆坐标系中

2.通过匹配当前特征点和地图点进行车辆位姿估计

3.最后采用EKF框架,将里程测量与视觉定位结果融合在一起。

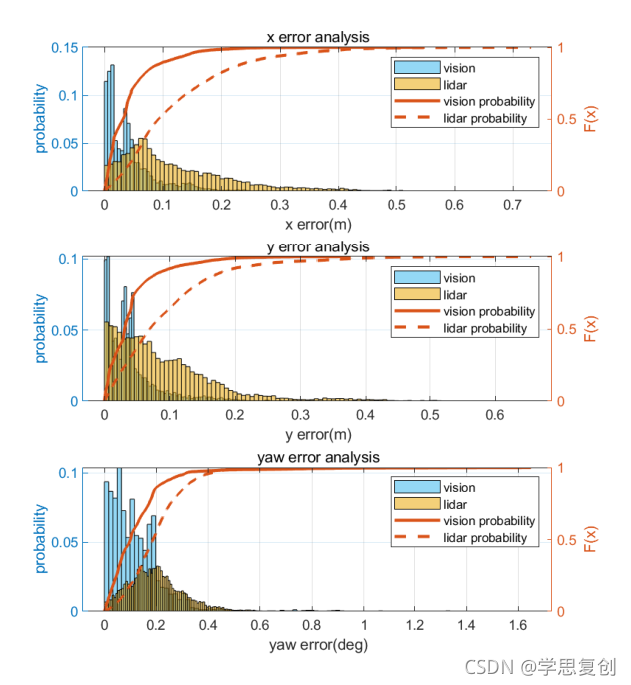

实验

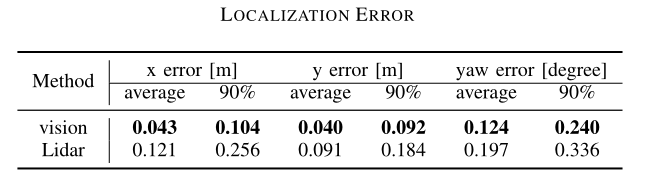

使用GNSS-RTK作为真值,对比了该系统与基于激光雷达定位方法的定位精度。关注于X,Y,Yaw的误差。

可改进的地方

- 将语义信息扩展到3D语义

- 语义地图压缩的方式