基于区间的视觉激光雷达传感器融合

摘要

由于摄像机和光探测与测距(LiDAR)传感器提供了有关环境的补充信息,因此,通过将LiDAR测量的距离指定给图像中检测到的视觉特征,将其信息融合到移动机器人定位中是有益的。

然而,现有的方法忽略了融合信息的不确定性,或者以乐观的方式对其进行建模(例如,不考虑外部校准误差)。由于传感器融合过程中误差的实际分布通常是未知的,因此我们假设只知道包含误差的边界(或间隔)。因此,我们建议使用区间分析将误差从输入源直接传播到融合信息。为了证明我们方法的适用性,我们使用融合信息进行航位推算。由于使用了间隔分析,我们的方法的结果是保证包含机器人真实姿势的间隔。使用真实数据进行的评估表明,我们确实能够以有保证的方式定位机器人。这使我们能够在十分之三的情况下检测到既定方法的故障,该方法忽略了融合信息的不确定性。

introduction

- 在缺少全球导航卫星系统信息的情况下,移动机器人必须使用不同的传感器(如照相机或激光雷达)进行定位。虽然相机提供了丰富的可重新识别的特征,但特征的深度(或距离)很难确定,并且“容易随时间漂移”。相比之下,激光雷达能够精确测量距离,但不能提供易于重新识别的特征。为了融合来自两个传感器的信息,现有的方法将激光雷达测量的距离分配给各个图像特征。这将产生可在连续图像中重新识别的三维特征。然而,在传感器融合过程中,大多数方法并不一致地传播传感器和传感器间(例如,传感器坐标系之间的转换)错误。

- 这导致了两个问题。首先,无法评估融合的3D特征的准确性,因此无法根据其可靠性对这些特征进行加权,以用于机器人定位。此外,基于这些特征的进一步结果的准确性也无法确定。其次,融合信息所需的传感器坐标系之间的转换假定是无误差的。然而,由于在使用传感器数据进行外部校准期间,需要事先确定这种转换,因此这种转换通常仅在一定精度范围内已知。根据估计变换的误差,可能会融合对应于不同对象的扫描点和图像特征,从而创建错误融合的三维特征。

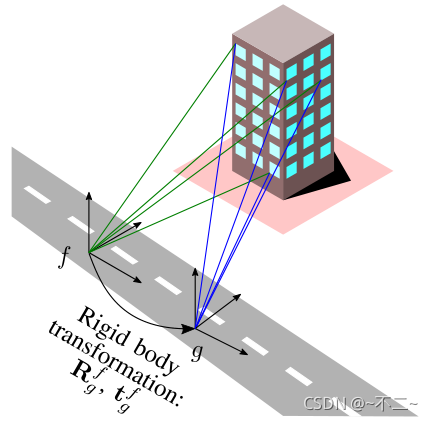

- 本文提出将所有传感器和传感器间的信息融合应用到相机和激光雷达的传感器融合中。使用区间分析对所有误差进行建模,并为相机和激光雷达引入有界误差模型。假设每个输入源都有一个未知但有界的误差,这意味着我们假设不知道精确的测量值,但只知道一个保证包含真实值的区间。因此,如图1所示,图像特征和激光扫描数据不再是点而是框。

- 利用融合的3D特征,基于摄像机和激光雷达数据(也称为视觉激光雷达里程计)执行航位推算,从移动机器人的任意位置开始进行增量定位。惯性测量单元(IMU)用于初始约束旋转。

related work

- 有两种不同的方法来融合来自相机和激光雷达的信息。更简单的方法是,在将激光雷达和图像数据中的特征组合到通用扩展卡尔曼滤波器(EKF)中之前,独立提取和跟踪特征。然而,这种方法仍然存在单个传感器的缺点,因为相机功能仍然无法获得准确的距离信息,并且激光扫描点无法随时间轻松关联。

- 第二种更复杂的方法是通过为图像特征指定距离来直接融合传感器信息,这些特征可以在连续图像中重新识别,这允许使用两种传感器模式的优点。

区间分析

区间分析可以理解为经典实数算术算子对集合论的扩展。然而,不是使用任意集合,而是在区间上执行计算,区间由下限和上限定义。因此,区间[x]=[xmin,xmax]被定义为这些边界之间的所有实数的集合。隐含的意思是我们只知道真正的值x?保证在区间[x]内,但我们无法访问真实值,因此不知道区间中最有可能出现的值。

For our work

- 不需要实际的误差分布,这对于现成的传感器通常是未知的。

- 未知的系统误差(例如,传感器之间的外部校准)可以方便地建模。

- 在不违反错误界限的假设下,结果是有保证的。

- 不存在局部极小值,可能的高度非线性函数不需要线性化。

传感器误差模型

相机模型

首先,我们必须决定要用深度信息增强哪些图像点。在这里,我们使用“Good features to track”,这是一种最先进的方法来检测图像中的特征。随后,我们使用Lucas Kanade特征跟踪器在连续图像中重新识别这些特征。通过这种方式,我们能够建立所谓的图像特征匹配,即连续图像的匹配图像特征对应于同一对象。因此,我们用于传感器融合的原始测量值是图像中的像素点。随后,我们应用针孔相机模型找到这些特征的归一化坐标。

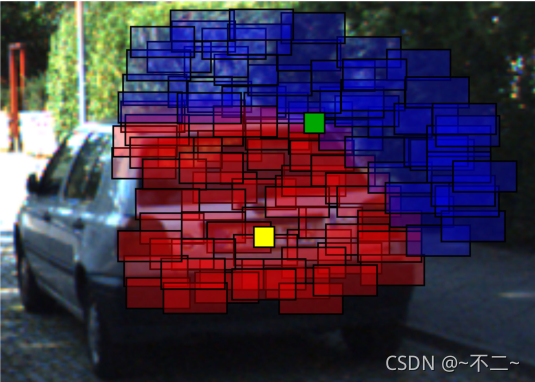

然而,由于不同的原因,图像特征无法被完全检测和匹配。首先,相机将实际场景离散为像素。由于这种离散化会导致自然区间界限(即[?0.5:0.5][px]),基于区间的误差模型更可取。其次,不同的因素(例如,图像模糊、噪声或不精确的内在参数)扭曲了特征匹配过程和/或归一化坐标的计算,但无法量化(即,真实误差分布未知),因为它们取决于各种情况(例如,环境)。假设知道误差界比假设知道全部误差分布更弱,因此基于区间的模型更可取。对于这项工作,我们根据经验确定了一个限制所有误差影响的框[Δpx](见图2)。

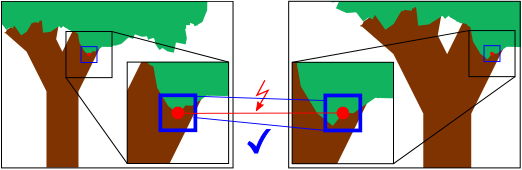

红点是传统图像特征匹配的预期结果,由于上述误差源,红点并不完全位于同一对象上。因此,我们使用区间框(用蓝色表示)对不确定性进行建模。可以看出,对于同一对象的部分,两个间隔框重叠,因此建立了正确的特征匹配。

激光雷达模型

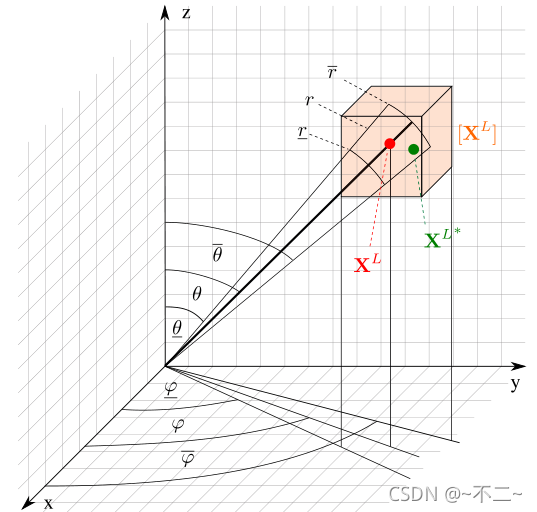

从概念上讲,3D激光雷达仅测量径向距离,并允许通过提供发射光束的极(垂直)角θ和方位(水平)角φ来计算3D笛卡尔点。然而,该光束不是完美的光束,而是发散的,因此,实际测量点可能位于产生的光束足迹内的任何位置。如果不知道光束内的功率分布,则无法推断测量点的误差分布。相比之下,光束发散度(即边界)通常由制造商指定,因此基于区间的误差模型很方便。此外,激光束的入射角和环境条件(如湿度)会影响距离测量,并可能导致系统误差(偏差)。

视觉-激光雷达传感器融合

激光扫描投影

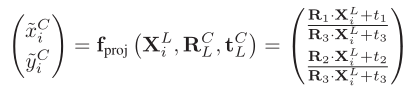

首先,必须将相机和激光雷达信息纳入一个共同的参考坐标系C,随后,将三维激光扫描点从激光雷达坐标系L转换为相机坐标系,并将其投影到图像平面上。

激光扫描点和非本征变换无法准确确定,但只能在一定程度上知道。因此定义了[f]proj自然包含函数计算包围扫描点的标准化坐标的框。

数据融合

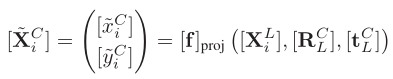

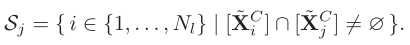

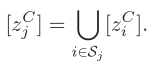

将来自两个传感器的数据引入一个共同的参考系统后,用深度信息来增强视觉特征,这些特征可以被检测和跟踪。图1显示了我们的传感器融合方法的总体思路。由于图像特征和扫描点不再是点而是框,我们可以找到每个图像特征框的所有重叠扫描框。因此,我们将图像特征的深度计算为所有相交扫描框深度的并集。这就产生了一个深度间隔,使我们能够立即评估其精度。

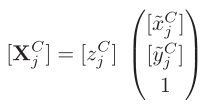

在图像平面上设置一个图像特征并且[XCj] =([XCj][yCj])其归一化坐标。我们确定所有先前投影的扫描框的集合sj,其归一化坐标与特征j的归一化坐标具有非空交点:

随后,我们可以通过计算所有重叠扫描框深度上的并集来确定图像特征的z坐标。

接下来,我们使用这个间隔来确定3D坐标

保证VISUAL-LIDAR测程法

接下来的目标是利用之前融合的来自相机和激光雷达的信息逐步定位机器人。在这里,没有全局信息(例如,已知的地图或已知的姿态在全局坐标系统)可用。因此,我们只能计算机器人在获取图像和激光扫描数据之间的相对运动。使用3D特征来计算机器人的相对运动。