前言

好吧我又来更新sota 论文了 这个是多模态情感分析的sota 而且和第二名相差很大。

摘要

多模态语言分析是NLP的一个新兴领域,旨在同时建模说话人的单词语义、语音和面部表情。在这方面,语义通常优于其他模态,因为它们是通过基于Transformer的模型在大型语料库上预先训练的。

尽管他们的表现很好,但由于数据不足,在任何模型上训练一个新的自监督学习(SSL)Transformer通常是不可能实现的,这在多模态语言学习中就是如此。

这项工作提出了一个基于Transformer的语音前缀语言模型,称为TRASTEL,以在不训练完整Transformer的情况下接近上述约束。

与传统的语言模型相比,TEASEL模型除了文本模态之外,还包括作为动态前缀的语音模态。

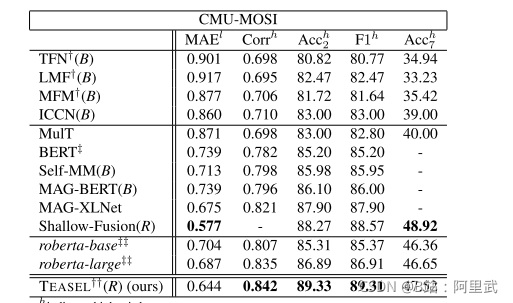

该方法利用传统的预训练语言模型作为跨模态Transformer模型。我们评估了由CMU-MOSI数据集定义的多模态情绪分析任务的TRANSEL。大量的实验表明,我们的模型在F1分数上优于单模态基线语言模型4%,优于当前的多模态最新(SoTA)模型1%。此外,我们提出的方法比SoTA模型小72%。

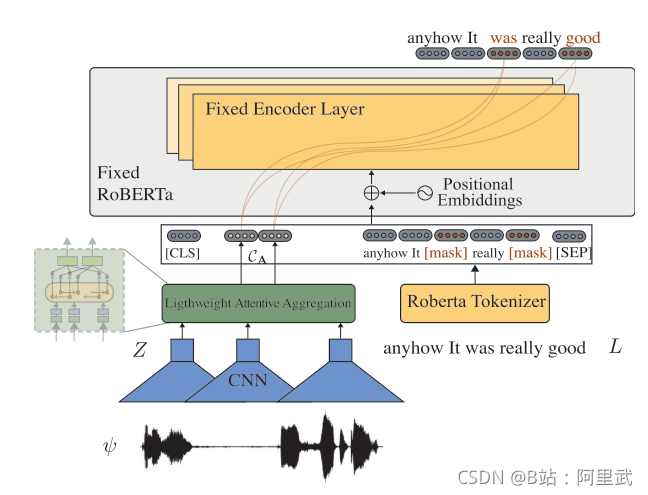

模型结构

文本模态

-

使用RoBERTa 作为文本特征提取器

语音模态

- 使用 wav2vec 2.0 来提取声音特征

- 使用Lightweight Attentive Aggregation 增强上下文表示

因为wav2vec 是预训练的模型, 对于特征提取可能还是提取一个偏通用的特征, 所以 在上层再加入一个 轻量级的特征提取器进行更狭义的提取。

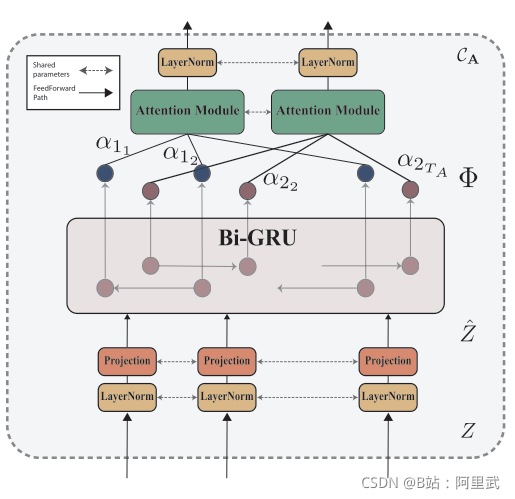

Lightweight Attentive Aggregation

主要包括以下几步

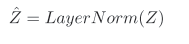

- 进行layer norm

- 通过双向GRU 获取特征双向表示

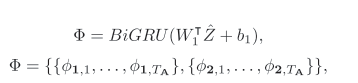

- 对双向语义进行Attention 合并

- 对双向语义进行Attention 合并

Ca 表示 前向特征的加权特征 和 后向特征的加权特征

训练过程

阶段1: 预训练

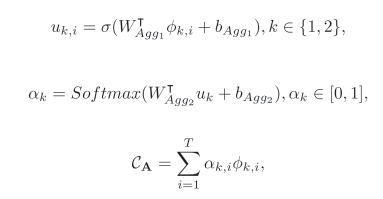

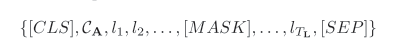

模型的输入是

声音作为前缀输入, 然后直接放到Roberta 的 encoder中 进行预训练

其中Ca 表示的 是 两个输入 一个前向输入, 一个后向输入

阶段2: 下游finetune

在预训练完之后,固定权重, 用 CLS的结果用于上游finetune

效果

效果有点过于好了

预训练细节

- 100 hours of LIBRISPEECH in 8,000 cumulative steps (9 epochs)

- fine-tuned TEASEL on CMU-MOSI with 3 epochs.

超参选择

learning rates in range of {1e- 0.10, 0.2, 0.3, 0.4, 0.5}

batch sizes in the range of {8, 16,32}

warm-up steps using {0%, 10%, 20%, 30%, 40%}

总结

- 大道至简, 没有繁琐的预训练输入, 非常的朴素的输入

- 有点像prompt里面的一种 , 前缀prompt

- 看起来单用robert 的情感分析效果已经很不错了