说明:这是一个机器学习实战项目(附带数据+代码+文档+代码讲解),如需数据+代码+文档+代码讲解可以直接到文章最后获取。

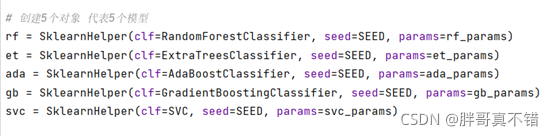

包含算法:RandomForestClassifier、ExtraTreesClassifier、AdaBoostClassifier、GradientBoostingClassifier、SVC。

?

1.项目背景

? ? ? 在大数据时代,我们终于拥有了算法所需要的海量数据。如果把机器学习比作工业革命时的蒸汽机,那么数据就是燃料。有了燃料,机器才能够运转。其次,在硬件方面,随着存储能力、计算能力的增强,以及云服务、GPU(专为执行复杂的数学和几何计算而设计的处理器)等的出现,我们几乎能够随意构建任何深度模型(model)。Stacking集成学习方法可以将多种单一模型以一定的方式组合起来,它可以结合各个单项预测模型的优点,更好地进行预测。

? ? ? ?Stacking集成学习方法最初由Wolpert于1992年提出。作为一种新兴的算法,它在不同领域均有应用,并且取得了较为不错的结果。Stacking的特别之处在于,它可以融合不同种类的模型。在解决分类问题时,以一个层数为2的Stacking集成框架为例,一般地,框架的第一层由多个基分类器组成,各基分类器的输入均为训练数据,框架的第二层是元分类器,元分类器的训练数据由第一层基分类器的输出和原始训练数据的标签组成,元分类器经过训练后,就可以得到完整的Stacking集成模型。

2.数据获取

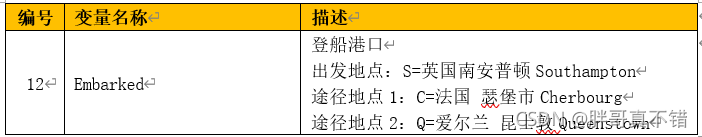

本次建模数据来源于网络(本项目撰写人整理而成),数据项统计如下:

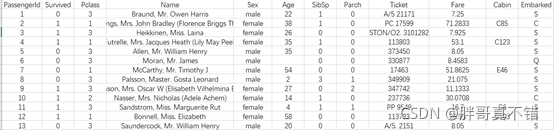

?数据详情如下(部分展示):

3.数据预处理

? ? ? 真实数据中可能包含了大量的缺失值和噪音数据或人工录入错误导致有异常点存在,非常不利于算法模型的训练。数据清洗的结果是对各种脏数据进行对应方式的处理,得到标准的、干净的、连续的数据,提供给数据统计、数据挖掘等使用。数据预处理通常包含数据清洗、归约、聚合、转换、抽样等方式,数据预处理质量决定了后续数据分析挖掘及建模工作的精度和泛化价值。以下简要介绍数据预处理工作中主要的预处理方法:

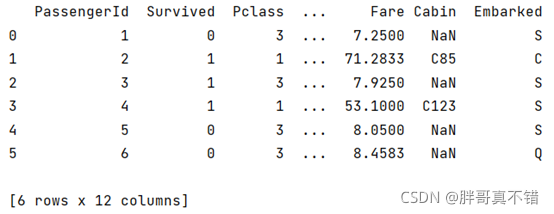

3.1 用Pandas工具查看数据

使用Pandas工具的head()方法查看前6行数据:

关键代码:

?

3.2对特征Cabin进行处理

?使用Pandas工具的type()方法来查类型是否为float类型,来判断乘客是否有客舱号,关键代码:

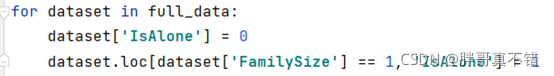

3.3构建IsAlone特征

通过SibSp 和 Parch 特征的结合,来构建新的特征FamilySize;通过FamilySize特征来构建IsAlone特征;关键代码如下:

?

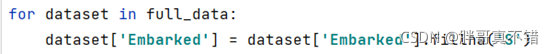

3.4特征Embarked和Fare缺失数据处理

Embarked特征用’S’来填充空值, Fare特征用中位数来填充空值,关键代码如下:

?

?

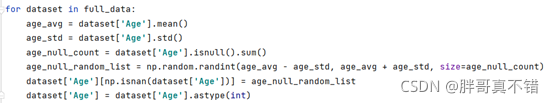

3.5构建CategoricalAge特征

通过年龄的平均值、标准差来构建年龄分段特征,关键代码如下:

?

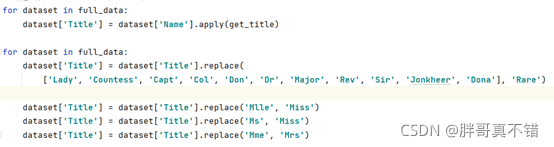

3.6构建Title特征

对乘客名字进行规范化处理,关键代码如下:

?

最后针对处理后的特征进行查看,结果如下:

?

4.探索性数据分析

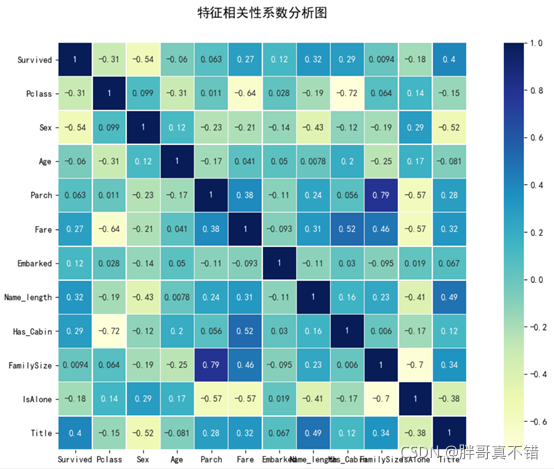

4.1 相关性分析

用Pandas工具的corr()方法 matplotlib seaborn进行相关性分析,结果如下:

?

通过上图可以看到,数据项之间正值是正相关/负值是负相关,数值越大 相关性越强。

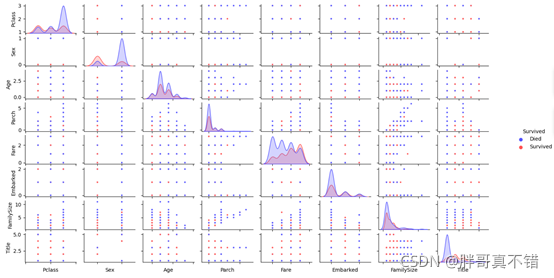

4.2 每个特征生成配对图

这种配对图,可以看到每两个特征之间 针对乘客是否生存形成对比,方便观察特征。例如:乘客在2等舱且年龄越小 越容易生存。

5.特征工程

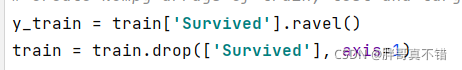

5.1 建立特征数据和标签数据

Survived为标签数据,除 Survived之外的为特征数据。关键代码如下:

?

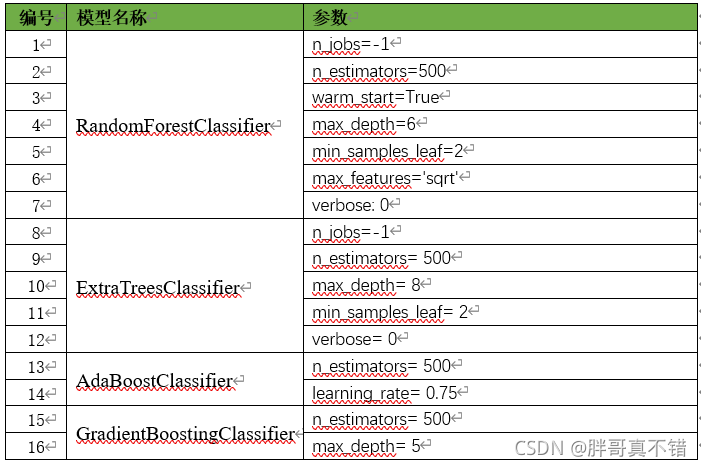

6.构建Stacking分类模型

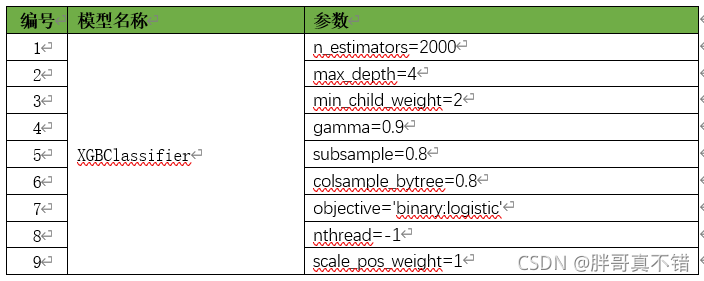

主要使用RandomForestClassifier、ExtraTreesClassifier、AdaBoostClassifier、GradientBoostingClassifier、SVC算法,用于目标分类。第一层模型:使用上面5种算法进行建模、拟合、预测;第二层模型:本次分类模型是使用前5个模型的预测结果作为特征,测试集的标签作为标签,以XGBClassifier算法作为基分类器,进行建模、拟合、预测。

6.1第一层模型参数

?关键代码如下:

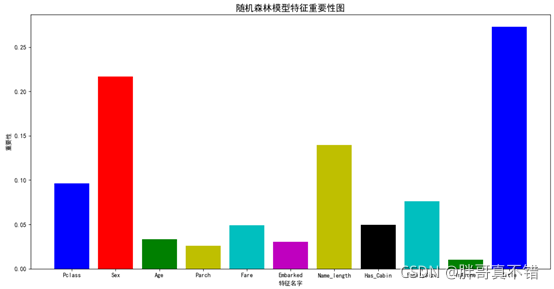

6.2第一层模型特征重要性

?

通过上图可以看出,随机森林模型特征重要性排名为Title、Sex等。

?

通过上图可以看出,极端随机树模型特征重要性排名为Sex、Title等。

?

通过上图可以看出,AdaBoost模型特征重要性排名为Name_length、Title等。

?

通过上图可以看出,Gradient Boost模型特征重要性排名为Title、Name_length等。

?

通过上图可以看出,所有模型特征重要性排名为Name_length、Title、Sex等。

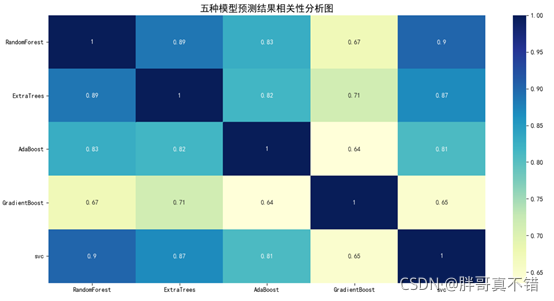

6.3 五种模型相关性分析

?

针对五种模型的预测结果进行相关性分析,通过上图可以看出大于0的为正相关 数值越大相关性越强;小于0的为负相关。

6.4第二层模型参数

关键代码如下:

?

7.模型评估

7.1评估指标及结果

评估指标主要包括准确率、查准率、查全率、F1分值等等。

?从上表可以看出,准确率为87% ?F1分值为82%,Stacking分类模型也相当不错。

关键代码如下:

7.2 分类报告

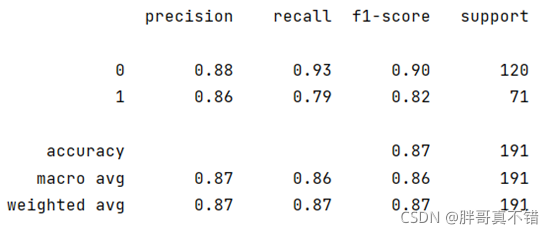

Stacking分类模型分类报告:

从上图可以看到,分类类型为0的F1分值为0.90;分类类型为1的F1分值为0.82;整个模型的准确率为0.87.

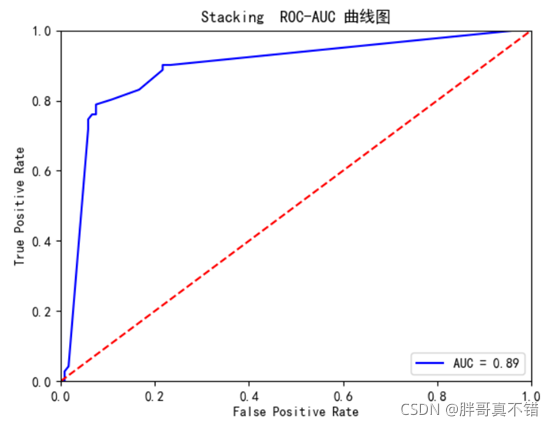

7.3 ROC曲线

从上图可以看出AUC值为0.89,模型也相当不错。

8.结论与展望

综上所述,本文采用了Stacking分类模型,最终证明了我们提出的模型效果良好。准确率达到了93%,可用于日常生活中进行建模预测,以提高价值。

本次机器学习项目实战所需的资料,项目资源如下:

项目说明:

链接:https://pan.baidu.com/s/13r3-mTcCRBfwWRtbpnFUpw?

提取码:s2wn网盘如果失效,可以添加博主微信:zy10178083