一、实验内容

将重庆交通大学新闻网站中近几年所有的信息通知http://news.cqjtu.edu.cn/xxtz.htm的发布日期和标题全部爬取下来,并写到CSV电子表格中。

二、爬虫定义与分类

网络爬虫,通过一定的规则策略,自动抓取、下载互联网上网页,在按照某些规则算法对这些网页进行数据抽取,形成所需要的数据集。

按照抓取网站对象来分类,可以分为2类爬虫。

通用爬虫:类似百度、谷歌这样的爬虫,抓取对象是整个互联网,对于网页没有固定的抽取规则。 对于所有网页都是一套通用的处理方法。

垂直爬虫:这类爬虫主要针对一些特定对象、网站,有一台指定的爬取路径、数据抽取规则。比如今日头条,它的目标网站就是所有的新闻类网站。 比如Etao比价、网易的慧慧购物助手,他们的目标网站就是 淘宝、京东、天猫等等电商网站。

通用爬虫和垂直爬虫显著的区别:

抓取范围,通用爬虫的抓取范围要比垂直爬虫大得多,一个是整个互联网,一个是指定的网站。

爬取路线,通用爬虫要不按照深度爬取、要不是按广度爬取。 而垂直爬虫则可能是按照指定路线爬取。

数据处理,通用爬虫一般就是分词、索引到数据库。 而垂直爬虫则通过特定的规则来抽取更加精细的数据 。

关于行业内的网络爬虫,经过除部分分析,基本以垂直爬虫需求为主,比如通过垂直电商平台获取国内和国际的商品价格等场景。

三、爬取过程

- 导入需要的包

- BeautifulSoup4

- tqdm

- 等等

- 代码:

# 爬取重庆交通大学新闻网站

# 时间:2021.11.14

# 作者:伊木子曦

# import requests

from bs4 import BeautifulSoup

import csv

from tqdm import tqdm

import urllib.request, urllib.error # 制定URL 获取网页数据

# 模拟浏览器访问

Headers = { # 模拟浏览器头部信息

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 "

"(KHTML, like Gecko) Chrome/70.0.3538.25 Safari/537.36 Core/1.70.3741.400 "

"QQBrowser/10.5.3863.400"

}

# 表头

csvHeaders = ['时间','标题']

# 题目数据

subjects = []

# 爬取题目

print('信息爬取中:\n')

for pages in tqdm(range(1, 55 + 1)):# 自行设置爬取的页数

request = urllib.request.Request(f'http://news.cqjtu.edu.cn/xxtz/{pages}.htm', headers=Headers)

html = ""

try:

response = urllib.request.urlopen(request)

html = response.read().decode("utf-8") # 设置编码

# print(html)

except urllib.error.URLError as e:

if hasattr(e, "code"):

print(e.code)

if hasattr(e, "reason"):

print(e.reason)

soup = BeautifulSoup(html, 'html5lib')

div_time = soup.find_all('div', class_="time") # 获取消息时间

title = soup.find_all('div',class_="right-title") #先获取包裹消息内容的div标签class=right-title的所以内容

subject = []

for d in div_time:

for t in title:

for t in t.find_all('a',target="_blank"): # 获取消息div标签class=right-title的内容含a标签且target="_blank"

if t.string is not None: # 判断满足以上所以条件的title不为空

if d.string is not None: # 判断满足以上所以条件的time不为空

subject.append(d.string) # 先将time放入subject

subject.append(t.string) # 再将title放入subject

#if len(subject) == 2:

subjects.append(subject) # 再将整条time,及title放入subjects

print(subject)

subject = []

# 存放内容

with open('./file/CQJTU_news.csv', 'w', newline='') as file:

fileWriter = csv.writer(file)

fileWriter.writerow(csvHeaders) # 写入表头

fileWriter.writerows(subjects) # 写入数据

print('\n题目信息爬取完成!!!')

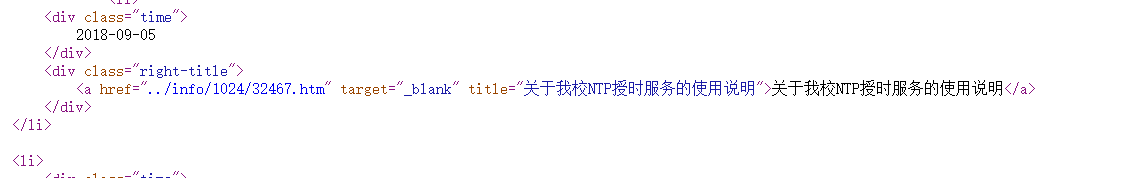

- 查看网页源代码

发现时间在div中且class="time” 为唯一,可直接通过

div_time = soup.find_all('div', class_="time") # 获取消息时间

获得,title的内容获取稍微麻烦点,

因为是div标签且class=class_=“right-title"不只是我们需要的标签是这样,而a标签且target=”_blank"也是一样,所以还需要增加条件(即增大范围),再缩小范围

title = soup.find_all('div',class_="right-title") #先获取包裹消息内容的div标签class=right-title的所以内容

t.find_all('a',target="_blank")

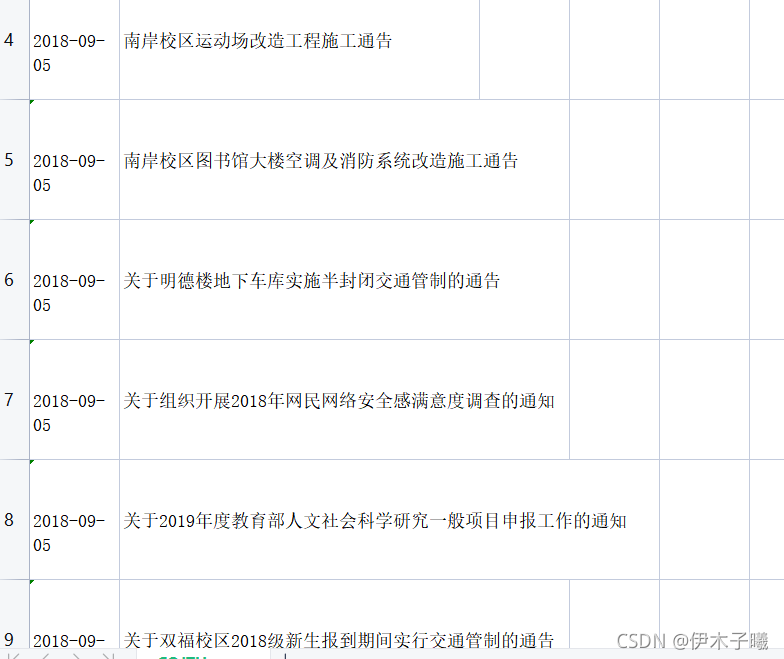

- 运行获取数据