摘要

文本视频检索是一项具有挑战性的任务,其目标是基于自然语言描述搜索相关视频内容。该问题的关键是测量文本视频在联合嵌入空间中的相似性。然而,现有的方法大多只考虑了全局的跨模态相似度,而忽略了局部的细节。有些工作通过跨模态局部匹配和推理结合局部比较。这些复杂的运算需要大量的计算。

本文设计了一种有效的全局-局部对齐方法。多模态视频序列和文本特征采用一组共享语义中心自适应聚合。在同一中心内计算视频特征和文本特征之间的局部交叉模态相似性。该设计实现了细致的局部比较,降低了文本-视频对交互的计算成本。此外,提出了一种全局对齐方法,提供了一种与局部视角互补的全局跨模态测量。全局聚合的视觉特征还提供了额外的监督,这对可学习语义中心的优化是必不可少的。我们在三个标准的文本-视频检索基准上实现了一致的改进,并以明显的优势超越了目前的水平。

介绍

实现跨模式视频检索的一个有希望的方向是使用度量学习来测量文本视频的相似性。在这种情况下,通常的做法是将描述和视频都嵌入到联合嵌入空间中。

这些方法侧重于学习有效的语言和视频表示,但忽视了细粒度语义对齐。

在本文中,我们提出了一种有效的文本-视频检索的全局-局部序列对齐方法。从局部的角度来看,我们的目标是利用一些可学习的语义主题来共同总结文本和视频。与将文本描述解析为分层语义角色图[2]不同,我们希望这些语义主题能够在端到端培训期间被发现并自动学习。我们进一步共享文本主题和视频主题的权重,以提供联合主题表示学习,并减少文本和视频数据之间的语义差距。为了实现局部对齐,我们最小化分组文本特征和相同主题中相应的分组视频特征之间的距离。从全局角度来看,多模态视频序列在每个模态内临时聚合。在聚合的视频特征和全局文本特征之间计算全局相似性。全局对齐不仅作为局部对齐的补充度量,而且还为可学习的语义主题提供额外的监督。

1、首先,我们提出自动学习文本和视频语义主题,并再次强调文本和视频之间的局部语义对齐对于更好的跨模式检索的重要性。

2、其次,我们引入了一种有效的策略来实现文本输入和视频输入的局部对齐。在NetVLAD[1]编码成功的基础上,我们提出了一种用于跨模态检索的T2VLAD编码,利用共享中心来减少文本和视频之间的语义差距,而不是复杂的成对局部匹配操作。

3、第三,我们展示了T2VLAD在三个标准文本-视频检索基准上的显著改进。

全局对齐提供了文本和视频之间全面的相似性度量。

局部对齐通过计算来自相同语义中心的局部文本-视频特征之间的相似性来提供细粒度的比较。

netVLAD理解

算法理解

NetVLAD是一种特征编码的方式,主要用于图像特征提取。首先定义聚类中心,然后计算图像像素点到聚类中心的距离,之后累加作为图像特征。NetVLAD就是在VLAD的基础上,动态可学习的为每个像素到各个聚类中心赋予权重。

相关工作

文本视频检索

文本视频检索需要理解时间动态和复杂的文本语义。

语言表征学习

我们在文本视频检索中使用BERT模型,在端到端跨模态检索训练中对模型进行微调。

VLAD Encoding

在本文中,我们利用NetVLAD进行文本-视频局部相似度匹配,并引入局部对齐损失,以减少文本和视频局部学习特征的差距。我们不对得到的聚合特征进行分类,而是对文本和视频特征进行局部对齐。

方法

我们提出文本到视频的VLAD (T2VLAD)用于跨模式检索,它在全局和局部视角下对文本和视频特征进行对齐。给定一个文本-视频对,我们的目标是将其编码到一个联合特征空间,以衡量相似性。

如图2所示,我们利用多个专家提取每个模态对应的本地视频特征(Section3.2)。利用BERT模型提取上下文词特征(章节3.3)。然后,我们将来自不同专家的所有视频特征输入到自注意层,基于交叉模态关系增强特征。输出的视频特征和文本特征被分配到一组聚类中心,文本编码和视频编码共享这些聚类中心。我们基于赋值聚合局部特征,生成视频和文本的局部对齐特征,以计算局部视频和文本的相似度(章节3.4)。为了对局部线形提供额外监督并引入补充信息,,我们开发了一个全局对齐方案(章节3.5)。

视频表示

为了充分利用视频数据中的多模态信息进行文本视频检索任务,我们利用多个专家[24,22,9]对原始视频进行编码。具体来说,给定一个输入视频,我们利用专家{E1,E2,…,EN}提取多模态特征。 E n {E^n} En代表n时刻的特征。每个专家都在特定的任务上进行预先训练,以获得相应模态的特定知识。我们的目标是实现文本视频检索的局部和全局对齐,因此我们从每个时间片段中提取特征。对于每个专家,我们得到一组段级视频表示,即{En(x1),En(x2),…, (xT)}。这里是段数,xt是视频的第t段。我们利用以下两个操作进一步处理段级多专家特性,以便后续的全局-局部对齐。

首先,我们介绍了用于全局对齐的全局专家特征。我们的目标是对每个专家进行时间聚合,以生成全局的专家特征。(感觉这里的专家是片段的意思)为了简单起见,我们利用不带附加参数的max-pooling操作。这个简单的操作在我们的实验中效果很好。将时间聚合的特征投影到同一维度,用于后续的聚类。

其次,我们使用一个自注意层融合多专家特征进行局部对齐。我们首先为每个专家使用一个全连接层,将不同的专家特征投影到ac维嵌入空间。然后我们连接所有专家的特征来生成本地特征 z v i d e o = z v i d e o 1 , z v i d e o 2 , … z^{video} ={z^{video1},z^{video2},…} zvideo=zvideo1,zvideo2,…其中M是来自所有专家的特性的数量。

文本表示

BERT模型[4]在语言特征编码中表现出了很强的泛化能力。BERT模型提取每个文本输入的上下文词嵌入。输入的句子被标记并填充成固定长度的序列。定长序列是BERT模型的输入。我们添加特殊的标记,如“[CLS]”和“[SEP]”来表示句子的开始和结束。

与视频编码不同的是,在后续的T2VLAD模块中,文本的全局特征与局部表示联合提取。

局部比对

经过上述的文本编码和视频编码后,这些特征包含了丰富的输入句子和视频信息。然而它们没有很好地对齐。

此外,本地视频的特点是来自不同的模式。区域间隙增加了局部对齐的难度。直观上,如果我们对同一主题的本地文本特征和视频特征进行选择和聚合,然后比较它们的相似性,那么测量就会变得更加精确。

在这种精神的推动下,我们提出了文本到视频的VLAD (T2VLAD),以聚类来自共享中心的多种模式的局部特征。这些中心提供了共享的语义主题,可以弥合不同形式之间的差距。

我们利用余弦距离来度量最终视频和文本特征之间的局部相似性

全局对齐

我们引入全局对齐有两个原因。首先,文本-视频对的全局特征更全面,与局部特征互补。其次,当缺乏辅助监控时,特别是当视频特征包含多模态信息时,难以优化与可训练中心的精细局部对齐。因此,我们通过独立地聚合和转换来自每个专家的视频特征来缓解全局对齐中的优化困难。同时,我们利用本地文本特征的串联来生成特定于专家的全局文本表示{Ftext1,Ftext1,…,FtextN}。然后使用每个特征计算与相应视频专家特征的相似度。在[24]之后,我们将全局textvideo相似性计算为每个全局视频专家特征和相应文本特征之间余弦距离的加权和。

实验

三个数据集的测试

表1。与MSRVTT[35]数据集上最新方法的比较。

表2。与ActivityNet标题数据集上最新方法的比较。

表3。与LSMDC数据集上最新方法的比较。

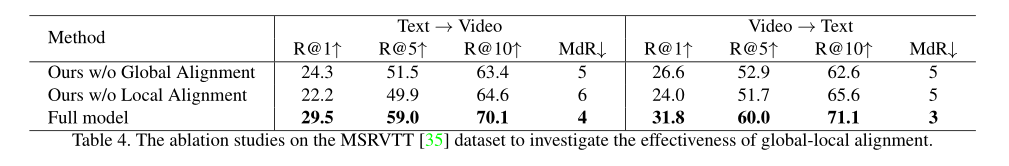

消融实验

对MSRVTT[35]数据集的消融研究,以调查整体局部校准的有效性。

可视化

作业的可视化。文本本地特征和本地视频特征被分配到T2VLAD中的一组共享中心。我们希望在同一个中心上聚合的文本功能和视频功能共享类似的主题。在图3中,我们说明了三个中心上的文本分配和视频外观特征分配。视频在文本检索结果中排名第一。我们显示与指定给特定中心的外观特征相对应的视频帧。如图3所示,在中心1上具有最高分配的文本特征是“guy”特征。已指定给中心1的所有帧也包含“guy”的外观信息。中心2上分配最高的文本是“某物”,而分配给中心的唯一帧是关于视频中的“某物”。在中间6, “some-

thing”, “talks”, “camera” and “another” 都有很高的赋值。

人类观点中最突出的单词“extinguishes”在所有中心上的赋值都很低。这是因为有限的训练数据不足以理解低频词。任务可视化验证了我们的T2VLAD可以实现文本到视频检索的充分局部对齐。

文本视频检索可视化

我们展示了通过我们的方法检索到的视频的两个例子,以及没有局部对齐分支的模型。如图4所示,两个查询语句由多个语义主题组成。

这些结果表明,我们的T2VLAD可以有效地对齐多个语义线索。

结论

本文介绍了一种端到端文本视频序列对齐方法。我们证明文本和视频之间的局部语义对齐对于高性能检索系统是至关重要的。基于NetVLAD实现了文本视频的局部对齐,并引入了用于文本视频协同编码的T2VLAD。在三个标准文本-视频检索基准上的结果清楚地证明了我们的方法的有效性。可视化结果也验证了我们的联合语义主题学习动机。未来,通过端到端优化,可以获得更好的全局视频特性。