图像超分辨率[CVPR2016]-VDSR-PyTorch代码复现

前言:

Implementation of CVPR2016 Paper: “Accurate Image Super-Resolution Using Very Deep Convolutional Networks”(http://cv.snu.ac.kr/research/VDSR/) in PyTorch

论文原作者是用matlab写的代码,GitHub上有大佬用PyTorch复现,为我们提供了便捷。但是毕竟已经过去五年了,复现过程中也遇到了很多问题,当然,也从中学到了很多。

跑源码遇到的问题

- main_vdsr:

UserWarning: torch.nn.utils.clip_grad_norm is now deprecated in favor of torch.nn.utils.clip_grad_norm_.

nn.utils.clip_grad_norm(model.parameters(),opt.clip)

特别细微的区别,函数方法后加了一个下划线

# 修改前

nn.utils.clip_grad_norm(model.parameters(),opt.clip)

# 修改后

nn.utils.clip_grad_norm_(model.parameters(),opt.clip)

-

demo.py:

ImportError: cannot import name ‘imread’ from ‘scipy.ndimage’,从scipy1.3.0开始,imread已从这个模块移除

from scipy.ndimage import imread

ImportError: cannot import name 'imread' from 'scipy.ndimage' (D:\Anaconda\envs\pytorch\lib\site-packages\scipy\ndimage\__init__.py)

# 修改前

from scipy.ndimage import imread

# 修改后

from imageio import imread

- 如何在训练的时候指定GPU(如果你的电脑有GPU的话,最好用起来)

- 看到每个py里,开头总有很多parser.add_argument()来设置参数,这有什么作用呢?python之parser.add_argument()用法——命令行选项、参数和子命令解析器

- 解决报错:h5py objects cannot be pickled,这是因为在加载训练集时使用了多线程

PSNR(图像峰值信噪比)

vdsr.py中参数对卷积参数的初始化

for m in self.modules():

if isinstance(m, nn.Conv2d):

# 打印下来看了看

# print(m.kernel_size[0], m.kernel_size[1], m.out_channels)

n = m.kernel_size[0] * m.kernel_size[1] * m.out_channels

m.weight.data.normal_(0, sqrt(2. / n))

把以上报错以及一些小错误解决之后,代码终于跑通了!用作者给的model_epoch_50.pth重新跑demo.py和eval.py可以出结果,总是报一堆SourceChangeWarning,很明显是网络源有了更改,但结果和GitHub及论文里公布的差不多,我本以为这样就算成功了。

但正是由于我的强迫症,于是打算自己重新训练一下,用自己训练出来的模型进行测试,果然模型训练出来了,这些warning也不在了,结果令我震惊,好像白训练了,PSNR和双三次插值的基本没差别,这是什么问题呢?

想找一下解决方案也搜不到,找了好久,就在自己想要放弃的时候,在GitHub的Issues下发现了同样的问题:使用提供的train.h5按照main_vdsr.py中的超参数进行重新训练,经过50个epochs后得到的结果却是和bicubicu的值差不多,请问这是什么原因?

这下就不奇怪了,原来大家也遇到这问题了。还好作者耐心解答,我也根据作者提供的matlab源码,用91张图片重新生成了训练用的数据。然后白嫖Google Colab的Tesla K80进行训练,原本训练50个epochs不到30分钟,现在训练了将近两天(而且Google还要限制使用时长)。最后顺利用2G数据集训练出来的第50个epoch测试,得到了和论文、GitHub中接近的结果。

用91张图片数据集训练的结果

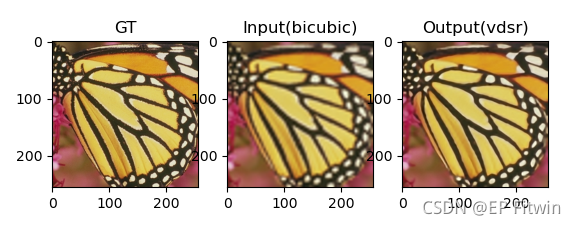

From left to right are ground truth, bicubic and vdsr

After 50 epochs of training, performance on set5:

| Scala | PSNR_bicubic | PSNR_predicted | PSNR_paper | Time |

|---|---|---|---|---|

| 2x | 33.69 | 37.32 | 37.53 | 2.54s |

| 3x | 30.41 | 33.52 | 33.66 | 2.14s |

| 4x | 28.41 | 31.22 | 31.35 | 2.03s |

后记:

这个代码虽然复现成功了,但其实仅仅是停留在了跑通代码的阶段,只是看懂了网络。要让自己现在重写还真写不出来。b站刘老师说,要提升能力应该是这样的过程:

- 理论《Deep Learning》,从数学和工程学的角度理解深度学习理念

- 阅读PyTorch文档

- 想写复杂网络:要阅读PyTorch文档

经典代码光跑通没用,如何提炼能力:读代码->写代码->学代码,不断迭代 - 读代码,看系统、训练、测试架构、如何构建损失函数等

- 尝试自己来写,而不是直接拿下来跑代码

- 扩充视野:知识盲点、代码实践上的不足