1 预备工作

1.1 码源下载

下载地址:YOLOv5码源下载

进不去的同学找个梯子哦。

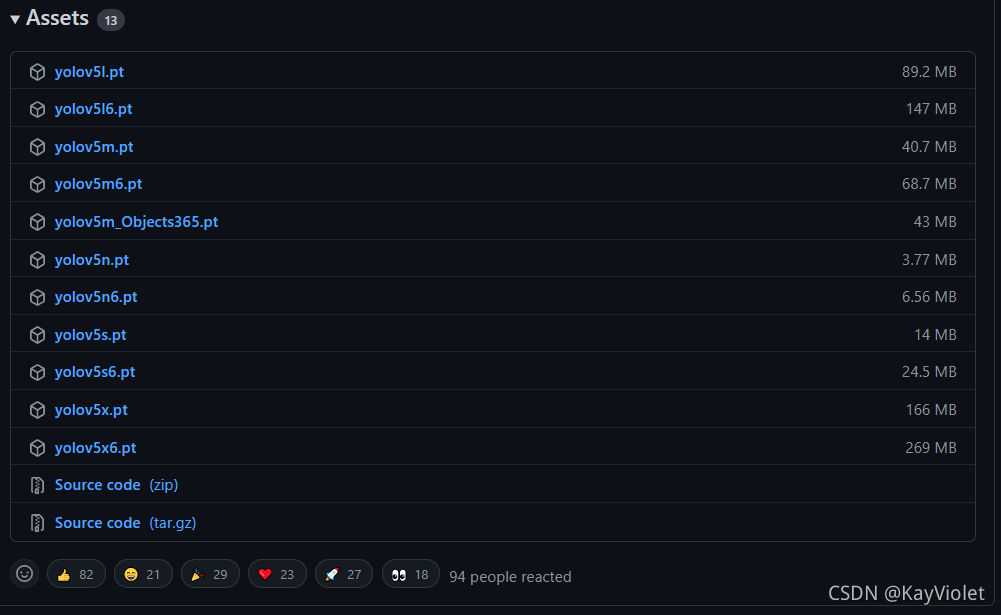

1.2 模型下载

有梯子的同学可以忽略这一步。

没有梯子的话,通过程序下载模型会很慢,所以还是建议通过GitHub官方去下载。

这边也放上下载地址:YOLOv5模型下载

页面向下拉看到下图页面,直接点击,即可下载。

没有梯子的同学,需要的话留言,我会放上百度云连接。

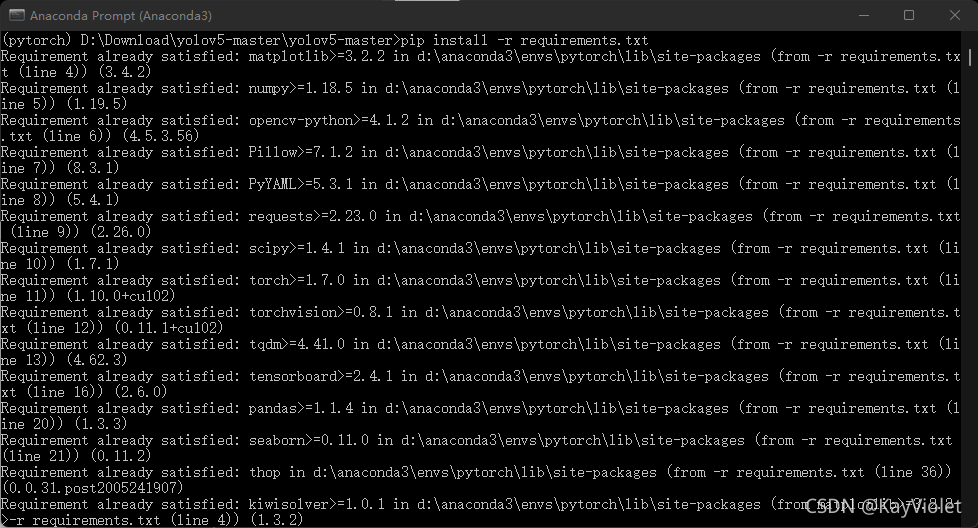

1.3 环境配置

我用的是Anaconda虚拟环境,具体环境配置我会单独写一篇文章。

将下载下来的yolov5-master.zip文件解压。

接下来就是配置环境了。

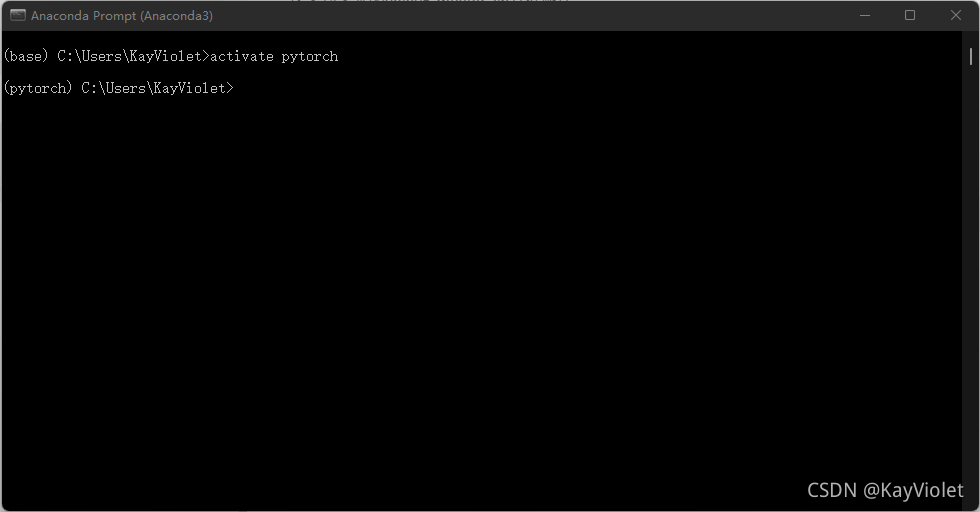

打开Anaconda Prompt输入如下代码,进入虚拟环境。这边的虚拟环境是自定义的虚拟环境,activate后面加的是你自定义的虚拟环境。

activate pytorch

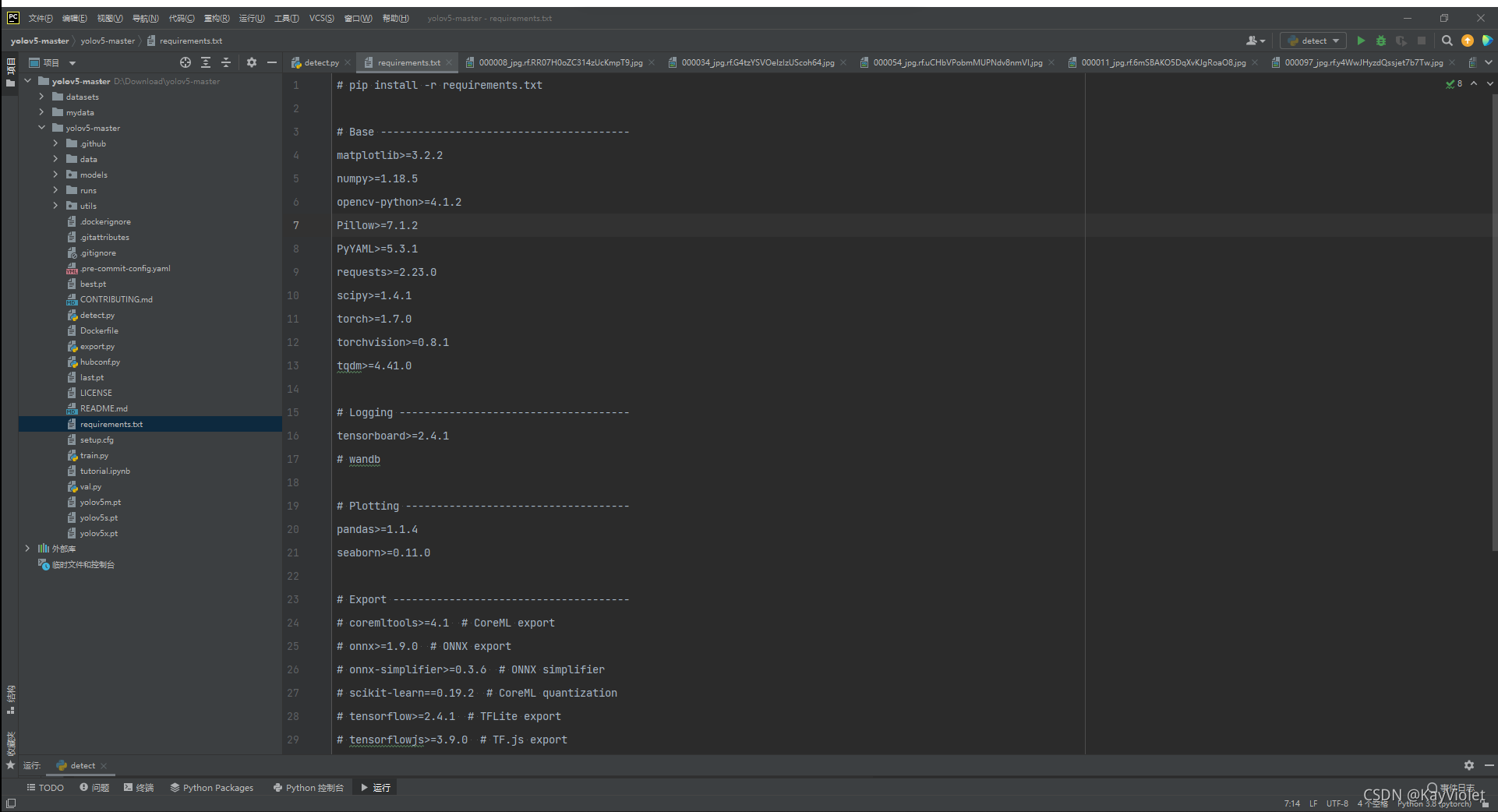

打开程序可以看到有一个requirements.txt文件,我们通过这个文件来安装没有的包。

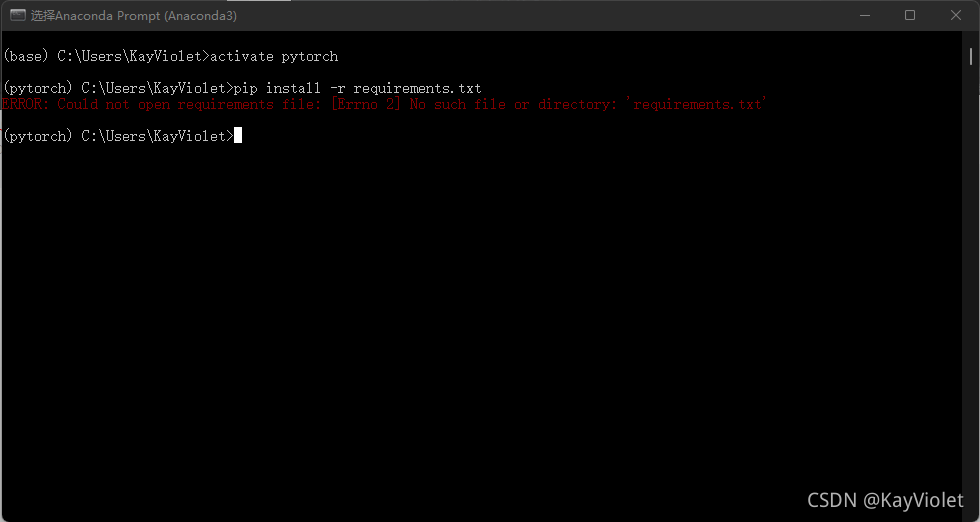

在终端虚拟环境中输入如下代码安装requirements.txt中所需要的包。

pip install -r requirements.txt

这边要注意一点,一定去找到requirements.txt当前所在的文件夹去安装,不然会出错。

ERROR: Could not open requirements file: [Errno 2] No such file or directory: ‘requirements.txt’

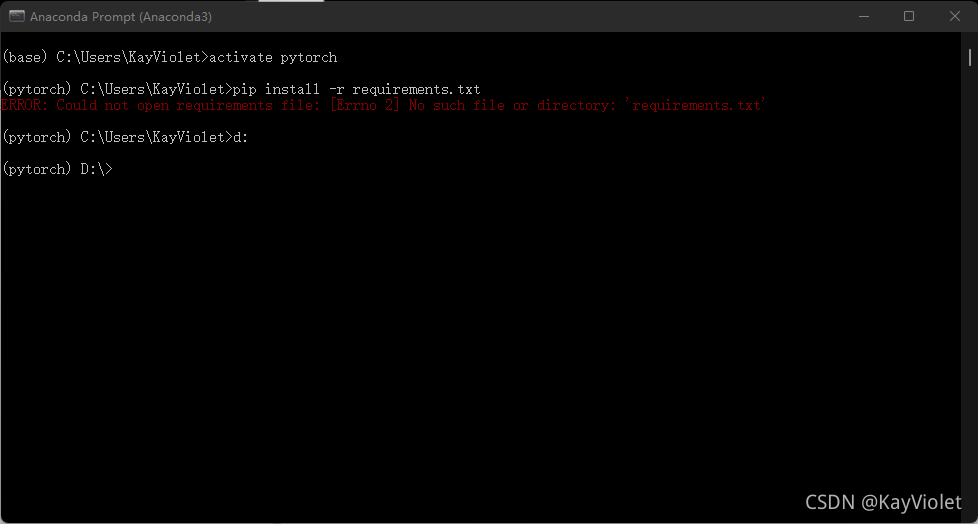

按照如下操作通过终端进入解压后的文件夹。

博主是将压缩包解压在D盘,因此输入

d:

进入D盘。

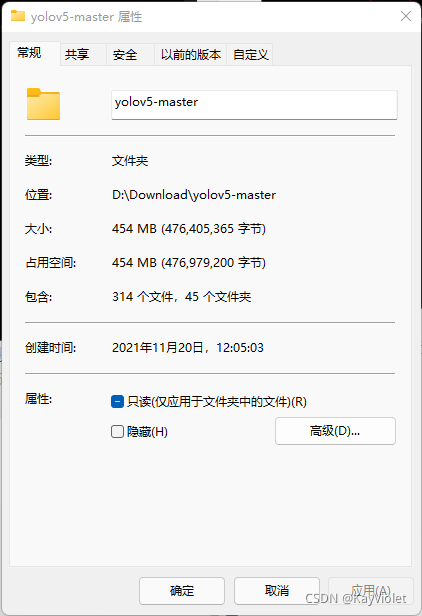

点击解压后的文件夹,查看属性,这一步主要是要查看文件夹所属路径。如果文件放得比较浅,可以直接敲。

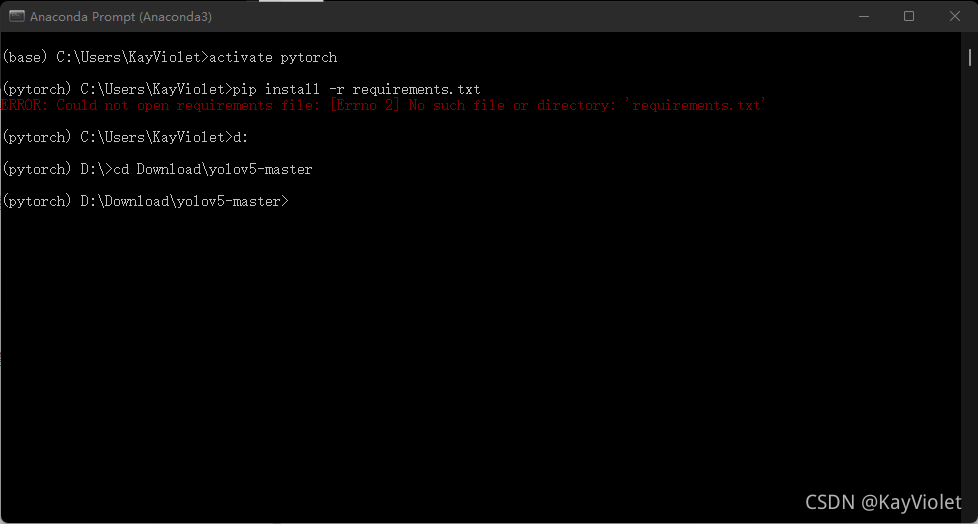

在终端输入进入文件夹

cd Download\yolov5-master

cd后面跟的就是你的解压后文件夹路径,这里就是博主所放的一个路径。

接着就可以安装requirements.txt中所需要的包啦。

输入指令

pip install -r requirements.txt

没有出现错误就是安装成功啦。

2 YOLOv5预测

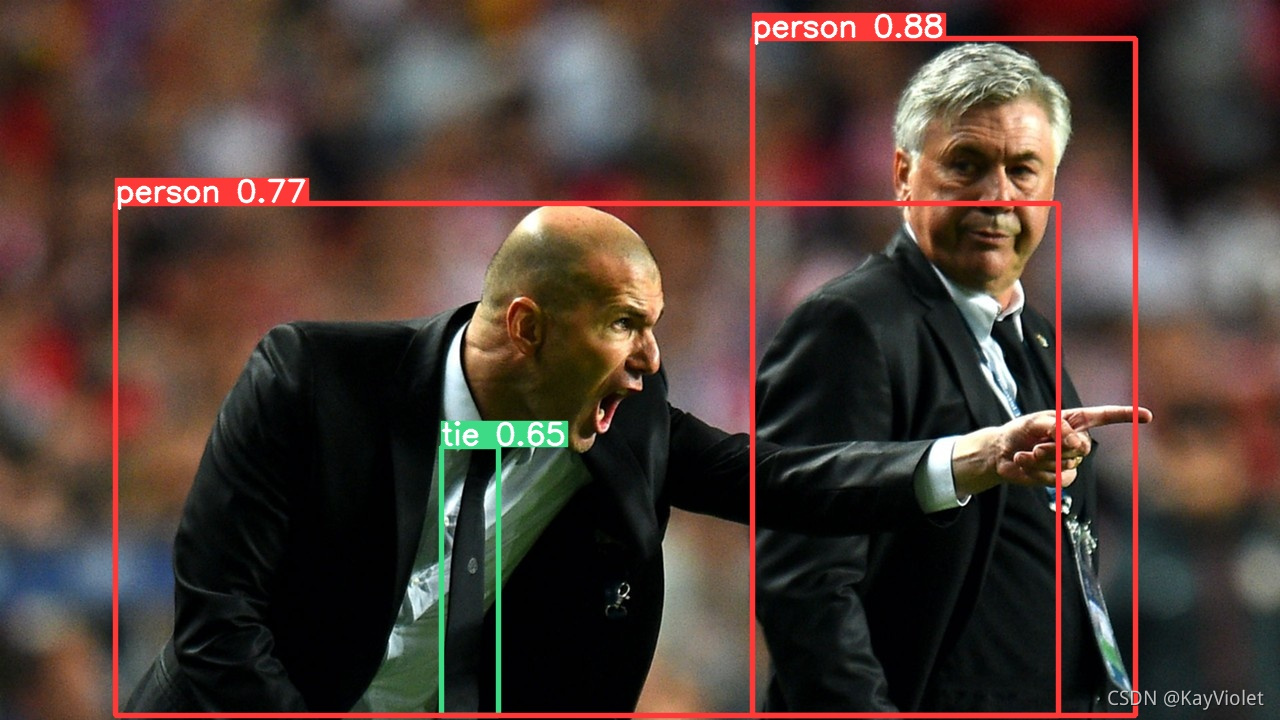

在PyCharm平台上打开detect.py,直接点击运行,看看有没有出错,博主当时下载完模型后是没有出错的,在yolov5-master\data\images文件夹中有两张照片,你也可以放上在自己的照片,进行预测。

预测后的结果在yolov5-master\runs\detect\exp8文件夹中,里面有检测物体方框,物体类别和预测的置信度。如图所示。

预测后图片。

当然,如果你想提高检测的置信度,可以改变模型,将原来

parser.add_argument('--weights', nargs='+', type=str, default=ROOT / 'yolov5s.pt', help='model path(s)')

中的模型改成其他的模型,这里的模型从官网下载后的模型。

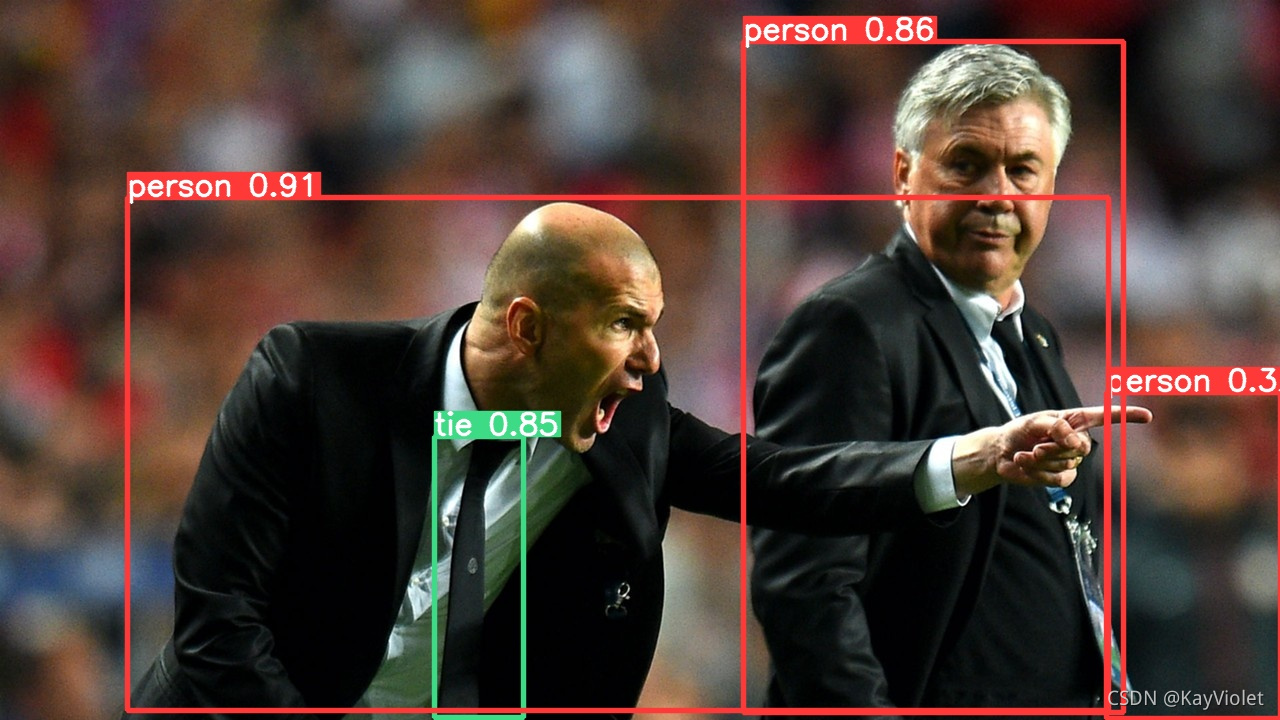

例如,改成yolo5m.pt这个模型,将原代码改成

parser.add_argument('--weights', nargs='+', type=str, default=ROOT / 'yolov5m.pt', help='model path(s)')

即可。

可以看到检测结果置信度有明显提升,当然,模型越大检测的速度就会越慢。

累了,明天继续train的部分

如果有没有gpu的朋友,还会出Google colab远程服务器的教程,看心情写,进行就先这样。

detect.py文件运行有错误的可以留言一起讨论哦~