卷积神经网络

前言

- 为什么要使用卷积神经网络呢?

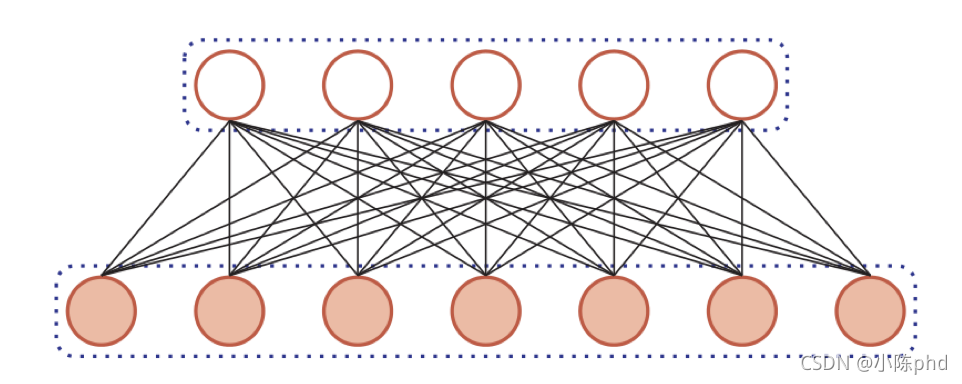

- 首先传统的MLP的有什么问题呢? -

传统过的全连接网络,每一层的输出就是下一层的输入。在一个模型拟合任务中,并不是所有的参数特征都占据很大。因此,有些特征依然会存在冗余的情况。

总结:并不是所有的权重都会发生作用,依然会有很多不必要的参数。

全连接存在的问题就是,这一层的输入也许我并不是全部需要,也许本身也不需要。参数过多也会造成计算的增加,浪费时间。

参数过多,计算冗余

- 首先传统的MLP的有什么问题呢? -

卷积神经网络

- 卷积神经网络也是一种前馈神经网络,是受到生物学上感受野(感受野主要是指听觉系统、本体感觉系统和视觉系统中神经元的一些性质)的机制而提出的(在视觉神经系统中,一个神经元的感受野是指视网膜上的特定区域,只有这个区域内的刺激才能够激活该神经元)。

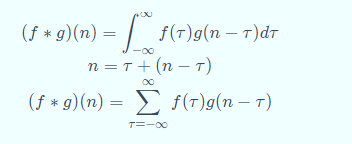

卷积:(f**g*)(n)成为 ff 和 gg 的卷积,连续卷积和离散卷积可以表达为如下形式:

卷积有很多应用,经常用于处理一个输入,通过系统产生一个适应需求的输出。

统计学中加权平均法

概率论中两个独立变量之和概率密度的计算

信号处理中的线性系统

物理学的线性系统

图像处理中的应用(卷积神经网络)

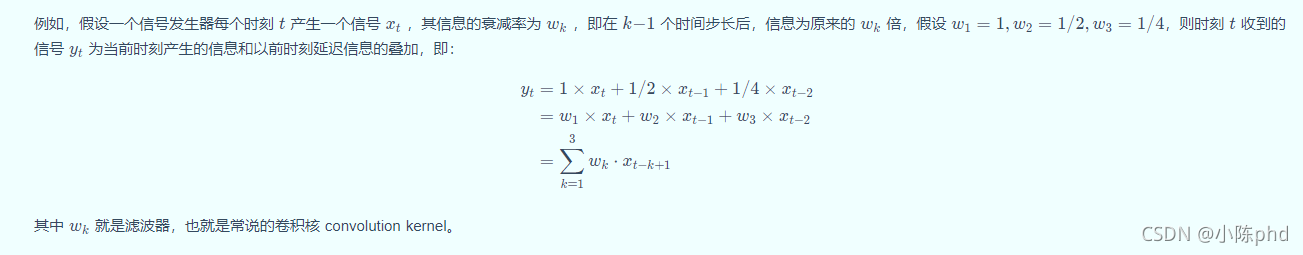

卷积经常用在信号处理中,用于计算信号的延迟累积。

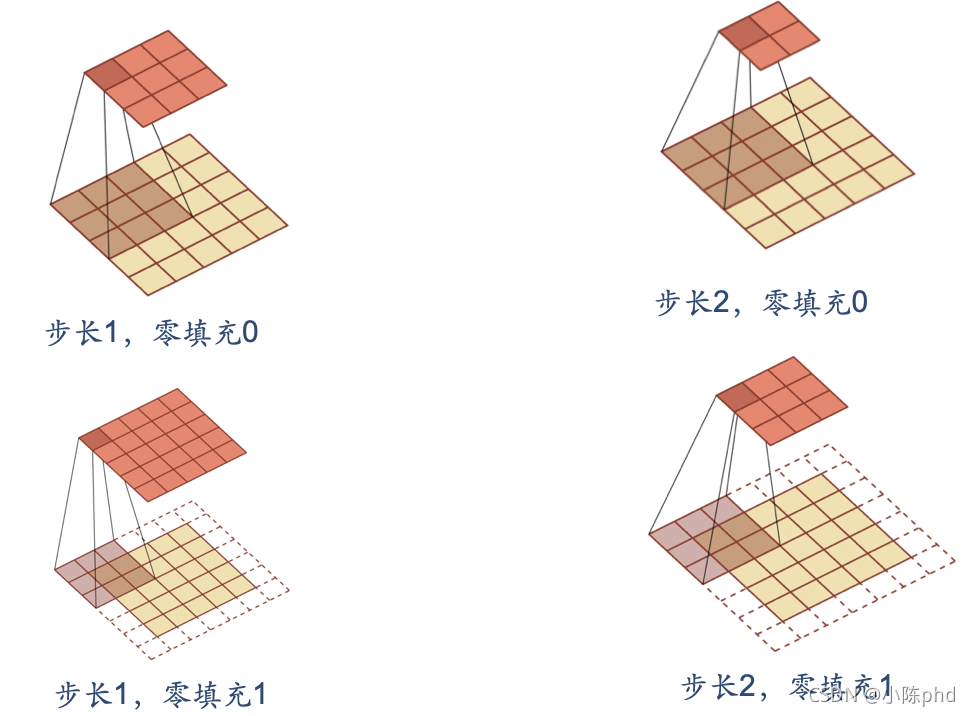

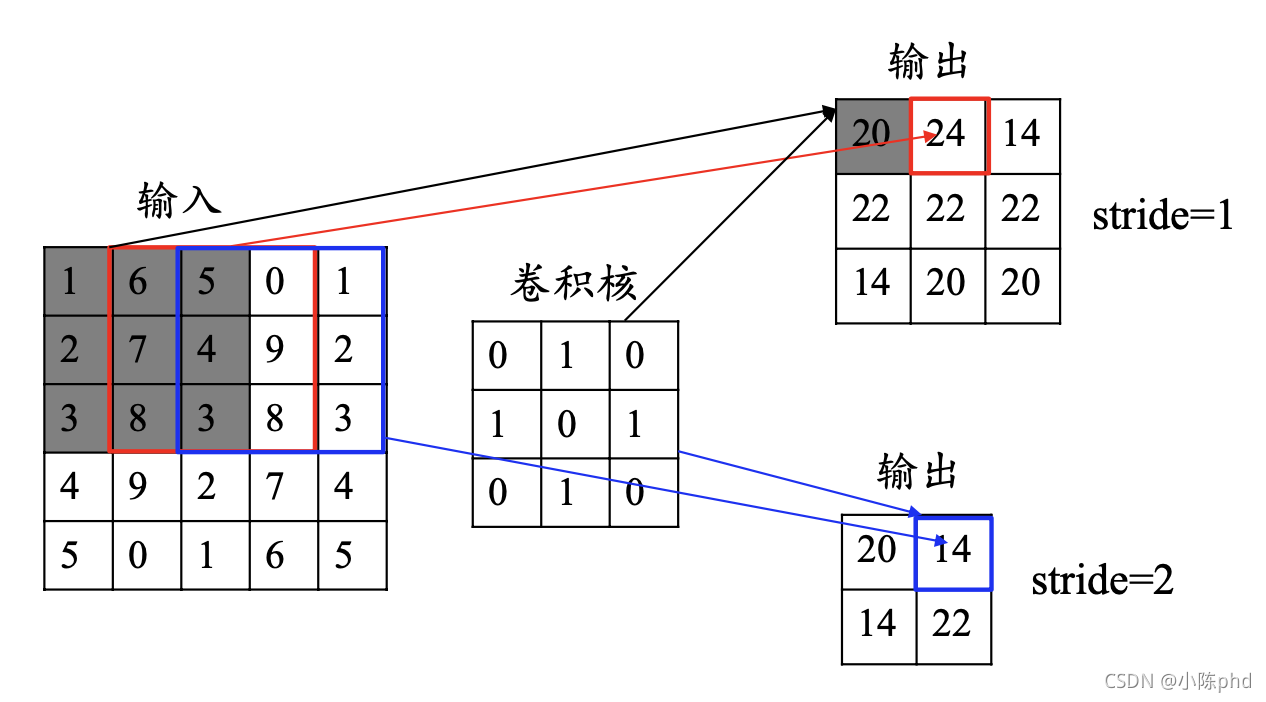

卷积的填充方式

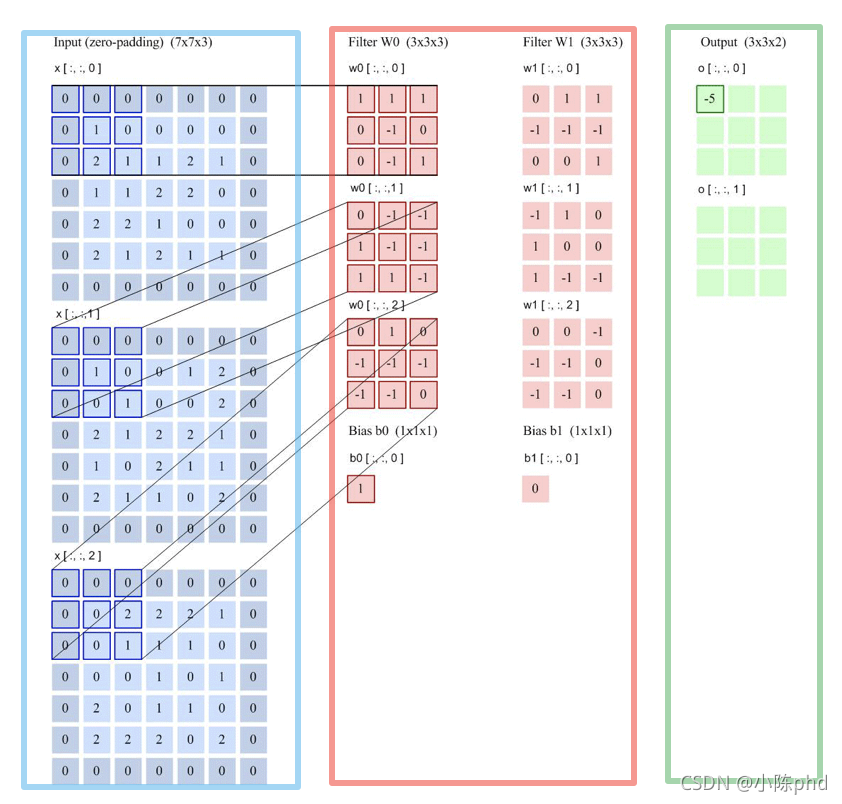

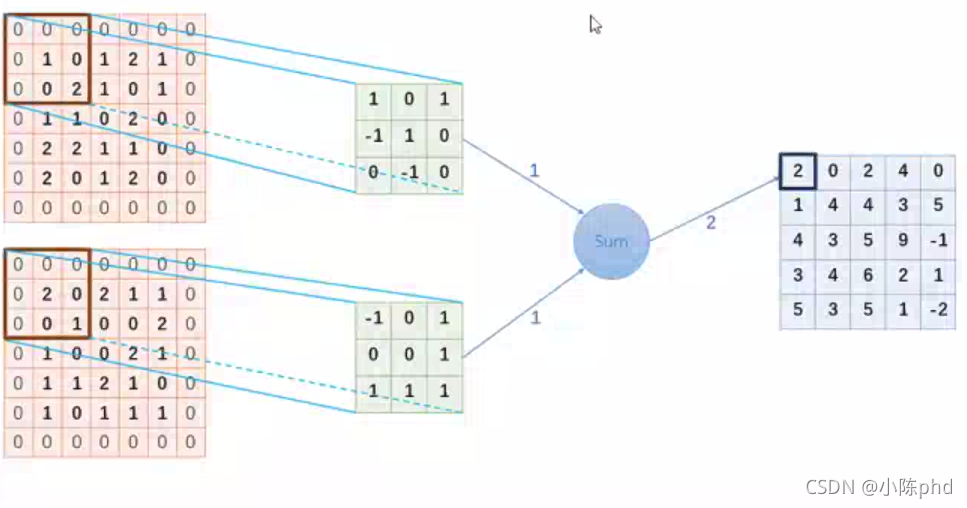

卷积原理展示

卷积核在很大程度上可以看成滤波器。至少作用上具有很大相似性。

卷积原理示意图

卷积运算:通过学习得来的卷积核,获得特征图

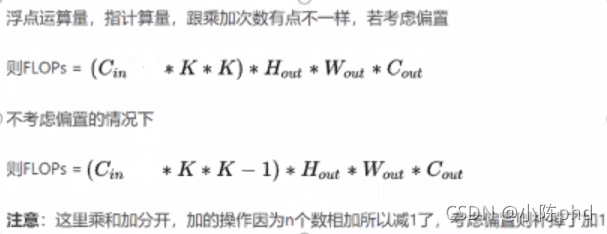

卷积计算量公式

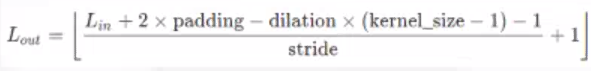

卷积核输出的大小计算

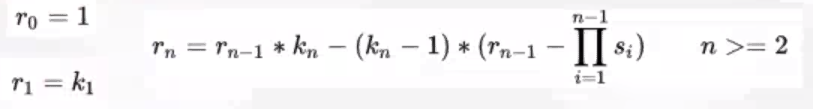

感受野

-

感受野:类似于余光感受的视野,有时候关键信息分布很分散,需要足够的感受野捕捉足够的信息,这样足够的参考信息利于提高精确度(网络层次不够时,感受野可以辅助处理问题)

因此,小的特征图往往也能看到很多全局的特征、

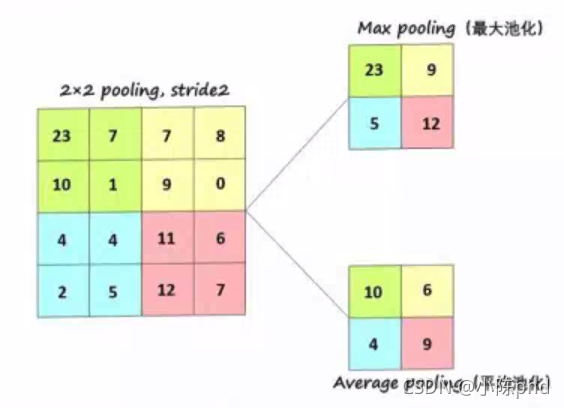

池化

- 具有平移不变形和移动不变性

- 备注:池化类似于卷积的过滤,池化会丢失信息(无用信息或者 重要信息)

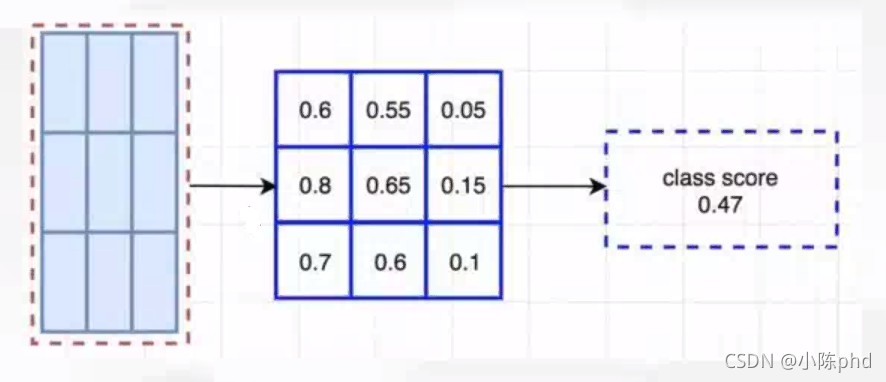

自适应均值化

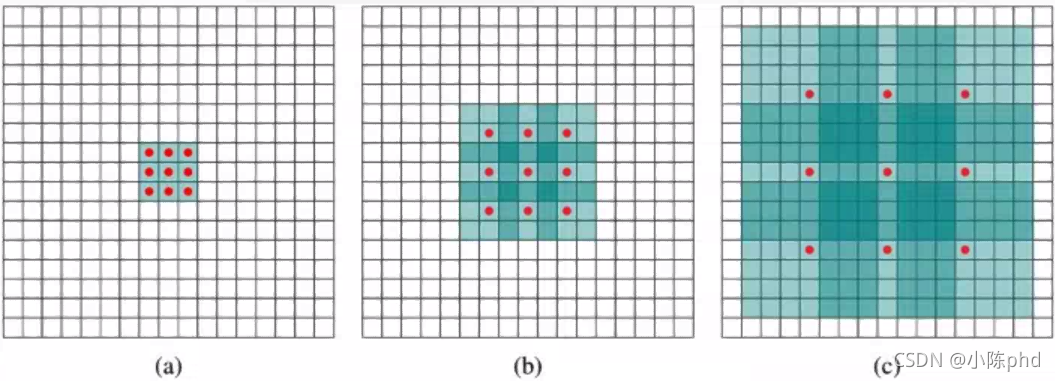

空洞卷积

- 空洞卷积

- 红点参与计算,没有空洞时空洞值为1,多一个空洞,空洞值+1

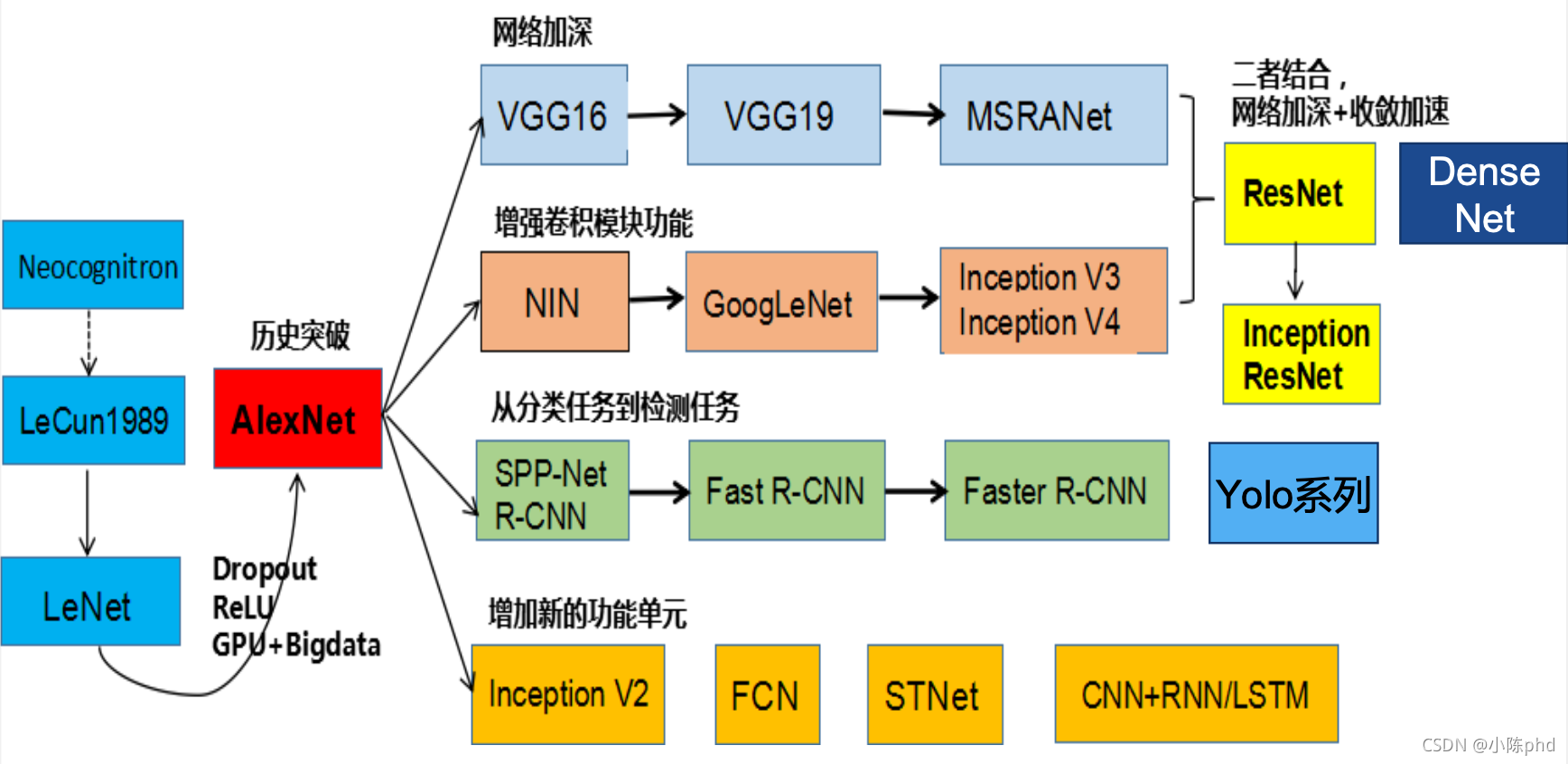

经典卷积神经网络

以上类别,以后分开介绍吧…

参考

链接: Datawhale.