NUWA:一种多模态方法,操纵视觉图像。

贡献:

1、一个3D transformer,可以包括文字、图片与视频输入。

2、提出3D Nearby attention(3DNA)。3DNA由空域和时域的局部特征组成。不仅减少了复杂度,同时提高了最后可视化图片的质量。

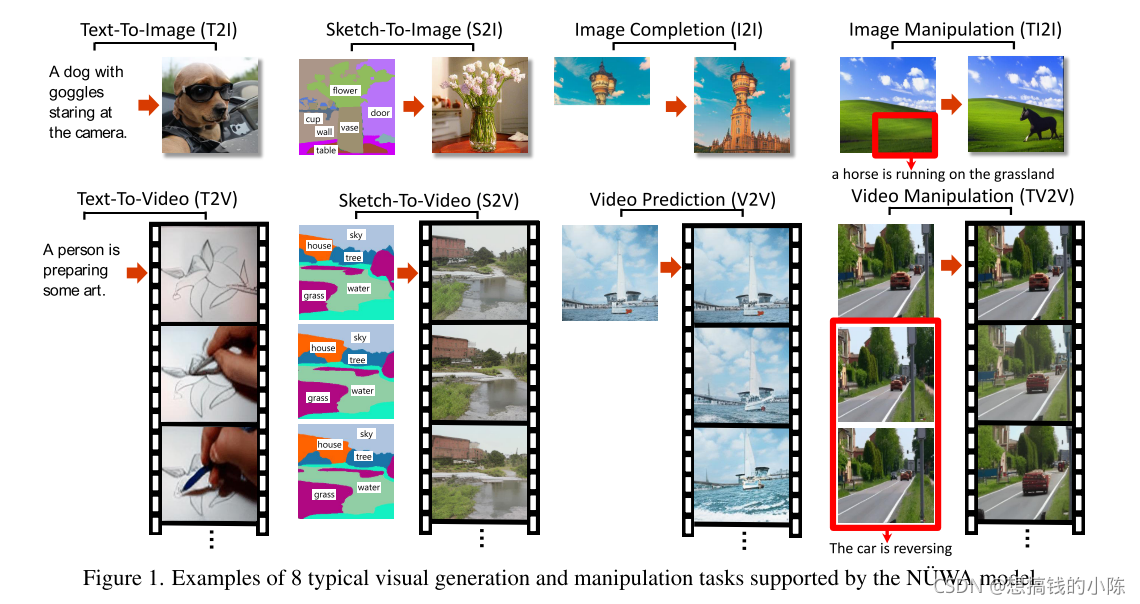

3、在T2I(text-to-image),T2V(text-to-video),Video prediction 等等任务中都达到SOTA结果。并且模型不仅在text-guided image manipulation(文本操控图片)(图一的第一行第四列)展示了很好的zero-shot能力,在text-guide video manipulation(文本操控视频)(图1的第二行第一列)也展示了很不错的能力。

?引言:

一些Auto-regressive 自回归模型都基于pixel-by-pixel的方式,所以都有一个缺点:无法处理高维度high-dimensional visual data,只能处理一些低分辨率low-resolution 图片和视频。

最近,VQ-VAE 是一个离散可视token化的方法,可以有效并且在large-scale上训练visual synthesis task.但其有个缺点,就是VQ-VAE把视频和图片分离开,这对训练来说并不友好。

方法:

如何分别标准文本、图像、视频?

1、用一个通用的维度来获得输入,其中h和w代表图像的高和宽,s代表多少个token(NLP的词向量的个数),d代表每个token的维度。

2、文本用一个lower-case byte pair encodeing(BPE)将文本嵌入到中。文本在h和w方向都没有维度,因此用1表示;

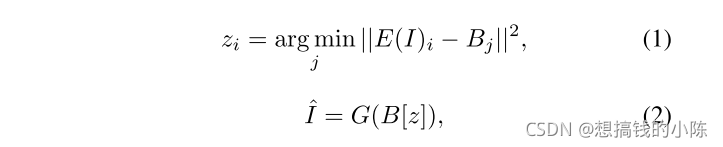

图片的输入,也是需要编码的,公式如下:

代表一个encoder,将raw data送入encoder,得到?

,比较

和

codebook的距离,其中

,

,得到离

最近的token,将其离散化,并且利用decoder(G)重构I_hat.这部分就是VQ-VAE,然后通过G和D的不断训练,得到B。最后的

用于训练,1代表没有temporal dimensions

3、视频可以被视为图像的时间扩展,最近的作品如VideoGPT[48]和VideoGen[51]将VQ-V AE编码器中的卷积从2D扩展到3D,并训练视频特定的表示。然而,这不能为图像和视频共享一个共同的码本。在本文中,我们展示了简单地使用2D VQ-GAN编码视频的每一帧也可以产生时间一致性的视频,同时受益于图像和视频数据。结果表示为asRh×w×s×d,其中表示帧的数量。

?3DNA

一个减法的算法,原论文写的听清楚的,这里不介绍了(主要做K和V的减法)

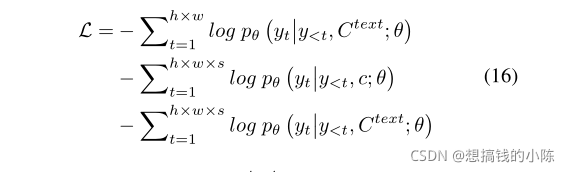

Loss

?