文章目录

论文题目:Progressive Semantic Segmentation(渐进式语义分割)

四个问题

-

要解决什么问题?

?? 自动问答系统可以帮助人们快速从海量文本中提取出有效信息,答案选取这关键一步对自动问答系统的性能有很大的影响。这篇文章要优化现有答案选择模型中答案关键信息捕获不准确的问题

-

提出了什么新的方法?

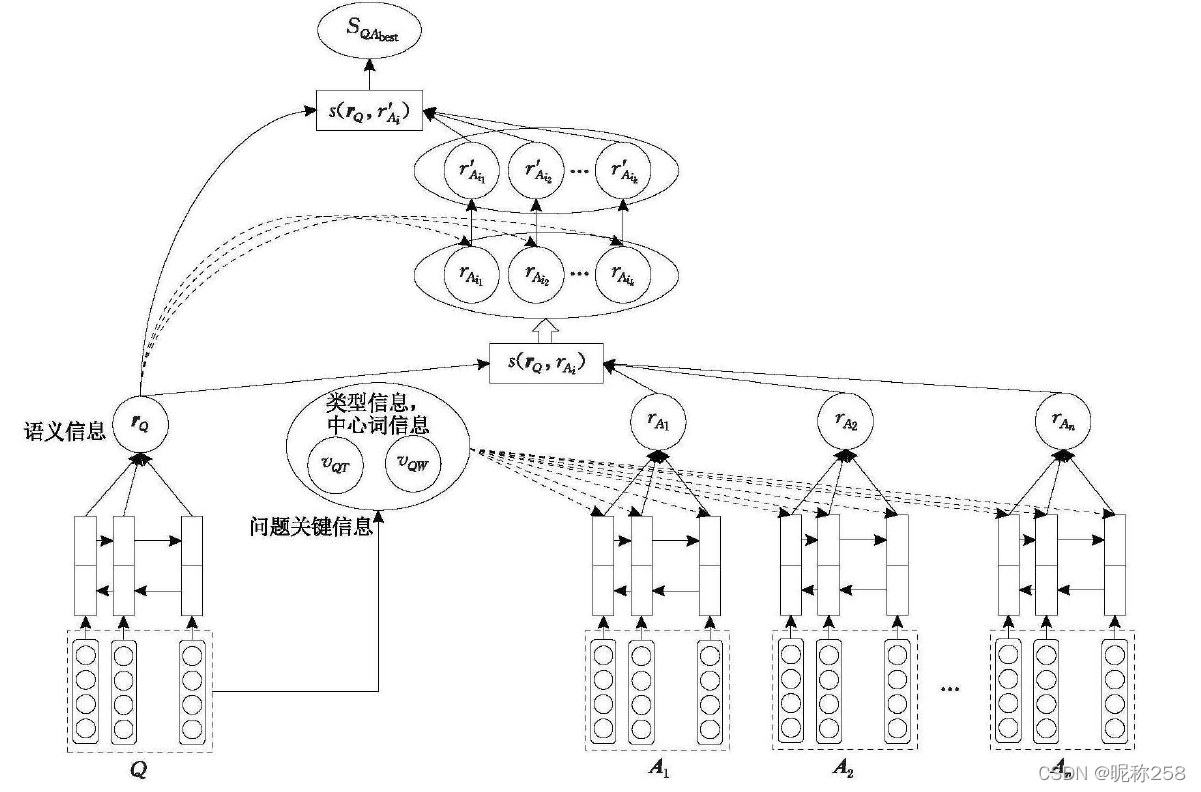

??这篇文章提出了一种融合语义信息与问题关键信息的多阶段注意力答案选取模型,该方法首先利用双向LSTM模型分别对问题和候选答案进行语义表示;然后采用问题的关键信息,包括问题类型和问题中心词,利用注意力机制对候选答案集合进行信息增强,筛选Top K个候选答案;然后采用问题的语义信息,再次利用注意力机制对Top K个候选答案集合进行信息增强,筛选出最佳答案。

-

效果如何?

??通过分阶段地将问题的关键信息和语义信息与候选答案的语义表示相结合,有效提高了对候选答案关键信息的捕获能力,从而提升了答案选取系统的性能。在三个数据集上对本文所提出的模型进行验证,相较已知同类最好模型,最高性能提升达1.95%。

1.介绍

1.1答案选取模型

??第一种是传统的答案选取模型大多利用词法或句法分析以及人工构造特征的方法来选取答案,缺点是较难捕捉到问题与候选答案之间的语义关联信息。

??第二种是利用神经网络模型获取问题和候选答案的语义关联信息,并对它们之间的匹配关联程度进行评估,进而选取匹配关系最强的答案作为最佳答案。优点是引人注意力的模型,能够强化问题与候选答案之间语义关联的程度;缺点是忽略了两者之间关键信息的联系;现有的基于注意力的答案选取模型往往将问题和答案的建模放在同一阶段进行,这对从多个候选答案中选取一个最佳答案的答案选取任务来说,不容易捕捉到答案相互之间的差异。

1.2关于答案选取

??答案选取问题通常被视为分类任务和相似度计算任务两种类型的问题进行解决。

??为了有效提升答案选取的效果,大多研究学者都致力于研究问题与候选答案之间相关关系的表示,主要的研究工作可分为两个阶段:第一阶段是基于语言学知识和特征工程的答案选取方法,第二阶段是基于深度学习的答案选取方法。

??对于第一个阶段,主要是结合外部资源对问题、候选答案进行词法、句法分析进而选取答案。缺点:性能好坏对提取特征的质量、采用的外部资源有很大的依赖;需要一定的领域知识和较高的人工成本。

??对于第二个阶段,通常是利用神经网络对问题和候选答案进行语义表示,接着进行相似度计算来选取最佳答案。优点:具有较强的通用性;能够在语义层面学习问题和候选答案之间的语义匹配关系,提升选取效果。不足:对候选答案中的关键信息以及问题与候选答案之间的关联关系的捕捉能力有限。

1.3关于注意力机制

??注意力机制可以抽象为针对性地提高数据中特定位置的关注度。现有注意力机制在答案选取任务中的运用大多采用问题的信息对答案进行注意力增强,从而将问题和答案的建模放在同一阶段进行,这不利于从多个维度对候选答案的关键信息进行捕获,从而导致对于多个候选答案之间差异性的捕获能力有限。

2.方法

2.1答案选取的基础模型

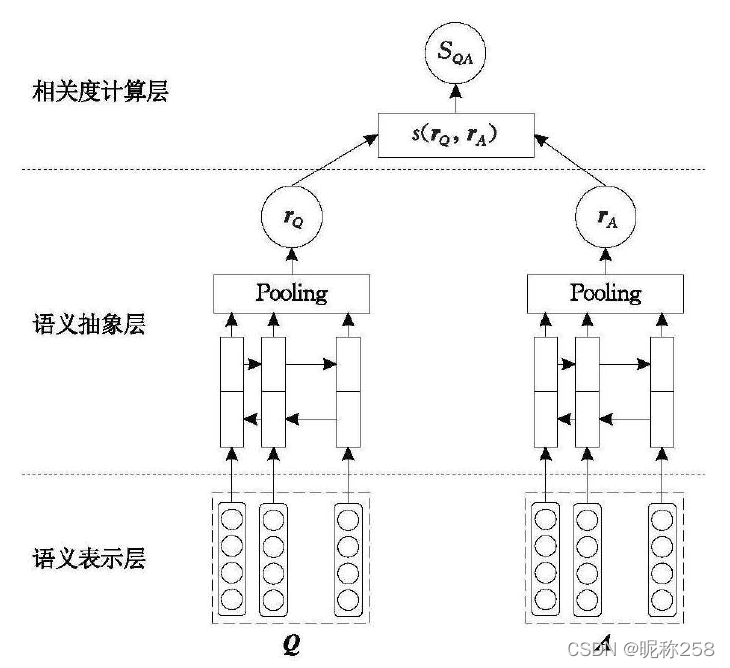

??答案选取的基础模型的主要由问题与候选答案的语义表示层、语义抽象层和相关度计算层组成。

??a.语义表示层:利用问题和候选答案所包含词语信息的词向量,分别对问题和候选答案进行语义表示;

??b.语义抽象层:釆用Bi-LSTM+Pooling对输入的问题和候选答案答案语义表示的上下文进行语义编码,分别得到问题和候选答答案的语义表示rQ和rA。

??c.相关度计算层:相关度计算层利用余弦相似度计算问题和答案的语义表示rQ和rA之间的相似度SQA作为问题和答案的相关程度的度量。

2.2基于问题语义信息注意力的信息增强模型

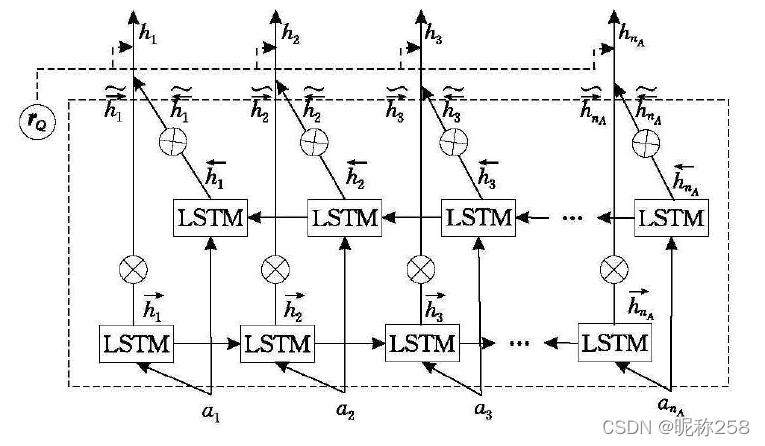

??为了解决候选答案与问题相关度权重的问题,采用注意力机制对候选答案的语义信息迸行增强,使得候选答案中与问题相关度较高的部分所占权重更高,提升候选答案与问题语义的相关性。

??基于问题语义信息注意力的信息增强主要利用问题的语义信息rQ对候选答案的LSTM输出进行注意力加权更新,强化候选答案中与问题有关的部分。在LSTM中,对每一时刻言点的正向输出与反向输出进行拼接;得到语义编码同时包含当前时刻的上文信息和下文信息。组合LSTM各个时刻的输出,得到问题的语义编码矩阵。对问题的语义編码矩阵进行压缩,得到问题的语义信息。同理答案也进行以上步骤。将以上得到的语义编码进行余弦相似度计算,将结果作为问题语义对答案语义编码的关注权重,利用权重对LSTM的每一时刻的隐藏单元进行加权更新。

2.3基于问题关键信息注意力的信息增强模型

??这一部分采用问题类型和中心词作为问题的关键信息。利用注意力机制对候选答案进行信息增强。

??对于问题类型:具体来说,在模型初始化时,为每一种问题类型分别设定一个表示向量。利用VQT对候选答案的LSTM输出进行注意力加权

更新,强化候选答案中与问题类型有关的部分。计算流程和2.2相似。

??对于中心词: 得到间题的中心词后,将中心词对应的词向量集合的向量表示作为中心词的注意力向量VQW。VQW对候选答案的正向输出和反向输出的拼接进行加权更新。具体来说,将集合VQW中的每个词向量分别和语义编码进行相似度计算,然后将其中的最大值作为问题中心词的注意力向量在语义编码上的权重表示Vi。接着利用Vi对语义编码进行加权更新。

2.4融合语义信息与问题关键信息的多阶段注意力答案选取模型

3.实验

??数据集:InsuranceQA数据集、TREC-QA数据集和Wiki-QA数据集

??评估指标:其中InsuranceQA数据集采用准确率P@1;TREC-QA数据集和Wiki-QA数据集采用MAP和MRR。

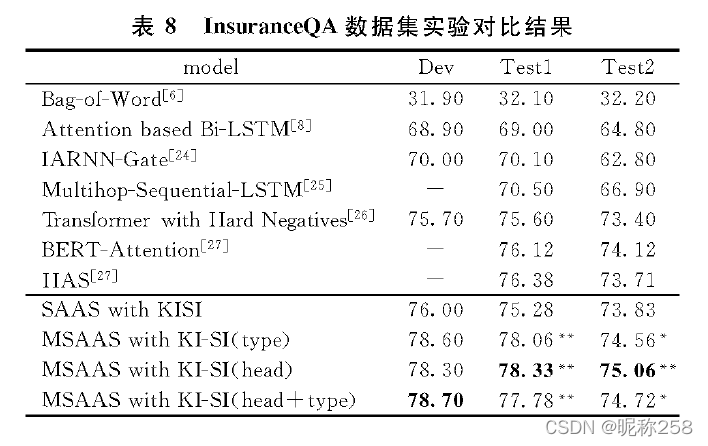

3.1 在三个数据集上和其他模型的比较

????????

??在InsuranceQA数据集中,SAAS with KISI模型就表现出了明显的优势,说明本文问题的语义信息和问题关键信息的信息增强是有效果的;在进一步将问题关键信息和问题语义信息分阶段地进行信息增强以后,MSAAS With KI-SI模型的性能也超过了基于BERT的模型,表现出了最优的性能,说明了本文构建的分阶段的信息增强方式是有效的。

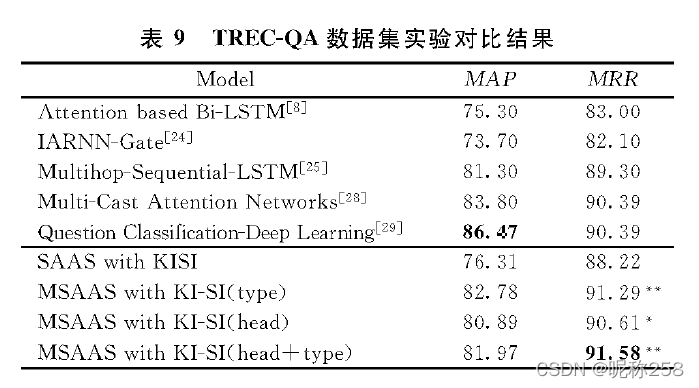

??在TREC-QA数据集中,本文提出的MSAAS with KI-SI(head+type)模型在MRR指标上取得的结果明显好于其他模型,在MAP指标上虽然没有达到最优,但也维持在比较高的性能。同时,在添加多阶段的注意力机制以后,本文MSAAS with KI-SI模型的性能都是有所提升的,也说明了本文多阶段模型的有效性。

?? ?? ??

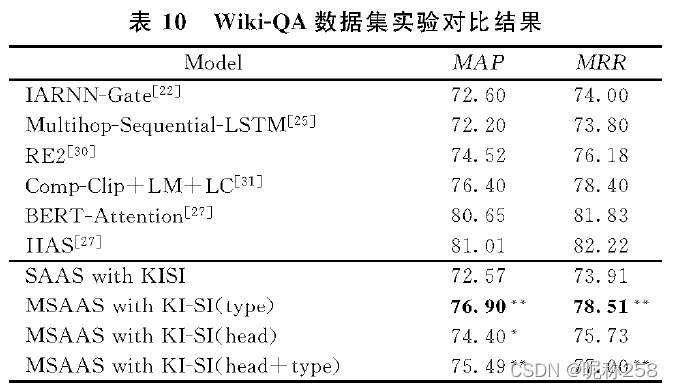

?? 在Wiki-QA数据集中,本文的MSAAS with KI-SI(head+ type)模型的性能虽不如基于BERT的BAER-Attention和HAS模型,但是也明显好于其他模型,也说明了本文模型的有效性。

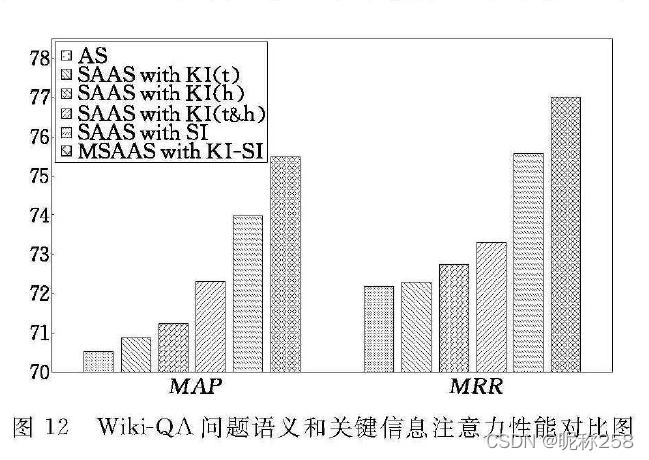

3.2问题语义和关键信息注意力性能分析

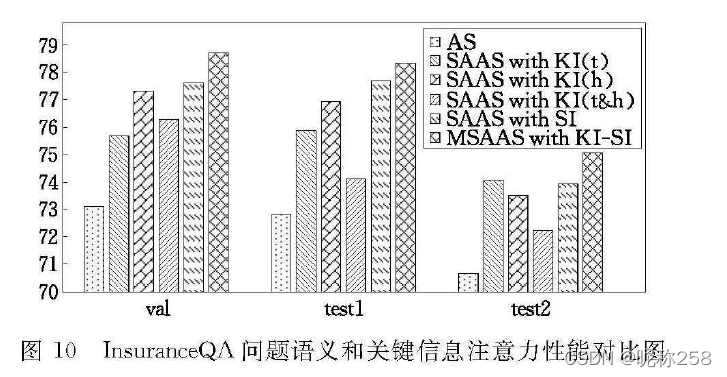

????????

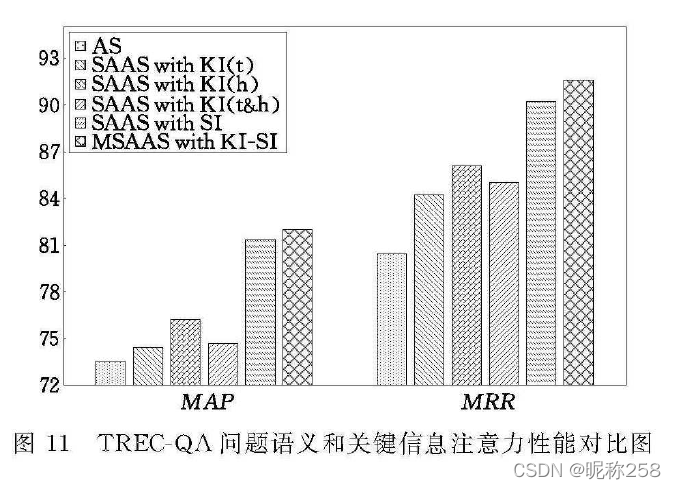

????????

?? ?? ?? ??

?? 以上三个图中,对于三个数据集,在基础模型上添加了问题语义信息和问题关键信息的注意力后,效果有了很好的提升。

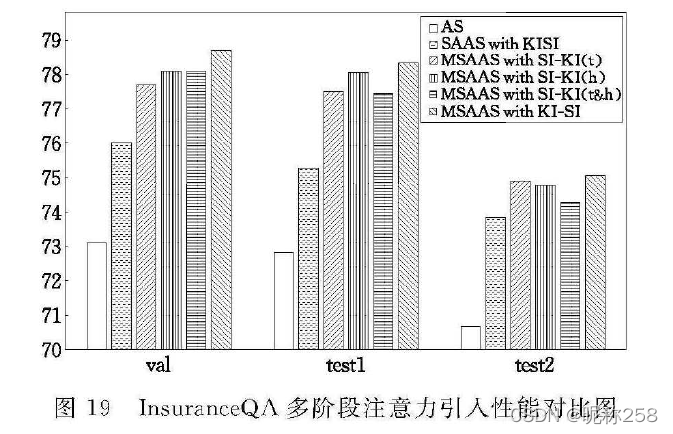

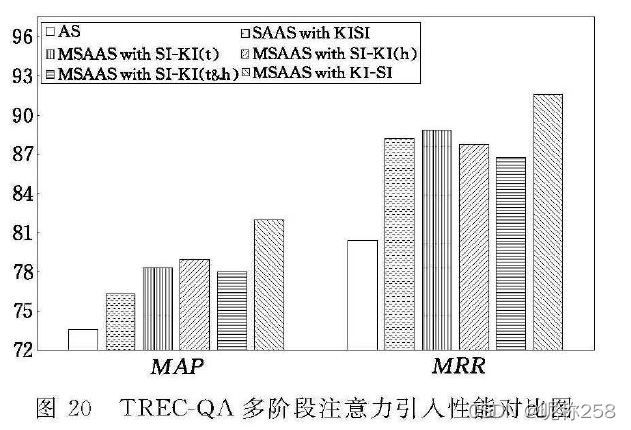

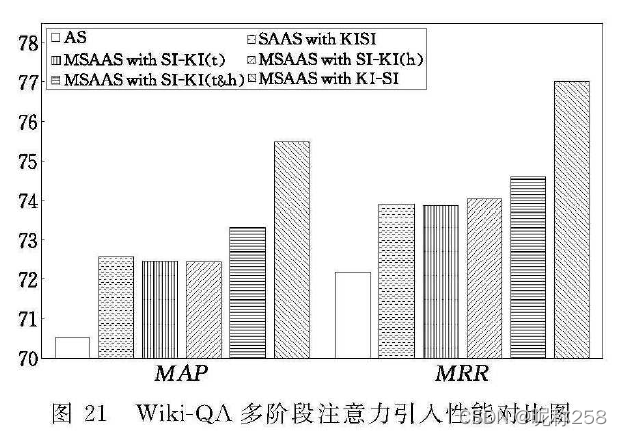

3.3多阶段注意力引人性能分析

?? ?? ??

?? ?? ?? ??

?? ?? ?? ??

??从以上三个图中可以看出,在三个数据集上相比于在同一阶段加入多种注意力(SAAS with SIKI)以及交换问题语义注意力和问题关键信息注意力的添加顺序(MSAAS with SI-KI),本文的MSAAS with KI-SI模型性能均达到了最优效果,说明了本文提出的分阶段注意力的方法的有效性。