文章题目、出处:

Step-Wise Hierarchical Alignment Network for Image-Text Matching

IJCAI 2021

文章地址:https://arxiv.org/abs/2106.06509

目的:

利用上下文信息解决语义内容相似但上下文信息略有不同的错误匹配。

结论:

基于交叉注意的融合策略将进一步促进两种模态之间的相互信息传播,从而学习更多区分上下文的特征。

背景:

从全局的角度来表示图像和文本可能不能充分利用片段级的细粒度细节,并引入一些噪声背景信息。

现有的基于细粒度交互的学习方法大多倾向于根据图像和文本之间的明显的区别来区分图像和文本对,无法区分语义内容相似但上下文信息略有不同的负面例子。

总的来说,以往的方法大多依赖于单步推理来发现视觉-语义交互,缺乏利用多层次信息定位层次细粒度相关性的能力。如,网络可以识别“人”这个实体,却很少关注“两个人”中的上下文关系“两个”。

方法:

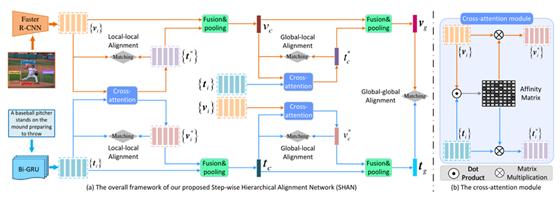

本文提出了一种逐级的层次对齐网络(SHAN) ,将图文匹配分解为多步的跨模态推理过程。具体来说,我们首先在片段级别实现局部到局部的对齐,然后在上下文中执行全局到局部和全局到全局的对齐。这种渐进匹配策略为我们的模型提供了更多互补和充分的语义线索,以理解图像和文本之间的层次关系。

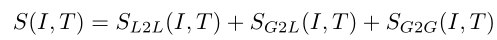

片段级的局部到局部对齐、上下文级的全局到局部对齐和上下文级的全局到全局对齐被逐步执行,以学习不同模态实例之间的视觉语义对应。

1、特征表示

图像:Fast-RCNN+FC得到区域级视觉特征

文本:bi-directional GRU+FC得到单词级文本特征,使用双向 GRU 通过从前向和后向两个方向捕获句子中的上下文信息来增强词级表示

2、分级对齐:

**片段级局部-局部对齐:**基于双向交叉注意机制,在视觉区域和文本词之间进行细粒度片段级的局部-局部匹配。

**上下文级全局-局部对齐:**通过对原始区域/词特征进行fusion和pooling操作,得到图像和文本的全局表示,并通过跨模态注意力增强图像和文本的全局表示。

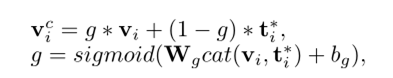

以图像为例,fusion时g是一个门值,自适应的更新融合信息的重要性。

基于生成的视觉和文本的全局上下文表示,我们通过双向交叉注意机制执行全局-局部对齐。

**上下文级全局-局部对齐:**在SHAN模型顶层,从全局角度进一步对齐图像和文本。

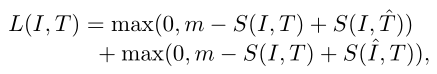

Loss:

三元排序损失:

结果:

数据集:Flickr30k and MS-COCO

其他:

交叉注意力:(以区域查询为例)每个区域特征作为一个查询,对词语进行权重分配,然后通过对词语进行加权组合,构造出一个基于区域特征的文本级别的表示。