1 介绍

Transformer网络取得了非常大的成功并具有广泛的应用。 然而由于它巨大的计算代价,使得部署到手机等端侧设备面临巨大的挑战。

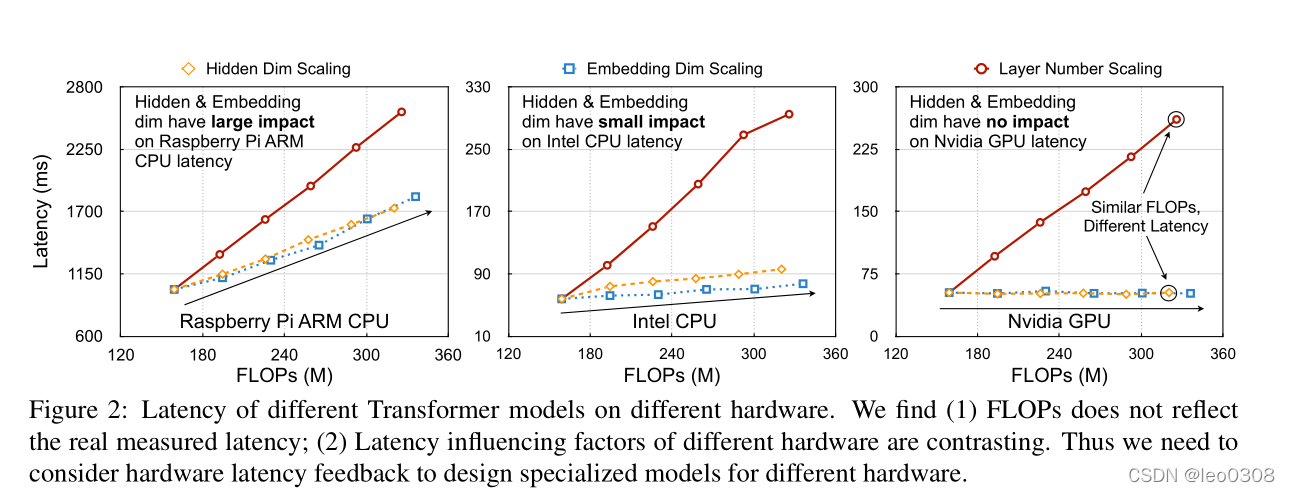

在评估Transformer网络的效率时有两个常见的陷进: 1) FLOPs不能反映真实的时延; 2)不同硬件偏好不同的Transformer结构。

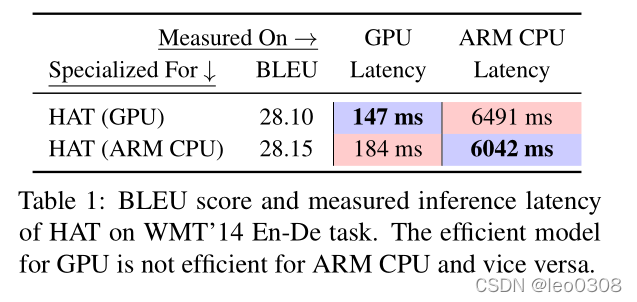

上图表明, 在一个硬件上表现好的网络在另一个硬件上表现反而不好。

上图表明: 1)FLOPs在lateny并不完全是线性关系; 2)不用硬件的影响因素不同。

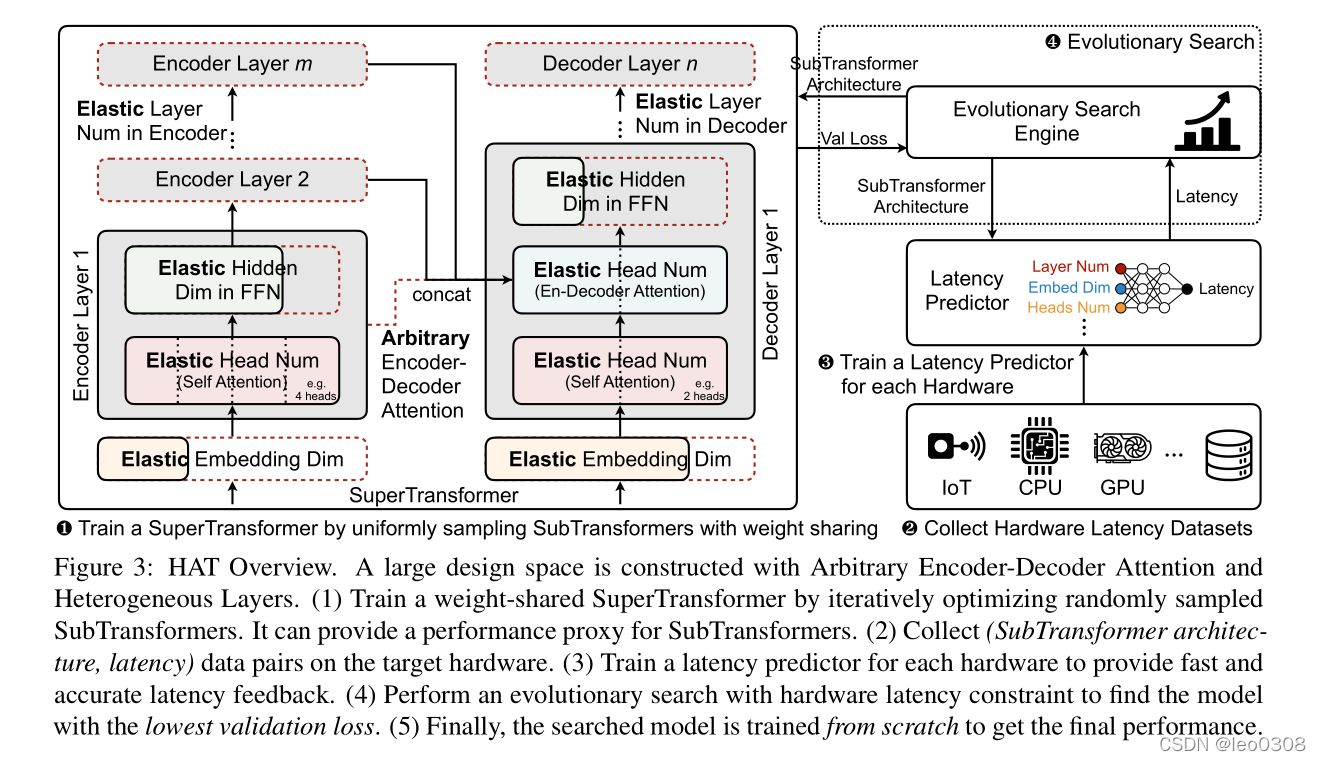

受NAS成功的启发, 我们提出了搜索硬件感知的Transformer网络, 通过把latency的反馈纳入搜索流程, 我们可以搜索针对多种硬件友好的Transformer网络。

作者首先设计了一个巨大的搜索空间, 包含任意的encoder-decoder连接。传统的Transformer网络在encoder和decoder之间存在信息瓶颈,任意的encoder-decoder允许decoder可以连接多个不同的encoder而不仅仅是最后一个从而打破了这一瓶颈。

为了在这个巨大的搜索空间上进行低成本的搜索, 作者首先训练了一个包含许多subTransformer的superTransformer网络。

最后作者通过进化搜索去寻找满足latency约束的最优的subTransformer网络。 实验结果表明, HAT天然地可以与模型压缩技术如量化、蒸馏等融合。

2 方法

方案总览:

2.1 搜索空间

核心是2点:

- decoder可以任意连接多个不同的encoder

- 不同的层结构可以是不同的, 而不是像传统的Transformer网络那样每层都是相同的进行重复

2.2 superTransformer

2.3 进化搜索

持续更新中。。。