Cascade R-CNN

做了很多实验,先挂一个讲解

知乎casade 讲解

这里记录一下不好懂的地方

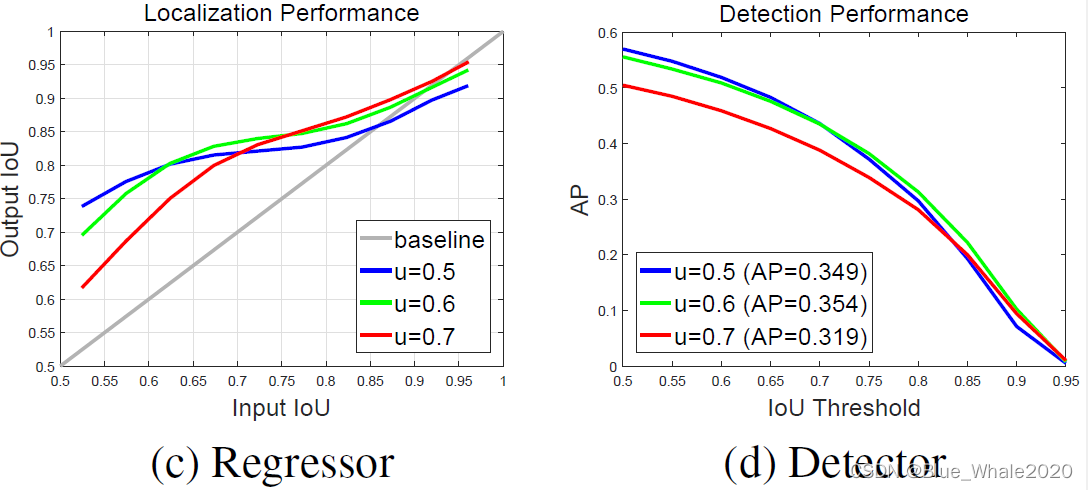

首先是这张图

这张图的蓝线绿线和红线分别代表这个模型是在,0.5、0.6、0.7下的阈值训练的.

?图的横坐标INPUT_IOU:在训练的时候,proposal经过INPUT_IOU筛选一遍,然后输入经过边界框回归调整,看iou提升了多少,这个提升后的iou就是Output_IOU也就是纵坐标。

所以c图中间有一条basline的灰线,意思就是经过regression的box总不能比输入的精度还差吧🤪🤪🤪。

文章对c图的解读为

each bounding box regressor performs best for examples of IoU close to

the threshold that the detector was trained

意思就是有颜色线纵坐标yi与灰色线纵坐标y0的差 y = yi-y0,这个差越大,就说明这个regressor的表现越好。

对(d)图的解读为

the detector of u = 0.5 outperforms the detector of u = 0.6 for low IoU examples,

这就比较好理解了

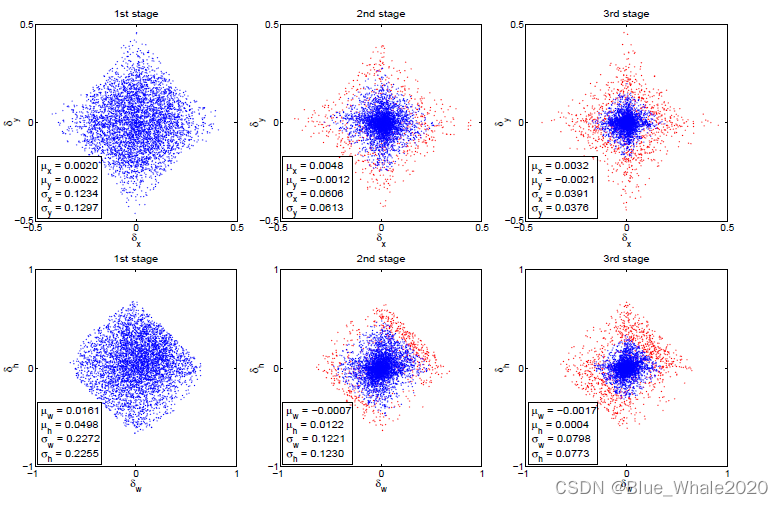

然后这张图

首先看每一个stage样本均值和样本方差,很明显的看出随着每一个stage的迭代,样本方差是在稳定的减小,说明蓝点的排列是越来越紧密集中了,就是越来越与gt接近(这个肉眼观察不是很明显,但是还是能看出来的,就是中间的蓝色区域越来越深了)

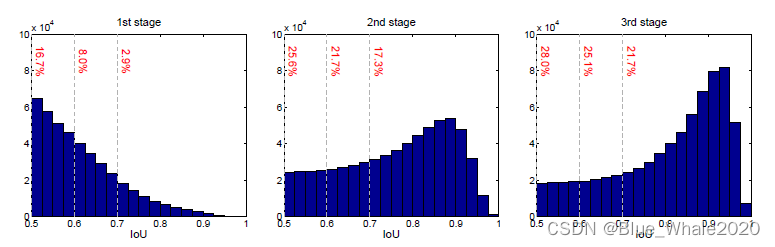

如果这时候在每一个stage都用相同的IOU,比如0.5来卡的话,就会带来很多的离群点,这个效果感觉在上图不是很明显,见下图,下图能看出随着stage的逐步迭代,IOU的”质量“越来高,如果每次都以0.5来卡,就会引入很多“错误box”,这也就是为什么原文说:

the distribution of bounding boxes changes significantly after each iteration. While the regressor is optimal for the initial distribution it can be quite suboptimal after that.

回到第二张图,红点就是提高了IOU阈值之后被巧妙的排除在外的“错误box”,这样其实也能保证每次回归的box的数量都是差不多的,尽管看起来不那么直观。🤠🤠🤠