1 简介

论文题目:Document-level Event Extraction with Efficient End-to-end Learning of Cross-event Dependencies

论文来源:NAACL 2021

论文链接:https://aclanthology.org/2021.nuse-1.4.pdf

1.1 动机

- 先前的工作没有结合事件提及抽取,来学习实体和事件共指。

- 在文档级别上,对跨事件依赖项进行建模时,效率是一个挑战。

1.2 创新

- 提出了一个文档级别的事件抽取模型,使用Deep Value Networks(DVN)捕捉跨事件依赖,同时进行事件提及抽取、事件共指和实体共指。

- 为了恰当地在文件级别上评测事件抽取,提出两种评测指标DOCTRIGGER和DOCARGUMENT DOCTRIGGER考虑触发词span、事件类型和事件共指,将相同的事件共指聚集到一起,然后计算匹配分数,使用Kuhn-Munkres algorithm约束一个真实触发词cluster对于一个预测触发词cluster。DOCARGUMENT考虑论元span,论元角色和实体共指。

2 背景知识

- 对于事件提及抽取,本篇论文的不同之处是需要提取所有名称、名词和代词论元的完整span,而先前的工作专注于抽取名称论元的head span。

- 事件共指(Event Coreference)是识别相互关联的事件提及。与实体共指类似,为每个预测的触发词 d i d_i di?预测最可能的祖先触发器 d j d_j dj?。

3 方法

主要包括两部分,使用base model独立地预测每个子任务,然后将DVN合并到base model中以高效地捕捉跨事件依赖关系。

3.1 基础模型

基础模型使用DYGIE++,主要包括下面模块:

- Encoding:使用BERT-BASE进行编码

- Span Enumeration:为了解决重叠实体,枚举全部的k-gram作为候选事件提及和实体提及,对于每个span s i s_i si?表示为head token e h e_h eh?、tail token e t e_t et?和距离编码,表示为 x i = [ e h , e t , c h , t ] x_i=[e_h,e_t,c_{h,t}] xi?=[eh?,et?,ch,t?]

- Classification:对于触发词抽取对应每个token,公式为 y i t r i g = F F N t r i g ( e i ) y_i^{trig}=FFN^{trig}(e_i) yitrig?=FFNtrig(ei?);实体抽取对应每个span,公式为 y i e n t = F F N e n t ( x i ) y_i^{ent}=FFN^{ent}(x_i) yient?=FFNent(xi?);论元抽取、事件提及和实体提及,对每对候选span进行评分,公式为 y k t = F F N t ( [ x i , x j ] ) y_k^{t}=FFN^{t}([x_i,x_j]) ykt?=FFNt([xi?,xj?])

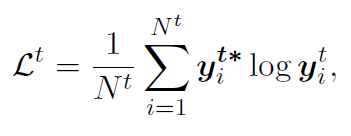

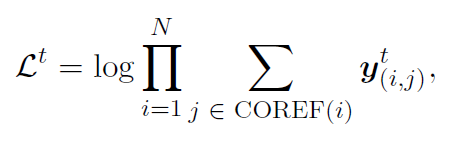

触发词抽取和论元抽取的loss为交叉熵;实体共指和事件共指的loss为优化候选span的所有正确共指span的marginal log-likelihood。公式分别如下:

|

|

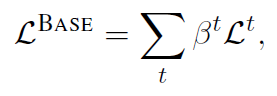

|

3.2 跨事件依赖

4 实验

数据集选择ACE 2005,实验结果如下图:

在每个子任务的效果如下图:

计算事件分析:

Value Function Approximation

人工进行错误分析,发现模型有如下错误:

- 标注歧义(Annotation ambiguity):与人工标注者存在歧义(如两个句子相同的上下文,但是相同的单词标注不同)。

- 观点的事件(Conceptual Events):该事件在未来没有发生或者可能发生。

- 欠缺的文本证明(Weak Textual Evidence):缺失知识库或者其他的新闻文章,不能正确的预测。

- 跨事件依赖(Cross-event Dependencies):跨事件依赖建模仍有改进的空间。

伦理分析:在ACE2005数据集中,男性代词有2780个,女性代词有970个,但在测试集中女性代词的F1值更高。在ACE2005数据集中,模型不受性别偏见的影响,在其他数据集上需要进一步研究。

|

|

|

|

|

|

| |