经过可乐老师的教诲之后打算focus NER方向,没想到第一篇就是复旦的

摘要和总结

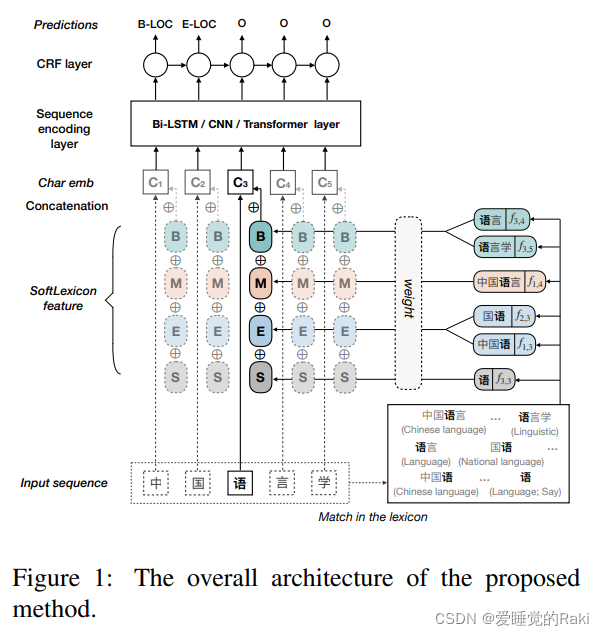

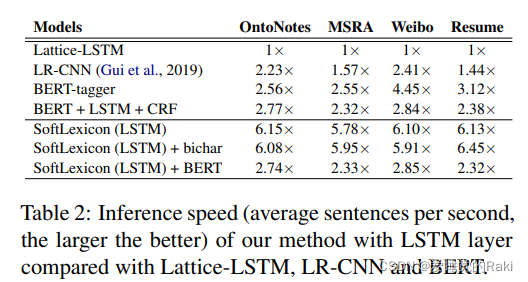

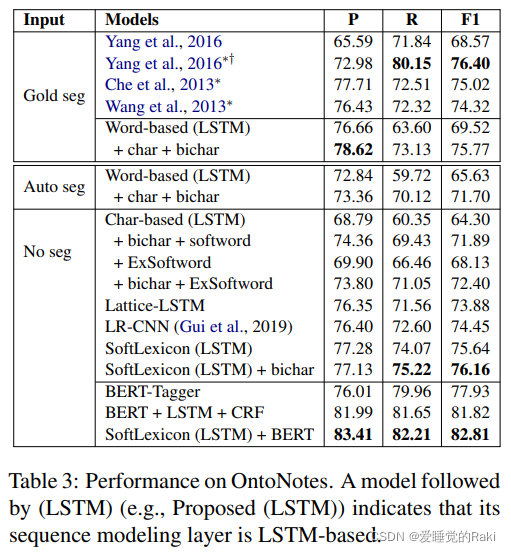

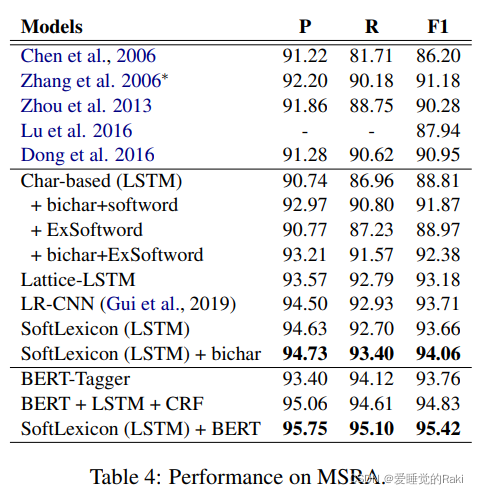

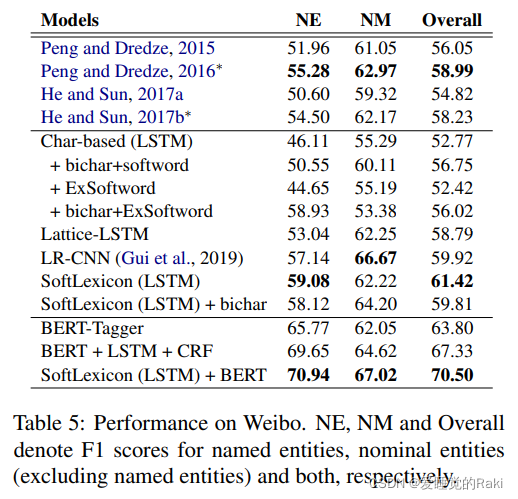

Lattice-LSTM虽然达到了sota,但是模型结构非常复杂,限制了其在工业上的应用,本文提出一个简单且高效的模型,融合了词汇信息到字编码中,避免了复杂的序列建模结构。而且对于任何神经NER模型,只需要对字表示层进行微调来引入词汇信息。

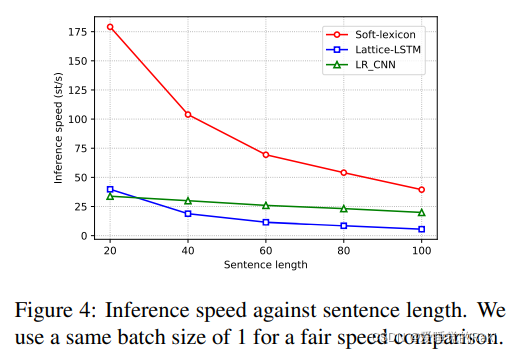

推理速度是之前sota模型的六倍,表现跟之前的sota相当

模型

embedding

char embedding

x i c = [ e c ( c i ) ; e b ( c i , c i + 1 ) ] x_i^c = [ e^c(c_i);e^b(c_i,c_{i+1})] xic?=[ec(ci?);eb(ci?,ci+1?)]

where

e

c

e^c

ec denotes the character embedding lookuptable.

where

e

b

e^b

eb denotes the bigram embedding lookup table.

Incorporating Lexicon Information

简单的char-based NER模型并没有发掘词信息,所以本文提出一种方法将词信息加入到其中

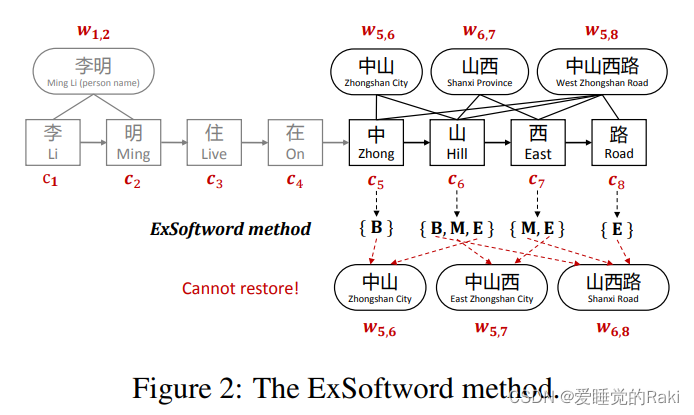

ExSoftword Feature

把每一个字和其所有可能的NER位置拼接到一起,这种方法的缺点是可能有多种组合方式而导致我们无法判断要恢复的正确结果。

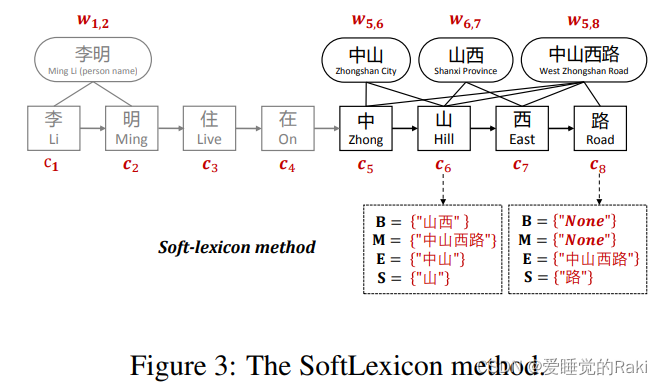

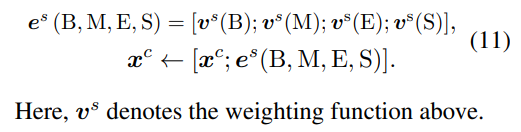

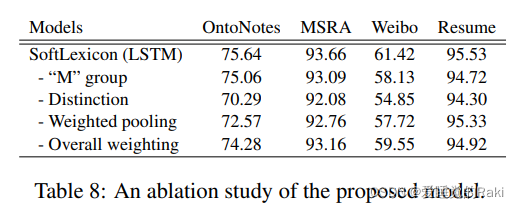

SoftLexicon

基于Exsoftword,本文提出一种新的方法来加入词汇信息,通过以下三步

-

Categorizing the matched words.

加入以这个字开头,中间,结尾,单字作为词的信息

-

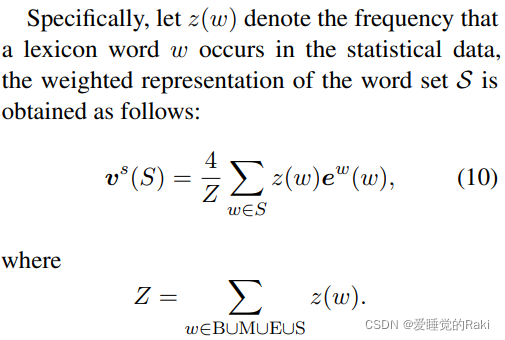

Condensing the word sets.

这里有两种方法,实验证明第一种方法并不好,我只记录第二种

这里权重乘以4而不是1,个人的理解是因为这个向量是对单独S进行计算的,而Z却是BMES四个词汇集合,所以要乘以4

-

Combining with character representation.

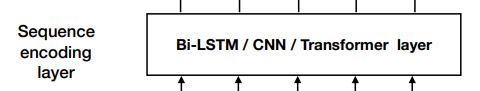

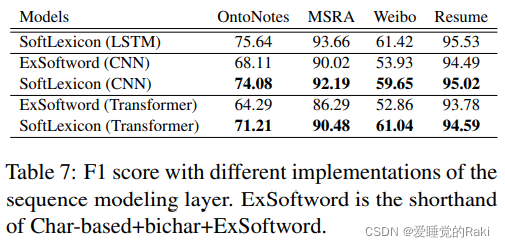

Sequence Modeling Layer

如之前的图,没啥好解释的

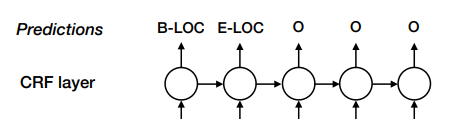

Label Inference Layer

一个CRF层,同样没什么好说的

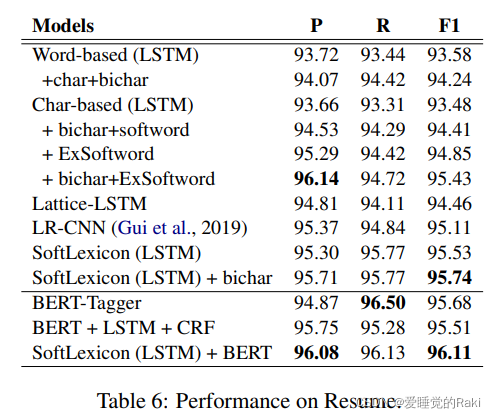

实验

推理速度大幅提升

评价

之所以这个模型能这么快,主要是因为应用了统计信息,这部分时间在训练推理之前就花掉了,所以只需要嗯跑就行了,但是这种模式是否能在工业上应用我觉得还不太好说