一、新序列的采样

Sampling

一个序列模型模拟了任意特定单词序列的概率,我们要做的就是对这个概率分布进行采样,来产生一个新的单词序列。

编程时采用numpy.random.choice()进行采样。

如何判定句子到了末尾呢?当遇到< EOS >时会提示模型句子到了末尾,或者在采样过程中设置最大时间步。

Character-level language model

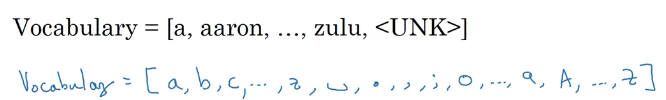

之前提到的都是词汇级别的语言模型,其实也可以是字符级别的语言模型。

比如 Cat eats. 这样的句子,在词汇级别的模型中,

y

<

1

>

y^{<1>}

y<1>是Cat,

y

<

2

>

y^{<2>}

y<2>是eats;而在字符级别的模型中,

y

<

1

>

y^{<1>}

y<1>是C,

y

<

2

>

y^{<2>}

y<2>是a,

y

<

4

>

y^{<4>}

y<4>是空格符。

基于字符的语言模型优缺点也很明显:优点就是不用担心出现位置单词标识,比如基于字符的语言模型允许出现 mau 这样的未知序列,而在基于词汇的语言模型中只能将其标识为< UKN >。基于字符的语言模型最后会得到太多太长的序列,所以在捕获句子的依赖关系不如基于词汇的模型那样可以捕获长句子关系,训练起来的计算成本也会比较昂贵。

现在的趋势就是,优先采用基于词汇的语言模型,但是随着计算机性能越来越好,会有更多应用在一些情况下开始用基于字符的模型。

下面是两个例子,分别用新闻和莎士比亚文章训练出来的模型来生成一段全新的文本:

到这里,已经介绍了RNN的基础结构,以及如何建立一个语言模型并使用它对训练出的语言模型进行采样。

二、RNN的梯度消失

看上面两句话:

cat ... was

cats ... were

当RNN网络够深时,我们到目前认识的简单RNN模型很难反向传播回去,会出现梯度消失的情况,因此很难影响到前面层的参数。

在上面的例子中,cat(s)和was(were)则可能相隔很远,所以cat这个时间步会很难决定到后面用was还是were,同时反向传播也很难传回到cat那里。后面将会讲解如何处理梯度消失,否则RNN不擅长处理长期依赖问题(long-range dependency)。

提到梯度消失,就回想到之前学过的梯度爆炸:随着网络加深,梯度可能呈指数型上升,这也是训练RNN时的首要问题,因为可能导致参数变得巨大而崩溃。当见到NaN(Not a Number)时,就可能出现了梯度爆炸,解决梯度爆炸的一种方式是梯度裁剪(gradient clipping),即观察梯度向量,当它大于某个阈值时,缩放梯度向量,保证其不会过大。

综上所述,其实梯度爆炸相比于梯度消失更好解决,通常采用梯度裁剪的方式。在后面的课程中,会介绍GRU(门控循环单元,Gated Recurrent Unit)单元来解决梯度消失的问题,从而帮助神经网络网络捕获更长的长期依赖。