4.1? 模型评估

模型指标

- 损失的值是衡量模型质量很好的指标,但模型的质量往往由多个指标来衡量;

- 其他指标:

- 具体的模型指标:分类的准确率,检测的mAP等;

- 具体的商业指标:推理/响应速度;

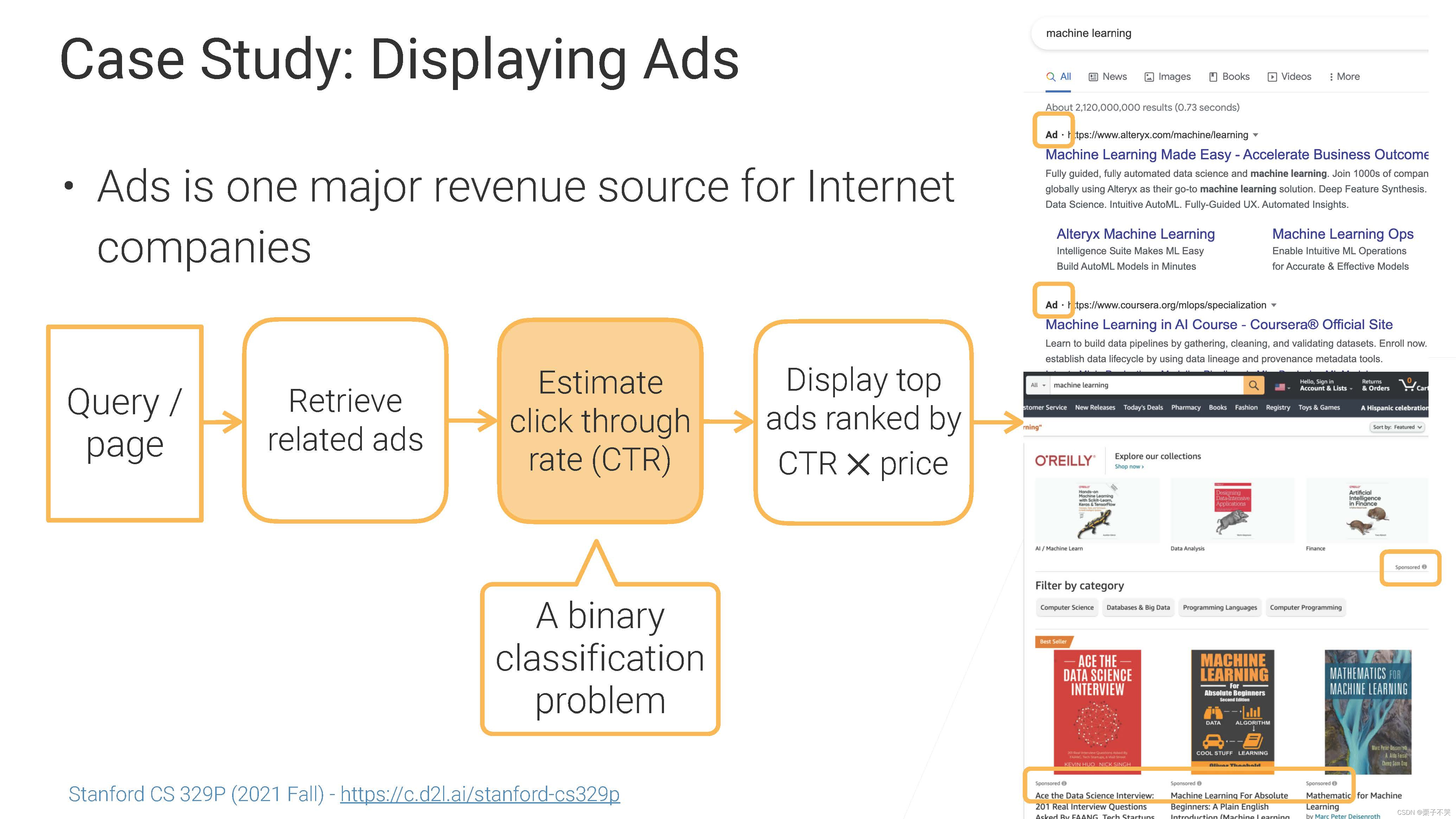

查询/页面 ==> 检索相关的广告 ==> 估计广告的点击率(CTR) ==> 展示CTR×price最高的广告

预测广告的点击率,即一个二分类问题;

正例(点击)往往较少,负例(不点击)往往较多,响应的数据量要符合实际。

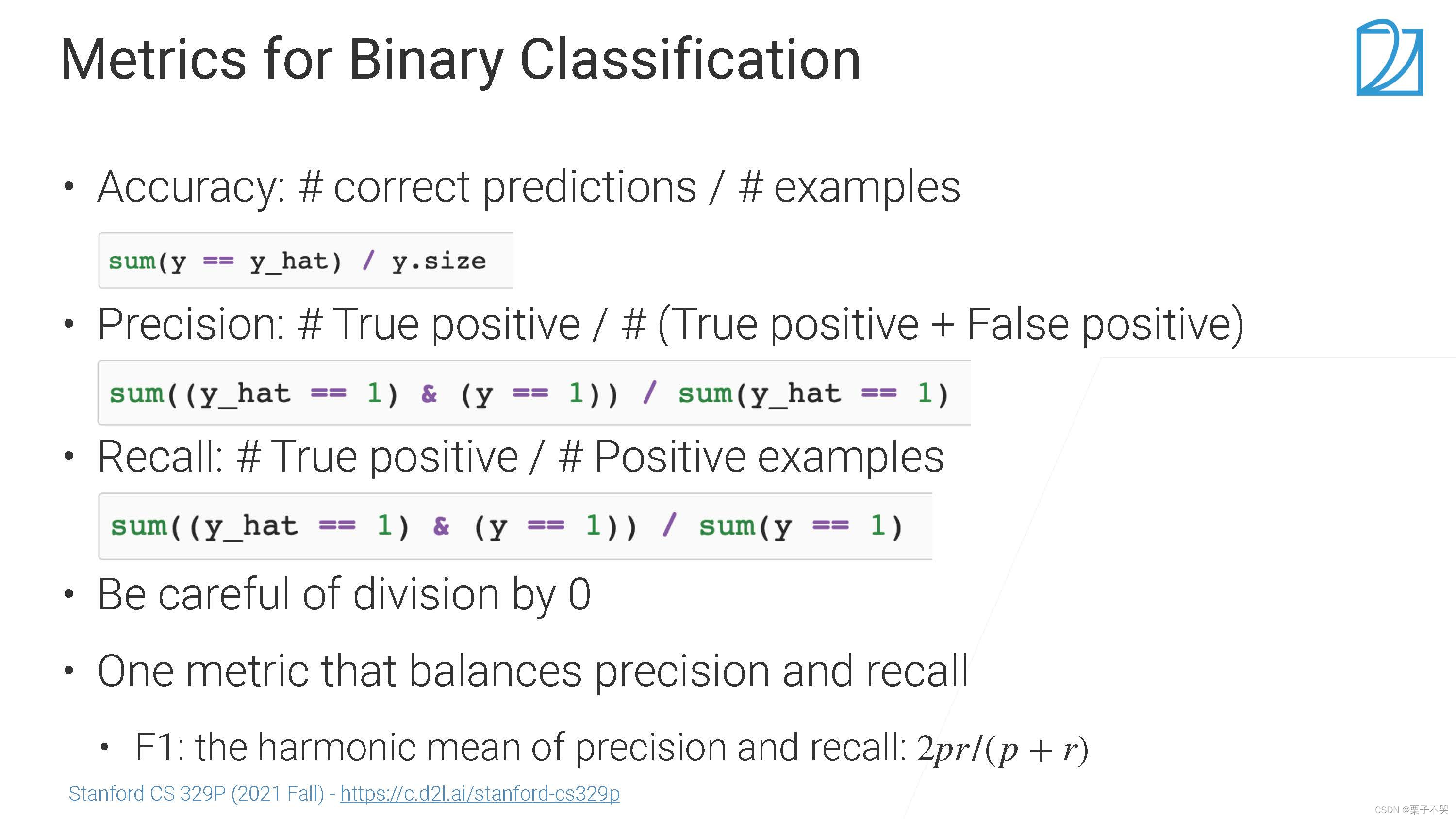

- Accuracy 准确率:预测正确的占总的(对于不平衡问题,往往更关注对正类的预测是否正确,更关注每一个类的精度和召回率);

- Precision 精度:对于某个具体的类

预测对了多少个(预测为类

且该类真的为类

)?/ 把多少个样本预测成类

;

- Recall 召回率:预测为类

而且它真的是类

?/ 样本中有多少是类

;

- F1:平衡精度和召回。

关心模型是不是真的能把这两个类区分开来;

对于一个样本,预测值为,阈值

(一般情况下为0.5,即正负样本平衡时),大于阈值为正类,小于阈值为负类,若正负样本不平衡,该怎么办?

实际生产过程中,会根据很多东西来选择,如就想把特别置信的选出来(关心广告正类预测的精度怎么样),将

设置的比较大(只有预测值大于0.9时,认为是正类,此时精度会高,但召回率会低)。

在调整时,会做ROC曲线:

- x轴,分母=有多少个负例的样本(没有点击的样本个数),分子=预测为正类,但实际是负类;

- y轴,正类的召回。

ROC:每次取不同的值,做正类和负类的判断 ==> 得到曲线,每个点表示不同的

,该曲线可以表示一种精度和召回之间的权衡。

AUC:曲线下面的面积(最大值为1,最小值为0);

上图右半部分解释如下:

- AUC=1,完全可以区分正类和负类;

- AUC=0.7,正负类部分耦合;

- AUC=0.5,正负类完全耦合 ≈ 随机预测;

- AUC=0,正负类预测相反。

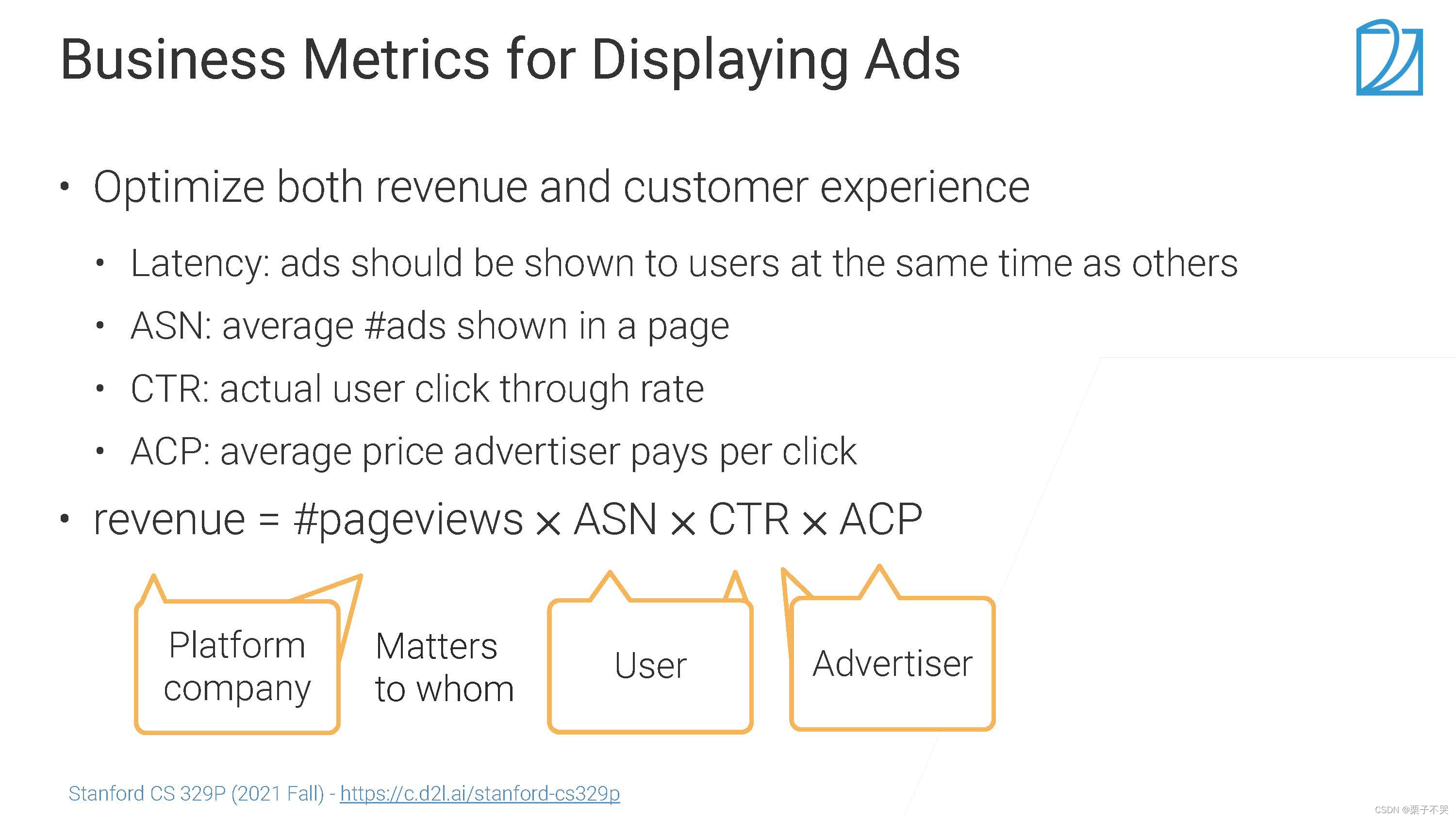

优化收入和用户体验;

- Latency: 延迟,响应速度;

- ASN:平均每一页展现多少广告;

- CTR:真实的用户点击率;

- ACP:平均每次点击广告主给的钱。

模型上线并不能一次性满足所有指标,通常要有一定的权衡。

- 模型最关注的指标AUC;

- 一个新的模型,评估时AUC增加,但商业指标不一定增加;

- 部署模型用真实的数据来评估模型。?

4.2? 过拟合和欠拟合

4.3? 模型验证

references

4.1 模型评估【斯坦福21秋季:实用机器学习中文版】_哔哩哔哩_bilibili