这篇论文不是讲场景图的,但它跟场景图很相关。查了一下这篇论文的领域应该是HOI Detection,就是人类与物体的交互检测,后面的实验做的是image retrieval的结果。

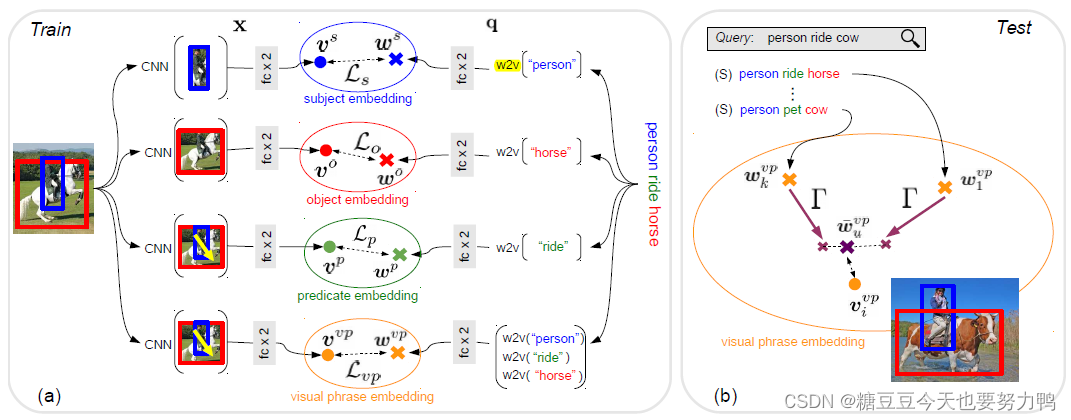

训练:

1.目标检测

2.提取主语s,宾语o,谓语p,三元组vp的视觉嵌入特征

主语和宾语的视觉特征就是目标检测器最后一层的输出

谓语的视觉特征是主宾对的空间特征

三元组的特征是主语宾语的视觉特征+它们的空间坐标特征,即前两者的融合

现在得到了上述的四种视觉特征,通过两层fc得到四种视觉嵌入特征。注意:四种嵌入函数是不同的。

视觉嵌入特征分别表示为vs,vo,vp,vvp

3.提取主语s,宾语o,谓语p,三元组vp的语言嵌入特征

主谓宾这三者的初始语言特征就是word2vec的向量,三元组的则是把主谓宾的word2vec向量cat在一起

现在得到了上述的四种语言特征,同样通过两次fc得到四种语言嵌入特征。这四种嵌入函数也是不同的。

语言嵌入特征分别表示为ws,wo,wvp,wp

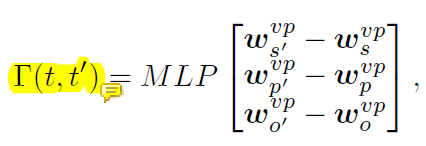

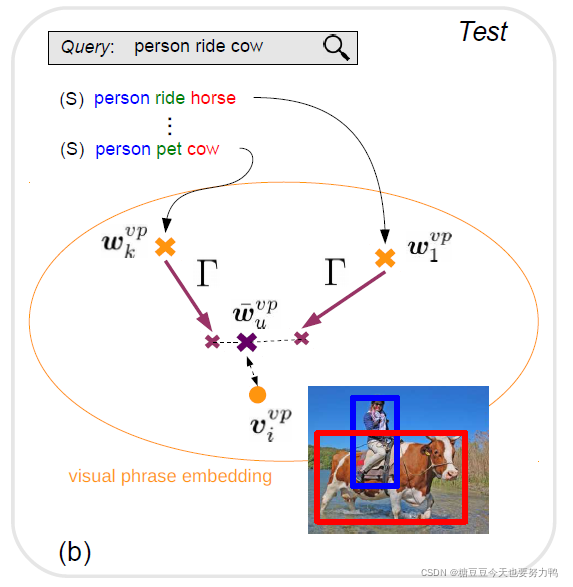

4.训练类比转移修正函数Γ

给定为原三元组(s,p,o),表示为t,t’为目标三元组(s’,p’,o’)

Γ是将wvpt 转换为wvpt’ 的修正,这里注意都是针对word的

Γ的计算公式如下:

这里的主谓宾三者都是在vp空间的特征

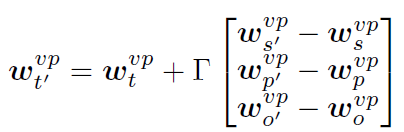

具体的转换公式如下:

如果t和t’的主语和谓语一样,那么Γ里面的就是[0 0 wo’-wo]

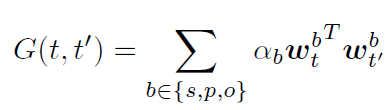

5.计算每个备选三元组的权重,即wvpu

备选三元组是与目标三元组相似的三元组,例如主语都是person。

计算权重的公式如下:

t是原三元组,t’是目标三元组

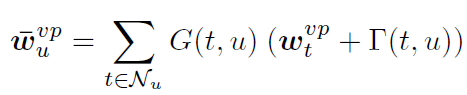

目标三元组的语言特征如下式所示:

t是源三元组,u是目标三元组,Nu是相似的源三元组

6.损失函数

首先通过优化 Ljoint来学习投影函数的参数,然后激活类比损失LΓ。我感觉这里论文的意思应该是先通过Ljoint学习嵌入特征表示,然后再通过LΓ学Γ的参数

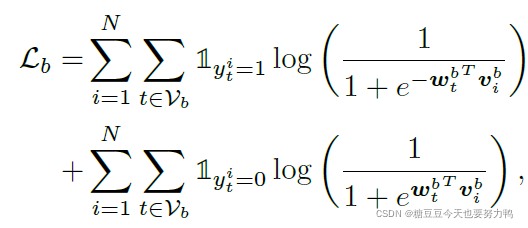

损失函数是让视觉嵌入特征和语言嵌入特征尽可能相似

Ljoint= Ls+ Lo+LP+Lvp

每一个分支的loss都如下式计算:

Lr:源三元组的wvpu和目标三元组视觉嵌入特征的loss

论文中没有给出具体的计算公式,我觉得应该是只有vp这个域的loss

测试:

给出一个query,模型自动找出与这个query相似的三元组,每一个三元组计算wvp,再计算它们的权重,最终得到wvpu,然后计算图像的视觉嵌入特征vvp,将二者求相似性分数,最相似的图像就是搜索结果了。

-------------------------------------一些碎碎念-----------------------------------------

马上就要过年了。

我给自己定了个四篇论文的计划(年前)。

我在想桃子。