论文链接:论文

代码链接:代码(Theano版本,论文作者给的源码)、代码(pytorch版本)、代码(tensorflow版本)

基本思想:

????????<Show,Attend and Tell>这篇论文,进行的是image caption这一经典的任务。相较于传统的encoder-decoder框架而言,作者认为不同的word应该对应到不同的图像区域,即在传统的框架基础上加入attention机制,论文的网络结构如下:

分析这个网络结构:

Input:image? ?#size(224,224,3)

Encoder:使用VGG16网络结构对image进行特征提取,经过特征提取之后,得到(14,14,512)的feature map

Decoder:利用Attention机制得到显著的图像区域特征,而后使用Lstm进行解码,得到对应的image caption

?论文笔记:

借助源码来理解论文实现思路:

(1)、经过Encoder模块:

????????我们可以得到(14,14,512)的feature map,就是论文中提到的

????????????????????????

其中,L=14*14=196,相当于将feature map的每一个像素对应的512维向量作为ai。

(2)、接下来是attention机制了:

????????在步骤(1)中,我们得到了feature map中的每个像素对应的向量,feature map中的每个点都代表原图的某个区域。我们想对原图中的某个区域有突出关注,对feature map中的每个像素点分配权重:

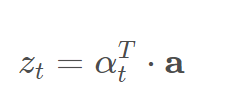

?????????????????????????????????????????????????????????????

其中,αt的维度是196,代表每个像素点分配对应的权重。?

权重α的值由当前时刻图像特征a和前一时刻的状态ht决定,即论文中的:

??????????????????????????????????????????????

?在初始时刻,α完全由图像特征来决定,tensorflow版本的代码如下(该代码位于tensorflow版本代码model.py的77~79行):

其余时刻的et由上一时刻的状态h和图像特征a共同决定,计算如下:

将这一逻辑用框图表示为:

论文提出了两种attention(hard attention 和soft attention),下面将分别介绍:

(3)、hard attention

? ? ? ? hard attention是希望在每一个时间点的feature map中,仅有一点进行响应,即仅有一点的值为1,其余各点皆为0,为"Stochastic"算法,此时zt的计算方式为:

??????????????????? ? ? ??

?由于hard attention不连续,所以并不可导,论文采用的方法是进行多次伯努利采样,而后最大化这个下界:

????????? ? ? ? ?

即将在特征为a的情况下取得word y的概率最大化,式中s为采样得到的点。

? ? ? ? 最大化这个式子,我们可以得到:

????????在图像特征为a的条件下,最有概率采样得到的点s( p(s|a) ),最能代表单词y(? p(y|s,a) )。

? ? ? ? 具体的优化方法请看论文详述。

(4)、soft attention

????????这里的soft attention就是经典的全图加权和,网上也有许多大佬的解读,附上我认为比较好的一篇,其中的loss值处处可导,可直接用网络实现。soft attention

???????总结:

????????这篇论文中的许多思想值得我们借鉴,个人目前阶段没有在lstm解码部分进行详细阅读,但其与常规的解码思路相似,不再赘述。自己把公式从头到尾推一遍也有了许多的启发,作为刚了解这一方面的萌新,我要学习的还有很多东西,这段时间应该都会看attention方面的文章,尽量每日一篇笔记吧。才疏学浅,欢迎各位大佬批评指正!