题目

快速多实例多标签学习(Fast Multi-Instance Multi-Label Learning)

Bib

@article{Huang:2018:26142627,

title={Fast multi-instance multi-label learning},

author={Sheng Jun Huang and Wei Gao and Zhi Hua Zhou},

journal={{IEEE} transactions on pattern analysis and machine intelligence},

volume={41},

pages={2614--2627},

year={2018},

publisher={IEEE}

摘要

在许多现实世界的任务中,特别是那些涉及具有复杂语义的数据对象(如图像和文本)的任务中,一个对象可以由多个实例表示,同时与多个标签相关联。此类任务可以表述为多实例多标签学习 (MIML) 问题,并且在过去几年中得到了广泛的研究。已经发现现有的 MIML 方法在许多应用中很有用;但是,它们中的大多数只能处理中等大小的数据。

为了有效地处理大数据集,本文提出了 MIMLfast 方法,该方法首先构建了一个由所有标签共享的低维子空间,然后训练标签特定的线性模型,通过随机梯度下降优化近似排序损失。尽管MIML问题很复杂,但MIMLfast能够通过利用具有共享空间的标签关系并发现复杂标签的子概念来实现出色的性能。实验表明,MIMLfast的性能与最先进的技术具有很高的竞争力,而其时间成本要低得多。此外,我们的方法能够为每个标签识别最具代表性的实例,从而提供了解输入模式和输出标签语义之间关系的机会。

方法概述

背景

现有方法复杂度高、效率低。这些方法通常很耗时,并且不能处理大规模数据

相关概念

利用实例和标签之间的对应关系,我们的方法可以基于实例级预测自然地识别每个标签的最具代表性的实例。

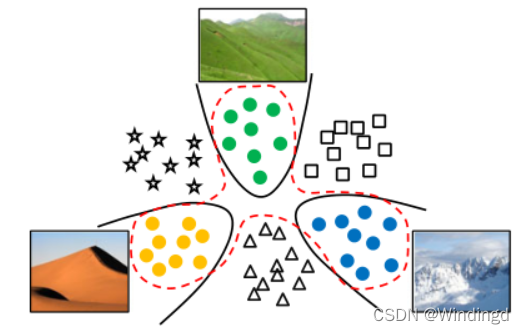

带有子概念的复杂标签:具有不同内容的示例可能会被分配相同的标签(雪山、沙山、树山)

步骤

具体而言,

(1)为了利用多个标签之间的关系,我们首先从原始特征中学习所有标签的共享空间,

(2)然后从共享空间中训练标签特定的线性模型。

为了识别表示特定标签的包的关键实例,我们在实例级别上训练分类模型,然后选择具有最大预测的实例作为关键实例。为了提高学习效率,我们采用随机梯度下降(SGD)来优化近似排名损失。在SGD的每个步骤中,MIMLfast随机抽样一个由袋子,袋子的相关标签和不相关标签组成的三元组,并且如果违反这样的命令,则优化模型以在不相关标签之前对相关标签进行排序。

一、预测模型

最简单的方法是通过为每个标签独立训练一个模型,将其退化为一系列单标签问题。在我们的方法中,我们将模型制定为两个组件的组合。

(1)第一个组件学习从原始特征空间到所有标签共享的低维空间的线性映射。

(2)第二个组件基于共享空间学习标签特定模型。这两个组件进行了交互优化,以适应所有标签的训练示例。

两级模型:

我们将标签

l

l

l上的分类模型定义为:

共享空间 (

W

0

W_0

W0?):将原始特征向量映射到共享空间

w

0

\textbf{w}_0

w0?:标签

l

l

l的

m

m

m维的权重向量

复杂标签:

很难训练单个模型(对应于红色虚线)将具有如此多样内容的图像分类到同一类别中。

所以为一个标签学习多个模型,一个用于子概念,并自动决定一个示例属于哪个子概念。

每个子概念的模型(对应于黑线)。将模型重新定义为:(选择最大预测值的子概念)

包预测:

一个包在标签

l

l

l 上的预测可以定义为这个包中所有实例的预测的最大值:

(将具有最大预测的实例称为标签 l 上 X 的关键实例)

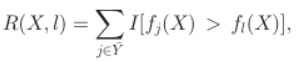

二、标签排名

每一个标签都有一个误差,排名越低,排名误差越大。

为了将相关标签排在不相关标签之前,只需要最小化训练数据上的排名损失,

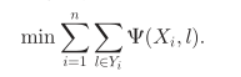

最终目标函数:

三、采用随机梯度下降(SGD)来最小化排名误差

在SGD的每个步骤中,MIMLfast随机抽样一个由袋子,袋子的相关标签和不相关标签组成的三元组

四、算法

(1)首先,所有标签

y

y

y 和所有子概念

k

k

k 的

W

0

W_0

W0?和

w

y

k

\textbf{w}^k_y

wyk? 的每一列都随机初始化,均值为 0,标准差为

1

/

d

1/\sqrt{d}

1/d?

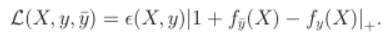

(2)然后在 SGD 的每次迭代中,随机抽样

L

(

X

,

y

,

y

?

)

\mathcal{L}(\textbf{X},y,y^-)

L(X,y,y?),并识别出它们对应的关键实例和子概念

(3)执行梯度下降以更新三个参数:

W

0

W_0

W0?、

w

y

k

\textbf{w}^k_y

wyk?、

w

y

?

k

?

\textbf{w}^{k^-}_{y^-}

wy?k??,并归一化

(4)重复直到达到停止准则:从训练数据中抽取一小部分来形成验证集,如果验证集上的排名损失不再减少,则停止训练

实验

6 moderate-sized datasets

Scene 、Reuters :图像的场景分类

Letter Carroll 、Letter Frost: 字母识别

Bird Song:鸟类种类

MSRC v2 :图像数据集

2 large datasets

Corel5K、MSRA:图像数据集