Abstract & Introduction & Related Work

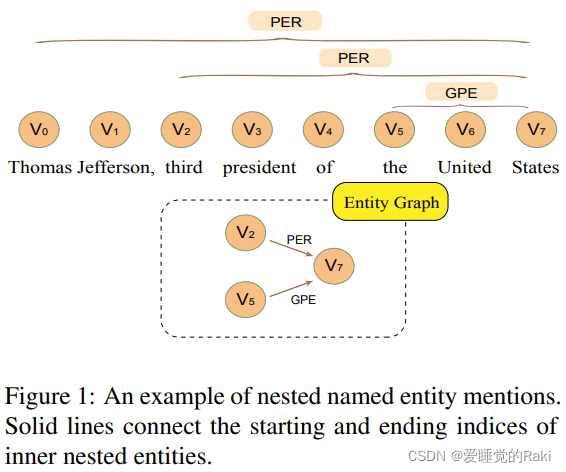

- 研究任务

嵌套NER - 已有方法和相关工作

- 面临挑战

- 已有的模型只考虑从最内层到外层的信息的单向传递

- 创新思路

- 双向考虑了内外层子图之间的信息交互

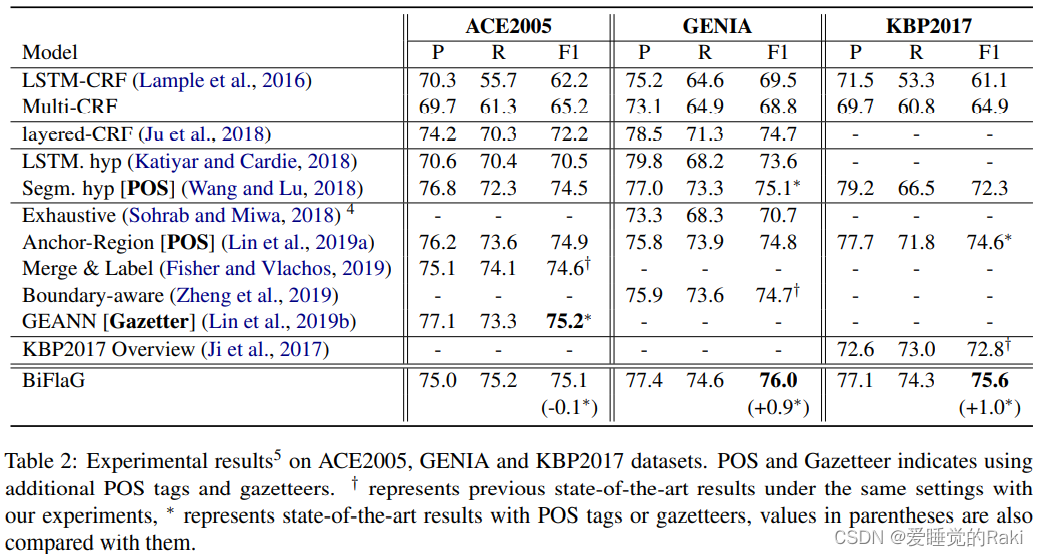

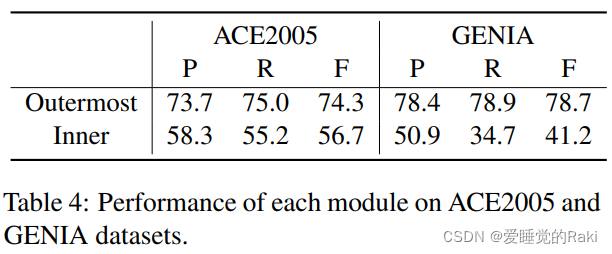

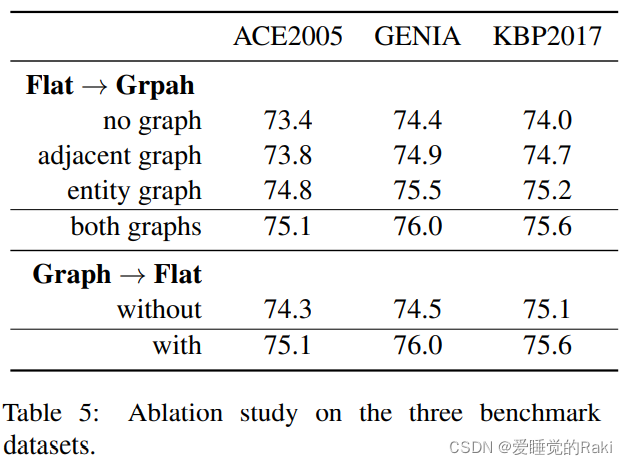

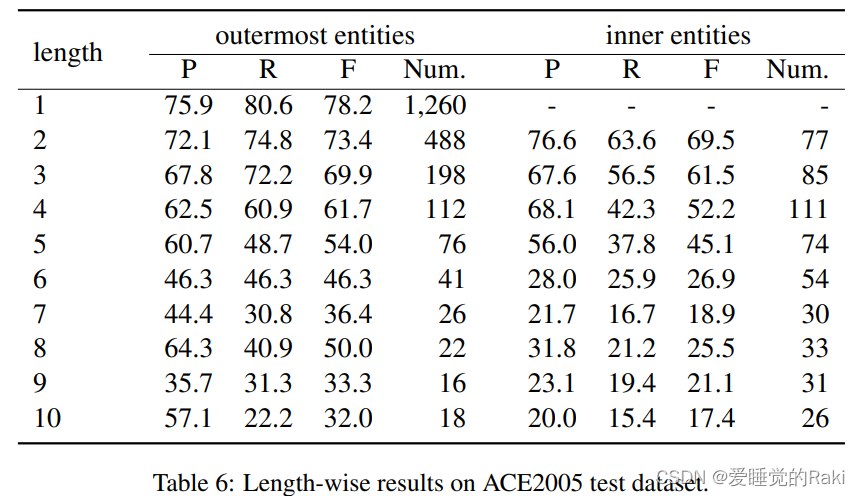

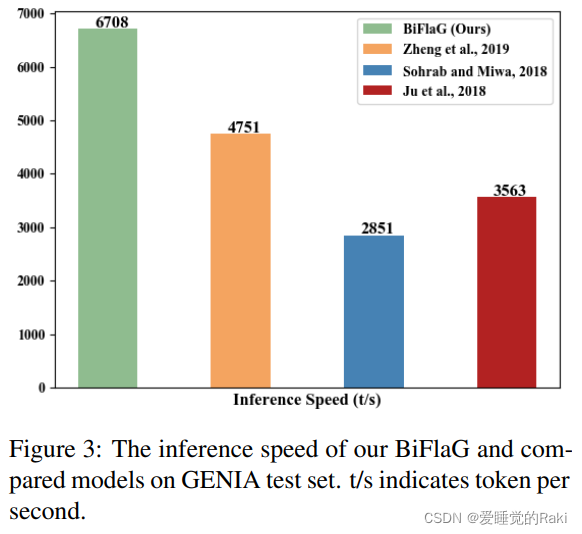

- 实验结论

sota

Model

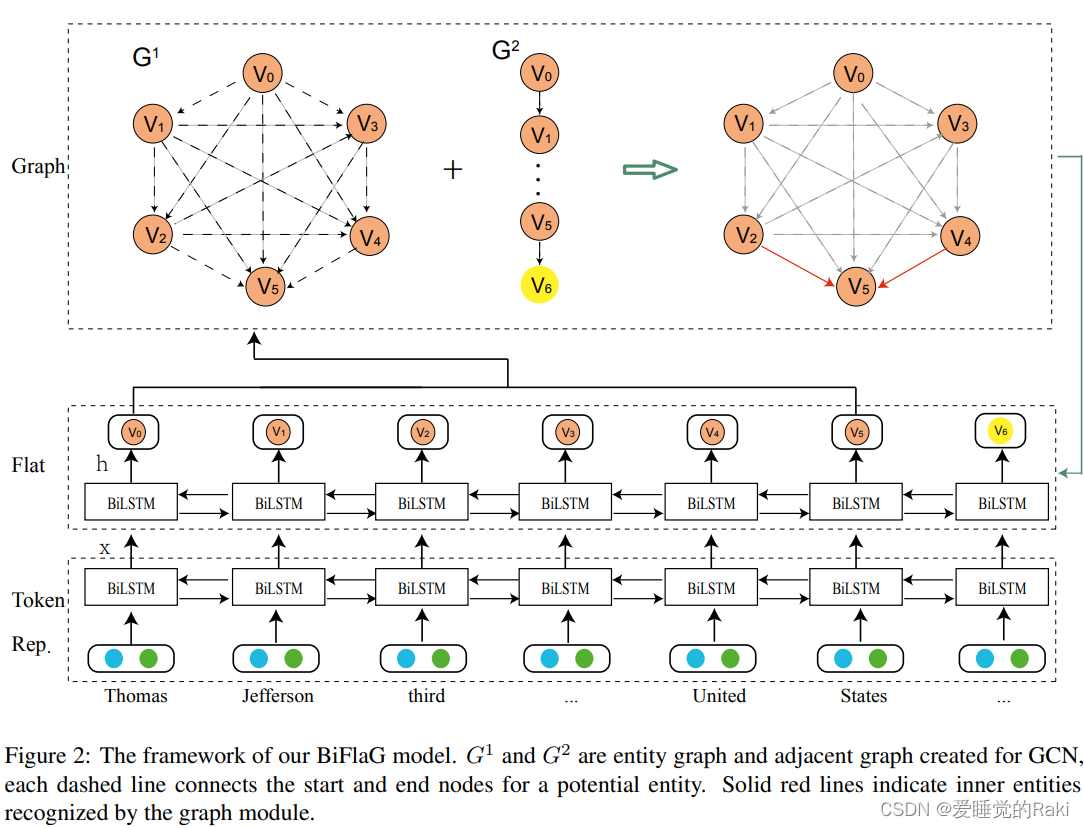

首先给出模型总览图

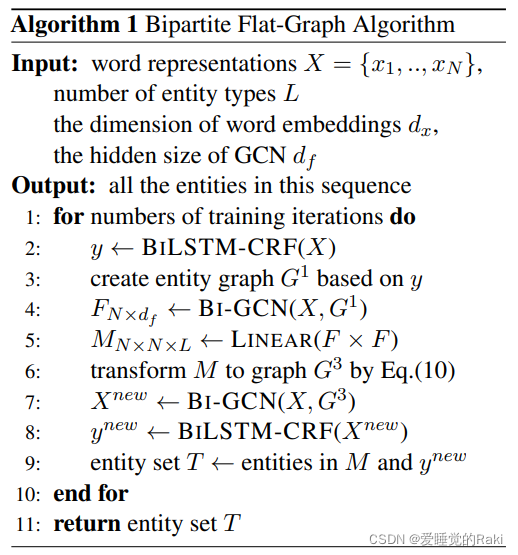

外层使用BiLSTM + CRF来抽取平面实体,并将抽取出来的特征构成一个图 G 1 G^1 G1

对于图模块,我们使用GCN,它在潜在实体的起点和终点节点之间迭代传播信息以学习内部实体。最后,从图模块学到的表征被进一步反馈到平面模块,以获得更好的最外层预测。

Token Representation

首先把word embedding和 char embedding concat起来,然后丢到一个BiLSTM里面得到序列信息,把输出的新特征丢到接下来的模块里面

Flat NER Module

一个BiLSTM + CRF 没什么好说的

Graph Module

Graph Construction

图一就是一个团

图二就是…从node0到nodeN的一个有向图

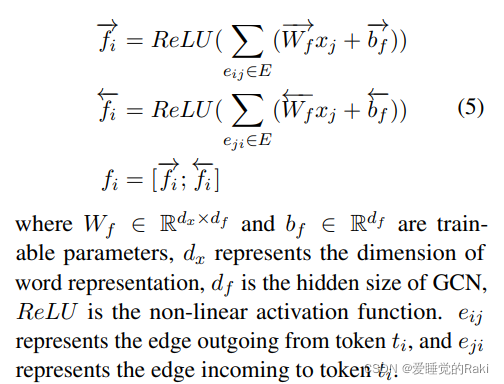

Bi-GCN

给出一个图G, 和它的节点,图特征由 Bi-GCN来学习

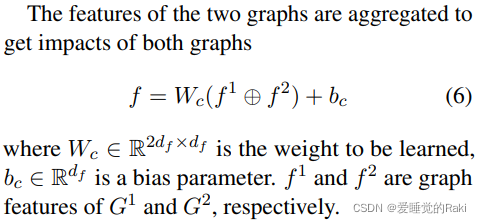

通过下面公式得到两个图的汇聚特征

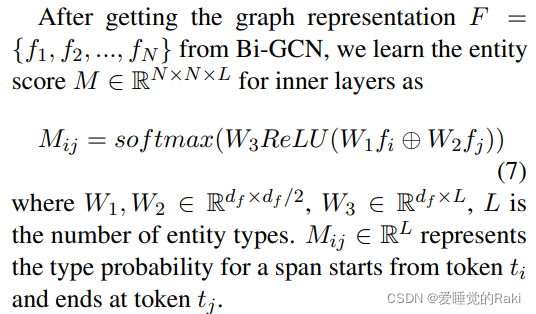

在得到每个节点的特征后,通过一个两层的fc,最后经过一个softmax来得到实体得分

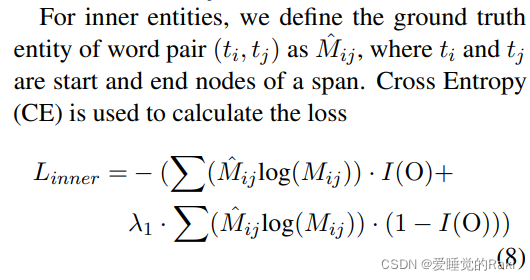

对于内部实体,使用交叉熵来计算损失

BiFlaG Training

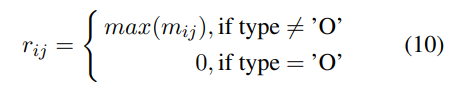

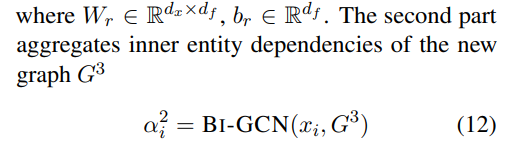

公式(7)中的实体得分M带有句子中每个词对的类型概率。为了进一步考虑从内部实体到外部实体的信息传播,我们使用 B i ? G C N Bi-GCN Bi?GCN 从实体得分M中为平面模块生成新的表示。词对 ( t i , t j ) (t_i , t_j) (ti?,tj?) 的最大类型得分 r i j r_{ij} rij? 表示这个span是实体还是非实体,以及作为这种类型的置信度,由最大汇聚得到

构建出一个新的图

G

3

G^3

G3 ,

r

i

j

∈

E

r_{ij} \in E

rij?∈E

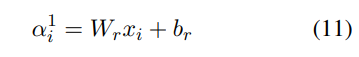

第一部分由平面模块构成

第二部分由新图上做双向图卷积得到

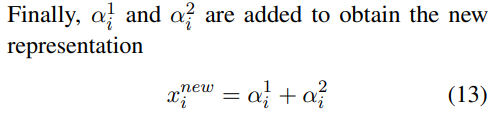

得到最终表示

新的表示丢到平面模块来更新参数并且抽取更好的外部实体

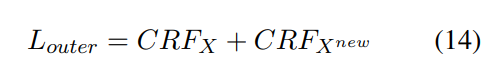

外部损失由两个CRF构成

整个算法的流程

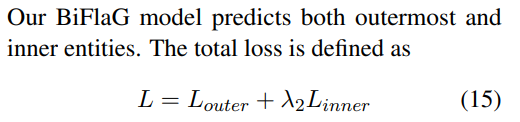

Loss Function

总的损失函数,其中

λ

2

λ_2

λ2? 是平面模块和图形模块的损失之间的权重。在训练阶段,我们将这一总损失降到最低

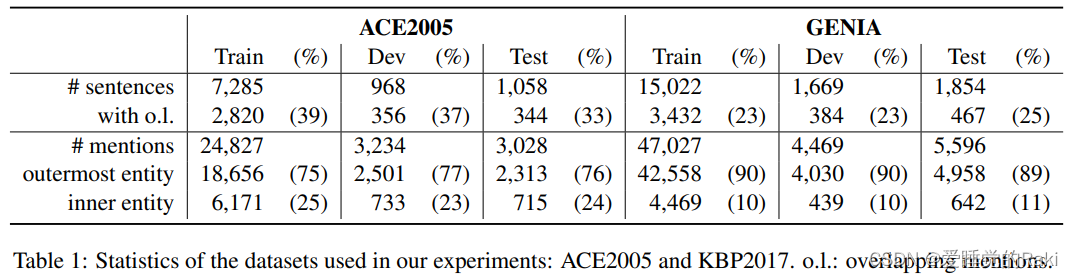

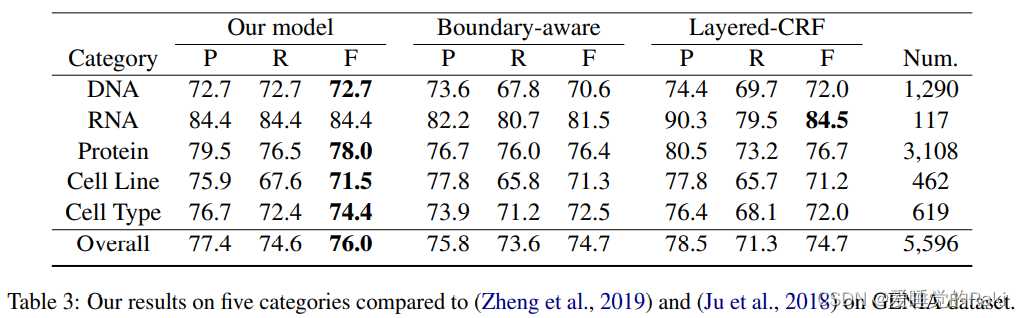

Experiment

Conclusion

我们的BiFlaG模型也可以通过简单地移除图模块来处理非嵌套结构。就相同的严格设置而言,实证结果表明,我们的模型普遍优于以前的sota

Remark

应用了图结构,感觉整体中规中矩,没啥亮点,或许一定程度上证明了应用图结构的有效性?