Character-Aware Neural Language Models

第三周阅读材料代码

csdn上的翻译

描述了一个简单的神经语言模型,输入部分只依赖于字符,预测以单词进行。

模型采用CNN和highway network over characters,输出结果到了一个long short-term memory (LSTM) recurrent neural network language model (RNN-LM)模型。

介绍

语言模型被形式化为一系列字符串(单词)上的概率分布,传统方法是 n 阶马尔可夫假设并通过计数和随后的平滑来估计 n-gram 概率,尽管基于计数的模型易于训练,但由于数据稀疏性,一些少见的 n-gram 的概率可能无法估计。

神经语言模型 Neural Language Models (NLM) 通过将词参数化为向量,并将它们用作神经网络的输入来解决 n-gram 数据稀疏问题。

但NLM对 subword information 视而不见。例如,他们不知道 eventful, eventfully, uneventful, and uneventfully 所应该在向量空间中具有的结构相关的嵌入。因此,稀有词的嵌入可能很难估计,从而导致稀有词(及其周围的词)有很高的perplexities值。这在long-tailed frequency 或具有动态词汇的领域(例如社交媒体)中尤其成问题。

此论文提出一种语言模型,通过 character-level 的CNN且利用subword information,其输出用作循环神经网络语言模型(RNN-LM)的输入。该模型无需预处理步骤,模型参数也很少

模型

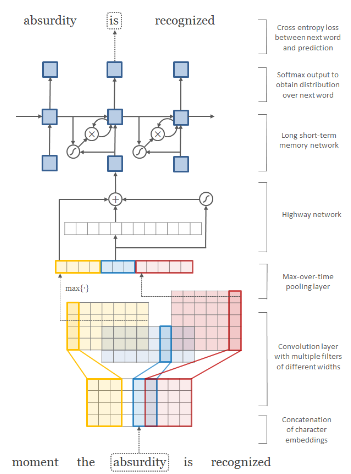

结构如图。图挺糊,配字为:Figure 1: Architecture of our language model applied to an example sentence. Best viewed in color. Here the model takes absurdity as the current input and combines it with the history (as represented

by the hidden state) to predict the next word, is.

第一层是一个character embeddings (of dimension four) ,将它们堆叠起来形成矩阵 C^k. 然后在 Ck 和多个滤波器矩阵之间应用卷积运算。

有十二个过滤器——三个宽度为二的蓝色过滤器、四个宽度为三的黄色过滤器和五个宽度为四的红色过滤器。

max-over-time 池化操作来获得单词的固定维度表示,并将其提供给highway network。highway network的输出用作多层 LSTM 的输入

最后,在 LSTM 的隐藏表示上应用仿射变换和 softmax,以获得下一个单词的分布。最小化下一个词的预测的分布与实际词的之间的交叉熵。

逐元素加法、乘法和 sigmoid 运算符用圆圈表示,仿射变换用实线箭头表示。

知乎上的一些笔记

RNN是循环神经网络,适用于对序列现象进行建模。理论上,RNN 可以用隐藏状态 ht 总结到时间 t 的所有历史信息。然而,在实践中,由于梯度爆炸和消失,使用 vanilla RNN 学习long range dependencies是很困难的,这是Jacobian’s multiplicativity with respect to time的结论。

LSTM 通过在每个时间步用记忆单元向量 ct ∈ R^n 扩充 RNN 来解决学习long range dependencies的问题。

LSTM 中的记忆单元是时间相加的,能有效缓解梯度消失问题。

但梯度爆炸仍然是一个问题,在实践中简单的优化策略(如梯度裁剪)能解决这个问题。

字符级卷积神经网络在论文模型中,时间 t 的输入是CharCNN的输出。CV和 NLP 程序的架构不同之处在于NLP通常涉及时间卷积而CV是空间卷积。

Highway Network Srivastava et al.(2015). 与 LSTM 网络中的记忆单元类似,Highway Network层允许通过自适应地将输入的某些维度直接传送到输出来训练深度网络。

…………

通篇公式偏多