一、Title

1.1前言:

基于移动传感器的人类活动识别(HAR)在普遍计算中起着重要的作用。然而,数据监管限制的增加妨碍了从个人设备上收集私人和标记信号数据。

由于移动设备上计算能力的增长,联邦学习已经成为模型训练的一种分散的替代解决方案,它迭代地将局部更新的模型聚合成一个共享的全局模型,因此能够利用分散的、私有的数据,而无需中央收集。

然而,每个用户有不同的活动类型,对于同一活动类型,甚至有不同的信号分布,这影响了HAR的联合学习的有效性。

此外,还不确定训练过的单一全局模型是否能很好地泛化到单个用户或具有异构数据的新用户。

在本文中,我们提出了一种联邦表示学习框架Meta-HAR,其中信号嵌入网络以联邦方式进行元学习,学习后的信号表示进一步输入每个用户的个性化分类网络中进行活动预测。为了提高嵌入网络的表示能力,我们将每个用户的HAR问题视为不同的任务,并通过一个模型不可知的元学习框架对共享的嵌入网络进行训练,使嵌入网络可以推广到任何单个用户。在适应过程中稳健学习表示的基础上进一步实现了个性化。

我们基于两个公开的HAR数据集以及一个新创建的HAR数据集进行了广泛的实验。结果验证了Meta-HAR在保持包括新用户在内的个人用户的高测试准确性方面是有效的,并且显著优于多个基线,包括联邦平均、爬行动物,甚至在某些情况下的集中学习。我们收集的数据集将是开源的,以促进基于传感器的人类活动识别领域的未来发展。

二、summary(idea)

2.1研究背景:

基于移动传感器数据的人类活动类型,在普适和普适计算中发挥着重要作用。目前最先进的方法是依靠深度神经网络模型来取代传统的手工特征工程,并大大提高了HAR[33,34]的精度。然而,大多数现有的解决方案依赖于集中收集的数据,例如,从移动用户那里收集的信号样本,包括陀螺仪和加速度计的时间序列。根据数据科学的广泛实践中出现的数据监管限制,并可能导致隐私问题,这种被标记的信号样本可能包含私人用户信息,如GDPR[1]。因此,迄今为止,收集和公开的大规模用户活动数据集很少,这阻碍了HAR技术的发展。

由于移动设备上计算和存储能力的快速发展,联邦学习(FL)已经成为一种替代的分布式学习框架,旨在训练基于分散在移动设备上的分散数据的机器学习模型,而不收集它们。在联邦学习中,每个移动设备都下载一个全局模型,并使用其本地数据进行更新,而本地更新则迭代地聚合成一个更新的全局模型。

2.1相关工作

HAR with deep learning model. 最近有几项研究利用深度神经网络模型应用于不同的移动感知或HAR应用。DeepEar[14]采用了深度波耳兹曼机,提高了在背景噪声环境中音频感知任务的性能。DeepX[13]和RedEye[17]分别降低了基于软件和硬件的深度神经网络的能量消耗。IDNet[8]使用cnn进行生物识别步态分析。RBM[4]和MultiRBM[23]结合了深度玻尔兹曼机和多模态DBMs,以提高人类活动识别任务的性能。深度感[34]在CNN之上应用RNN,获取输入传感器数据的序列信息

Federated optimization.联邦学习[12]旨在训练一个高质量的集中式模型,由数据定义的优化问题不均匀地分布在大量的节点上。这种数据分散化可以帮助减少数据传输和保护用户隐私。最近的研究大多集中在解决联邦学习所面临的沟通效率挑战上。联邦平均[18]结合了客户端节点上的局部随机梯度下降(SGD)和服务器端的模型平均,能够减少客户端和服务器之间的通信轮数。Bonawitz等人。[6]允许服务器通过一种通信高效、故障健壮的协议,以一种安全的方式汇总来自移动设备的大向量。差异隐私[19]为联邦平均算法实现了用户级的隐私保护。McMahan等人[18]、Sattler等人[25]也展示了当客户端持有非IID数据时,联邦学习算法的鲁棒性。Zhao等人[37]提出通过在服务器端共享一小部分客户端数据来改进非iid数据的联邦平均。然而,对于真实世界的联邦学习应用程序,共享本地样本是不可行的,因为客户端数量非常大,客户端上的数据可能经常更新,例如安装在智能手机上的app的日志数据。Sozinov等人[28]首先将联合应用于人类活动识别问题。然而,它只是简单地将FedAvg应用于HAR,而没有试图解决联邦HAR带来的新挑战。本文指出,除了非IID分布和标签分布不平衡外,信号分布的异质性也会导致联邦学习的性能下降。我们提出在全局嵌入网络上利用MAML算法的模型个性化来解决联邦HAR所面临的挑战。

Smith等人[27]提出了一个联邦多任务学习框架摩卡来解决一般的多任务学习问题,这是对我们的问题的一个合理的解决方案。然而,他们专注于解决高通信成本,掉队,容错分布式多任务学习和没有讨论异构输入信号分布的情况,不能适应新到来的用户由于没有全球共享表示模型MTL设置。支持[32]使用强化学习来实现智能设备选择,以提高联邦学习性能,并克服在参与者上的非IID数据分布。但是,它并不能为所有参与其中的用户提供个性化的模型。

Meta-learning.元学习旨在解决学习学习[20,30]的问题。早期的工作集中于元训练器的设计,即一个学习如何训练另一个模型的模型,以便在给定的任务[3,26]上获得更好的性能。[2]等人采用深度神经网络训练元收益,并提出了一种优化-优化设置,其中每个组件都通过迭代梯度下降过程学习。Li和Malik[15]遵循一个有指导的策略搜索策略,并自动学习更新模型的优化过程。模型不可知的元学习(MAML)[7]是另一种流行的方法,它不对学习者的架构施加约束。Ravi和拉罗谢尔·[24]提出了一个LSTM元学习器来学习少镜头图像分类的优化过程。Li等人[16]开发了一个类似于sgd的元学习过程,并在少镜头回归和强化学习问题上进行了实验。爬行动物[21],即本文所采用的方法,通过对元学习器进行一阶梯度更新,简化了MAML的学习过程。Jiang等人[10]将联邦学习解释为一个MAML算法,并实现了一个一阶MAML算法的一个联邦版本,爬行动物。然而,Jiang等人[10]关注于参数调优,以得到一个易于个性化的全局模型。

Learn personal models.

开发了几种分散点对点网络[31]训练个性化模型的算法。拥有本地数据集的用户通过网络中的对等交换相互协作,以学习个性化的模型。个性化模型对本地用户很方便,因为移动设备上新生成的数据经常在本地使用,例如用户与APP的交互日志。然而,点对点网络对于联邦学习设置是不现实的,在联邦学习设置中,客户端的数量如果非常大,并且客户端之间的关系是复杂的,甚至是动态的。Jiang等人[10]将联邦学习与MAML算法结合起来,并通过数值结果显示了采用个性化的好处联邦学习。然而,之前只是通过添加个性化步骤对原始的联邦学习框架做出了增量的贡献。另一方面,我们的框架更加灵活,个人模型甚至可以为不同的客户端提供不同的输出维度。

2.2存在问题:

与键盘输入预测[9]等其他移动应用程序类似,HAR是另一个动机良好的场景,可以受益于联邦学习[28],它简化了隐私管理,并给每个用户提供了更大的灵活性关于选择哪些本地数据样本,以及它们应该如何对整体应用程序的改进作出贡献。虽然联邦学习在文献中,如图像分类和键盘输入预测[9,12]等多个任务中表现不错,但它是否可以用于解决HAR仍然是一个问题。联邦HAR已经在一个简单的深度神经网络模型上进行了测试,[28]报告的准确率降低了高达6%,这是集中学习的一个显著退化。我们指出,在联邦学习中执行HAR有三个主要障碍:

①首先,虽然已知如果训练样本是独立的同分布(IID),联邦学习可以很好地近似集中学习,但这的IID假设不适用于活动信号。事实上,每个用户并不一定具有相同的活动类型——大多数用户只执行所有活动的一个子集,例如,一个用户可能只在他/她的设备上记录了{步行、驾驶},而另一个没有任何车辆的用户可能只有{步行、骑自行车}。因此,局部训练数据集具有不平衡的标签分布。这种跨用户的标签分布的异质性可能会导致联邦学习[37]的严重性能下降,并将随着参与用户数量的增加而加剧。

②其次,即使是对于相同的活动,两个用户也可能表现出显著不同的信号分布。其原因是,用户可能会以不同的风格执行相同的操作。例如,两个人可能有完全不同的行走模式,一个步幅较大,而另一个步幅频率较高,但步长较小。换句话说,在用户间相同活动的信号分布存在很大程度的异质性。我们通过实验表明,输入信号分布的这种异质性也会严重影响联邦学习所获得的模型精度。

③第三,通过联邦学习发现的单一全局模型很难适应和推广到个体用户,特别是对于具有自己活动特征的新用户。为了处理真实世界的HAR任务,每个用户都需要一个个性化的模型,它将从所有用户中联合挖掘出来的见解与一个专门适合其本地数据的预测器结合起来。这种个性化对于新用户或具有新引入的活动类型的现有用户尤其可取。

2.3设计目的:

解决这些挑战,在本文中我们提出Meta-HAR,联邦表示学习框架人类活动识别,共享,全球深度嵌入网络由联邦学习跨用户,而信号表示嵌入网络输入一个单独的分类网络针对每个设备个性化的活动预测。这样一个表示学习框架的灵感来自于一个好的信号表示不能训练本地基于稀疏数据,但必须利用丰富的异构数据驻留在不同的设备,而最终个性化预测在每个用户应该增加本地共享表示。

为了训练共享的嵌入网络,我们将每个设备(用户)视为一个单独的任务,它可能有其独特的标签分布和输入信号分布。受模型不可知的金属学习[7]的启发,我们元训练了一个嵌入网络,该网络适应任务的分布,而不是每个单独的任务,从而保持了该任务分布对新任务的泛化能力。具体来说,我们采用了一个联邦版本的爬行动物[10],一个一阶元学习算法[21],来训练嵌入网络。

每个设备通过两对相似性损失用其本地数据集迭代更新嵌入网络,并将更新后的嵌入网络推到服务器进行聚合。通过最小化成对损失而不是交叉熵损失,来自同一类的样本被鼓励在嵌入式空间中聚类,而那些来自不同类的样本则被推开。由于每一对样本都产生一个优化的损失值,我们已经有效地将每个设备上的稀疏数据引导到更多的训练样本中。结果表明,用该方法训练的共享嵌入网络对用户间的异构数据分布具有鲁棒性。

一旦获得了一个可推广的信号表示,就通过两阶段自适应程序来预测设备上的活动类型。我们首先在设备的本地数据集上对嵌入网络进行两两损失的微调。然后在每个用户的嵌入网络上添加一个特定于客户的输出层进行活动分类,并在同一本地数据上共同对嵌入网络和输出层进行微调。我们表明,嵌入网络可以在小的局部数据集上进行充分的微调,并且由于有效的局部自适应,个性化模型有时甚至可以优于集中训练的模型,特别是对于新用户。

我们进行了广泛的评估提出MetaHAR两个公开数据集:1)异构人类活动识别(HHAR)数据集[29]9用户和6种活动,和2)USC-HAD[36]数据集,14用户和6种不同的活动,以及一个更大的新收集的数据集148用户和6不同的活动。请注意,这两个公开可用的数据集是在精心控制的环境中创建的,这样每个用户都有所有的活动类型和一个平衡的标签分布。为了模拟真实世界的场景,对于这两个数据集,我们从每个用户中随机删除了一些活动,以模拟非IID标签分布的情况。

在每个实验中,我们随机剔除几个用户作为元测试用户来测试meta-har对新用户的普遍性,并使用所提出的方法对剩余的元训练用户训练我们的模型。对于每个元训练用户,其部分本地数据也被遗漏以进行测试。我们重复每个实验5次,并取平均值。在HHAR和USC-HAD数据集上,元测试用户和元训练用户的测试准确率分别达到了92.5%、98.39%和91.07%、93.79%。在较大的收集数据集上,在元测试用户和元训练用户上观察到类似的93.29%和90.76%,证明了Meta-HAR的缩放能力。这些数据集的结果表明,Meta-HAR明显优于FedReptile[10]。我们还合并了两个公开的数据集,以压力测试Meta-har,在一个显著的异构和不平衡的场景下,共有23个用户和7个不同的活动(在两个数据集中有5个重叠的活动)。在这种情况下,我们证明了所提出的Meta-HAR显著优于FedReptile。

人类活动识别(HAR)的目的是将移动设备上的大量传感器读数(例如,来自陀螺仪和加速度计的信号段)分类为人类活动类型。在本节中,我们将介绍在不能集中收集传感器数据的联邦学习设置中的HAR问题,以及HAR对联邦学习带来的新挑战

假设有𝑛参与的移动设备(或用户)。让用户𝑖的本地数据集用𝐷𝑖={(𝑠𝑖𝑗,𝑎𝑖𝑗)|𝑎𝑖𝑗∈𝐴𝑖,𝑗=1,2,…,𝑁𝑖},表示,其中𝑠𝑖𝑗是第𝑗个样本in𝐷𝑖的传感器信号,𝑎𝑖𝑗是其对应的活动标签。𝑁𝑖=|𝐷𝑖|表示𝐷𝑖中的样本数量,而𝐴𝑖表示在用户𝑖中观察到的活动类型集。请注意,每个用户可能有不同的活动类型,即,𝐴𝑖在不同的用户之间是不同的。最终的目标是解决每个用户的活动识别问题

一个简单的想法是对每个设备分别执行基于𝐷𝑖的本地监督学习。然而,这里的陷阱是,从每个用户的角度来看,该方案未能利用位于其他用户身上的大量数据。此外,由于每个用户上的活动类型可能是稀疏的(有个人用户不做的动作),一个本地训练的模型不能对用户的新活动做出预测。

一个看似合理的解决方案是联合学习,例如,联邦平均(FedAvg)[18],它能够学习驻留在移动用户上的分散数据集的全局模型。然而,该方案并不能很好地适用于HAR问题,这主要是由于在标签和输入信号分布中都存在的异质性。首先,研究表明,在图像分类中,用户间标签分布的异质性,也被称为非IID和数据不平衡的问题,会导致联邦学习[37]的性能显著下降。除了非IID标签分布外,在HAR中,即使对于相同的活动,用户也有异构的输入信号分布,这也会导致性能下降,但在文献中没有报道。

在这里,我们通过在HHAR数据集[29]上的实验证明,仅信号分布的异质性就会导致显著的性能下降。请注意,在这个数据集中,每个用户都有IID活动类型(IID标签)。我们将每个用户的数据分成一个训练集(80%)和一个测试集(20%)。用于HAR任务的神经网络模型如图4所示,并将在第3节中详细介绍。评估了三种方案:

中心:收集服务器上的所有数据,并集中训练HAR模型。

?FedAvg-用户:FedAvg应用于跨用户学习全局HAR模型。

?FedAvg-洗牌:应用FedAvg学习一个全局模型,首先收集所有样本并在服务器上打乱,然后重新分配给所有用户。

请注意,原始HHAR数据集是在受控的情况下收集的,因此它不存在标签分布的异质性(非IID或不平衡),因此FedAvg-用户和FedAvg-洗牌之间的唯一区别是用户之间的信号分布是否存在异质性。结果如图1所示,其中x轴表示中央方法的训练时期,以及两种FedAvg方案的联邦更新轮。

很容易观察到fedavg用户的准确率从97%以上降低到80%以下。而,没有信号fedavg-shuffle可以学习一个性能接近集中训练模型的模型。在我们的实验中,从中心模型到FedAvg方法的性能下降了近20%,远远高于之前工作[28]报道的6%,原因是[28]采用了可推广的手工特性和简单的分类模型、softmax回归和DNN模型。然而,最先进的HAR模型在联邦学习设置下的性能仍然未知,值得进一步研究。

为了进一步证明用户在相同的活动中存在异质性,我们提取了传统的手工特征[28](均值、每个轴上的标准差、信号振幅的最大、最小),并使用PCA从HHAR数据集中可视化样本分布。结果如图2所示,如图2(b)中所示,对用户?不同活动的样本进行了很好的聚类,显示了手工制作功能的效率。然而,相同活动的“楼梯向下”的样本也被不同的用户聚类,如图2(a)所示,这显示了用户间信号分布的异质性

除了我们上面讨论的性能问题之外,还有一些实际因素表明了联邦学习对我们的问题的缺点。

首先,不收集用户数据很难知道全局活动集,𝐴=𝐴1∪𝐴2…𝐴𝑛,𝑛是用户数,对于分类问题,它决定了全局模型的输出维度。此外,为了在用户数据上进行本地训练模型,我们需要统一不同用户之间的标签,**例如,我们需要确保标签“0”在联邦HAR问题中代表不同用户之间的相同活动。**这项工作既单调乏味又很耗时。最后,解决具有大量类的分类问题比具有较少类别的问题更难。

因此,对于联邦学习在人类活动识别中的成功应用,我们需要一个能够克服标签和输入信号分布的异质性的新框架。

三、Method

3.1简述

在本节中,我们将描述Meta-HAR,我们提出的联邦表示学习框架,用于解决HAR问题,而是在不集中收集数据的情况下。**Meta-HAR不是训练所有活动类型的全局分类网络,而是首先通过跨所有用户的模型无关的元学习框架,学习由Θ参数化的通用深度表示模型(或信号嵌入网络)。嵌入网络的目标是将任何给定的输入信号,无论其活动类型如何,嵌入到一个固定长度的向量中,该向量被输入到每个用户单独学习的分类器中,以符合其自己的活动集和输出维度。**这种设计避免了为全局活动集训练大型全局分类器的复杂性,并消除了跨不同用户统一标签的需要,如在第2节中所提到的。

下面,我们首先概述了嵌入网络的训练过程,然后描述了Meta-HAR所采用的嵌入网络的神经结构及其局部训练过程。最后,我们提出了针对用户的模型个性化和活动推理的过程。Meta-HAR的整体工作流程见算法1。

我们首先介绍了我们的以联邦方式对嵌入网络进行元学习的方法,以便在利用异构数据的同时实现强大的泛化能力。为了在有信号和标签异质性存在的情况下引入鲁棒性,全局嵌入网络不通过监督分类任务进行训练,而是通过两两比较任务进行元训练,该任务比较两段信号是否属于同一类型的活动。

在联邦HAR中,尽管每个用户可能有一个具有不同活动类型和信号分布的本地数据集,但不同用户之间的活动分类的本地任务在概念上是相似的。这与基于优化的元学习[24]的问题非常相似,该[24]试图从多个相似的任务中学习模型的初始化,然后可以通过一个微调阶段在推理时适应一个新的任务,也称为适应。

模型不可知元学习(MAML)是一种新兴的学习方法,其目标是在各种类似的学习任务上训练模型,以便在少量的训练样本和步骤下解决新的学习任务。**因此,我们将每个用户的活动识别问题视为一个单独的任务。每个任务都有其独特的输入信号分布、不同的输出活动集,甚至还有不同数量的活动类型。然而,假设每个任务都是从𝑝(T)中采样的,这是一个任务的全局分布。根据基于优化的元学习,例如MAML[7,21],可以通过适当的优化程序来训练模型,使模型适应任务𝑝(T)的底层分布,从而可以推广到从𝑝(T)采样的任何新任务。

[10]指出,FedAvg是爬行动物的一种特殊情况,是一种可伸缩的一阶元学习算法,我们采用了爬行动物[21]的联邦版本,我们称之为联邦爬行动物(联邦爬行动物),**在去中心化的用户中以联邦的方式对嵌入网络Θ进行元训练。使用Fed爬行动物训练嵌入网络的工作流程,参数为Θ,如图3所示,其中有𝑛用户参与训练,有一个联邦学习服务器(FL服务器)和一个新的泛化能力测试用户。每个用户都持有一个本地数据集,从FL服务器中提取模型参数,使用其本地数据集更新它们,然后将这些更新推送到FL服务器。FL服务器负责协调所有用户的协作过程,并更新全局模型。

如算法1所示,假设𝑛用户涉及到本地数据集{𝐷𝑖},𝑖=1,2,……𝑛。在每一轮测试中,都会选择一个用户子集𝑈来更新全局参数。(根据[5]的说法,在每一轮的联邦学习活动中,只有一部分用户会参与其中,以避免在分布式环境中出现过多的等待时间。)每个用户𝑖∈𝑈首先从FL服务器中提取当前参数Θ𝑐,并执行𝑚阶段的本地训练,然后将更新后的模型Θ𝑖推送到FL服务器。然后,FL服务器对收集到的更新Θ𝑖进行平均,以更新全局模型Θ𝑐如下:。

在本小节中,我们将简要介绍嵌入网络的结构,以及个体用户如何在本地更新嵌入网络。

与之前的HAR深度神经网络(如[22,34,35])类似,我们的嵌入网络Θ涉及到卷积网络和循环网络的联合使用。然而,Θ并不是通过最小化局部分类损失(交叉熵损失)来进行局部更新的。相反,一个权重共享的暹罗网络被用来预测两个信号样本是否属于同一类。我们现在描述了嵌入网络的体系结构和局部训练方法。

四、Experiment

4.1实验步骤

首先,我们将数据集中的所有用户分成元训练用户,分别参与元学习过程,和元测试用户,元测试用户作为测试元学习模型泛化能力的新用户。具体来说,在HHAR或USC-HAR数据集上,我们随机选择一个用户作为元测试用户。在合并后的数据集上,分别从HHAR和USC-HAD数据集中随机选择两个用户作为元测试用户。对于收集的数据集,选择5个用户作为元测试用户。我们的最终目标是为所有用户、元雨水和元测试用户学习一个个性化的模型,从而解决当地的人类活动识别问题。为了训练模型并测试性能,我们进一步将每个用户的本地数据集分割为一个训练集(80%)和一个测试集(20%)。具体来说,我们评估了以下方案,以证明我们所提出的方法的有效性:

? Central: HAR分类模型是对在服务器上收集的所有数据样本进行训练的。

? FedAvg: 原始的联邦平均方法[18],其中以联邦的方式学习全局的共享分类模型。

? FedReptile: 联邦爬行动物[10]被应用于第一个元学习一个分类模型的全局初始化。然后通过对每个用户进行交叉熵损失来实现个性化

? Meta-HAR: 提出的Meta-HAR框架。

? Meta-HAR-CE:所提出的Meta-HAR的一个变体,其中嵌入网络的训练与交叉熵损失,而不是成对损失。

请注意,与FedAvg相比,FedReptile只是添加了额外的适应步骤来生成个性化的模型。然而,与以往的工作不同的是,在我们提出的方法中,只有嵌入网络是联邦学习的。此外,还对以下个性化的微调策略进行了评估和比较:

分离:对嵌入网络和输出层的参数进行微调。具体来说,首先对嵌入网络进行两两损失的微调,然后固定嵌入网络,以进一步微调具有交叉熵损失的输出层。

?合并:将嵌入网络和用户特定的输出层共同进行微调,并具有交叉熵损失。

?两阶段:提出的两阶段微调策略

请注意,FedAvg[18]方案设计得很好,以克服系统的挑战,如通信效率和移动设备上的计算能力有限等。我们提出的框架遵循与FedAvg相同的系统设计,即我们具有与FedAvg相似的系统效率和通信成本。

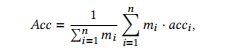

在这项工作中,我们的目标是解决联邦HAR带来的数据异构性问题,因此,我们不是解决通信挑战,而是关注HAR问题的模型性能。用平均预测精度来评价一个模型的性能,其定义如下:

其中,𝑎𝑐𝑐𝑖是对𝑖th用户的测试精度,𝑚𝑖是对该用户的测试样本数。利用元训练和元测试用户的平均精度来评估参与元学习的用户和未参与嵌入网络训练的新用户的未来数据的泛化能力。在每个实验中,我们随机选择元测试和元测试用户来评估所提出的方法和所有基线的性能。我们在每个数据集上重复整个过程5次。给出了平均精度及其标准差。