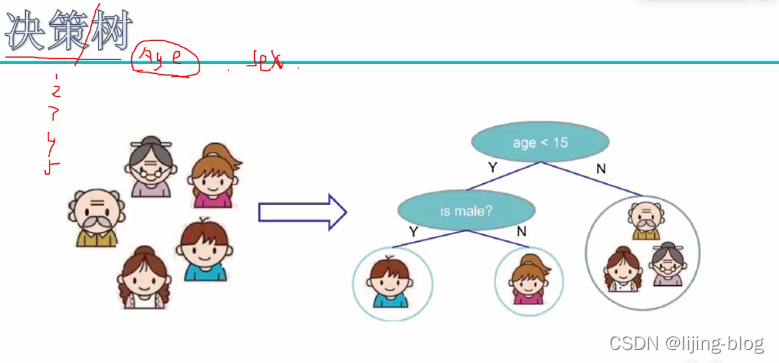

决策树

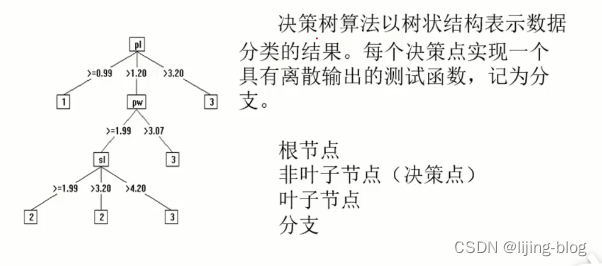

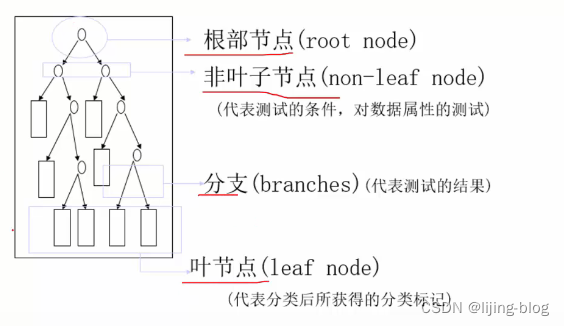

1.决策树概念

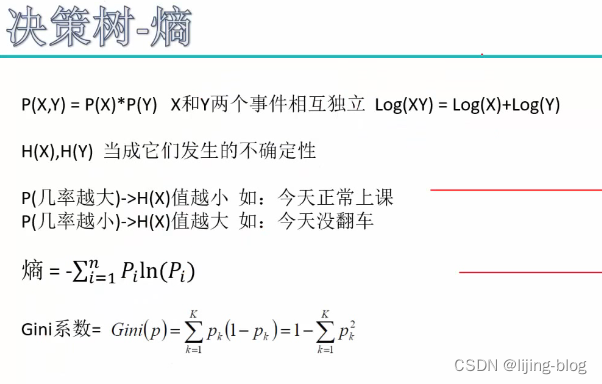

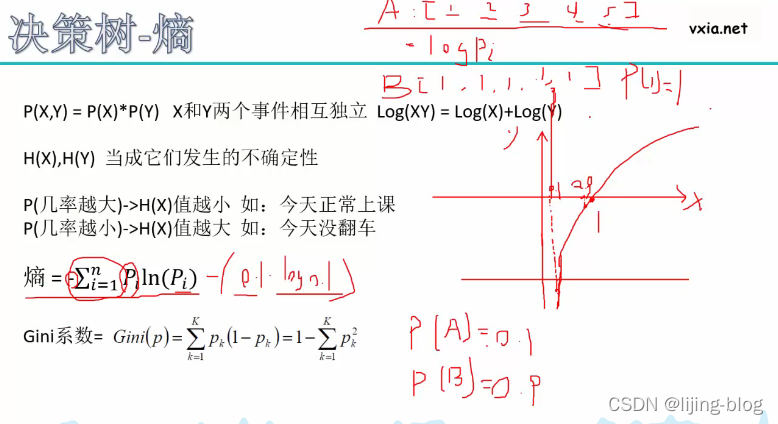

2.熵值

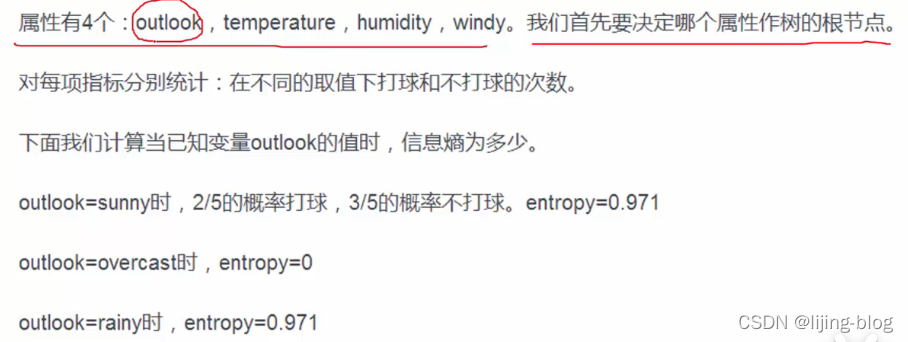

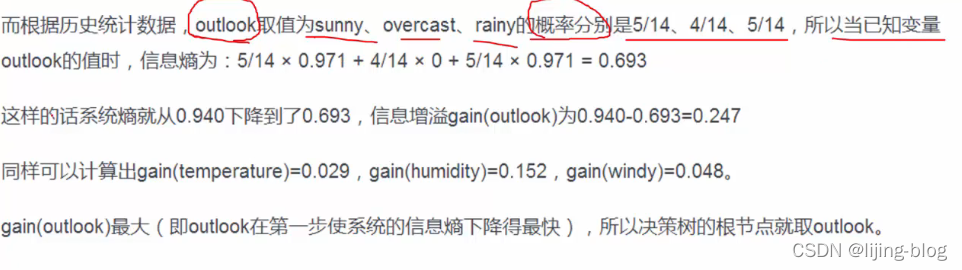

3.决策树构造实例&信息增益

统计原始数据最初的熵值为:0.940

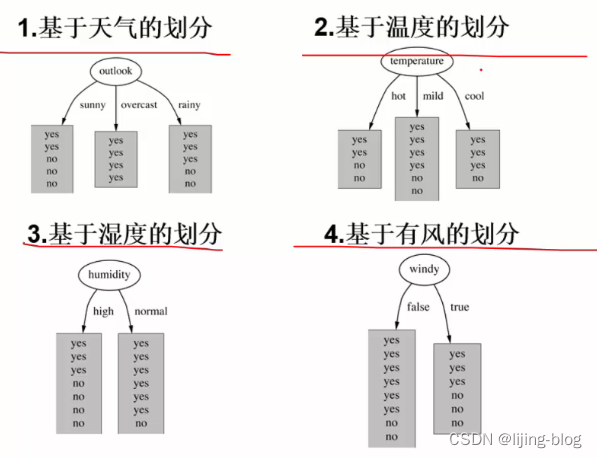

基于四个条件都可以划分

4.信息增益率

决策树算法的版本

ID3:会出现信息增益最大化

ID和最终结果并不存在关系,只是一个符号值,但是会产生信息增益最大化,因此提出了信息增益率

信息增益率:信息增益 / ID自身的熵值

此时,即使信息增益大,但id自身的熵值会更大,比值就会很小。

Gini系数在第二点中有公式

评价函数

H(t)为熵值

Nt为叶子节点里面的样本数目,也就是权重

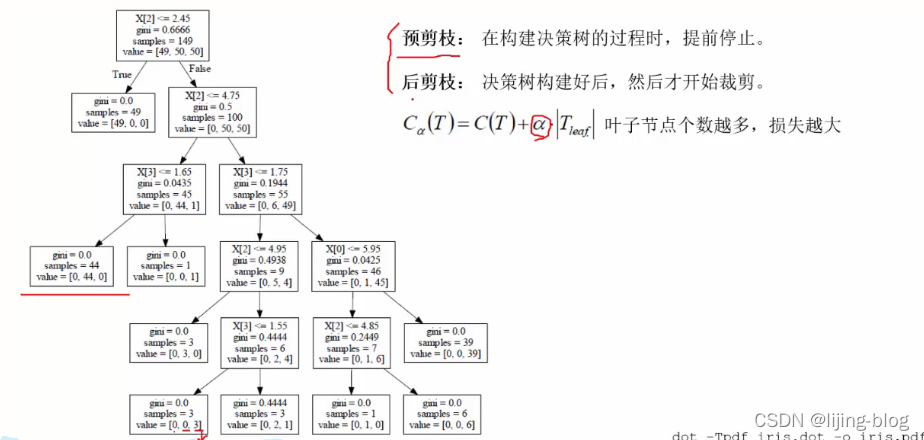

5.决策树剪枝

预剪枝:手动剪枝。

假设我只要三层,则决策树的后面都不要了

或者限定样本数量,多于样本数量就不继续分裂了。

就是提前结束,防止过拟合

后剪枝:新的评价函数=C(T)是评价函数,|T|是叶子节点个数

当决策树构建好后,对结点进行遍历,比较评价函数的值,大的去掉

比如,某个节点分裂了两个结点,则叶子节点数为3,即评价函数=c1+3a

如果其不分裂,则评价函数=c2+a

比较两个评价函数值的大小,大的去掉,用小的那个

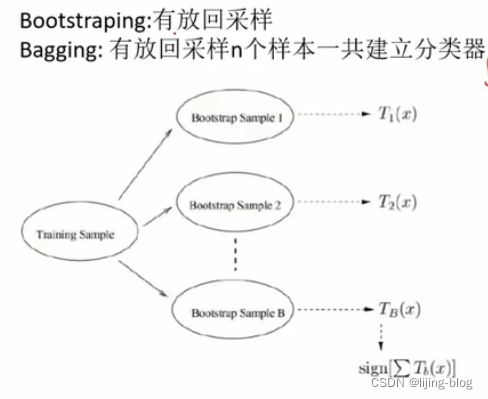

6.随机森林

就像构造出了多棵决策树,共同来做决策

随机的解释:

1.数据选择的随机。不将所有样本都放入去训练,只随机选取其中一部分(假设十个选六个),是为了避免错误数据次次干扰-----数据的选择是可放回的选择。

2.特征的随机选择。特征不放回

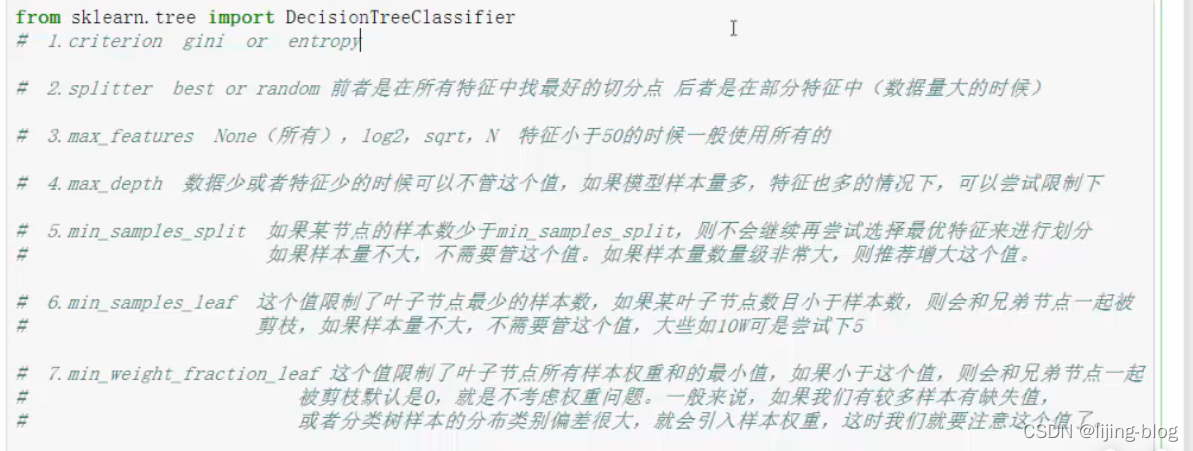

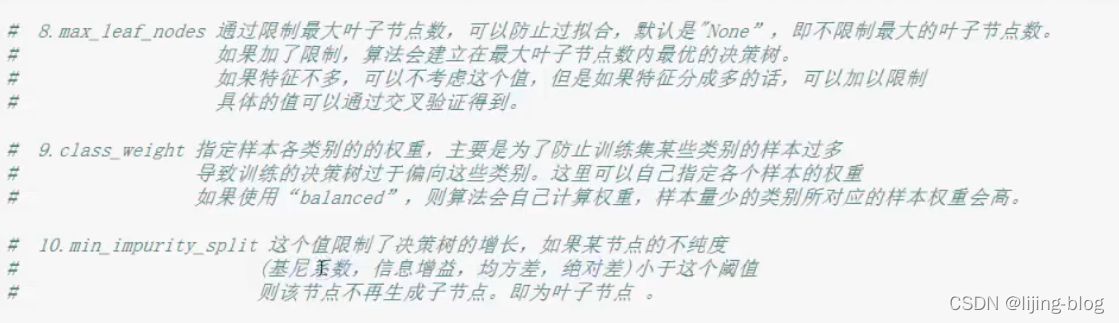

7.案例决策树参数