翻译:用LSTM递归神经网络提取定义

Siliang Li,Bin Xu, Tonglee Chung. Definition Extraction with LSTM Recurrent Neural Networks. The 15th Chinese National Conference on Computational Linguistics (CCL 2016) and the Fourth International Symposium on Natural Language Processing based on Naturally Annotated Big Data (NLP-NABD 2016), Yantai, Shandong,Oct 15-16, 2016,LNAI 10035, p177-189.

关键词:

Definition extraction、LSTM recurrent neural networks

目标:

定义的自动抽取。定义抽取:从非结构化文本中自动识别定义句。

问题:以前的方法使用由句子依赖结构生成的手工特征。在此过程中,只使用部分依赖结构提取特征,导致信息丢失。

解决办法:我们将定义抽取建模为一个有监督的序列分类任务,并提出了一种使用长短期记忆神经网络模型自动生成句子特征的新方法。我们的方法直接从原始句子和相应的词性序列中学习特征,充分利用了整个句子。

贡献:

- 提出了利用LSTM进行定义抽取的新方法。LSTM:具有很强的捕捉序列中长期和短期依赖关系的能力。

- 该方法不依赖于手工模式,也不依赖于从句子依赖解析(dependency parsing)中手工规定特征。通过从句子序列中自动学习结构特征,减少基于监督学习方法的特征工程的工作量。(dependency parsing https://zhuanlan.zhihu.com/p/66268929)

- 该方法很少依赖于语言特征,可以用于多语言的定义提取。实验证明了它在中英文两种语言中的有效性。

(综上三点其实就是一点:我们的LSTM很好,并解释都哪里好)

效果:

我们在Wikipedia基准数据集上进行了实验,获得了91.2% 的F1分数,比目前最先进的方法提高了5.8% 。在一个中文数据集上进行测试,结果表明该方法对其他语言的处理是有效的,F1分值达到85.7% 。

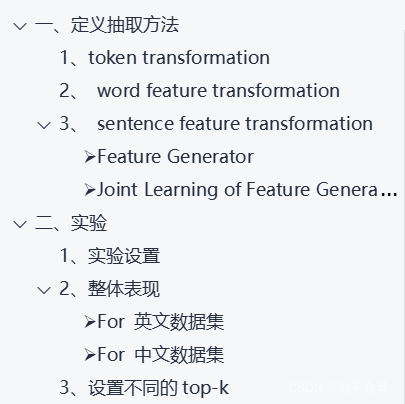

笔记目录: