Visual Transformers: Token-based Image Representation and Processing for Computer Vision

2020 CVPR

1. 摘要

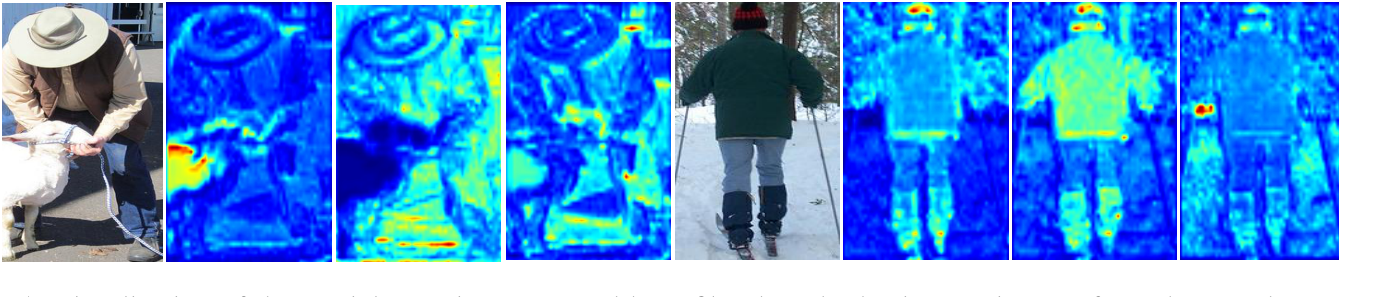

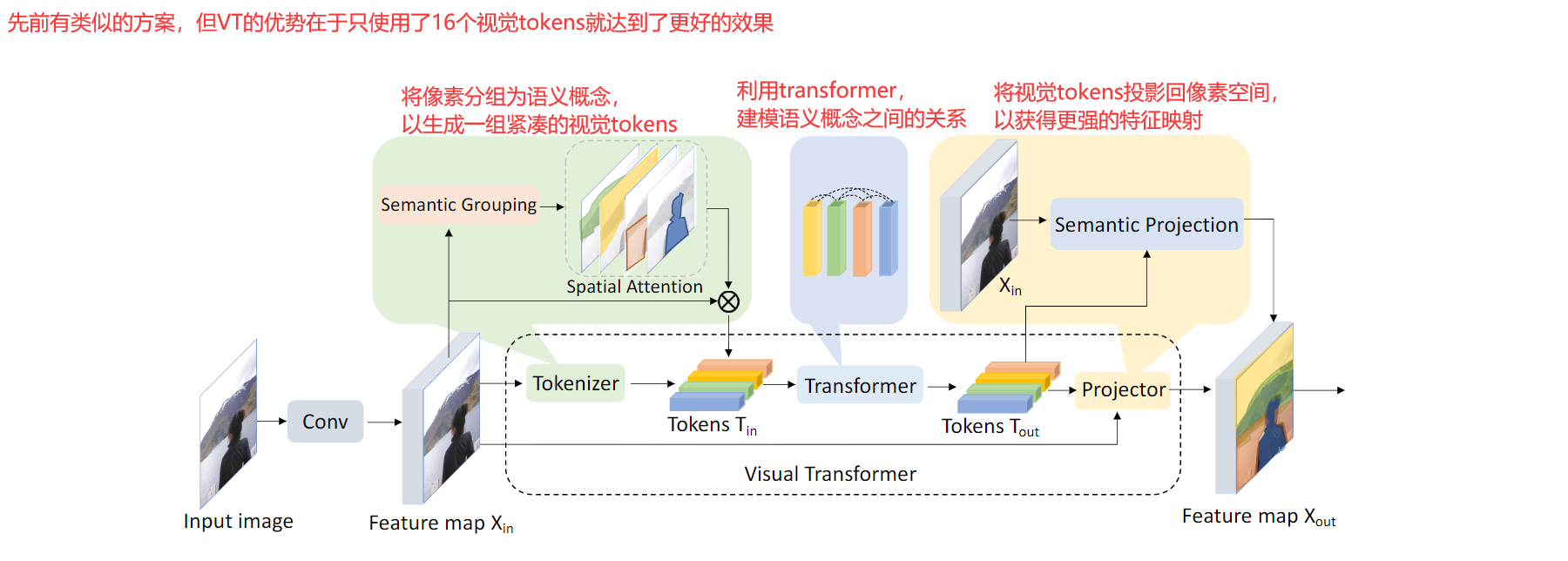

? 计算机视觉通过(A)将图像表示为均匀排列的像素阵列和(B)卷积高度局部化的特征取得了显著的成功。然而,卷积对所有图像像素一视同仁,不考虑重要性;明确地对所有图像中的所有概念建模,而不考虑内容;以及尽力将空间距离的概念联系起来。在这项工作中,我们通过(A)将图像表示为语义视觉标记(semantic visual token)和(B)运用transformer来密集地建模标记关系来挑战这一范式。我们的Visual Transformer在语义标记空间中操作,基于上下文明智地处理不同的图像部分。这与需要更多数量级计算的像素空间Transformer形成鲜明对比。使用先进的训练方法,我们的VTs显著优于卷积同行,将ImageNet Top-1上的ResNet精度提高4.6到7个点,同时使用更少的FLOP和参数。对于LIP和COCO的语义分割,基于VT的特征金字塔网络(FPN)在降低FPN模块错误率6.5的同时,提高了0.35个MIU点。

2. 方法

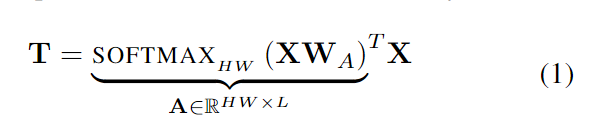

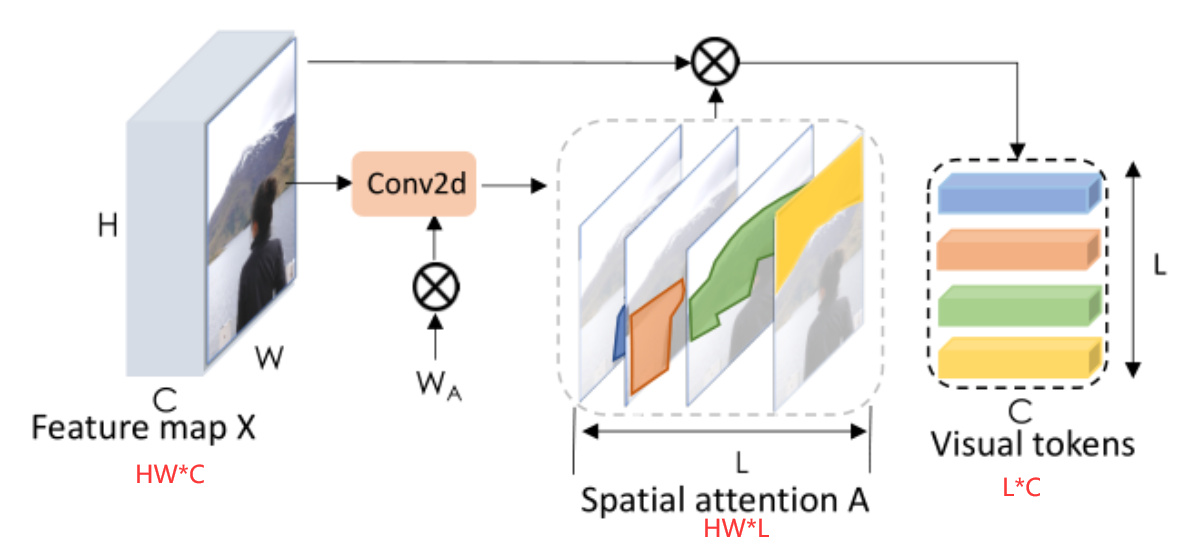

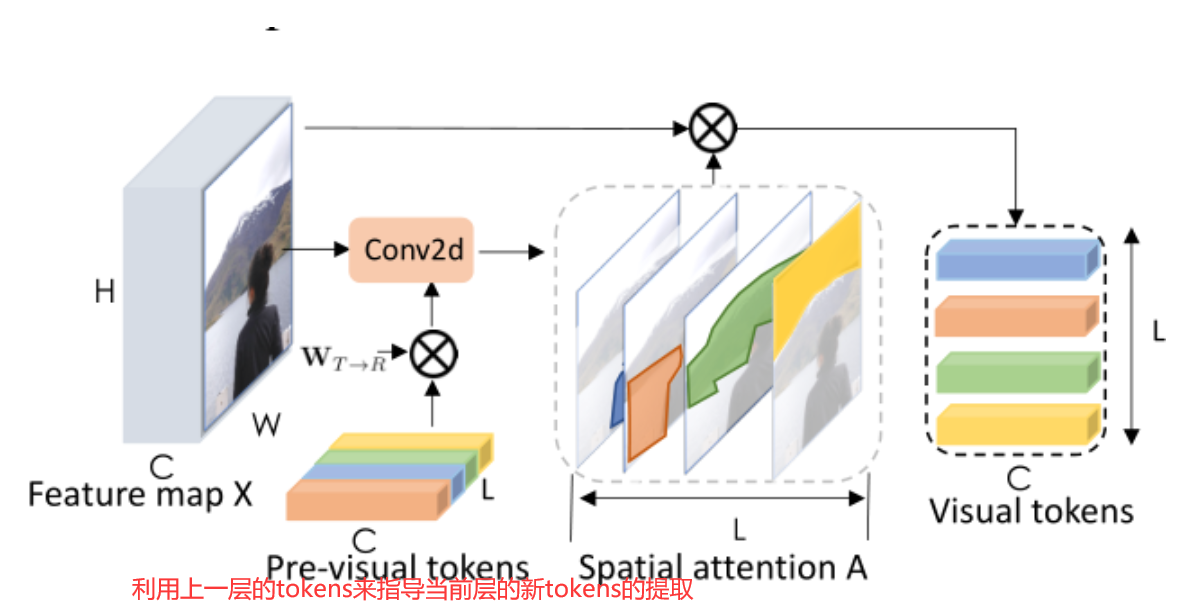

2.1 Tokenizer

参考:

LatentGNN: Learning Efficient Non-local Relations for Visual Recognition

Graph-Based Global Reasoning Networks

Symbolic Graph Reasoning Meets Convolutions

-

Filter-based Tokenizer

基于核的Tokenizer,使用卷积来使用固定卷积核对像素进行分组;缺点在于,许多高级语义概念是稀疏的,每个概念可能只出现在几个图像中,固定的学习权重集合Wa对所有这样的高级概念进行建模会潜在地浪费计算。

-

Recurrent Tokenizer

上一层的tokens指的是什么?是一次预测产生的tokens还是指有多层的tokenizer

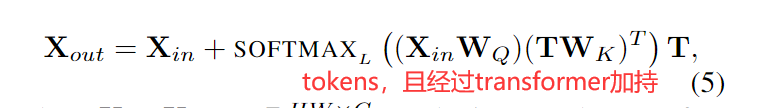

2.2 Transformer

先前有利用图卷积进行关系感知,但是这样的操作使用固定的权重,这意味着每个token或节点都被绑定了一个特点的概念,即使有的概念只出现在几个图像中。

使用transformer的原因:依赖于输入的权重,从而支持具有可变含义的可视tokens,用更少的标记覆盖更多可能的概念。

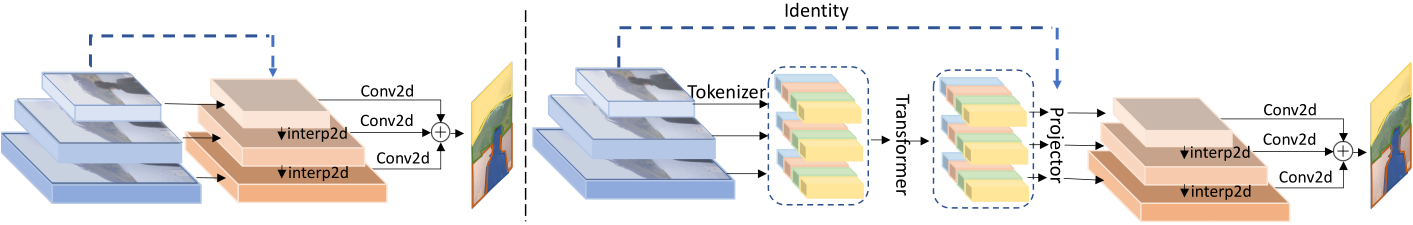

2.3 Projector

3. 应用视觉transformer到视觉模型中

外链图片转存中…(img-XXBtVIcQ-1645432267352)]