???????去年由于一些原因,需要在手机端部署人体姿态估计模型,早就写完了,但由于一些原因一直没有记录下来。大致的过程是,经过一番百度,找到了一个名为ncnn的框架,然后参考ncnn-android-yolox的实现,完成了人体姿态估计模型在移动端的部署。代码已开源:ncnn-android-pose,采用的目标检测器是旷视开源的YOLOX。

效果

???????用坤坤打篮球的经典视频测试了一波,感觉还不错?

环境

???????这里需要配置的环境是Android端的OpenCV和ncnn框架,其实只需要下载这两个东西,然后将CMakeLists中的两个路径修改以下即可。我的CMakeLists.txt主要部分如下所示:

cmake_minimum_required(VERSION 3.10)

set(OpenCV_DIR ${CMAKE_SOURCE_DIR}/opencv-mobile-4.5.4-android/sdk/native/jni)

find_package(OpenCV REQUIRED core imgproc)

set(ncnn_DIR ${CMAKE_SOURCE_DIR}/ncnn-20211208-android/${ANDROID_ABI}/lib/cmake/ncnn)

find_package(ncnn REQUIRED)

add_library(ncnnyolox SHARED yoloxncnn.cpp yolox.cpp slpn.h slpn.cpp ndkcamera.cpp)

target_link_libraries(ncnnyolox ncnn ${OpenCV_LIBS} camera2ndk mediandk)

????下载ncnn和opencv的Android版本即可。注意这里还要下一下ncnn的Windows版本或Linux版本,取决于你自己模型的平台,将onnx模型转为ncnn的param和bin文件。onnx模型的生成在我前面的博客都有。

模型转换

????首先要把onnx模型转换为ncnn支持的param和bin文件,运行下面的命令即可:

onnx2ncnn.exe a.onnx a.param a.bin

???????后面就是你模型的名字了,我是在Windows下转换的。

???????然后采用量化工具进行一下量化,这里参考的是ncnn量化,可以对模型的参数大小进行一些优化。然后就生成了模型的bin和param文件,就可以利用它们进行推理了。

代码

???????其实采用ncnn的好处是,你可以在Windows或者Linux环境下用C++预先调试好代码,再在Android Studio上用JNI的方法,直接把调试好的C++代码复制过去就行了。总的来讲,这部分代码就是ncnn的模型前向推理过程加上我之前博客写的人体姿态估计的前后处理部分。具体可以参考我的开源代码实现,主要是在SLPNet.cpp中。推理部分主要代码如下:

// 载入模型

int SLPNet::load(AAssetManager* mgr, const char* modeltype, int _target_size, const float* _mean_vals, const float* _norm_vals, bool use_gpu)

{

slpnet.clear();

blob_pool_allocator.clear();

workspace_pool_allocator.clear();

ncnn::set_cpu_powersave(2);

ncnn::set_omp_num_threads(ncnn::get_big_cpu_count());

slpnet.opt = ncnn::Option();

#if NCNN_VULKAN

slpnet.opt.use_vulkan_compute = use_gpu;

#endif

slpnet.opt.num_threads = ncnn::get_big_cpu_count();

slpnet.opt.blob_allocator = &blob_pool_allocator;

slpnet.opt.workspace_allocator = &workspace_pool_allocator;

char parampath[256];

char modelpath[256];

sprintf(parampath, "%s.param", modeltype);

sprintf(modelpath, "%s.bin", modeltype);

__android_log_print(ANDROID_LOG_DEBUG, "model", "%s", modeltype);

slpnet.load_param(mgr, parampath);

slpnet.load_model(mgr, modelpath);

target_size = _target_size;

mean_vals[0] = _mean_vals[0];

mean_vals[1] = _mean_vals[1];

mean_vals[2] = _mean_vals[2];

norm_vals[0] = _norm_vals[0];

norm_vals[1] = _norm_vals[1];

norm_vals[2] = _norm_vals[2];

return 0;

}

这里是推理部分,github上有很多注释的调试代码,可以忽略~~~

int SLPNet::detect(const cv::Mat& rgb, cv::Rect_<float> rect)

{

std::vector<float> center{0.0,0.0};

std::vector<float> scale{0.0,0.0};

box_to_center_scale(rect, img_size[0], img_size[1], center, scale);

cv::Mat input;

cv::Mat tran = get_affine_transform(center, scale, 0, img_size,0);

cv::warpAffine(rgb, input, tran, cv::Size(img_size[0],img_size[1]), cv::INTER_LINEAR);

_normalize(input);

convertMat2pointer(input, x);

ncnn::Mat in(192, 256, 3, x);

ncnn:: Extractor ex = slpnet.create_extractor();

ex.input("data", in);

{

ncnn::Mat out;

ex.extract("output_heatmaps", out);

}

return 0;

}

模型

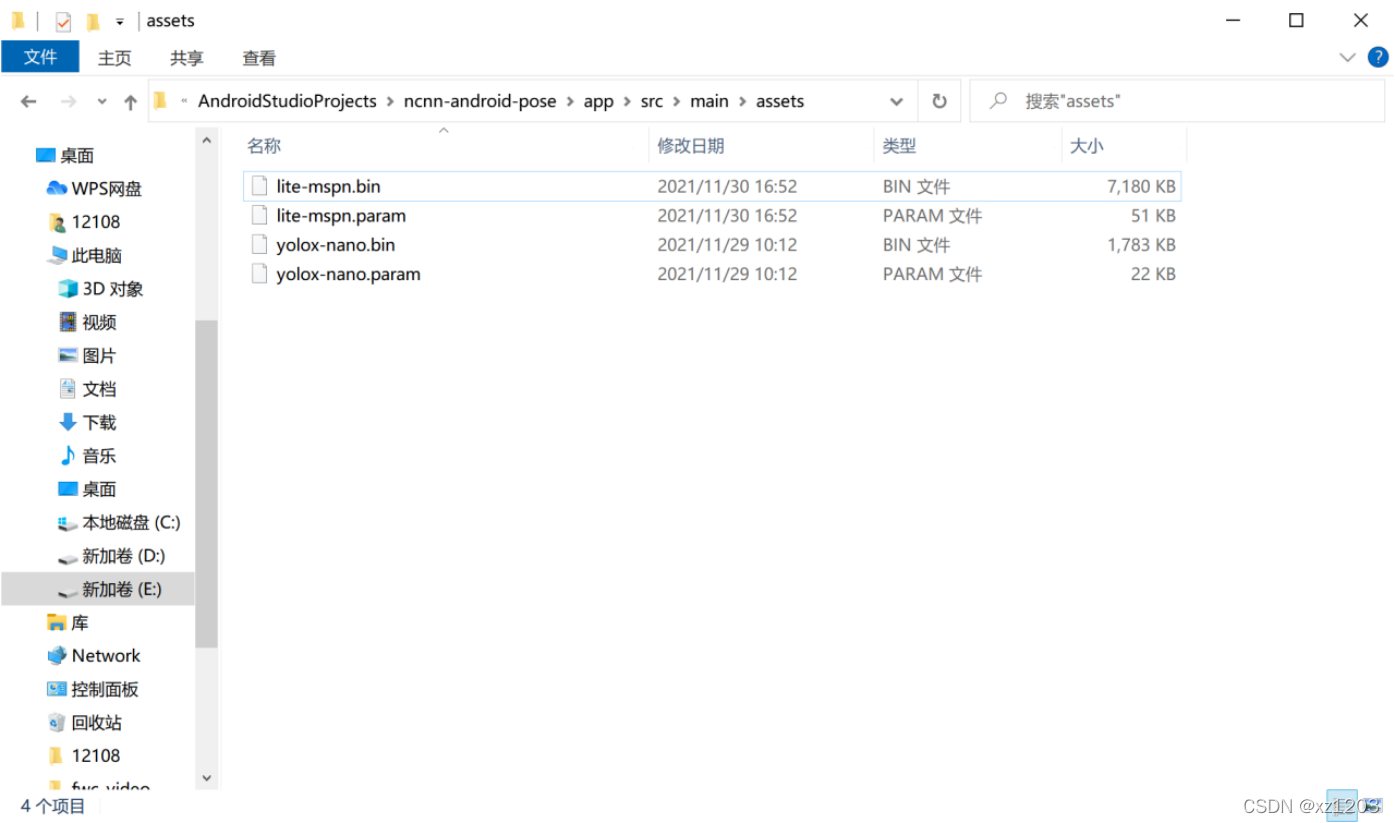

???????由于是部署到移动端,因此我对MSPN进行了轻量化设计,然后再COCO数据集上重新训练得到最后的模型。包括YOLOX采用的也是nano版本。两个模型加起来的大小不超过9M,其中yolox-nano是2M,我的模型是7M。由于时间不足,我没有去对比模型量化前后的精度差异,所以没有对我的模型进行量化操作。

APP大小

???????由于该模型只部署到Android端,而arm-v7a架构适合市面上大部分安卓机,因此我删掉了v8a和x64及x86的库文件,最后APP的大小大约在10M左右。主要体积在模型部分。

总结

???????通过一系列操作,最后也算是成功把人体姿态估计模型部署到Android端了,帧率也还能保持在十几帧。总的来说在手机端的CPU可以到这个程度也不错了。后续可以考虑继续压缩模型,也可以尝试知识蒸馏等方法提升精度。当然,有机会也可以深入了解一下ncnn的原理,或者是硬件方法进一步加速。