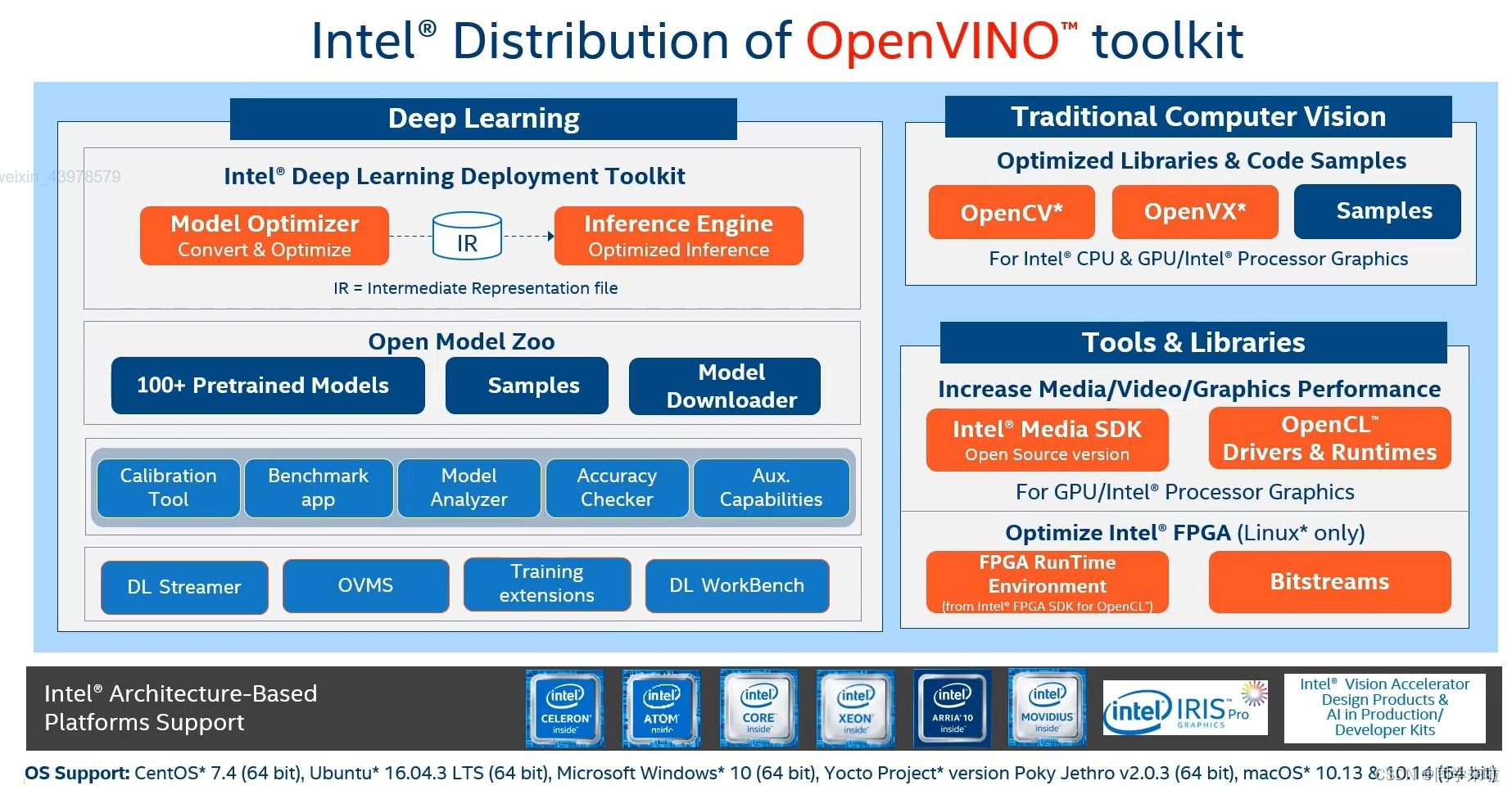

一、Traditional Computer Vision & Tools & Libraries

目前,许多平台和操作系统都支持OpenVINO的运行,并将继续扩大支持范围,支持即将推出的Inter集成显卡以及其他智能硬件。

我们可以看见,OpenVINO工具套件包括最新的最优化的OpenCV*、OpenVX*版本,以及加速视频编程和解码的Media SDK,目前Media SDK正在向Open VPL迁移。值得一提的是,之后FPGA的软件包只会根据需求直接提供,将会从正式版本中逐步分离出来。

二、Deep Learning

OpenVINO里面最重要的部分深度学习部署工具套件(Deep Learning Deployment Toolkit,DLDT)用于深度学习的推理加速,作为模型优化器和推理引擎工具套件的核心,务必掌握其使用方法。其中,模型优化器是推理之前对模型进行预处理的工具,模型优化器会输出基于原始生成的深度学习模型的IR文件,该文件仅能在OpenVINO中使用,而推理引擎可以使用IR文件,在编写的应用中执行深度学习推理请求,IR文件实际上是两个文件,包括xml文件(用于描述网络结构)和bin文件(存储模型参数权重)。

通过模型优化器可以支持各种框架下的模型,包括TensorFlow、Caffe、mxnet、ONNX等。值得一提的是,从2024版本开始,推理引擎可以不通过模型优化器转换,直接读取原生ONNX模型。推理引擎可以使用已经转换好的IR文件,并且对于相同模型只需要一套代码,推理引擎就可以部署在多种设备,如Inter CPU,灵动、酷睿或至强、Inter集成式GPU、Videos、VPU和FPGA进行推理。

使用模型优化器转换是一个离线流程,对于一个模型只需要执行一次,只需要花费几秒钟,一旦有IR文件,推理引擎可以反复使用进行推理。

1、OpenVINO整体流程

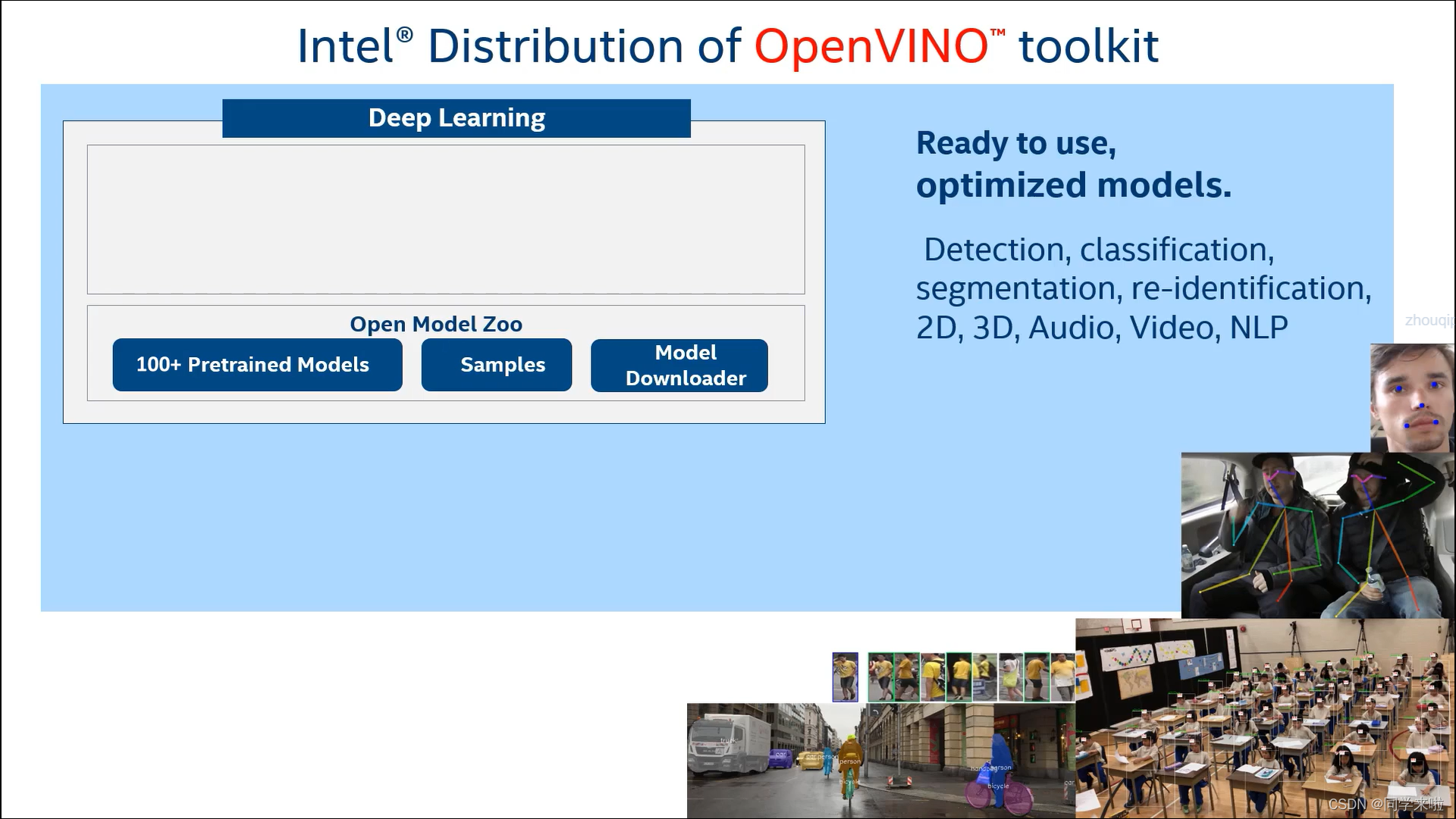

2、Open Model Zoo

Open Model Zoo提供很多直接可以使用的模型,包括检测、分类、分割、重新识别、2D、3D、音频、视频、NLP等。

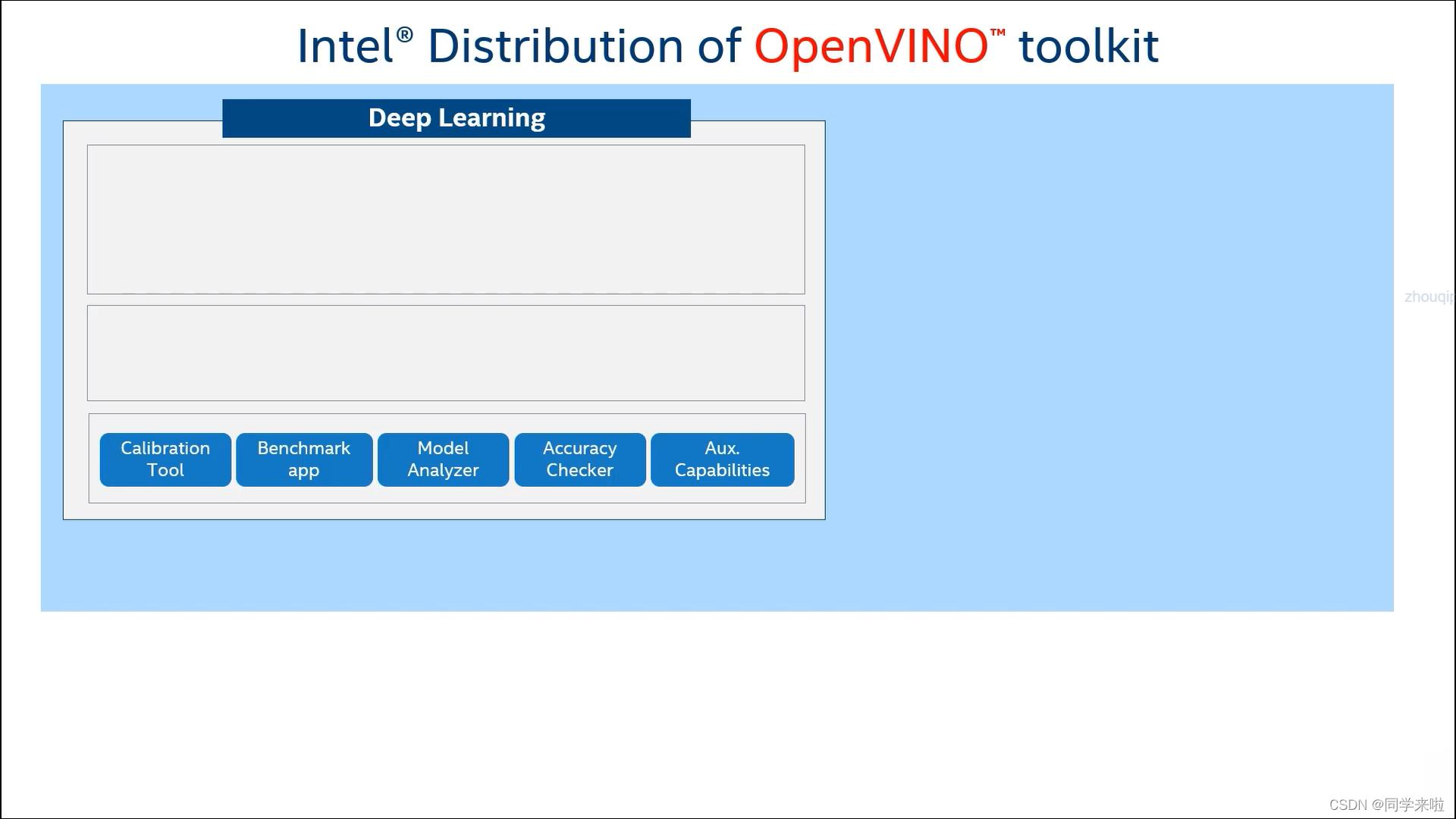

3、性能测试Benchmark工具

包括Benchmark app、Accuracy Checker、Model Analyzer等。

4、其他工具

包括DL Streamer(使用少量代码构建视频分析流程)、OVMS(OpenVINO模型服务器提供推理服务器的全部资料,运行到本地或云端)、训练拓展工具、DL WorkBench(一款可视化的基于Docker的BenchMark工具)。