Abstract & Introduction & Related Work

- 研究任务

自动音频字幕 - 已有方法和相关工作

- 面临挑战

- 创新思路

- 我们提出了第一个明确侧重于利用时间和局部时间频率信息的AAC方法

- 为了生成字幕,我们采用了广泛使用的transformer解码器

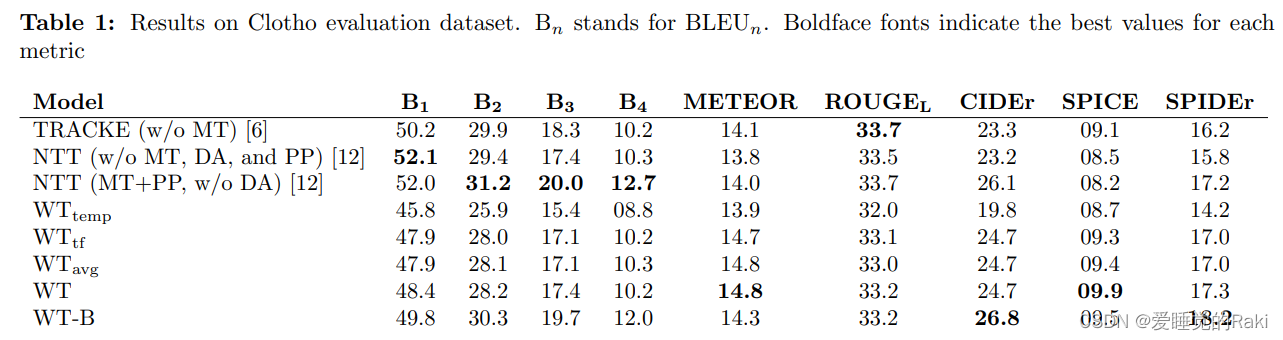

- 实验结论

我们的结果将以前报告的最高SPIDEr从16.2提高到17.3

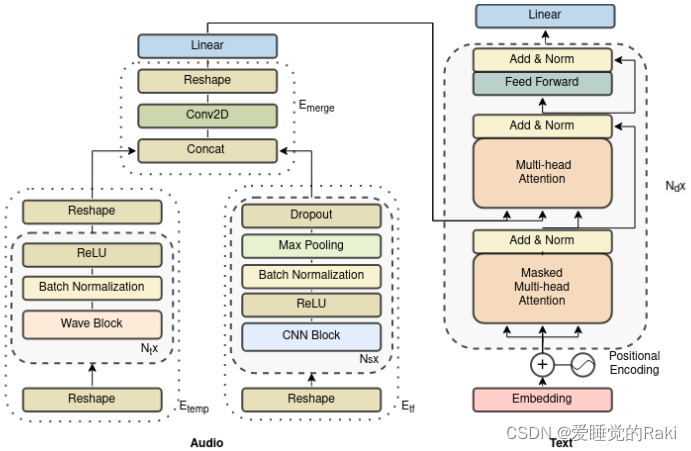

Encoder

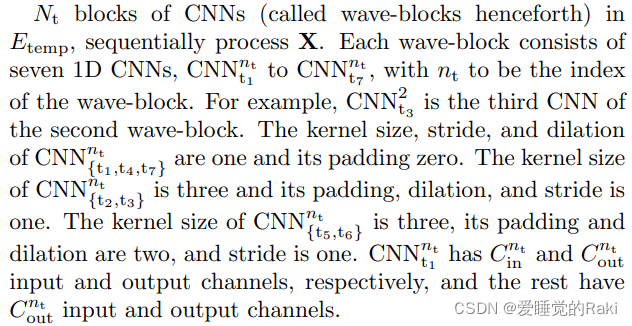

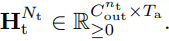

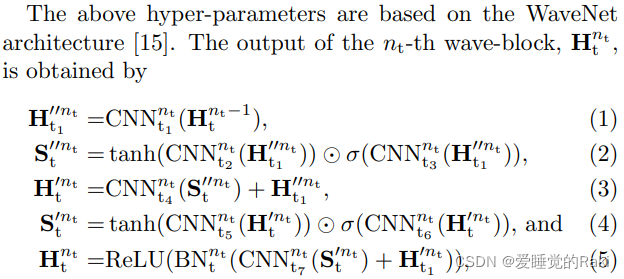

一共有 N t N_t Nt? 个 CNN块,每个wave-block里面还有七个一维CNN卷积

| name | kernel_size | stride | dilation |

|---|---|---|---|

| C N N t 1 , t 4 , t 7 n t CNN_{t_1,t_4,t_7}^{n_t} CNNt1?,t4?,t7?nt?? | 0 | 0 | 0 |

| C N N t 2 , t 3 n t CNN_{t_2,t_3}^{n_t} CNNt2?,t3?nt?? | 1 | 1 | 1 |

| C N N t 5 , t 6 n t CNN_{t_5,t_6}^{n_t} CNNt5?,t6?nt?? | 3 | 2 | 2 |

BN是batch normalization

H

t

0

=

X

t

H_t^0 = X_t

Ht0?=Xt?

所有的CNN都是在X上沿着时间顺序进行操作,使得其能学习到局部信息

每个二维卷积后都接上一个ReLU

S

?

C

N

N

n

t

f

S-CNN^{n_{tf}}

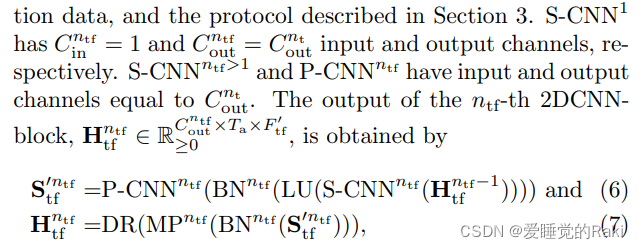

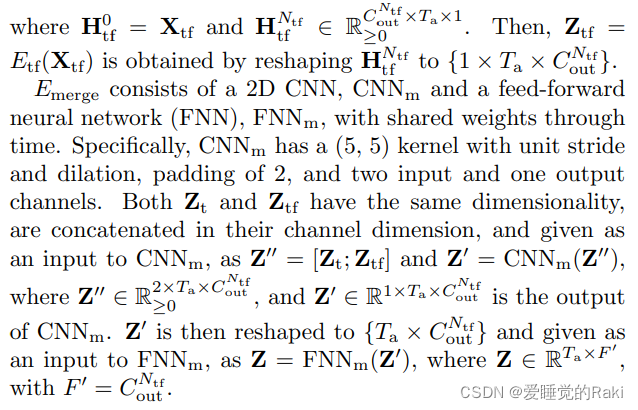

S?CNNntf?有五个不同的5 * 5卷积核,步幅为1,填充为2,PCNN用来学习不同通道的SCNN卷积的输出

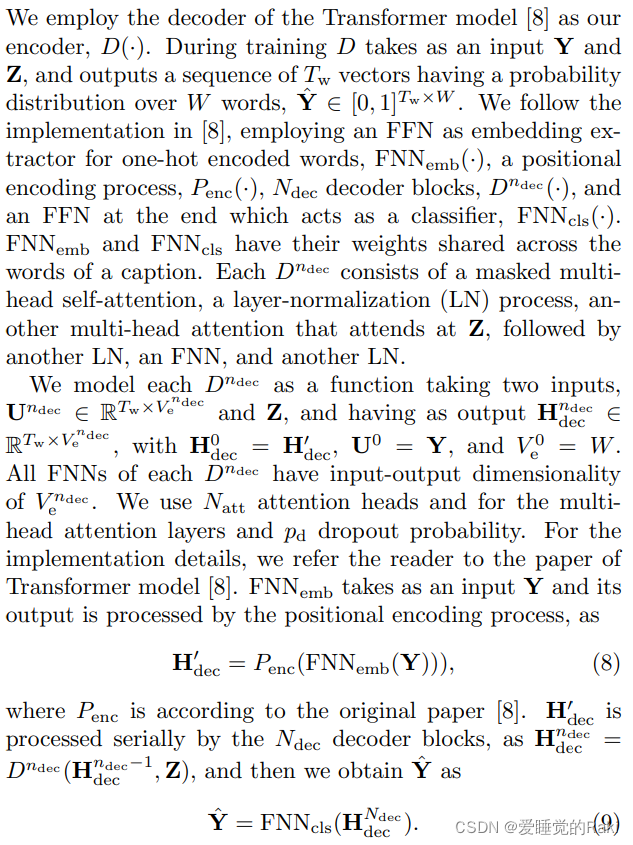

Decoder

Evaluation

Conclusion

在本文中,我们提出了一个新的AAC架构,基于卷积和前馈神经网络,称为WaveTransformer(WT)。WT专注于从音频中学习长时间和时间频率信息,并使用Transformer模型的解码器将其与文本表达出来。我们使用AAC DCASE挑战赛中采用的数据集和指标对WT进行了评估,并将我们的方法与以前的SOTA方法和DCASE AAC基线进行了比较。获得的结果表明,学习时间频率信息,结合良好的语言模型,可以导致良好的AAC性能,但纳入长的时间信息可以提高获得的分数

Remark

请问这篇在写什么玩意啊?您有事吗?