Model LineUpper: Supporting Interactive Model Comparison at Multiple Levels for AutoML

In 26th International Conference on Intelligent User Interfaces(IUI) 2021

Link:https://arxiv.org/pdf/2104.04375.pdf

该文章首发于:https://zhuanlan.zhihu.com/p/474937764

这是一篇关于自动化机器学习(AutoML)中人机交互的论文,来自IBM的Yunfeng Zhang大佬。自动化机器学习中很关键的一步就是模型选择,能够通过人机交互式的方式来选择模型呢?这篇论文介绍了 Model LineUpper,通过集成多种可解释 AI (XAI) 和可视化技术来支持 AutoML 的交互式模型比较。

背景

-

即使是自动化机器学习,在 AutoML 的工作流程中保留人仍然是很重要的, 用户需要特征是具备高透明度的,以此来了解 AutoML 的工作原理,并且可以根据他们的先验知识对特征进行调整。

-

许多AutoML的工作专注于程序透明度(procedural transparency),但很少关注算法透明度(algorithmic transparency)。应该展示下AutoML生成的模型是如何工作的,如何权衡特征的,如何判定特定的实例。

-

可解释 AI (XAI)技术可以帮助了解 ML 模型的内部工作原理。

模型 LINEUPPER

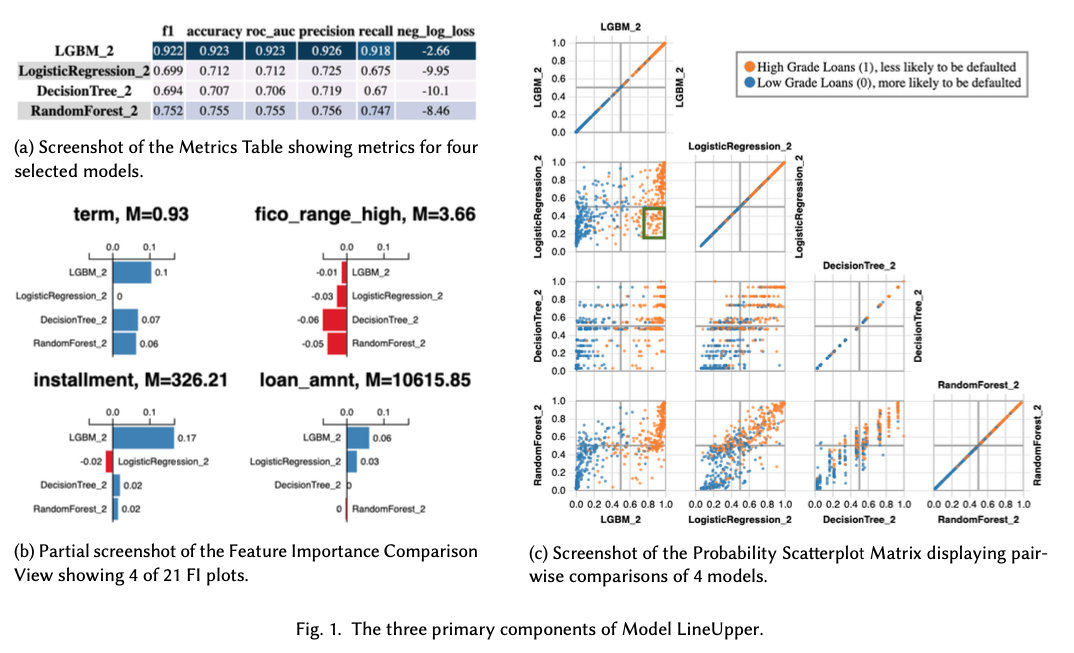

- Model LineUpper,是一种可视化工具,可以为 AutoML 生成的候选模型提供透明度。 Model LineUpper 允许用户基于 AutoML 模型的功能和行为的多个方面进行交互比较, 可以帮助参与者根据不同的标准选择模型,例如错误类型和与领域知识的一致性。

- LineUpper通过三个视图来支持可解释性和实例级调查。(1)metric表;(2)特征重要性(FI)比较;(3)概率散点图矩阵

- 第三个视图是从实例的角度分析的,这个图挺有意思的。每个点代表一个数据实例,其 (𝑥,𝑦) 坐标对应于两个模型预测该实例为高等级的概率。象限和颜色表示两个模型预测的真/假和阳性/阴性。两个模型一致,点就在象限 1 或 3,两个模型预测不一致,点就在象限 2 和 4。象限 1 中的蓝点表示两个模型的预测错误,而象限 2 中的蓝点表示仅是 𝑦 轴代表的模型预测错误。点的分布模式有助于比较两个模型的置信度,因为轴末端的更密集的线表示对应于轴的置信度更高的模型。

- 作者说这种矩阵的设计是受到了Manifold [1]的启发,有机会看一下。

数据

学习任务是贷款风险预测的二分类任务。数据集有 47 个特征和 11,553 个实例(即贷款申请)。模型预测申请的等级(还款的可能性),两类标签分别是:贷款是高等级(原始数据集中的 A 级和 B 级)和低等级(C 到 G 级)。

实验:User Study

这部分比较有意思,是做关于人的实验。

- 实验目的:评估 Model LineUpper 的设计,;了解 AutoML 的用户如何参与模型比较任务。

- 实验内容:设计了一个基于场景的上下文查询,参与者被要求扮演数据科学家的角色,构建一个机器学习模型来帮助信贷员评估贷款申请人。实验开始时,向参与者展示了由 IBM 的 AutoML 系统生成的 16 个模型,参与者的任务是使用 Model LineUpper 来选择最佳模型。

- 实验设计:更进一步,为了探究模型比较时候的标准不一样带来的影响,实验还设计了一个环节:相关人员提出对模型的不同偏好,并要求参与者重新考虑他们的选择。具体场景包括: 1) 一位高管表示他们更喜欢可解释的模型; 2) 一位信贷员表示,模型的基本原理与其关注的特征保持一致是很重要的; 3) 一位高管表示避免向可能违约的人提供贷款的重要性(降低误报率)。

- 实验过程:14位数据科学家参加了实验。完成上述三个实验场景,采访10-15分钟,最后填写调查问卷。

然后就是对视频、问卷、访谈的一些分析了,总结出AutoML工具设计中应该有哪些地方可以改进等等。

引用

- Jiawei Zhang, Yang Wang, Piero Molino, Lezhi Li, and David S. Ebert. [n.d.]. Manifold: A Model-Agnostic Framework for Interpretation and Diagnosis of Machine Learning Models. 25, 1 ([n. d.]), 364–373. https://doi.org/10/ggsr89 arXiv:1808.00196