本文按照北京邮电大学计算机学院鲁鹏老师的计算机视觉与深度学习课程按章节进行整理,需要的同学可借此系统学习该课程详尽知识~

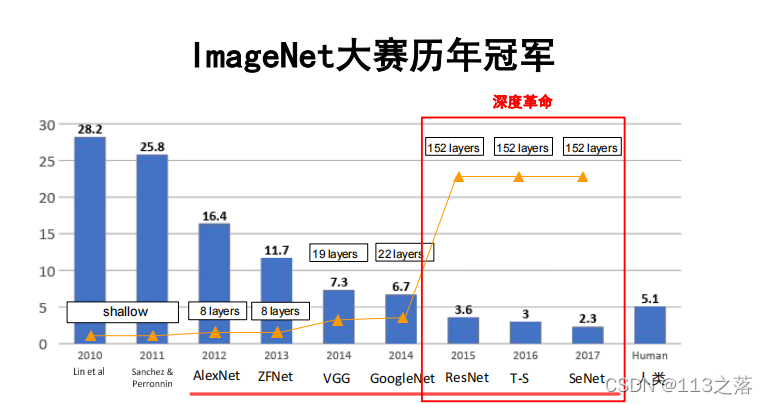

ImageNet大规模视觉识别挑战赛(ILSVRC)

? 计算机视觉领域最具权威的学术竞赛之一;

? ImageNet数据集——由斯坦福大学李飞飞教授主导制作,其包含了超过1400万张全尺寸的有标记图片;

? ILSVRC从ImageNet数据集中抽出子集作为竞赛数据。

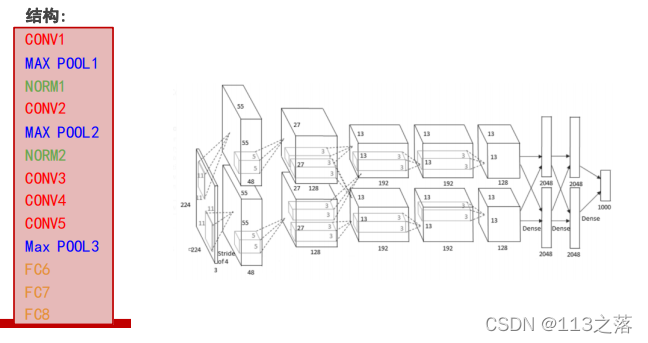

一、AlexNet

AlexNet——验证了深度卷积神经网络的高效性

主体贡献

- 提出了一种卷积层加全连接层的卷积神经网络结构;

- 首次使用ReLU函数做为神经网络的激活函数;

- 首次提出Dropout正则化来控制过拟合;

- 使用加入动量的小批量梯度下降算法加速了训练过程的收敛;

- 使用数据增强策略极大地抑制了训练过程的过拟合;

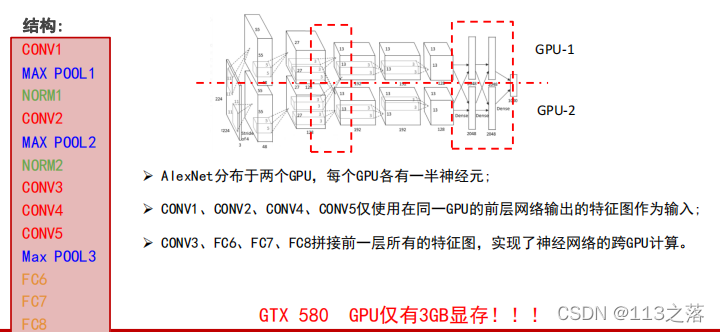

- 利用了GPU的并行计算能力,加速了网络的训练与推断。

重要说明

? 用于提取图像特征的卷积层以及用于分类的全连接层是同时学习的;

? 卷积层与全连接层在学习过程中会相互影响、相互促进。

重要技巧

? Dropout策略防止过拟合;

? 使用加入动量的随机梯度下降算法,加速收敛;

? 验证集损失不下降时,手动降低10倍的学习率;

? 采用样本增强策略增加训练样本数量,防止过拟合;

? 集成多个模型,进一步提高精度。

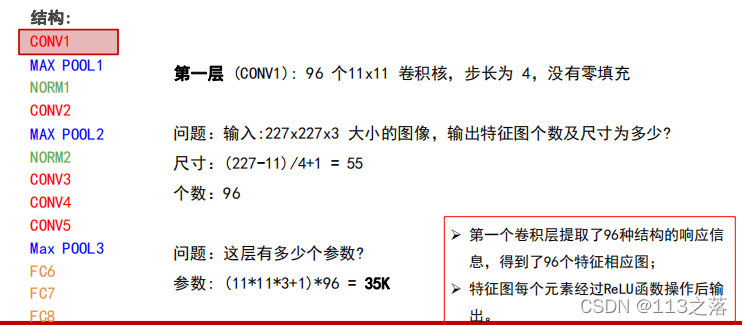

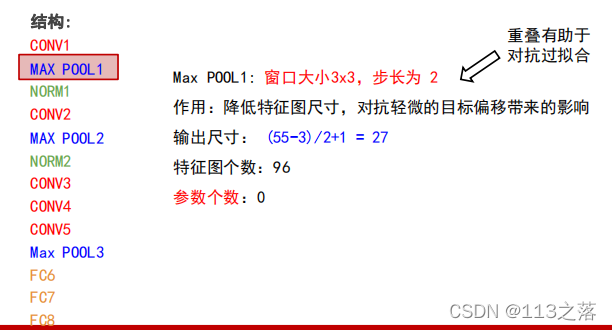

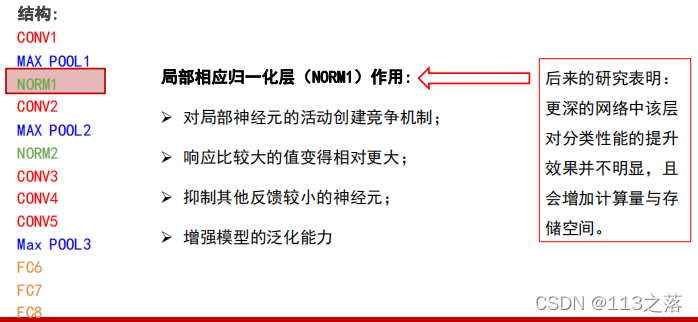

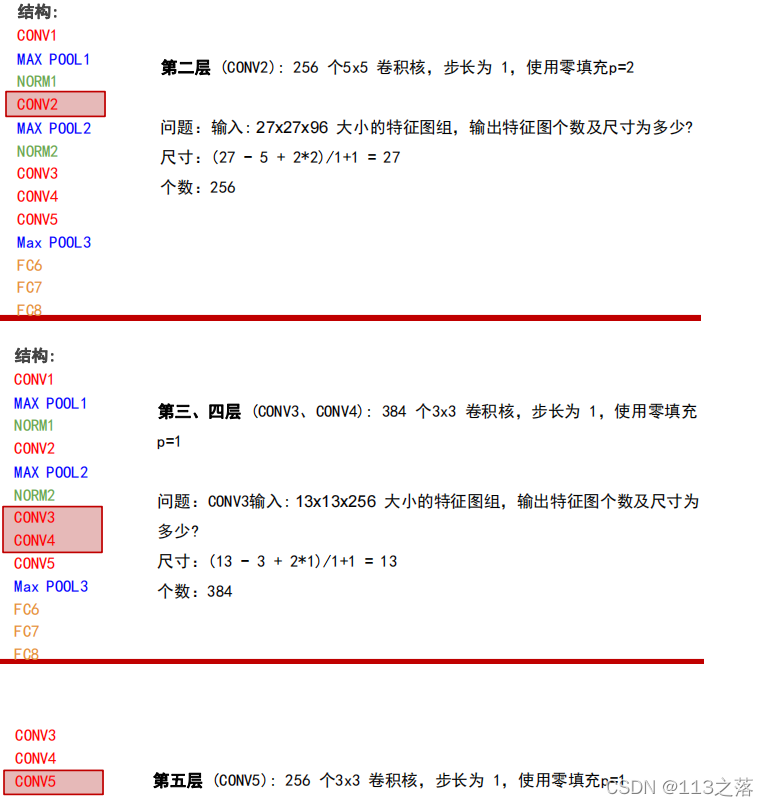

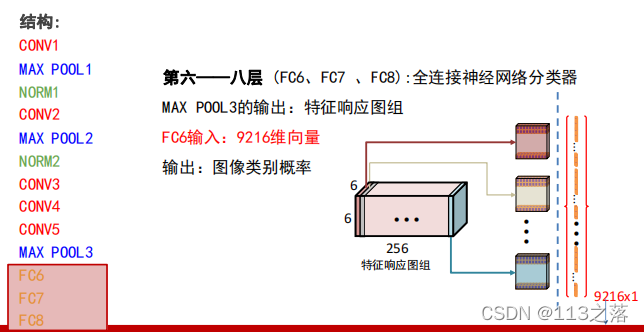

总结结构

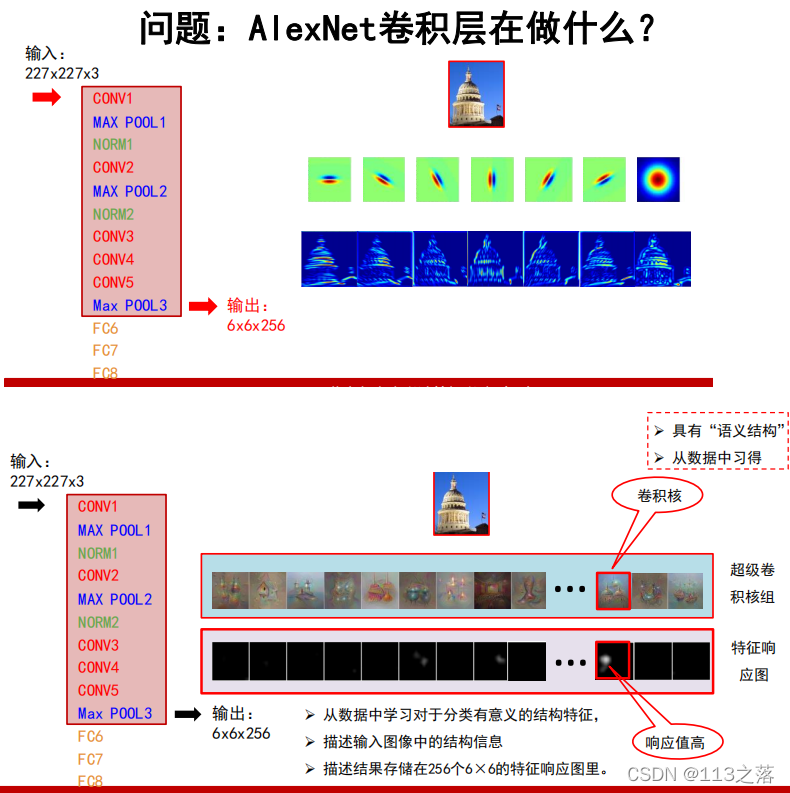

重点问题

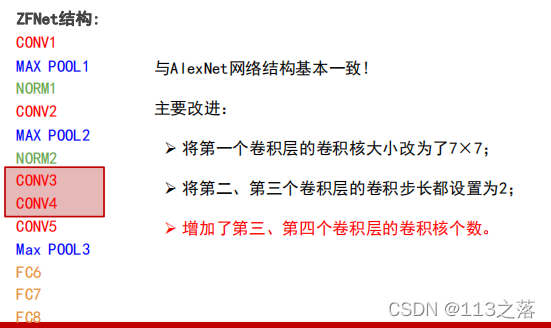

二、ZFNet

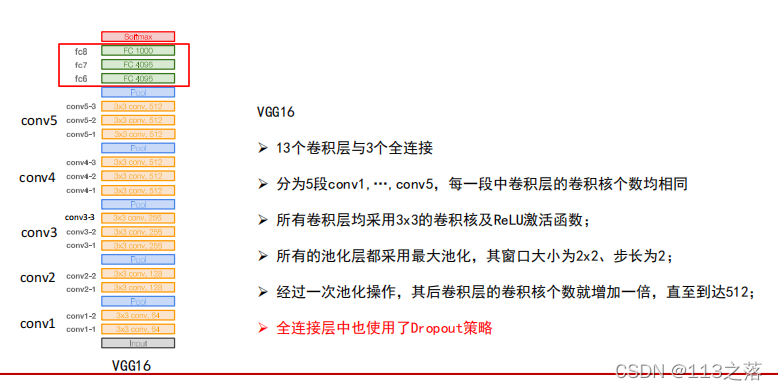

三、VGG

VGG网络贡献

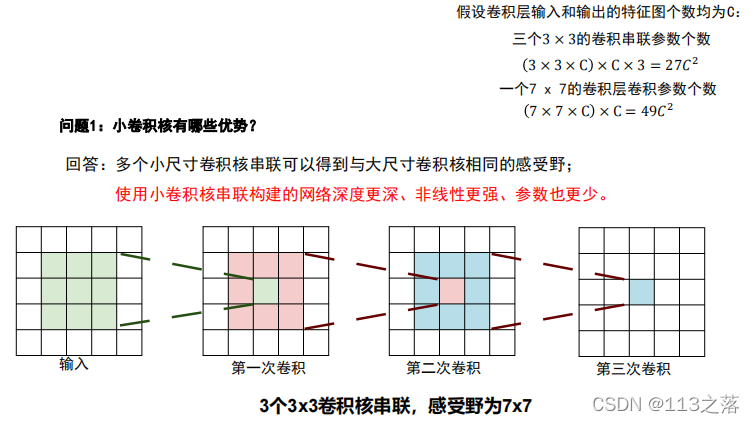

- 使用尺寸更小的3x3卷积核串联来获得更大的感受野;

- 放弃使用11x11和5x5这样的大尺寸卷积核;

- 深度更深、非线性更强,网络的参数也更少;

- 去掉了AlexNet中的局部响应归一化层(LRN)层。

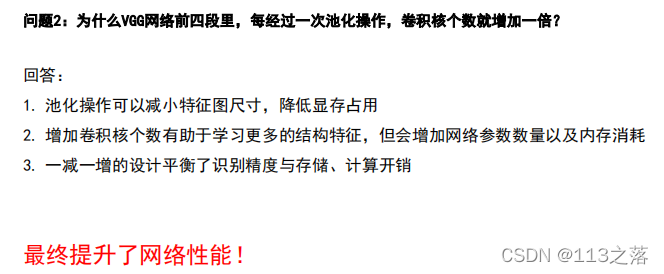

重点问题

注:

串联结构(如VGG)存在的问题

后面的卷积层只能处理前层输出的特征图;前层丢失重要信息,后层无法找回。

解决方案

每一层尽量多的保留输入信号中的信息。

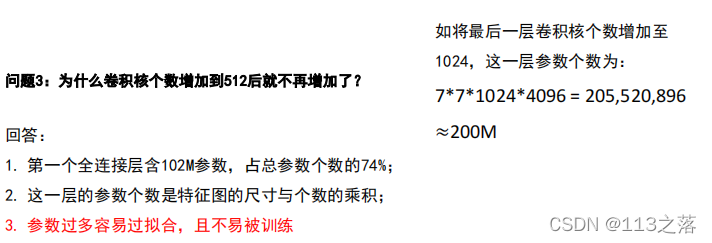

四、GoogleNet

GoogleNet创新点

- 提出了一种Inception结构,它能保留输入信号中的更多特征信息;

- 去掉了AlexNet的前两个全连接层,并采用了平均池化,这一设计使得GoogLeNet只有500万参数,比AlexNet少了12倍;

- 在网络的中部引入了辅助分类器,克服了训练过程中的梯度消失问题。

网络分析

? VGG的第一个全连接层参数占了整个网络74%的参数,需dropout策略应对过拟合。

? GoogLeNet采用平均池化,GoogLeNet的参数总量不到500万, 无须使用Dropout策略。

? 原因:虽然ReLU单元能够一定程度解决梯度消失问题,但是并不能完全解决深层网络难以训练的问题。离输出远的层就不如靠近输出的层训练得好。

? 结果:让低层的卷积层学习到的特征也有很好的区分能力,从而让网络更好地被训练,而且低层的卷积层学到了好的特征也能加速整个网络的收敛。

? 网络推断:仅利用网络最后的输出作为预测结果,忽略辅助分类器的输出。

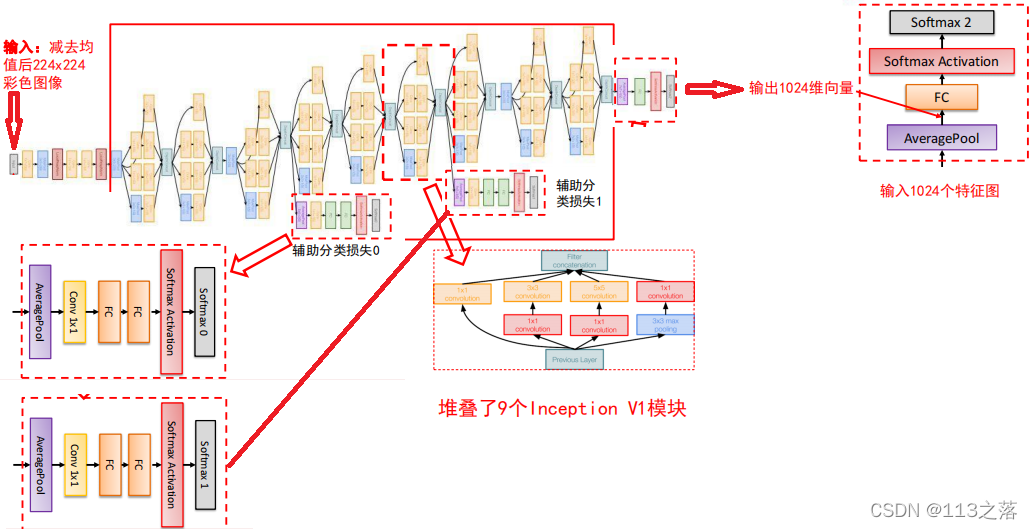

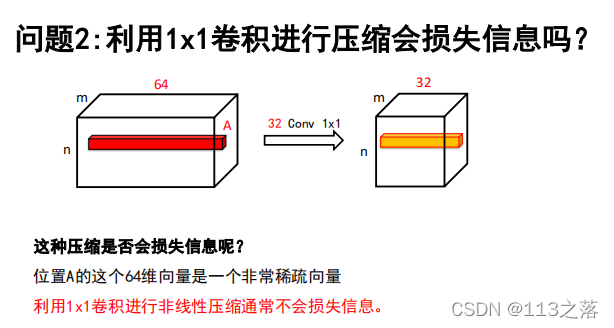

重点问题

五、ResNet

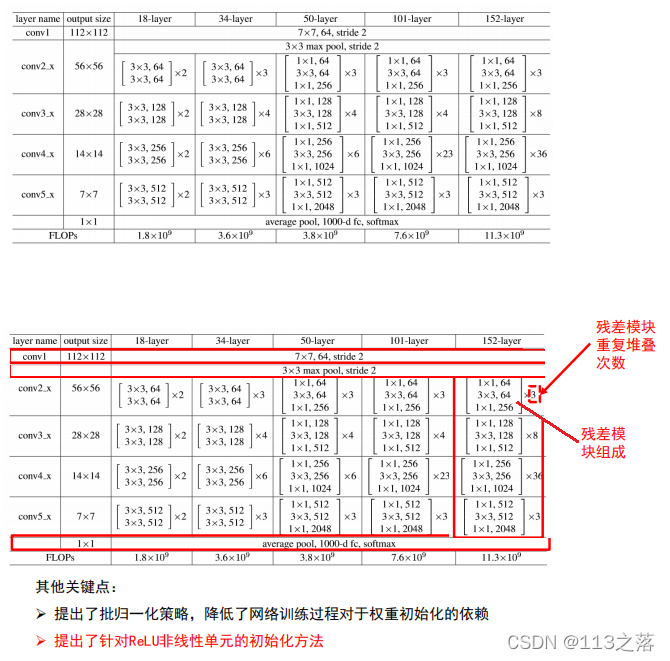

ResNet贡献

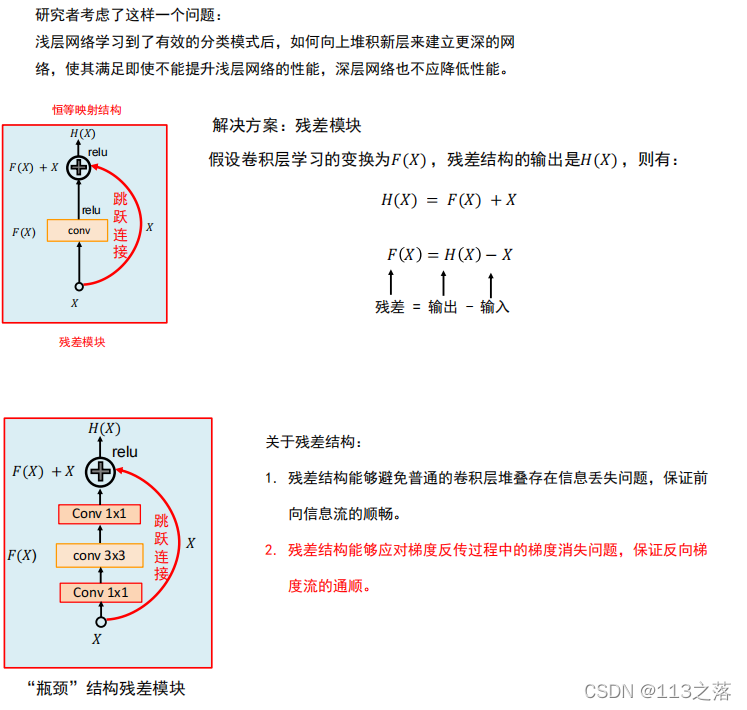

- 提出了一种残差模块,通过堆叠残差模块可以构建任意深度的神经网络,而不会出现“退化”现象;

- 提出了批归一化方法来对抗梯度消失,该方法降低了网络训练过程对于权重初始化的依赖;

- 提出了一种针对ReLU激活函数的初始化方法。

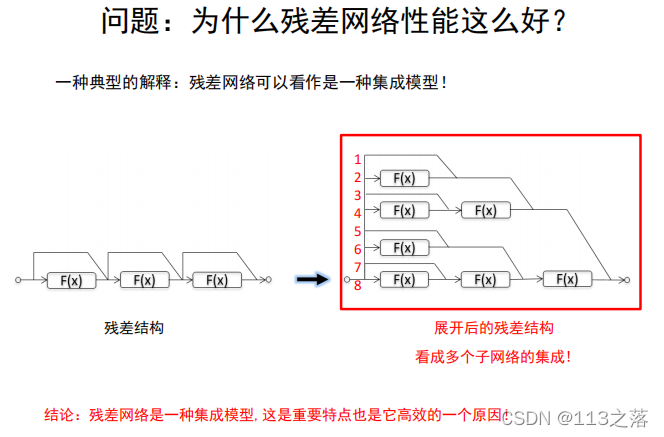

重点问题

总结

? 介绍了5种经典的卷积神经网络AlexNet、ZFNet、VGG、GoogLeNet和ResNet;

? 残差网络和Inception V4是公认的推广性能最好的两个分类模型;

? 特殊应用环境下的模型:面向有限存储资源的SqueezeNet以及面向有限计算资源的

MobileNet和ShuffleNet。