该论文是《MobileNetV2: Inverted Residuals and Linear Bottlenecks》。

1. 研究问题

研究新的移动架构。

2. 研究方法

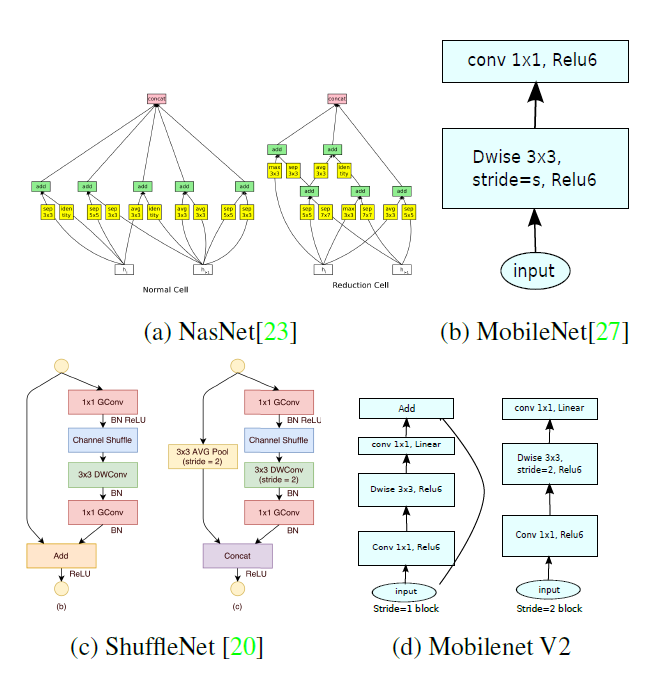

MobileNetV2提出了两个创新点:倒置的残差结构和线性瓶颈。其中倒置的残差结构相比于MobileNetV1的残差结构可以提取更多特征,线性瓶颈替代非线性ReLU可以减小特征损失。

2.1 线性瓶颈

这部分有一个很难懂的概念——感兴趣的流形(manifold of interest)。意思就是说网络的每一层都是对感兴趣的流形的学习,这些流形可以通过降维(比如1*1卷积)嵌入到低维空间中。

文章举了个例子,MobileNetV1中的宽度乘数可以减小激活空间的维度,这个就是将感兴趣流形嵌入到低维空间中。通过低维嵌入,直到感兴趣流形跨越整个空间,此时网络能达到准确度和计算代价的最佳平衡。

但由于ReLU非线性激活层的非线性化,会打破以上的一个假想。因为加上ReLU后,深度网络仅在非零部分具有线性分类器的能力。这里的意思是ReLU使得原有的特征丢失了一部分。

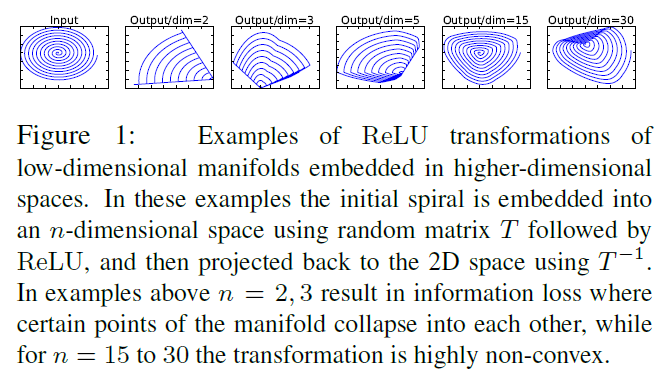

紧接着,文章做了一个实验,证明了将输入流形嵌入到低维空间中,那么 ReLU 变换会保留信息,同时将所需的复杂性引入可表达的函数集。实验结果如下所示:

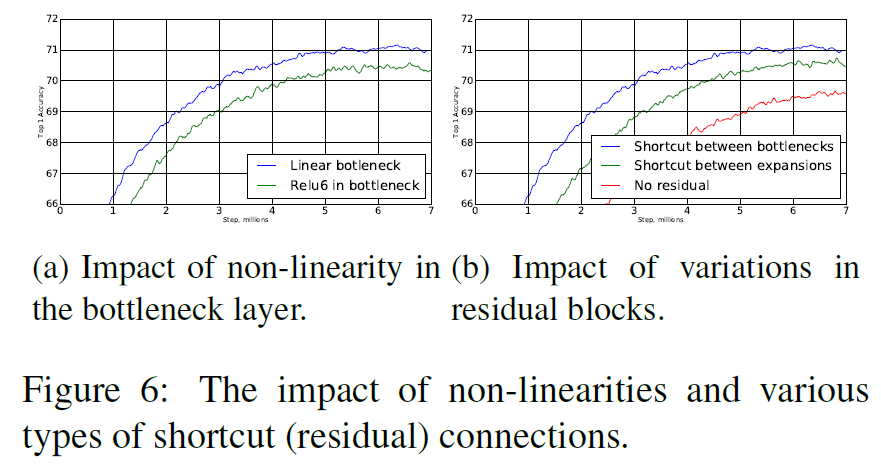

上面已经可以得到一个结论:ReLU本身会损坏特征信息,所以,文章的第一个创新点就是线性瓶颈,意思就是将原始残差块中的低维流形后的ReLU去掉,而替换为线性的1*1卷积。

2.2 倒置的残差结构

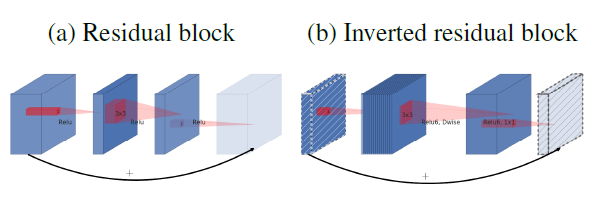

不多说,直接上图。。。

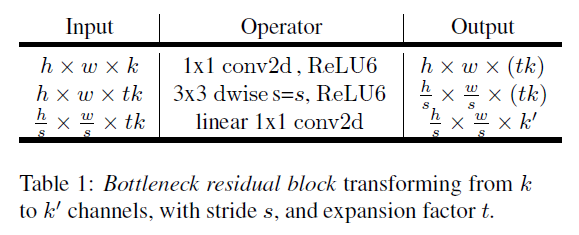

上面两图首先是标准残差和倒置残差的对比,下图是倒置残差的bottlenect结构,t是扩张率,大于1.

标准残差是先“压缩”,后“扩张”。而倒置残差是先“扩张”,后“压缩”,目的是为了提取更多的特征。因为MobileNet是轻量化网络,如果使用标准残差的bottlenect会倒置特征损失过多。

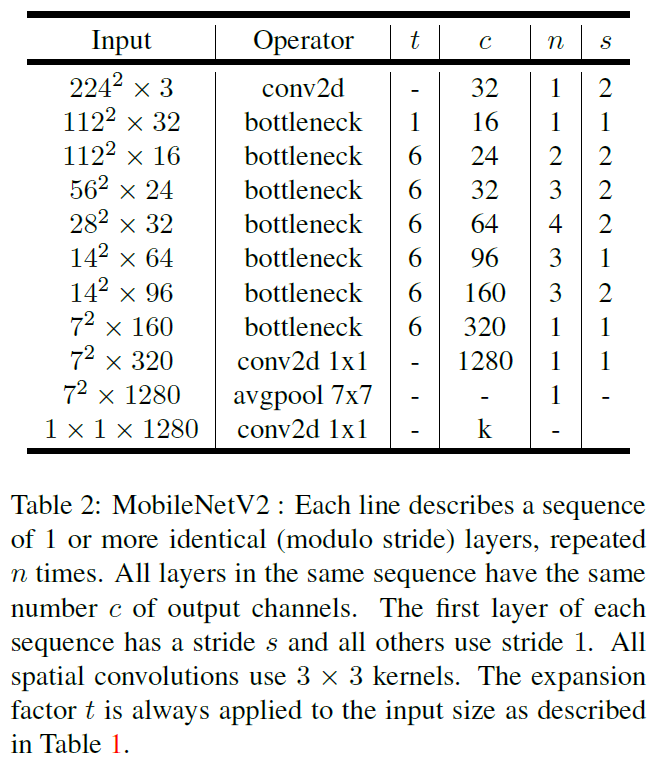

倒置残差沿用了MobileNetV1中的深度可分离卷积,下面给出本文所提出的总体架构:带有线性瓶颈的倒置残差结构。

2.3 MobileNetV2的网络结构

3. 实验结果

3.1 ImageNet 分类

3.2 目标检测

文章基于所提出的MobileNetV2架构,提出了SSDLite网络,该网络是将MobileNetV2和SSD结合。

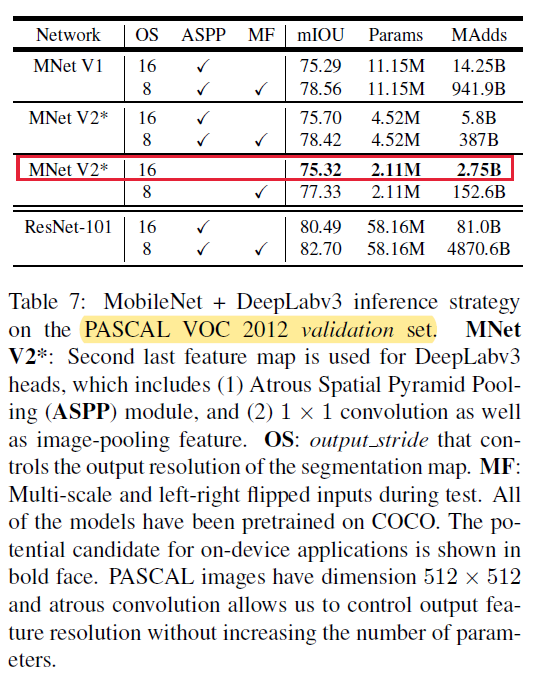

3.3 语义分割

文章基于所提出的MobileNetV2架构,提出了Mobile DeepLabv3网络,该网络是将MobileNetV2用作特征提取,将DeepLabv3用作头。在PASCAL VOC 2012上进行实验。结果如下:

3.4 消融实验

4. 结论

残差块中最后一个卷积后不要加ReLU,可以减小特征损失。