论文名称:A Unified MRC Framework for Named Entity Recognition

?1. 解决问题

?1. 解决问题

解决Flat and Nested NER任务。传统解决方案:将NER看作是序列标注问题(sequence labeling problem),本文提出采用MRC框架(machine reading comprehension)来解决NER任务。

2. 主要思想

本文中提出了采用MRC来解决NER问题,将提取实体标签被形式化为基于问题从上下文中抽取答案块。这样做的好处:

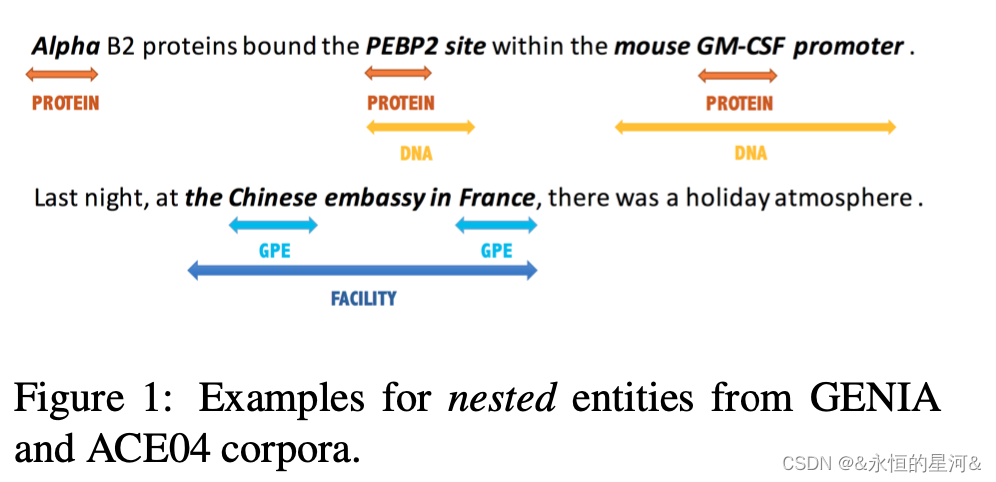

- 可以解决实体嵌套的问题,图1 所示。

- 问题编码中包含了丰富的先验知识,可以提升模型的性能。

- 在flat ner数据集nested ner数据集上都达到了SOTA的结果。

图1 实体嵌套

3. 方法论

3.1 形式化表示

设: X = {x1 , x2 , ..., xn },Y 表示所有可能的标签类型(例如: PER, LOC, 等),n 表示句子的长度,X 表示输入句子,目标是从 X 中找到每个实体,并给它们赋予标签y, y属于Y。

3.2 输入数据处理

首先,将NER数据集标注转化为 (QUESTION, ANSWER, CONTEXT)元组。对于标签类型y属于Y, 它被分配一个问题qy = {q1, q2, ..., qm},m 表示问题的长度。一个标注实体xstart,end = {xstart , xstart+1 , · · · , xend-1 , xend }是 X 的子串,满足start <= end,并且被分配一个标签y。

图2 MRC中NER数据集单个句子标注表示?

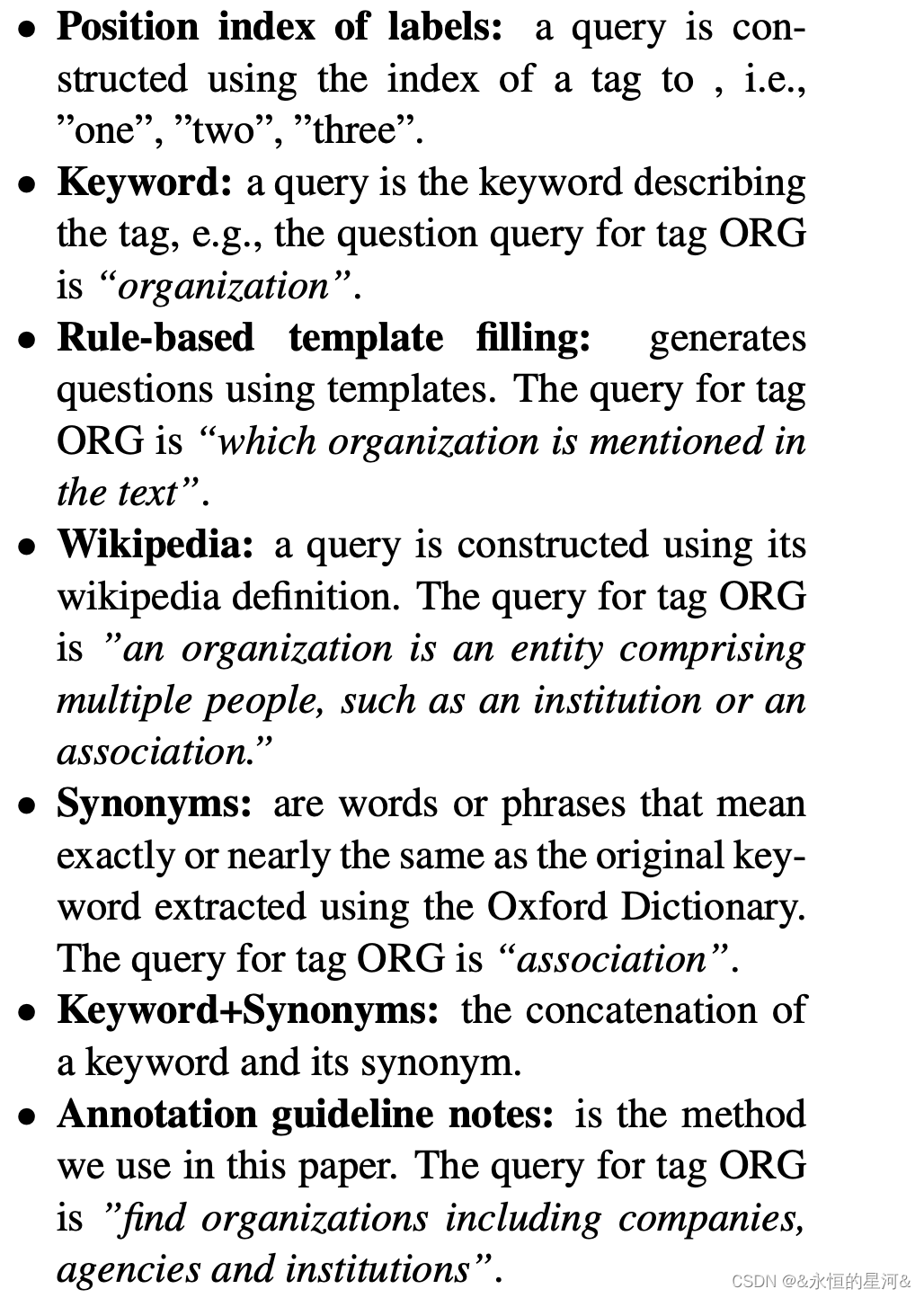

3.3 问题产生

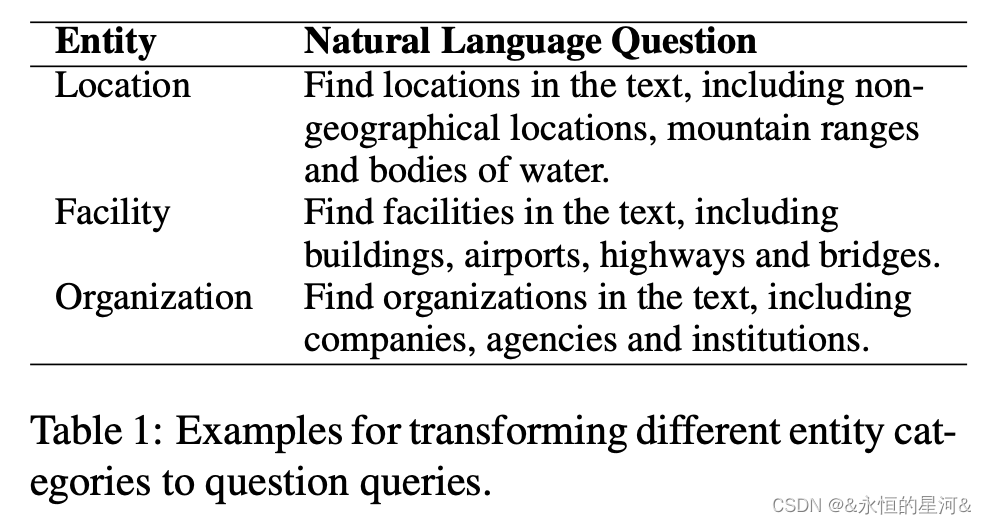

问题生成过程很重要,因为问题编码了关于标签的先验知识,并且对最终结果有重大影响。在本论文中,作者以标注解释作为参考来构造问题。标注注释指南是数据集生成器向数据集注释者提供的指南。它们是标签类别的描述,描述得尽可能通用和精确,以便人类标注者可以在任何文本中注释概念或提及,而不会产生歧义。示例如图3所示。

?图3 将问题转化为对应的问题描述的案例

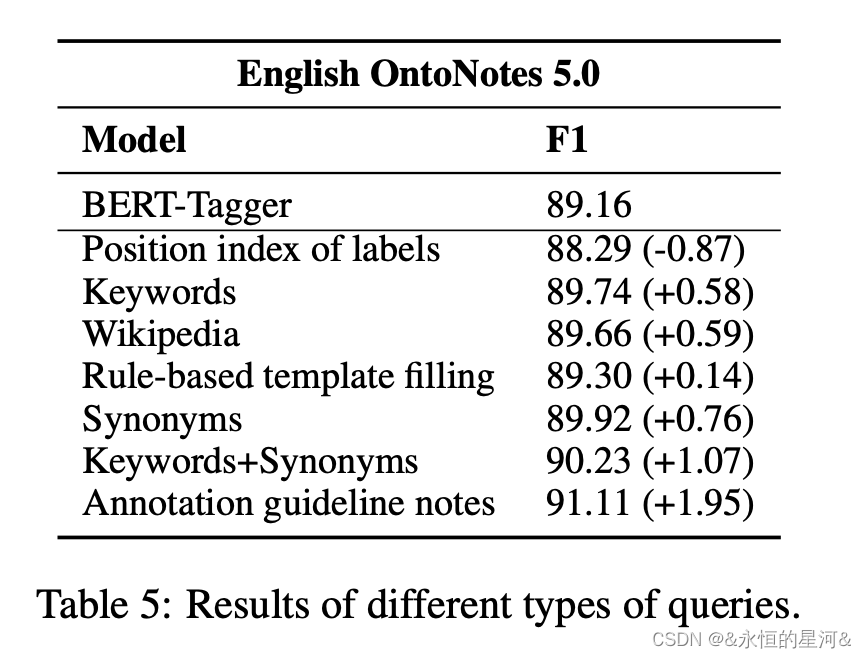

?不同类型query定义模型结果对比

query构造方式

3.4 Model Backbone

文中使用了BERT作为Backbone,对上下文X 和问题qy进行concat,形式如图4。

图4 Bert输入形式?

最终Bert输出是上下文表示向量![]() ,d是Bert最后一层的向量维度,于此同时drop掉了query representations。

,d是Bert最后一层的向量维度,于此同时drop掉了query representations。

3.5?Span Selection

方法一:分别用两个n-class分类器来预测start和end的index,n表示上下文的长度。然后使用softmax function进行作用,这种策略的缺点是仅仅能够基于给定的query输出单个span。

方法二:分别使用两个binary classifiers分类器,第一个分类器用来预测每个token是否文start的index,第二个分类器来预测每个token是否为结束的index。

方法二相比方法一,能基于给定的query和context输出多个start和end的index,进而基于qy抽取出所有潜在的实体。本文采用第二种策略来抽取实体。

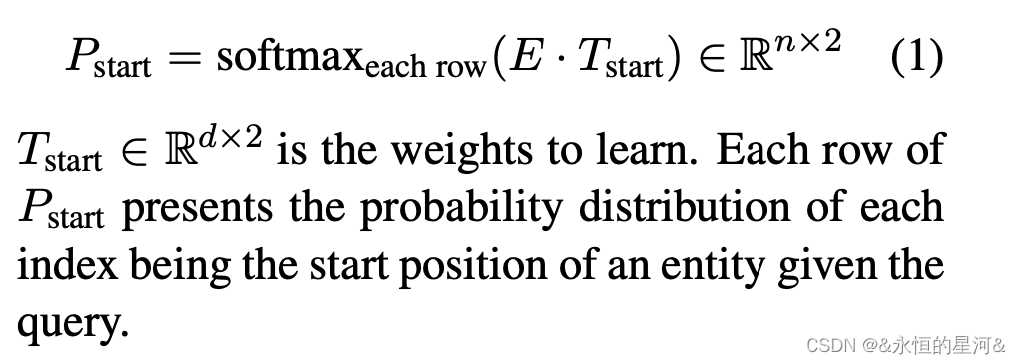

3.5.1?Start Index Prediction

E: 表示Bert的输出矩阵,模型预测每个token是否为start index公式如图5,![]() 中每一行表示每个索引的概率分布。

中每一行表示每个索引的概率分布。

图5 模型预测每个token是否为开始index方式?

3.5.2?End Index Prediction

每个token是否为结束index的预测公式同图5,但是引入了矩阵![]() 来获得概率矩阵

来获得概率矩阵![]() 。

。

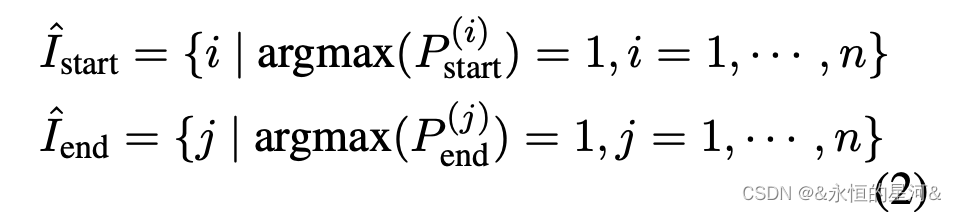

3.5.3?Start-End Matching?

目的:利用3.5.1中预测的开始index和3.5.2中预测的结束index来匹配实体可能的开始或结束index,并计算他们能构成实体的概率。

实现方法:

(1).对?![]() 的每一行应用argmax,从而获得可能的开始或结束的index,

的每一行应用argmax,从而获得可能的开始或结束的index,![]() ,具体公式如图6.

,具体公式如图6.

图6 开始和结束index索引的获取?

上标(i)表示矩阵的第i行。

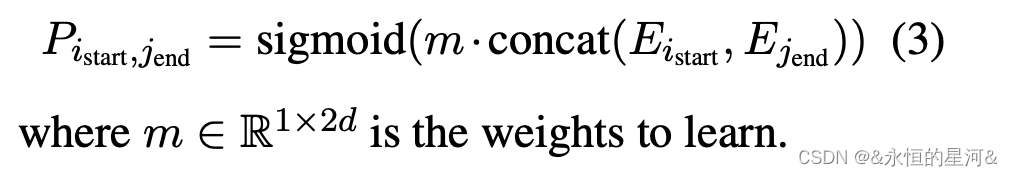

(2)给定任意的![]() 和

和![]() ,a binary classification被训练来预测他们匹配的概率,公式如图7:

,a binary classification被训练来预测他们匹配的概率,公式如图7:

图7 预测任意开始index和结束index匹配的概率?

?3.6?Train and Test

在训练阶段:

![]() 与两个标签序列

与两个标签序列![]() 的长度n代表

的长度n代表![]() 作为任何实体的开始索引或结束索引的真实标签。因此,有如下两个损失函数,如图8:

作为任何实体的开始索引或结束索引的真实标签。因此,有如下两个损失函数,如图8:

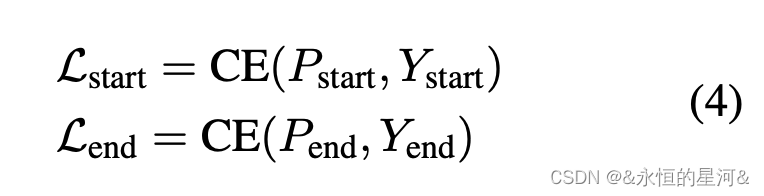

?图8 实体开始index和结束index预测损失函数

另![]() 表示每个开始索引是否应与每个结束索引匹配的金色标签。开始和结束index匹配损失如图9:

表示每个开始索引是否应与每个结束索引匹配的金色标签。开始和结束index匹配损失如图9:

图9 开始和结束匹配损失

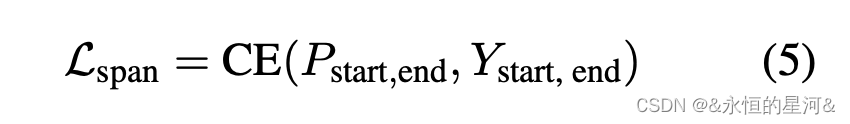

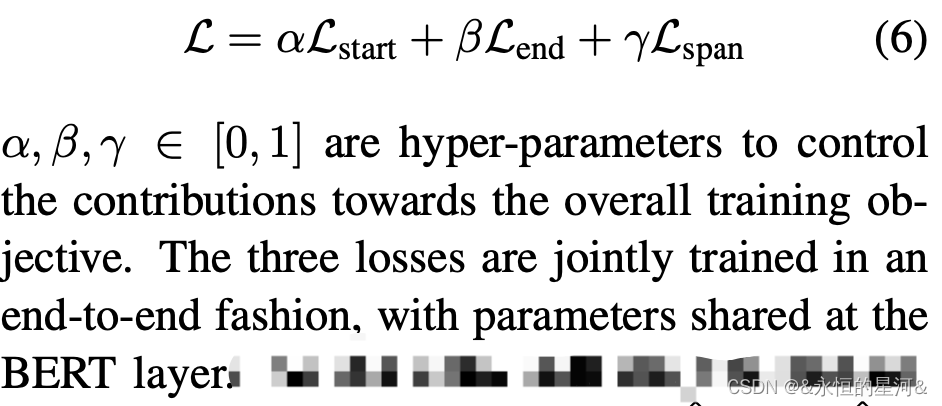

?整个训练损失如图10,对模型进行优化:

?图10 训练损失

?在测试阶段:

首先根据![]() 分别选择开始索引和结束索引。然后使用索引匹配模型将提取的起始索引与结束索引对齐,从而得到最终的提取答案。

分别选择开始索引和结束索引。然后使用索引匹配模型将提取的起始索引与结束索引对齐,从而得到最终的提取答案。

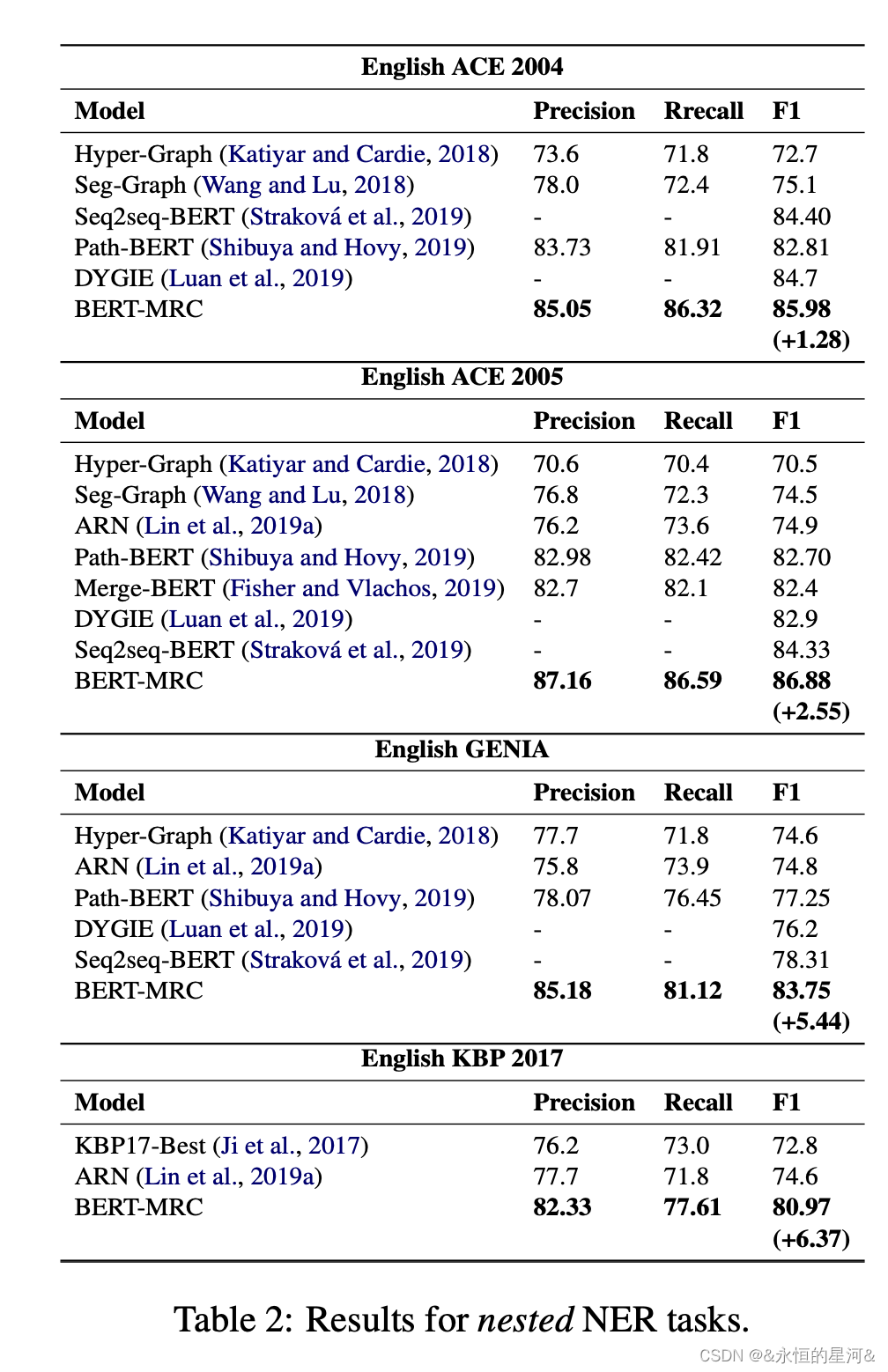

4. 模型对比

在Nested Ner Datasets上对比:

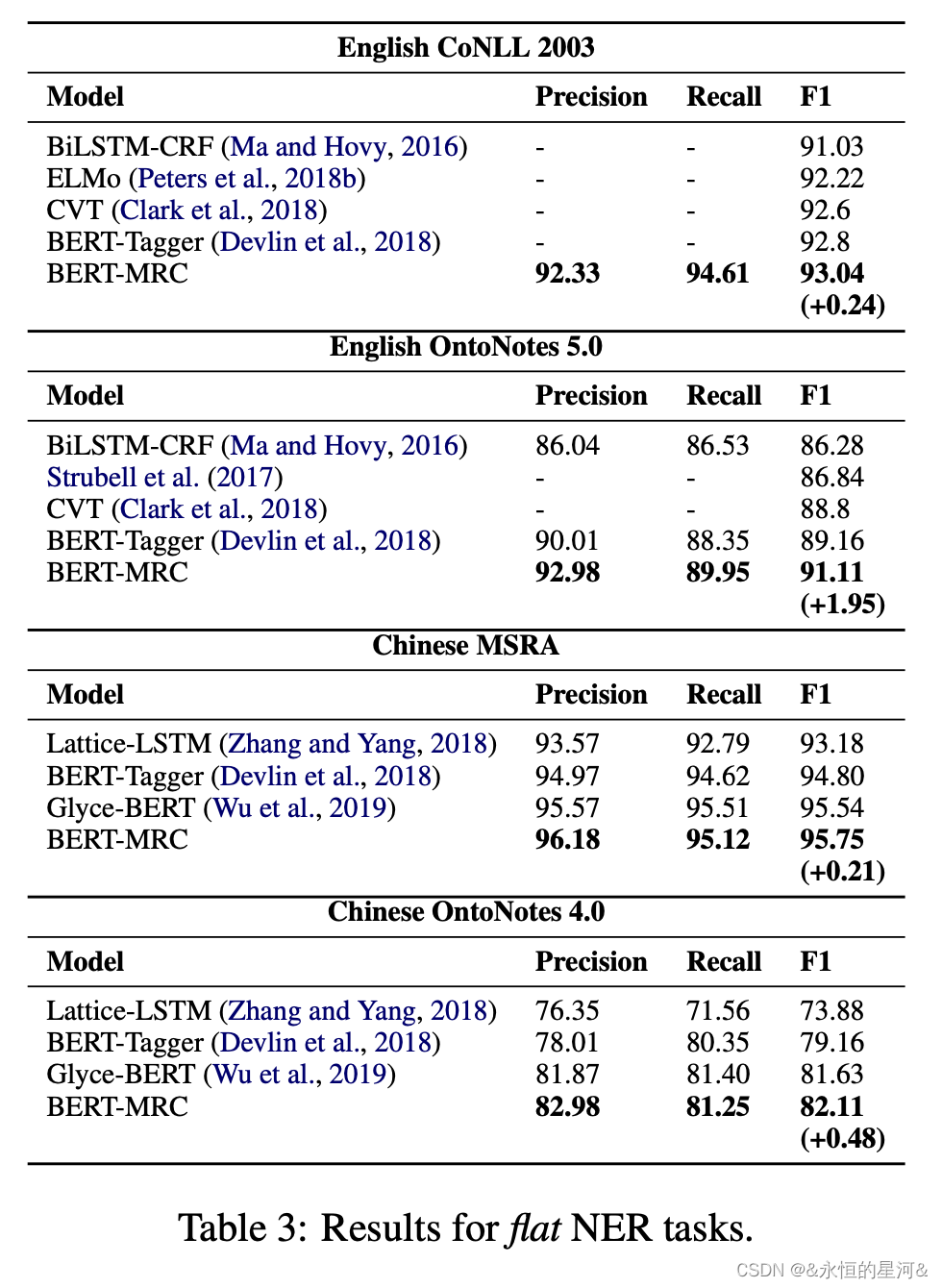

?在Flat NER Datasets对比

5. 总结

在本文中,将NER任务重新定义为MRC问答任务。这种形式化有两个关键优势

- 能够处理重叠或嵌套的实体

- query encode实体类别重要先验知识。该方法在嵌套和flat NER数据集上都得到了SOTA结果,表明了其有效性。