Bert模型学习之预训练模型的简单应用

上文讲到,让自己的机器可以同时安装两个版本的python3.x,下面我们就可以正式运行Bert模型。

一、框架安装

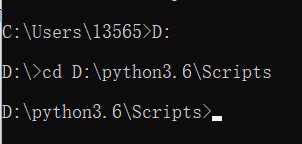

1.首先切换到版本3.6的文件夹下

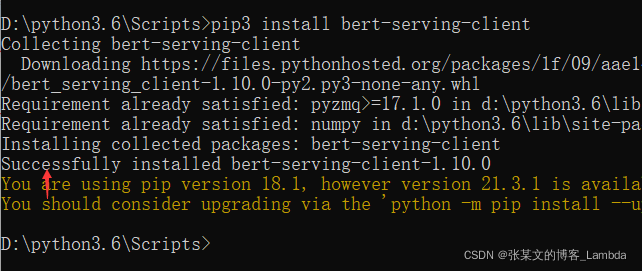

2.安装bert-as-server 框架

pip3 install bert-serving-server #server

pip3 install bert-serving-client #client

完成如下:

3.中文预训练模型下载

Google下载地址:https://storage.googleapis.com/bert_models/2018_11_03/chinese_L-12_H-768_A-12.zip

记得解压到一个文件夹下。

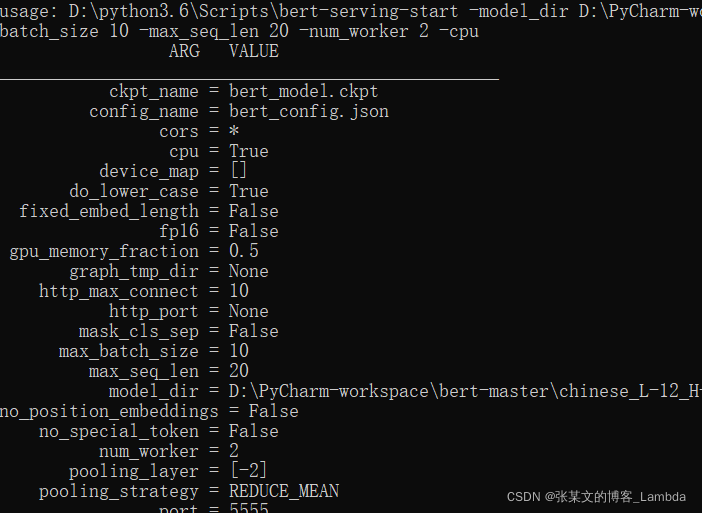

4.启动BERT服务

tensorflow-gpu根据个人需求和硬件条件选择性安装。命令语句的地址要根据解压的地址修改,我的电脑不跑GPU版本的,所以运行命令调整为以CPU方式运行:命令行参数介绍

bert-serving-start -model_dir D:\PyCharm-workspace\bert-master\chinese_L-12_H-768_A-12 -max_batch_size 10 -max_seq_len 20 -num_worker 2 -cpu

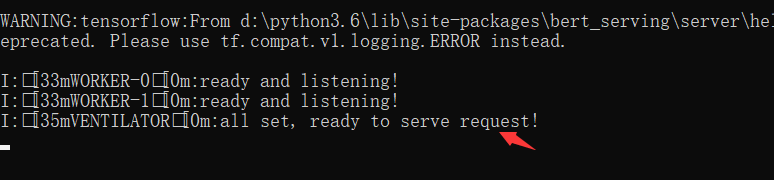

运行成功截图:

太不容易了,踩了3天坑,真的要专门记录一下,希望后面的人不要像我一样走各种弯路。

二、模型使用

1.打开pycharm

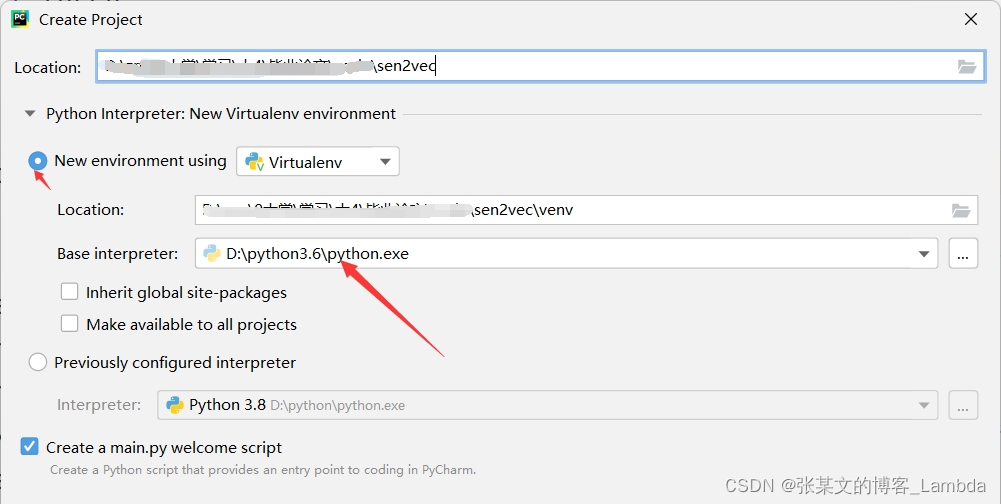

创建一个解释器为python3.6的项目,它会自动给我们创建一个虚拟环境(爱了爱了):

2.运行代码测试

# -*- coding:utf-8 -*-

from bert_serving.client import BertClient

def main():

bc = BertClient()

doc_vecs = bc.encode(['今天天空很蓝,阳光明媚', '今天天气好晴朗', '现在天气如何'])

print(doc_vecs)

if __name__ == '__main__':

main()

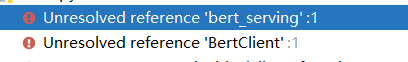

咦,这是什么情况?

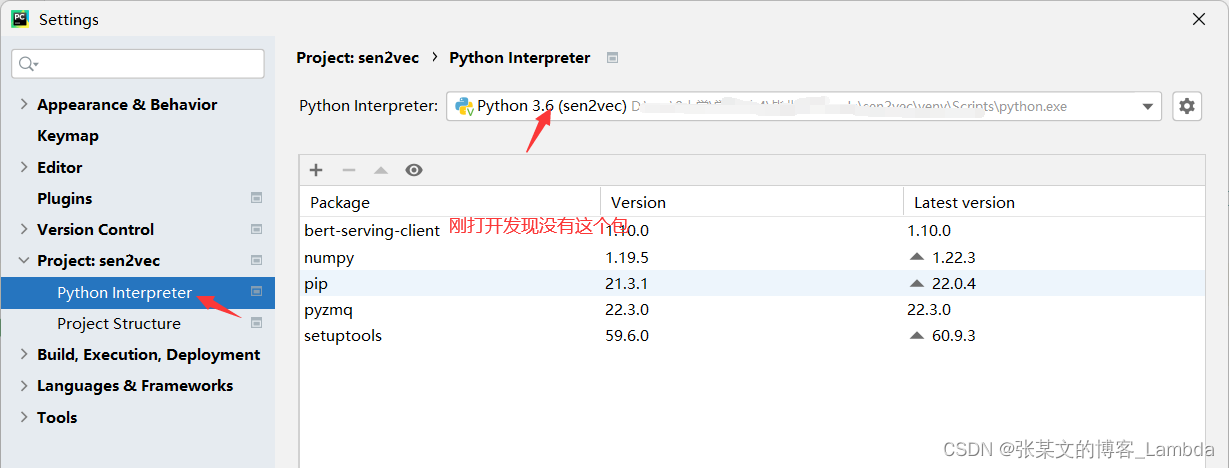

点击 左上角 文件/file => 设置/Settings => Project Interpreter => 看看包进来了不

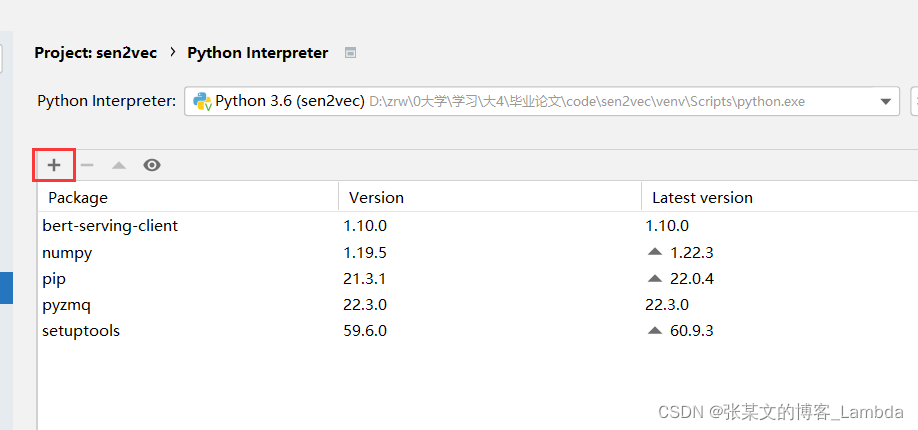

没有进来,重新添加一下。点击“+”,搜索添加。 KO!不报错了!

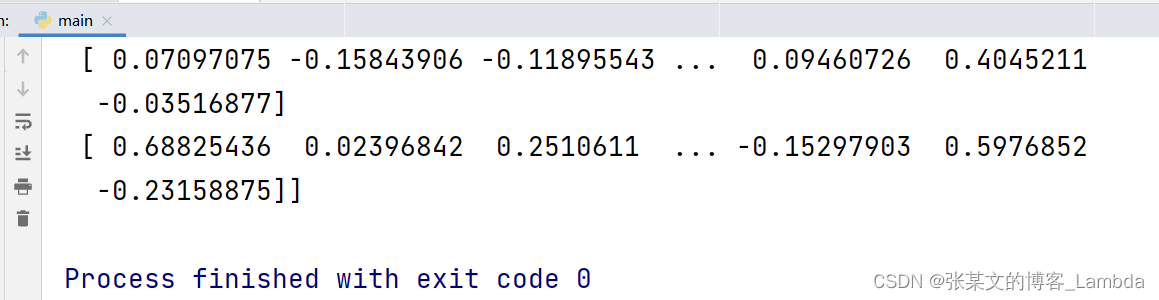

3.运行结果

注意,bert句向量运行的结果是768维度的,打印的句向量shape为(sents_num, 768),没有必要额外降维噢。

参考博客:

(1)BERT预训练模型简单应用

(2)keras构造的分类模型中将bert预训练出的句子向量