Abstract & Introduction & Related Work

- 研究任务

- 实体和关系抽取

- 已有方法和相关工作

- 结构化预测,两个任务使用同一框架

- 多任务学习,

- 面临挑战

- 长期以来,人们一直认为联合模型可以更好地捕捉实体和关系之间的相互作用,并有助于缓解错误传播问题

- 创新思路

- 我们的方法基本上是建立在两个独立的编码器上,只是使用实体模型来构建关系模型的输入

- 通过一系列仔细的检查,我们验证了为实体和关系学习不同的上下文表征的重要性,在关系模型的早期融合实体信息,并纳入全局上下文

- 实验结论

- 在ACE04和ACE05上达到sota

Method

Our Approach

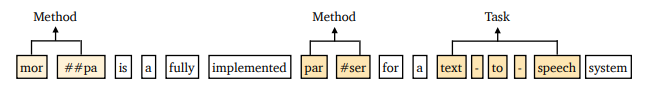

如图1所示,我们的方法由一个实体模型和一个关系模型组成。实体模型首先接受输入的句子,并预测每个单独span的实体类型(或)。然后,我们在关系模型中独立处理每一对候选实体,插入额外的标记标记,以突出主语和宾语及其类型。我们将在下面详细介绍每个组件,最后总结我们的方法和DYGIE++之间的差异

Entity model

标准的基于span的模型

Relation model

关系模型旨在将一对span

s

i

,

s

j

s_i , s_j

si?,sj?(一个主体和一个客体)作为输入,并预测关系类型或。 以前的方法重新使用跨度表示

h

e

(

s

i

)

\mathbf{h_e(s_i)}

he?(si?),

h

e

(

s

j

)

\mathbf{h_e(s_j)}

he?(sj?)来预测

s

i

s_i

si? 和

s

j

s_j

sj? 之间的关系。我们假设这些表征只捕获了每个单独实体周围的上下文信息,可能无法捕获这对span之间的依赖关系。我们还认为,在不同的span对之间共享上下文表示可能是次优的。例如,图1中的单词is a对于理解MORPA和PARSER之间的关系至关重要,但对于MORPA和TEXT-TO-SPEECH则不然

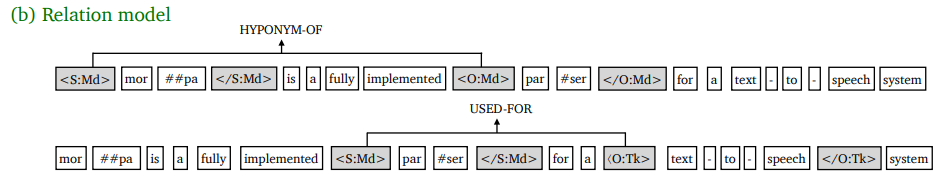

我们的关系模型反而独立地处理每一对跨度,并在输入层插入类型标记,以突出主体和客体及其类型

标识这个span对

concat起来,然后输入一个全连接层来预测各种关系的概率

我们发现,在输入层注入类型信息对于区分实体类型非常有帮助–例如,在试图理解关系之前,"迪士尼 "是指一个人还是一个组织

Cross-sentence context

跨句子信息可用于帮助预测实体类型和关系,特别是对代词的提及。采用传播机制来纳入跨句子语境。Wadden等人(2019)还增加了一个3句话的语境窗口,这被证明可以提高性能。我们还评估了在我们的方法中利用跨句子语境的重要性。由于我们期望预训练的语言模型能够捕获长距离的依赖关系,我们只是通过将句子扩展到实体和关系模型的固定窗口大小W来纳入跨句子语境。具体来说,给定一个有n个词的输入句子,我们分别从左边语境和右边语境中增加 ( W ? n ) / 2 (W-n)/2 (W?n)/2 个词的输入

Training & inference

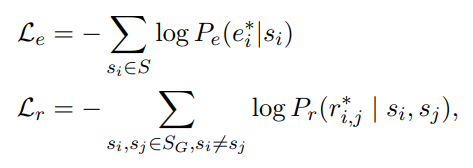

使用两个交叉熵损失函数

枚举所有的span来计算relation模型的损失

Differences from DYGIE++

我们的方法与DYGIE++(Luan等人,2019;Wadden等人,2019)有以下不同之处。

(1) 我们对实体和关系模型使用单独的编码器,没有任何多任务学习。预测的实体类型被直接用于构建关系模型的输入。

(2) 通过使用文本标记,关系模型中的上下文表示是针对每一对跨度的。

(3) 我们只通过用额外的上下文扩展输入来纳入跨句子信息(就像他们那样),我们不采用任何图传播层和beam search。正如我们在实验中所显示的(第4节),它在所有的基准中也取得了很大的进步,使用的是相同的预训练编码器

Efficient Batch Computations

我们的方法的一个可能的缺点是,我们需要为每一对实体运行一次我们的关系模型。为了缓解这个问题,我们提出了一个新颖而有效的替代我们的关系模型的方法。关键问题是,我们希望对同一句子中的不同跨度对进行重复使用计算。这在我们原来的模型中是不可能的,因为我们必须为每对跨度独立插入实体标记。为此,我们提出了一个近似模型,对原来的关系模型做了两个主要的改变。首先,我们不直接在原句中插入实体标记,而是将标记的位置嵌入与相应跨度的开始和结束标记联系起来

第二,我们给注意力层添加了一个约束条件。我们强制文本标记只关注文本标记,不关注标记标记,而实体标记标记可以关注所有的文本标记和与同一跨度对相关的所有4个标记标记。这两个修改使我们能够重新使用所有文本标记的计算,因为文本标记的表示是独立于实体标记标记的。因此,我们可以在关系模型的一次运行中对同一句子中的多对跨度进行批判。在实践中,我们将所有的标记标记添加到句子的末尾,形成一个批处理跨度对的输入(图1(c))。这导致了推理时间的大幅加速,而性能仅有小幅下降(第4.3节)

Experiments

Conclusion

在本文中,我们提出了一种简单而有效的端到端关系提取方法。我们的模型独立地学习了用于实体识别和关系提取的两个编码器,我们的实验表明,它在三个标准的基准上大大地超过了以前的技术水平。我们进行了广泛的分析,以了解我们方法的优越性能,并验证了为实体和关系学习不同的上下文表示的重要性,以及将实体信息作为关系模型的输入特征。我们还提出了一个有效的近似方法,在推理时获得了很大的速度,但准确度却有小幅下降。我们希望这个简单的模型能够作为一个非常强大的基线,并使我们重新思考端到端关系抽取中联合训练的价值

Remark

简单有效,那就是好文章!